From Wikipedia, the free encyclopedia

This is a list of file formats used by archivers and compressors used to create archive files.

Archive formats by purpose

[edit]

Archive formats are used for backups, mobility, and archiving. Many archive formats compress the data to consume less storage space and result in quicker transfer times as the same data is represented by fewer bytes. Another benefit is that files are combined into one archive file which has less overhead for managing or transferring. There are numerous compression algorithms available to losslessly compress archived data; some algorithms are designed to work better (smaller archive or faster compression) with particular data types. Archive formats are used by most operating systems to package software for easier distribution and installation than binary executables.

| File extension(s)[a] | MIME type[b] | Official name[c] | Platform[d] | Description |

|---|---|---|---|---|

| .a, .ar | application/x-archive | Unix Archiver | Unix-like | The traditional archive format on Unix-like systems, now used mainly for the creation of static libraries. |

| .cpio | application/x-cpio | cpio | Unix-like | RPM files consist of metadata concatenated with (usually) a cpio archive. Newer RPM systems also support other archives, as cpio is becoming obsolete. cpio is also used with initramfs. |

| .shar | application/x-shar | Shell archive | Unix-like | A self-extracting archive that uses the Bourne shell (sh). |

| .LBR | .LBR | CP/M

DOS |

A system for storing multiple files. LBR archives typically contained files processed by SQ, or the archive itself was compressed with SQ. LBR archives that were compressed with SQ ended with the extension .LQR | |

| .iso | application/x-iso9660-image | ISO-9660 image | (Various; cross platform) | An archive format originally used mainly for archiving and distribution of the exact, nearly-exact, or custom-modified contents of an optical storage medium such as a CD-ROM or DVD-ROM. However, it can be used to archive the contents of other storage media, selected partitions, folders, and/or files. The resulting archive is typically optimized for convenient rendering to (re-)writable CD or DVD media. |

| .lbr | Commodore 64/128 | A library format used primarily on the Commodore 64 and 128 lines of computers. This bears no resemblance to the DOS LBR format. While library files were quick to implement (a number of programs exist to work with them) they are crippled in that they cannot grow with use: once a file has been created it cannot be amended (files added, changed or deleted) without recreating the entire file. | ||

| .mar | Mozilla ARchive[1] | (Various; cross platform) | An archive format used by Mozilla for storing binary diffs. Used in conjunction with bzip2. | |

| .sbx | application/x-sbx | SeqBox[2] | (Various; cross platform) | A single file container/archive that can be reconstructed even after total loss of file system structures. |

| .tar | application/x-tar | Tape archive | Unix-like | A common archive format used on Unix-like systems. Generally used in conjunction with compressors such as gzip, bzip2, compress or xz to create .tar.gz, .tar.bz2, .tar.Z or tar.xz files. |

| File extension(s)[a] | MIME type[b] | Official name[c] | Platform[d] | Description |

|---|---|---|---|---|

| .br | application/x-brotli | Brotli | all | Brotli is a compression algorithm developed by Google for textual web content, and typically achieves higher compression ratios than other algorithms for this use case. |

| .bz2 | application/x-bzip2 | bzip2 | Unix-like | An open source, patent- and royalty-free compression format. The compression algorithm is a Burrows–Wheeler transform followed by a move-to-front transform and finally Huffman coding. |

| .F, .?XF[e] | Freeze/melt[3] | QNX4, Unix-like and DOS | Old compressor for QNX4 OS. The compression algorithm is a modified LZSS, with an adaptive Huffman coding. | |

| .genozip | application/vnd.genozip | genozip | Linux, macOS, Windows | Genozip, a compressor for genomic file formats such as FASTQ, BAM, VCF and others.[4] |

| .gz | application/gzip[5] | gzip | Unix-like | GNU Zip, the primary compression format used by Unix-like systems. The compression algorithm is Deflate, which combines LZSS with Huffman coding. |

| .lz | application/x-lzip | lzip | Unix-like | An alternate LZMA algorithm implementation, with support for checksums and ident bytes. |

| .lz4 | LZ4 | Unix-like | Algorithm developed by Yann Collet, designed for very high (de)compression speeds. It is an LZ77 derivative, without entropy encoding. | |

| .lzma | application/x-lzma | lzma | Unix-like | The LZMA compression algorithm as used by 7-Zip. |

| .lzo | application/x-lzop | lzop | Unix-like | An implementation of the LZO data compression algorithm. |

| .rz | rzip | Unix-like | A compression program designed to do particularly well on very large files containing long distance redundancy. | |

| .sfark | sfArk | Windows compress/decompress- Linux and macOS decompress only | A compression program designed to do high compression on SF2 files (SoundFont). | |

| .sz | application/x-snappy-framed | Snappy | Unix-like | A compression format developed by Google, and open-sourced in 2011. Snappy aims for very high speeds, reasonable compression, and maximum stability rather than maximum compression or compatibility with any other compression library. It is an LZ77 derivative, without entropy encoding. |

| .?Q? | SQ | CP/M and DOS | Squeeze: A program which compressed files using Huffman coding. A file which was «squeezed» had the middle initial of the name changed to «Q», so that a squeezed text file would end with .TQT, a squeezed executable would end with .CQM or .EQE. Typically used with .LBR archives, either by storing the squeezed files in the archive, or by storing the files decompressed and then compressing the archive, which would have a name ending in «.LQR». | |

| .?Z? | CRUNCH | CP/M and DOS | A compression program written by Steven Greenberg implementing the LZW algorithm. For several years in the CP/M world when no implementation was available of ARC, CRUNCHed files stored in .LBR archives were very popular. CRUNCH’s implementation of LZW had a somewhat unusual feature of modifying and occasionally clearing the code table in memory when it became full, resulting in a few percent better compression on many files. | |

| .xz | application/x-xz | xz | Unix-like | A compression format using LZMA2 to yield high compression ratios. The LZMA algorithm is an LZ77 derivative, with entropy encoding in the form of range encoding. |

| .z | application/x-compress | pack | Unix-like | The traditional Huffman coding compression format. |

| .Z | application/x-compress | compress | Unix-like | The traditional LZW compression format. |

| .zst | application/zstd | Zstandard | Cross-platform | Algorithm developed by Yann Collet at Facebook, combining high speed and high compression. It is an LZ77 derivative, with entropy encoding in the form of finite-state entropy and Huffman coding. |

| .??_ | MS-DOS/Windows | Compression format(s) used by some DOS and Windows install programs. MS-DOS includes expand.exe to decompress its install files. The compressed files are created with a matching compress.exe command. The compression algorithm is LZSS. |

Archiving and compression

[edit]

| File extension(s)[a] | MIME type[b] | Official name[c] | Creation platform[d] | Restoration platform[f] | Restorable with free software[g] | Description |

|---|---|---|---|---|---|---|

| .7z | application/x-7z-compressed | 7z | Multiple | Multiple | Yes | Open source file format. Used by 7-Zip. |

| .s7z | application/x-7z-compressed | 7zX | macOS | macOS, restoration on different platforms is possible although not immediate | Yes | Based on 7z. Preserves Spotlight metadata, resource forks, owner/group information, dates and other data which would be otherwise lost with compression.

Made obsolete by the introduction of AppleDouble-encoded 7z archives (Macintosh only). |

| .aar | application/octet-stream | Apple Archive | macOS | macOS | No | Created by Apple introduced with iOS 14 in 2020. |

| .ace | application/x-ace-compressed | ACE | Windows | Multiple | Yes | Proprietary format |

| .afa | application/x-astrotite-afa | AFA | UNIX-like | UNIX-like | No | A format that compresses and doubly encrypt the data (AES256 and CAS256) avoiding brute force attacks, also hide files in an AFA file. It has two ways to safeguard data integrity and subsequent repair of the file if has an error (repair with AstroA2P (online) or Astrotite (offline)). |

| .alz | application/x-alz-compressed | ALZip | Windows | Multiple | Yes | A mainly Korean format designed for very large archives. |

| .apk | application/vnd.android.package-archive | APK | Multiple | Multiple | Yes | Android application package (variant of JAR file format). |

| .arc, .ark | application/octet-stream | ARC | Multiple | Multiple | Yes | Very popular in the early days of BBSes, one of the first to offer compression and archiving in a single program. Largely replaced by PKZIP. |

| .arc, .cdx | application/x-freearc | FreeArc | Windows, Linux | Windows, Linux | Yes | Open source file format developed by Bulat Ziganshin. A «FreeArc Next» version is under development which includes Zstandard support. |

| .arj | application/x-arj | ARJ | Originally DOS, now multiple | Multiple | Yes | Competitor to PKZIP in the 1990s, offered better multi-part archive handling. |

| .b1 | application/x-b1 | B1 | Multiple | Multiple | Yes | Open archive format, used by B1 Free Archiver[6] |

| .b6z | B6Z | macOS | Multiple | Yes | Compressed archive format B6Zip[7] | |

| .ba | Scifer | Multiple | Multiple | Yes | Binary Archive with external header | |

| .bh | BlakHole | Yes | Proprietary format from the ZipTV Compression Components | |||

| .cab | application/vnd.ms-cab-compressed | Cabinet | Windows | Multiple | Yes | The Microsoft Windows native archive format, which is also used by many proprietary installers such as WISE. |

| .car | Compressia archive | Originally DOS, now DOS and Windows | Originally DOS, now DOS and Windows | Yes | Created by Yaakov Gringeler; released last in 2003 (Compressia 1.0.0.1 beta), now apparently defunct. Free trial of 30 days lets user create and extract archives; after that it is possible to extract, but not to create. | |

| .cfs | application/x-cfs-compressed | Compact File Set | Windows, Unix-like including macOS | Multiple | Yes | Open source file format. |

| .cpt | Compact Pro | Classic Mac OS | Multiple | Yes | Compact Pro archive, a common archiver used on Mac platforms until about Mac OS 7.5.x. Competed with StuffIt; now obsolete. | |

| .dar | application/x-dar | Disk Archiver | Unix-like including macOS | Unix-like including macOS, Windows | Yes | Open source file format. Files are compressed individually with either gzip, bzip2 or lzo. |

| .dd | DiskDoubler | Classic Mac OS | Obsolete | |||

| .dgc | application/x-dgc-compressed | DGCA | Windows | Windows | ||

| .dmg | application/x-apple-diskimage | Apple Disk Image | macOS | macOS, Windows, Linux | Yes | Supports «Internet-enabled» disk images, which, once downloaded, are automatically decompressed, mounted, have the contents extracted, and thrown away. Currently, Safari is the only browser that supports this form of extraction; however, the images can be manually extracted as well. This format can also be password-protected or encrypted with 128-bit or 256-bit AES encryption. |

| .ear | EAR | Multiple | Multiple | Yes | Enterprise Java Archive archive | |

| .gca | application/x-gca-compressed | GCA | The predecessor of DGCA. | |||

| .genozip | Genozip[8] | Linux, macOS, Windows | Linux, macOS, Windows | No | Optimized for (but not limited to) genomic file types such as FASTQ, BAM, VCF | |

| .ha | [9] | Originally DOS, now multiple | Multiple | Yes, but may be covered by patents | DOS era format; uses arithmetic/Markov coding | |

| .hki | WinHKI[10] | MS Windows | MS Windows | No | HKI | |

| .ice | ICE | Windows | Windows | Yes | Produced by ICEOWS program. Excels at text file compression. | |

| .jar | application/java-archive | JAR | Multiple | Multiple | Yes | Java archive, compatible with ZIP files |

| .kgb | KGB Archiver | Multiple | Multiple | Yes | Open sourced archiver with compression using the PAQ family of algorithms and optional encryption. | |

| .lzh, .lha | application/x-lzh | LHA | Originally DOS, now multiple | Multiple | Yes | The standard format on Amiga. |

| .lzx | application/x-lzx | LZX | Amiga | Archiver originally used on The Amiga. Now copied by Microsoft to use in their .cab and .chm files. | ||

| .pak | PAK | HP NonStop | HP NonStop | Yes[11] | file format from NoGate Consultings, a rival from ARC-Compressor.

.pak was also briefly used by the short lived MSDOS PKPAK program. |

|

| .partimg | PartImage | Multiple | Multiple | Yes | A disk image archive format that supports several compression methods as well as splitting the archive into smaller pieces. | |

| .paq6, .paq7, .paq8 and variants | PAQ | Unix-like and Windows | Unix-like and Windows | Yes | An experimental open source packager[12] | |

| .pea | PeaZip | Linux and Windows | Linux and Windows | Yes | Open source archiver supporting authenticated encryption, cascaded encryption, volume spanning, customizable object level and volume level integrity checks (form CRCs to SHA-512 and Whirlpool hashes), fast deflate based compression | |

| .phar | PHAR | Multiple | Multiple | Yes | A package format to enable distribution of applications and libraries by bundling many PHP code files and other resources (e.g. images, stylesheets, etc.) into a single archive file | |

| .pim | PIM | Windows | Windows | Yes | The format from the PIM — a freeware compression tool by Ilia Muraviev. It uses an LZP-based compression algorithm with set of filters for executable, image and audio files. | |

| .pit | PackIt | Classic Mac OS | obsolete | |||

| .qda | Quadruple D | Windows | Windows | Used for data in games written using the Quadruple D library for Delphi. Uses byte pair compression. | ||

| .rar | application/x-rar-compressed | RAR | Originally DOS, now WinRAR | Multiple | Partial[h] | A popular proprietary archive format. |

| .rk | RK and WinRK[16] | Multiple | Multiple | No | The format from a proprietary archiving package. Odd among proprietary packages in that they focus on incorporating experimental algorithms with the highest possible compression (at the expense of speed and memory), such as PAQ, PPMD and PPMZ (PPMD with unlimited-length strings), as well as a proprietary algorithms. | |

| .sda | Self Dissolving ARChive | Commodore 64, Commodore 128 | Commodore 64, Commodore 128 | Yes | SDAs refer to Self Dissolving ARC files, and are based on the Commodore 64 and Commodore 128 versions of ARC, originally written by Chris Smeets. While the files share the same extension, they are not compatible between platforms. That is, an SDA created on a Commodore 64 but run on a Commodore 128 in Commodore 128 mode will crash the machine, and vice versa. The intended successor to SDA is SFX. | |

| .sea | Self Extracting Archive | Classic Mac OS | Classic Mac OS (implicitly) | A pre-Mac OS X Self-Extracting Archive format. StuffIt, Compact Pro, Disk Doubler and others could create .sea files, though the StuffIt versions were the most common. | ||

| .sen | Scifer | Multiple | Multiple | Yes | Scifer Archive with internal header | |

| .sfx | Self Extracting Archive | Commodore 64, Commodore 128 | Commodore 64, Commodore 128 | Yes | SFX is a Self Extracting Archive which uses the LHArc compression algorithm. It was originally developed by Chris Smeets on the Commodore platform, and runs primarily using the CS-DOS extension for the Commodore 128. Unlike its predecessor SDA, SFX files will run on both the Commodore 64 and Commodore 128 regardless of which machine they were created on. | |

| .shk | NuFX | Originally Apple II, now multiple | Multiple | Yes | An archive format designed for the Apple II series of computers. The canonical implementation is ShrinkIt, which can operate on disk images as well as files. Preferred compression algorithm is a combination of RLE and 12-bit LZW. Archives can be manipulated with the command-line NuLib tool, or the Windows-based CiderPress. | |

| .sit | application/x-stuffit | StuffIt | Originally Classic Mac OS, now multiple | Originally Classic Mac OS, now multiple | Yes | A compression format common on Apple Macintosh computers. The free StuffIt Expander is available for Windows and macOS. |

| .sitx | application/x-stuffitx | StuffIt X | Multiple | Multiple | Yes | The replacement for the .sit format that supports more compression methods, UNIX file permissions, long file names, very large files, more encryption options, data specific compressors (JPEG, Zip, PDF, 24-bit image, MP3). The free StuffIt Expander is available for Windows and OS X. |

| .sqx | SQX | Windows | Windows | Yes | A royalty-free compressing format | |

| .tar.gz, .tgz, .tar.Z, .tar.bz2, .tbz2, .tar.lz, .tlz, .tar.xz, .txz, .tar.zst |

application/x-gtar | tar with gzip, compress, bzip2, lzip, xz, or zstd | Multiple | Multiple | Yes | The «tarball» format combines tar archives with a file-based compression scheme (usually gzip). Commonly used for source and binary distribution on Unix-like platforms, widely available elsewhere. Xarchiver supports the .tar.zst Archive/Compression format on Unix-like platforms. |

| .uc .uc0 .uc2 .ucn .ur2 .ue2 | UltraCompressor II | DOS | DOS | UltraCompressor 2.3 was developed to act as an alternative to the then popular PKZIP application. The main feature of the application is its ability to create large archives. This means that compressed archives with the UC2 file extension can hold almost 1 million files. | ||

| .uca | PerfectCompress[17] | Windows | Windows | No | Based on PAQ, RZM, CSC, CCM, and 7zip. The format consists of a PAQ, RZM, CSC, or CCM compressed file and a manifest with compression settings stored in a 7z archive. | |

| .uha | UHarc | DOS/Windows | DOS/Windows | Yes | A high compression rate archive format originally for DOS. | |

| .war | WAR | Multiple | Multiple | Yes | Web Application archive (Java-based web app) | |

| .wim | application/x-ms-wim | Windows Image | Windows | Windows | Yes | File-based disk image format developed to deploy Microsoft Windows. |

| .xar | application/x-xar | XAR | Multiple | Multiple | Yes | |

| .xp3 | KiriKiri | Windows | Windows | Yes | Native format of the Open Source KiriKiri Visual Novel engine. Uses combination of block splitting and zlib compression. The filenames and pathes are stored in UTF-16 format. For integrity check, the Adler-32 hashsum is used. For many proprietary games, the files are encrypted (and decoded on runtime) via so-called «cxdec» module, which implements xor-based encryption. | |

| .yz1 | YZ1 | Windows, DOS, Linux | Windows, DOS, Linux | Yes | Yamazaki zipper archive. Compression format used in DeepFreezer archiver utility created by Yamazaki Satoshi.[18] Read and write support exists in TUGZip, IZArc and ZipZag | |

| .zip, .zipx | application/zip | ZIP | Originally DOS, now multiple | Multiple | Yes | The most widely used compression format on Microsoft Windows. Commonly used on Macintosh and Unix systems as well. |

| .zoo | application/x-zoo | zoo | Multiple | Multiple | Yes | |

| .zpaq | ZPAQ | Multiple | Multiple | Yes | Journaling (append-only) archive format with rollback capability. Supports deduplication and incremental update based on last-modified dates. Multi-threaded. Compresses in LZ77, BWT, and context mixing formats. Open source. | |

| .zz | Zzip[19] | Multiple | Multiple | Yes | Archiver with a compression algorithm based on the Burrows–Wheeler transform method. |

| File extension(s)[a] | MIME type[b] | Official name[c] | Platform[d] | Description |

|---|---|---|---|---|

| .ecc | dvdisaster error-correction file | Multiple | File format used by dvdisaster to be used for data recovery when discs become damaged or partially unreadable. | |

| .ecsbx | Error-correcting SeqBox[20] | Multiple | Archive with forward error correction and sector level recoverability. Error-correcting version of SeqBox.[2] | |

| .par .par2 |

application/x-par2 | Parchive file | Multiple | File format used in conjunction with any archive format to provide error correction and file recovery, most often in newsgroup distribution of binary files. |

| .rev | WinRAR recovery volume | Multiple | File format used with WinRAR rar volumes. The data recovery is error correction data which is provided in the form of open recovery records and/or recovery volumes, allowing reconstruction of good archives (including reconstruction of entirely volumes) |

Containers and compression

[edit]

| Format |

Filename |

Created by |

Introduced in | Based on |

Compression |

Integrity check[j] | Recovery record[k] | Encryption supported[l] | Unicode filenames | Modification date resolution | Pre-processing | License |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Archive (ar) | .a, .ar | CSRG | 1971 | Original | No | No | No | No | No | 1 s | ? | ? |

| cpio | .cpio | Bell Labs | 1983 Unix System V | ? | No | Partial, select formats only | No | No | No | 1 s | No | ? |

| Shell Archive (shar and makeself) | .shar, .run | James Gosling, Alan Hewett | 1994 4.4BSD | Original | No | Yes, commonly MD5 | Partial | Partial | Partial | arbitrary (typically 1 s) | No | Public domain (shar 1.x — 3.x), GPL (shar 4.x) |

| Tape Archive (tar) | .tar | Bell Labs | 1975 Version 6 Unix | ? | No | Partial, metadata only. Full integrity providable by filters such as gzip. | No | No | Optional[m] | 1 s | No | ? |

| Extended TAR format (pax) | .tar | OpenGroup | 2001 | Sun proposal + TAR | No | metadata | No | No | Yes | arbitrary (typically 1 ns) | No | ? |

| BagIt | – | The Library of Congress | 2007 | file system | No | Yes | No | No | Yes | No | ? | ? |

| 7z | .7z | Igor Pavlov | 2000 | LZMA, LZMA2, Bzip2, PPMd, Deflate | Yes | Yes, CRC32 |

No | Yes, AES-256 |

Yes | 100 ns[21] | Yes | LGPL, Public domain |

| ACE | .ace | Marcel Lemke | 1998[22] | LZ77 | Yes | Yes | Yes | Yes, Blowfish | Yes | 2s | ? | Proprietary software |

| AFA | .afa | Vicente Sánchez-Alarcos | 2009 | Original | Yes | Yes | Yes | Yes, AES and CAST | Yes | ? | ? | ? |

| ARC | .arc | Thom Henderson (SEA) | 1985 | ? | Yes | CRC16 | No | weak XOR only | No | 2s | No | ? |

| ARJ | .arj | Robert Jung | 1991 | AR001 and AR002 | Yes | Yes | Yes | weak XOR with initial constant | No | ? | ? | Proprietary software |

| B1 | .b1 | Catalina Group Ltd | 2011 | LZMA | Yes | Yes | No | Yes, AES | Yes | ? | ? | ? |

| Cabinet | .cab | Microsoft | 1992 Windows 3.1 | Deflate | Yes | Optional PKCS7 Authenticode signature | No | Optional (with SDK) | Yes | 2 s | ? | ? |

| Compact File Set | .cfs | Joe Lowe (Pismo Technic Inc.) | 2008 | ZIP/LZMA | Yes | Yes | ? | Yes | Yes | ? | ? | Free software |

| Compact Pro | .cpt | Bill Goodman | 1990 (as «Compactor») | Original | Yes | Yes | No | Yes | ? | ? | ? | Proprietary software |

| Disk Archive (DAR) | .dar | Denis Corbin | 2002 | Original | Yes | Yes | Yes[n] | Yes | Yes | 1 μs | Yes | GPLv2 |

| DGCA | .dgc | Shin-ichi Tsuruta | 2001 | GCA | Yes | Yes | Yes | Yes | Yes | ? | ? | ? |

| FreeArc | .arc | Bulat Ziganshin | 2006 | LZMA, PPMd, TTA | Yes | Yes | Yes | Yes, AES, Blowfish, Twofish and Serpent | Yes | ? | ? | GPLv2 |

| LHA (also LZH) | .lzh, .lha | Haruyasu Yoshizaki | 1988 | Frozen | Yes | Only on recent LHA releases | No | No | No | 1–2 s | ? | ? |

| LZX | .lzx | Jonathan Forbes and Tomi Poutanen | 1995 | LZ77 | Yes | Only on recent LZX releases | ? | ? | ? | ? | ? | ? |

| ISO image | .iso, .img, .ima | ISO 9660 | 1988 | High Sierra Format | No | ? | ? | ? | ? | ? | ? | ? |

| Spark | .arc | David Pilling | 1989 | ARC | Yes | CRC16 | No | weak XOR only | No | 1 cs | No | CDDL 1.0[23] |

| WinMount format | .mou | ? | 2007 | ? | Yes | Yes | Yes | Yes | Yes | ? | ? | Proprietary software |

| Macintosh Disk Image | .dmg | Apple Computer | 2001 Mac OS X | Original | Yes | Yes | ? | Yes | ? | ? | ? | ? |

| Partition Image (PartImage) | .partimg | François Dupoux and Franck Ladurelle | 2000 | ? | Yes | ? | ? | ? | ? | ? | ? | GPLv2 |

| PAQ Family (Several formats)[o] | .paq#*, .lpaq#* | Matt Mahoney | 2002–2006 | Original | Yes | ? | ? | ? | ? | ? | ? | ? |

| PEA | .pea | Giorgio Tani | 2006 | Original, Deflate based compression | Yes | Yes Adler32, CRC32, CRC64, MD5, SHA1, RIPEMD-160, SHA256, SHA512, Whirlpool | No | Yes Authenticated Encryption, AES128 and AES256 in EAX mode | Yes system dependent | Yes arbitrary | ? | Public domain |

| PIM | .pim | Ilia Muraviev | 2004–2008 | Original | Yes | Yes | No | No | Yes | No | ? | ? |

| Quadruple D | .qda | Taku Hayase (aka sandman) | 1997 | ? | Yes | ? | ? | ? | ? | ? | ? | ? |

| RAR | .rar | Eugene Roshal | 1993 | Original | Yes | Yes, CRC32, BLAKE2 |

Yes, Reed–Solomon |

Yes, AES-256 for RAR 5.0 archives |

Yes, UTF-8 |

2 s, 1 s, 6.5536 ms, 25.6 μs or 100 ns[p] | Dropped | Proprietary software |

| RK | .rk | M Software, Ltd. | 2004 | Original | Yes | Yes | No | Yes, AES, Square, Twofish | Yes | 1 s | ? | ? |

| NuFX | .shk | Andy Nicholas | 1989 | Original | Yes | CRC16 | No | No | No | 1 s | ? | ? |

| StuffIt (also SIT) | .sit | Raymond Lau | 1987 | ? | Yes | ? | ? | Yes | ? | ? | ? | Proprietary software |

| StuffIt X (also SITx) | .sitx | Aladdin/Allume Systems | 2002 | ? | Yes | ? | Optional | Yes, RC4,Blowfish, AES,DES |

Yes | ? | ? | Proprietary software |

| UltraCompressor II | .uc .uc0 .uc2 .ucn .ur2 .ue2 |

Nico de Vries[26] | 1992–1996 | LZ77 and Huffman coding | Yes | Yes | Yes | Yes, triple DES | ? | ? | ? | ? |

| Windows Image | .wim, .swm, .esd | Microsoft | 2006 | Original | Yes | Yes | No | Partial[q] | Yes | 100 ns | ? | ? |

| ZIP | .zip | Phil Katz | 1989 | Deflate | Yes | Yes | No | Yes, AES | Yes | 1–2 s, depending on version | ? | ? |

| ZPAQ | .zpaq | Matt Mahoney | 2009 | PAQ | Yes | Yes, SHA-1 | No | Yes, AES-256 | Yes | ? | ? | MIT, Public domain |

Software packaging and distribution

[edit]

| Format | Filename extension |

Created by |

Introduced in | Based on | Integrity check | Recovery record | Encryption supported | Unicode filenames | Modification date resolution |

|---|---|---|---|---|---|---|---|---|---|

| Debian package (deb) | .deb | Debian | 1994 Debian 0.91 | ar, tar, and gzip, xz | Yes | No | No | Yes | 1 s |

| Macintosh Installer | .pkg, .mpkg (metapackage) | NeXT | 1989 NeXTSTEP 1.0 | pax and gzip | Yes | ? | ? | Yes | ? |

| RPM Package Manager (RPM) | .rpm | Red Hat | 1995 Red Hat Linux 1.0 | cpio and gzip | Yes | ? | ? | ? | 1 s |

| Slackware Package | .tgz | Patrick Volkerding | 1993 Slackware 1.0 | tar and gzip | Yes | No | No | ? | ? |

| Windows Installer (also MSI) | .msi | Microsoft | 2000 Windows 2000 | OLE Structured Storage, Cabinet and SQL | Optional PKCS7 Authenticode Signature | No | No | No | 2 s |

| MSIX | .appx, .appxbundle, .emsix, .emsixbundle, .msix, .msixbundle | Microsoft | 2012 Windows 8 | Zip | Yes | No | Yes | Yes | 1 s |

| Java Archive (JAR[r]) | .jar | Sun Microsystems | 1997 JDK 1.1 | PKZIP | Yes | No | ? | Yes | ? |

| Google Chrome extension package | .crx | 2009 (Chrome 4.0) | Zip | Yes | ? | No | ? | ? | |

| Pacman | .pkg.tar.zst, .pkg.tar (no compression) | Judd Vinet | 2001 (before ArchLinux 0.1) | tar and zstd[27] (formerly xz) | Yes | No | No | Yes | 1 s |

| Archive format | Built-in compression | Self-extracting | Directory structure | POSIX attributes | ACLs | Alternate data streams |

|---|---|---|---|---|---|---|

| cpio | No[s][s] | No | Yes | Yes | No | ? |

| tar | No[s] | No | Yes | Yes | Some | (in Solaris implementation) |

| dar | Yes[t] | No | Yes | Yes | Yes | Yes |

| ar | No | No | No | Yes | No | ? |

| pax | No | No | Yes | Yes | Yes | ? |

| dump | No[s] | No | Yes | Yes | Yes | ? |

| shar | No | Yes | Yes | Yes | No | ? |

| makeself | Yes | Yes | Yes | Yes | Yes | ? |

| zip | Yes | Yes[u] | Yes | No | ? | ? |

| rar | Yes | Yes[u] | Yes | No | ? | Yes |

| ace | Yes | ? | Yes | No | ? | ? |

| arj | Yes | Yes[u] | Yes | No | No | ? |

| zoo | Yes | ? | Yes | No | ? | ? |

| ISO 9660 (CD-ROM) | No[s] | No | Yes | (with Rock Ridge extension) | No | ? |

| cab | Yes | Yes[u] | ? | No | ? | ? |

| rpm | Yes | No | Yes | Yes | ? | ? |

| deb | Yes | No | Yes | Yes | ? | ? |

| 7z | Yes | Yes | Yes | No | ? | ? |

| Archive format | Built-in compression | Self-extracting | Directory Structure | POSIX attributes | ACLs | Alternate data streams |

- Archive file

- Comparison of file archivers

- Comparison of file systems

- List of file systems

- Solid compression

- zlib

- ^ a b c d File extensions may differ across platforms. The case of these extensions may differ on case-insensitive platforms.

- ^ a b c d MIME media types may be conjectural. Very few have been officially registered with the IANA. Compression-only formats should often be denoted by the media type of the decompressed data, with a content coding indicating the compression format.

- ^ a b c d Official names may be disputed.

- ^ a b c d Creation platform indicates the platform(s) under which a format can be created.

- ^ If attaching

.Fto the file name is not possible with the DOS operating system, the second and third character of the filename extension are replaced byXF. - ^ Restoration platform indicates the platform(s) under which a format can be restored/extracted. Most file formats can be understood by more than one platform.

- ^ «Restorable with free software» indicates whether the format can be restored using an extraction tool that is free software.

- ^ RARLAB UnRAR is proprietary. The free unar has partial unpacking support for RAR1.3, RAR1.5, RAR2, RAR3 & RAR5 [13] and the free libarchive has partial unpacking support for RAR3[14] & RAR5[15].

- ^ The DOS and Windows operating systems required filenames to include an extension (of at least one, and typically 3 characters) to identify the file type. Such extensions must be unique for each type of file. Many operating systems identify a file’s type from its contents without the need for an extension in its name. However, the use of three-character extensions has been embraced as a useful and efficient shorthand for identifying file types.

- ^ Archive files are often stored on magnetic or other media subject to storage errors. Many archive formats contain extra error detection or correction information which can be used by the software used to read the archive files to detect and possibly correct errors.

- ^ Many archive formats contain redundant data embedded in the files in order to detect data storage or transmission errors, and the software used to read the archive files contains logic to detect and correct errors.

- ^ Many archive formats include the capability to encrypt contents to prevent unauthorised access, using one of many available encryption methods.

- ^ While the original tar format uses the ASCII character encoding, current implementations use the UTF-8 (Unicode) encoding, which is backwards compatible with ASCII.

- ^ Supports the external Parchive program (par2).

- ^ The PAQ family (with its lighter weight derivative LPAQ) went through many revisions, each revision suggested its own extension. For example: «.paq9a».

- ^ From 3.20 release RAR can store modification, creation and last access time with the precision up to 0.0000001 second (0.1 μs).[24][25]

- ^ WIM can store the ciphertext of encrypted files on an NTFS volume, but such files can only by decrypted if an administrator extracts the file to an NTFS volume, and the decryption key is available (typically from the file’s original owner on the same Windows installation). Microsoft has also distributed some download versions of the Windows operating system as encrypted WIM files, but via an external encryption process and not a feature of WIM.

- ^ Not to be confused with the archiver JAR written by Robert K. Jung, which produces «.j» files.

- ^ a b c d e Compression is not a built-in feature of the formats, however, the resulting archive can be compressed with any algorithm of choice. Several implementations include functionality to do this automatically

- ^ Per-file compression with gzip, bzip2, lzo, xz, lzma (as opposed to compressing the whole archive). An individual can choose not to compress already compressed filenames based on their suffix as well.

- ^ a b c d Most implementations can optionally produce a self-extracting executable

- ^ Mozilla ARchive

- ^ a b «MarcoPon/SeqBox». May 13, 2024. Archived from the original on February 12, 2022. Retrieved March 20, 2019 – via GitHub.

- ^ «Archived copy». Archived from the original on 2022-02-01. Retrieved 2009-03-05.

{{cite web}}: CS1 maint: archived copy as title (link) - ^ «Genozip — A Universal Extensible Genomic Data Compressor». Archived from the original on 2022-12-26. Retrieved 2022-12-26.

- ^ The ‘application/zlib’ and ‘application/gzip’ Media Types. doi:10.17487/RFC6713. RFC 6713. Retrieved 2016-05-03.

- ^ «Overview». dev.b1.org. Archived from the original on 2023-04-04. Retrieved 2014-03-03.

- ^ «B6Zip — Extract .B6Z and .B6 files — Download». B6Zip. Archived from the original on 2024-05-23. Retrieved 2017-10-06.

- ^ «Genozip | Compression for FASTQ, BAM, VCF». Genozip. Archived from the original on 2024-05-27. Retrieved 2021-07-22.

- ^ «Archived copy». Archived from the original on 2024-04-17. Retrieved 2009-03-05.

{{cite web}}: CS1 maint: archived copy as title (link) - ^ «WinHKI». Archived from the original on 2006-12-05.

- ^ «Tandem Unpak GUI». Archived from the original on 2020-09-22. Retrieved 2013-09-16.

- ^ «Data Compression Programs». mattmahoney.net. Archived from the original on 2024-05-28. Retrieved 2010-09-29.

- ^ «unar RAR parsing implementation». Retrieved 2024-09-11.

- ^ «libarchive RARv3 parsing implementation». Retrieved 2024-09-11.

- ^ «libarchive RARv5 parsing implementation». Retrieved 2024-09-11.

- ^ «Archived copy». Archived from the original on 2018-03-20. Retrieved 2011-03-08.

{{cite web}}: CS1 maint: archived copy as title (link) - ^ «PerfectCompress». Archived from the original on 2012-07-23. Retrieved 2009-11-08.

- ^ DeepFreezer[circular reference]

- ^ Zzip

- ^ «darrenldl/blockyarchive». July 7, 2024. Archived from the original on May 1, 2019. Retrieved April 11, 2019 – via GitHub.

- ^ «7-Zip / Discussion / Open Discussion: File times: creation, access — precision». sourceforge.net. Archived from the original on 2021-07-25. Retrieved 2020-02-08.

- ^ Lemke, Marcel (1998). «Technical Information on the archiver ACE V1.2». hugi.scene.org. Archived from the original on 4 April 2023. Retrieved 22 May 2023.

- ^ «LICENCE · master · RiscOS / Sources / FileSys / ImageFS / SparkFS / Codecs / SparkSpark · GitLab». 28 January 2023. Retrieved 2023-03-26.

- ^ WinRAR download and support: Knowledge Base

- ^ «Switch -TS[N] — save or restore file time (modification, creat…» archive.ph. February 9, 2013. Archived from the original on February 9, 2013. Retrieved November 28, 2021.

- ^ «Professional – Nico de Vries». Archived from the original on 2012-12-30. Retrieved 2020-02-08.

- ^ «Arch Linux — News: Now using Zstandard instead of xz for package compression». archlinux.org.

В компании Microsoft рассказали о расширении списка поддерживаемых файлов встроенным архиватором Windows 11 22H2. Если изначально архиватор поддерживал файлы RAR, TAR и 7Z, сейчас этот перечень увеличился до 11 типов архивов. Об этом сообщает издание Bleeping Computer.

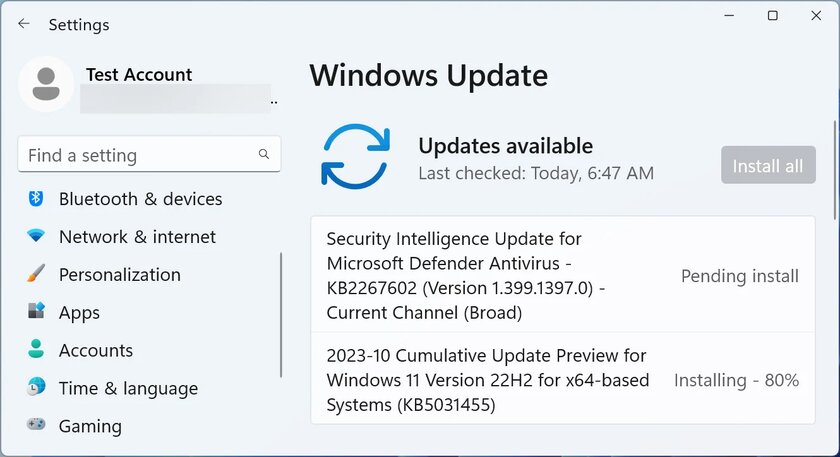

Поддержка новых форматов была добавлена в накопительное обновление за номером KB5031455 Preview, релиз которого состоялся чуть ранее в этом месяце. Теперь встроенный архиватор Windows 11 поддерживает следующие форматы: .rar, .7z, .tar, .tar.gz, .tar.bz2, .tar.zst, .tar.xz, .tgz, .tbz2, .tzst, и .txz. При этом разработчики уточнили, что их утилита не работает с запароленными архивами, и когда эта ситуация изменится, неизвестно.

Новые типы файлов добавлены при помощи бесплатной библиотеки libarchive с открытым исходным кодом, позволяющей читать и записывать различные форматы архивов. Это означает, что в обозримом будущем вышеуказанный перечень может пополнится другими форматами, например, LZH, LZH и XAR.

Накопление KB5031455 не является обязательным. Пользователи могут загрузить и установить его через «Центр обновления Windows».

Правда, пока встроенный в операционную систему архиватор не выдерживает конкуренции со сторонними приложениями, когда речь заходит о скорости работы.

Содержание статьи:

- Архивация файлов в Windows 11

- Способ 1

- Способ 2

- Альтернативные варианты сжатия

- Вопросы и ответы: 0

Приветствую!

В современной Windows 11 24h2 появилась встроенная возможность сжимать* файлы и папки в архивы 7Z и TAR (в дополнении к ZIP // на мой взгляд не хватает еще RAR, GZ). Т.е. для работы с этими форматами более не нужен сторонний архиватор, а все действия можно сделать прямо из проводника (что, собственно, сегодня и хочу кратко показать…).

📌 Для справки! Зачем может понадобиться сжимать файлы в 7Z:

- для того, чтобы уменьшить размер папки/файла (например, для ее более быстрой отправки по сети, или записи на флешку). 7Z показывает хор. степень сжатия (лучше, чем у ZIP);

- чтобы иметь дело с одним архивом, а не с сотней мелких файлов;

- для шифрования файла, чтобы запаролить его (правда Windows 11 такую опцию пока не предоставляет), и др.

*

Архивация файлов в Windows 11

Способ 1

Итак…

Если у вас Windows 11 24h2+ (как узнать версию ОС) — то достаточно сделать правый клик мышки по файлу/папке и выбрать в меню «Сжать до…», затем указать формат и архив будет создан (см. скриншот ниже). 👇

Обратите внимание, что есть возможность также открыть доп. параметры для ручной настройки создания архива (стрелка-4 на скрине ниже).

Примечание: если у вас при клике ПКМ по файлу появл. классическое контекстное меню (в котором нет 7Z) — то откл. его и вкл. меню от Windows 11. Вот пример, как это делается. Также проверьте версию своей ОС.

Сжать до (после ПКМ по файлу) — Windows 11

Среди доп. параметров можно выбрать место размещения нового архива, формат, метод сжатия (для 7Z: Store, Deflare, Bzip2, LZMA 1/2, PPMd), уровень сжатия. См. пример ниже. 👇

Выберите место назначения и создайте архив — меню Windows 11

Работает архиватор быстро, в моих тестах не зависал. Из недостатков лично я бы выделил следующее:

- отсутствие возможности поставить пароль;

- нельзя добавить в уже существующий архив новые файлы (для 7Z);

- не работает в старом контекстном меню проводника (просто его многие вкл. по умолчанию в отличие от нового…).

Тем не менее считаю, что поддержка основных форматов архивов ОС Windows — дело полезное (а то иной раз после переустановки ОС, когда под-рукой нет комп. аптечки, — думаешь чем открыть архив с драйверами… 👀).

Кстати!

Открывать архивы 7Z, TAR, ZIP в Windows 11 можно как обычные файлы: по двойному клику левой кнопки мыши (только у них значок в виде папки с замочком). См. пример ниже. 👇

Открыл архив 7Z в проводнике (Windows 11)

*

Способ 2

Если функционала архиватора (встроенного в Windows 11) недостаточно — можно прибегнуть к сторонней программе. В плане работы с форматом 7Z, наверное, нет ничего лучше, чем 📌7-Zip (ссылка на офиц. сайт).

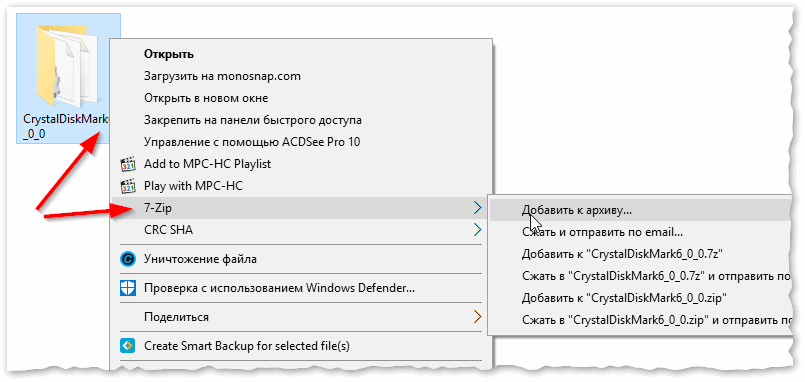

После ее установки — достаточно сделать правый клик мыши по файлу (перейти в контекстно меню, нажав показать доп. параметры), и выбрать в меню «7-ZIP -> Добавить к архиву».

7-Zip — добавить к архиву (проводник Windows)

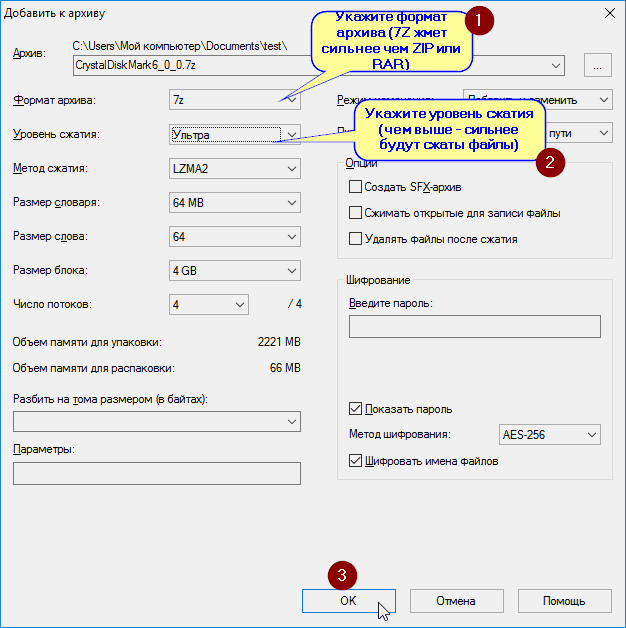

Далее откроется окно с кучей параметров. В общем случае достаточно указать формат сжатия (7Z), затем выбрать степень сжатия (например, ультра) и нажать OK. Всё просто?! 😉

Примечание: если вам нужно создать зашифрованный архив с доступом по паролю — то см. вот этот пример (он как раз для 7-ZIP).

Добавить к архиву — настройки архиватора 7-ZIP (необходимо задать основные параметры: уровень сжатия, метод, размер блока и т.д.)

Кстати, помимо 7-ZIP и WinRAR — есть и др. достаточно неплохие архиваторы, способные открывать десятки (если не сотни) всевозможных форматов. В этой заметке привел неск. таких продуктов, рекомендую к знакомству!

https://ocomp.info/arhivatoryi-analog-winrar.html

*

Альтернативные варианты сжатия

Не все файлы одинаково хорошо сжимаются. Например, картинки или видео (иногда документы в PDF, образы ISO, MDF) с помощью архиватора сжать практически не удается. И в таких случаях (при необходимости уменьшить их размер) — можно пойти «другим путем»…

О чем речь: можно попробовать их переконвертировать в иной формат, «отрезать» лишнее, удалить часть ненужных страниц (если это документ), и т.д. Несколько практических примеров для разных файлов я показал в этой заметке (рекомендую!).

https://ocomp.info/kak-umenshit-razmer-fayla.html

*

Дополнения по теме заметки — приветствуются в комментариях.

Удачи!

👋

Мне давно было интересно, как сжимаются данные, в том числе в Zip-файлах. Однажды я решил удовлетворить своё любопытство: узнать, как работает сжатие, и написать собственную Zip-программу. Реализация превратилась в захватывающее упражнение в программировании. Получаешь огромное удовольствие от создания отлаженной машины, которая берёт данные, перекладывает их биты в более эффективное представление, а затем собирает обратно. Надеюсь, вам тоже будет интересно об этом читать.

В статье очень подробно объясняется, как работают Zip-файлы и схема сжатия: LZ77-сжатие, алгоритм Хаффмана, алгоритм Deflate и прочее. Вы узнаете историю развития технологии и посмотрите довольно эффективные примеры реализации, написанные с нуля на С. Исходный код лежит тут: hwzip-1.0.zip.

Я очень благодарен Ange Albertini, Gynvael Coldwind, Fabian Giesen, Jonas Skeppstedt (web), Primiano Tucci и Nico Weber, которые дали ценные отзывы на черновики этой статьи.

Содержание

- История

- PKZip

- Info-ZIP and zlib

- WinZip

- Сжатие Lempel-Ziv (LZ77)

- Код Хаффмана

- Алгоритм Хаффмана

- Канонические коды Хаффмана

- Эффективное декодирование Хаффмана

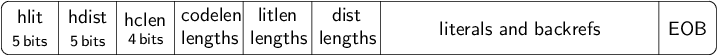

- Deflate

- Битовые потоки

- Распаковка (Inflation)

- Несжатые Deflate-блоки

- Deflate-блоки с применением фиксированных кодов Хаффмана

- Deflate-блоки с применением динамических кодов Хаффмана

- Сжатие (Deflation)

- Формат Zip-файлов

- Обзор

- Структуры данных

- Конец записи центрального каталога

- Центральный заголовок файла

- Локальный заголовок файла

- Реализация Zip-считывания

- Реализация Zip-записи

- HWZip

- Инструкции по сборки

- Заключение

- Упражнения

- Полезные материалы

История

PKZip

В восьмидесятых и начале девяностых, до широкого распространения интернета, энтузиасты-компьютерщики использовали dial-up-модемы для подключения через телефонную сеть к сети Bulletin Board Systems (BBS). BBS представляла собой интерактивную компьютерную систему, которая позволяла пользователям отправлять сообщения, играть в игры и делиться файлам. Для выхода в онлайн достаточно было компьютера, модема и телефонного номера хорошей BBS. Номера публиковались в компьютерных журналах и на других BBS.

Важным инструментом, облегчающим распространение файлов, был архиватор. Он позволяет сохранять один или несколько файлов в едином файле-архиве, чтобы удобнее хранить или передавать информацию. А в идеале архив ещё и сжимал файлы для экономии места и времени на передачу по сети. Во времена BBS был популярен архиватор Arc, написанный Томом Хендерсоном из System Enhancement Associates (SEA), маленькой компании, которую он основал со своим шурином.

В конце 1980-х программист Фил Катц выпустил собственную версию Arc — PKArc. Она была совместима с SEA Arc, но работала быстрее благодаря подпрограммам, написанным на ассемблере, и использовала новый метод сжатия. Программа стала популярной, Катц ушёл с работы и создал компанию PKWare, чтобы сосредоточиться на дальнейшей разработке. Согласно легенде, большая часть работы проходила на кухне его матери в Глендейле, штат Висконсин.

Фотография Фила Катца из статьи в Milwaukee Sentinel, 19 сентября 1994.

Однако SEA не устраивала инициатива Катца. Компания обвинила его в нарушении товарного знака и авторских прав. Разбирательства и споры в сети BBS и мире ПК стали известны как Arc-войны. В конце концов, спор был урегулирован в пользу SEA.

Отказавшись от Arc, Катц в 1989 создал новый формат архивирования, который он назвал Zip и передал в общественное пользование:

Формат файлов, создаваемых этими программами, является оригинальным с первого релиза этого программного обеспечения, и настоящим передаётся в общественное пользование. Кроме того, расширение «.ZIP», впервые использованное в контексте ПО для сжатия данных в первом релизе этого ПО, также настоящим передаётся в общественное пользование, с горячей и искренней надеждой, что никто не попытается присвоить формат для своего исключительного использования, а, скорее, что он будет использоваться в связи с ПО для сжатия данных и создания библиотек таких классов или типов, которые создают файлы в формате, в целом совместимом с данным ПО.

Программа Катца для создания таких файлов получила название PKZip и скоро распространилась в мире BBS и ПК.

Одним из аспектов, который с наибольшей вероятностью поспособствовал успеху Zip-формата, является то, что с PKZip шла документация, Application Note, в которой подробно объяснялось, как работает формат. Это позволило другим изучить формат и создать программы, которые генерируют, извлекают или как-то иначе взаимодействуют с Zip-файлами.

Zip — это формат сжатия без потерь: после распаковки данные будут такими же, как перед сжатием. Алгоритм ищет избыточности в исходных данных и эффективнее представляет информацию. Этот подход отличается от сжатия с потерями, который используется в таких форматах, как JPEG и MP3: при сжатии выбрасывается часть информации, которая менее заметна для человеческого глаза или уха.

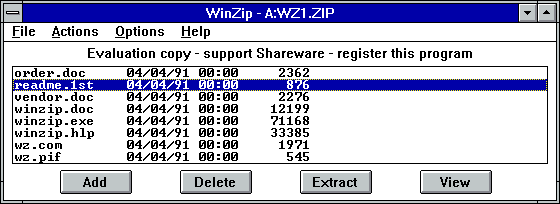

PKZip распространялась как Shareware: её можно было свободно использовать и копировать, но автор предлагал пользователям «зарегистрировать» программу. За $47 можно было получить распечатанную инструкцию, премиальную поддержку и расширенную версию приложения.

Одной из ключевых версий PKZip стала 2.04c, вышедшая 28 декабря 1992 (вскоре после неё вышла версия 2.04g). В ней по умолчанию использовался алгоритм сжатия Deflate. Версия определила дальнейший путь развития сжатия в Zip-файлах (статья, посвящённая релизу).

С тех пор Zip-формат используется во многих других форматах файлов. Например, Java-архивы (.jar), Android Application Packages (.apk) и .docx-файлы Microsoft Office используют Zip-формат. Во многих форматах и протоколах применяется тот же алгоритм сжатия, Deflate. Скажем, веб-страницы наверняка передаются в ваш браузер в виде gzip-файла, формат которого использует Deflate-сжатие.

Фил Катц умер в 2000-м. PKWare всё ещё существует и поддерживает Zip-формат, хотя компания сосредоточена в основном на ПО для защиты данных.

Info-ZIP и zlib

Вскоре после выхода PKZip в 1989-м начали появляться другие программы для распаковки Zip-файлов. Например, программа unzip, которая могла распаковывать на Unix-системах. В марте 1990-го был создан список рассылки под названием Info-ZIP.

Группа Info-ZIP выпустила бесплатные программы с открытым исходным кодом unzip и zip, которые использовались для распаковки и создания Zip-файлов. Код портировали во многие системы, и он до сих пор является стандартом для Zip-программ под Unix-системы. Позднее это помогло росту популярности Zip-файлов.

Однажды код Info-ZIP, который выполнял Deflate-сжатие и распаковку, был вынесен в отдельную библиотеку zlib, которую написали Jean-loup Gailly (сжатие) и Mark Adler (распаковка).

Jean-loup Gailly (слева) и Mark Adler (справа) на вручении им премии USENIX STUG Award в 2009-м.

Одна из причин создания библиотеки заключалась в том, что это обеспечивало удобство использования Deflate-сжатия в других приложениях и форматах, например, в новых gzip и PNG. Эти новые форматы были призваны заменить Compress и GIF, в которых применялся защищённый патентом алгоритм LZW.

В рамках создания этих форматов Питер Дойч написал спецификацию Deflate и опубликовал под названием Internet RFC 1951 в мае 1996-го. Это оказалось более доступное описание по сравнению с исходным PKZip Application Note.

Сегодня zlib используется повсеместно. Возможно, он сейчас отвечает за сжатие этой страницы на веб-сервере и её распаковки в вашем браузере. Сегодня сжатие и распаковка большинства Zip-файлов выполняется с помощью zlib.

WinZip

Многие из тех, кто не застал PKZip, пользовались WinZip. Пользователи ПК перешли как с DOS на Windows, так и с PKZip на WinZip.

Всё началось с проекта программиста Нико Мака, который создавал ПО для OS/2 в компании Mansfield Software Group в городе Сторрс-Мансфилд, штат Коннектикут. Нико использовал Presentation Manager, это графический пользовательский интерфейс в OS/2, и его расстраивало, что приходится переходить от файлового менеджера к DOS-командам каждый раз, когда он хотел создать Zip-файлы.

Мак написал простую программу с графическим интерфейсом, которая работала с Zip-файлами прямо в Presentation Manager, назвал её PMZip и выпустил в качестве shareware в 1990-м.

OS/2 так и не добилась успеха, а мир ПК захватывала Microsoft Windows. В 1991-м Мак решил научиться писать Windows-программы, и его первым проектом стало портирование своего Zip-приложения под новую ОС. В апреле 1991-го вышла WinZip 1.00. Она распространялась в качестве shareware с 21-дневным пробным периодом и стоимостью регистрации $29. Выглядела она так:

В первых версиях WinZip под капотом использовалась PKZip. Но с версии 5.0 в 1993-м для прямой обработки Zip-файлов стал использоваться код из Info-ZIP. Пользовательский интерфейс тоже постепенно эволюционировал.

WinZip 6.3 под Windows 3.11 for Workgroups.

WinZip была одной из самых популярных shareware-программ в 1990-е. Но в конце концов она потеряла актуальность из-за встраивания поддержки Zip-файлов в операционные системы. Windows работает с ними как со «сжатыми папками» начиная с 2001-го (Windows XP), для этого используется библиотека DynaZip.

Изначально компания Мака называлась Nico Mak Computing. В 2000-м её переименовали в WinZip Computing, и примерно в те годы Мак её покинул. В 2005-м компанию продали Vector Capital, и в конце концов ею стала владеть Corel, которая до сих пор выпускает WinZip в качестве продукта.

Сжатие Lempel-Ziv (LZ77)

Zip-сжатие состоит из двух основных ингредиентов: сжатия Lempel-Ziv и кода Хаффмана.

Один из способов сжатия текста заключается в создании списка частых слов или фраз с заменой разновидностей этих слов в рамках текста ссылками на словарь. Например, длинное слово «compression» в исходном тексте можно представить как #1234, где 1234 ссылается на позицию слова в списке. Это называется сжатием с использованием словаря.

Но с точки зрения сжатия универсального назначения у такого метода есть несколько недостатков. Во-первых, что именно должно попасть в словарь? Исходные данные могут быть на разных языках, это может быть даже не человеко читаемый текст. И если заранее не согласовать словарь между сжатием и распаковкой, то его придётся хранить и передавать вместе со сжатыми данными, что снижает выгоду от сжатия.

Элегантным решением этой проблемы является использование в качестве словаря самих исходных данных. В работе «A Universal Algorithm for Sequential Data Compression» 1977 года Якоб Зив и Абрахам Лемпел (работавшие в компании Technion), предложили схему сжатия, при которой исходные данные представляются в виде последовательности триплетов:

(указатель, длина, следующий)

где указатель и длина формируют обратную ссылку на последовательность символов, которую нужно скопировать из предыдущей позиции в оригинальном тексте, а следующий — это следующий символ в генерируемых данных.

Абрахам Лемпел и Якоб Зив.

Рассмотрим такие строки:

It was the best of times,

it was the worst of times,

Во второй строке последовательность «t was the w» можно представить как (26, 10, w), поскольку она воссоздаётся копированием 10 символов с позиции в 26 символов назад и до буквы «w». Для символов, которые до этого ещё не появлялись, используются обратные ссылки нулевой длины. Например, начальная «I» может быть представлена как (0, 0, I).

Эта схема получила название сжатие Lempel-Ziv, или сжатие LZ77. Однако в практических реализациях алгоритма обычно не используется часть триплета следующий. Вместо этого символы генерируются по-одиночке, а для обратных ссылок используются пары (расстояние, длина) (этот вариант называется сжатием LZSS). Как кодируются литералы и обратные ссылки — это отдельный вопрос, мы рассмотрим его ниже, когда будем разбирать алгоритм Deflate.

Этот текст:

It was the best of times,

it was the worst of times,

it was the age of wisdom,

it was the age of foolishness,

it was the epoch of belief,

it was the epoch of incredulity,

it was the season of Light,

it was the season of Darkness,

it was the spring of hope,

it was the winter of despair,

we had everything before us,

we had nothing before us,

we were all going direct to Heaven,

we were all going direct the other way

Можно сжать в такой:

It was the best of times,

i(26,10)wor(27,24)age(25,4)wisdom(26,20)

foolishnes(57,14)epoch(33,4)belief(28,22)incredulity

(33,13)season(34,4)Light(28,23)Dark(120,17)

spring(31,4)hope(231,14)inter(27,4)despair,

we had everyth(57,4)before us(29,9)no(26,20)

we(12,3)all go(29,4)direct to Heaven

(36,28)(139,3)(83,3)(138,3)way

Одним из важных свойств обратных ссылок является то, что они могут перекрывать друг друга. Такое случается тогда, когда длина больше расстояния. Например:

Fa-la-la-la-la

Можно сжать в:

Fa-la(3,9)

Вам это может показаться странным, но метод работает: после того, как скопированы байты первых трёх «-la», копирование продолжается уже с использованием недавно сгенерированных байтов.

По сути, это разновидность кодирования длин серий, при котором часть данных многократно копируется для получения нужной длины.

Интерактивный пример использования сжатия Lempel-Ziv для текстов песен показан в статье Колина Морриса Are Pop Lyrics Getting More Repetitive?.

Ниже приведён пример копирования обратных ссылок на языке С. Обратите внимание, что из-за возможного перекрытия мы не можем использовать memcpy или memmove.

/* Output the (dist,len) backref at dst_pos in dst. */

static inline void lz77_output_backref(uint8_t *dst, size_t dst_pos,

size_t dist, size_t len)

{

size_t i;

assert(dist <= dst_pos && "cannot reference before beginning of dst");

for (i = 0; i < len; i++) {

dst[dst_pos] = dst[dst_pos - dist];

dst_pos++;

}

}

Генерировать литералы легко, но для полноты воспользуемся вспомогательной функцией:

/* Output lit at dst_pos in dst. */

static inline void lz77_output_lit(uint8_t *dst, size_t dst_pos, uint8_t lit)

{

dst[dst_pos] = lit;

}

Обратите внимание, что вызывающий эту функцию должен удостовериться, что в dst достаточно места для генерируемых данных и что обратная ссылка не обращается к позиции до начала буфера.

Сложно не генерировать данные с помощью обратных ссылок в ходе распаковки, а создавать их первым делом при сжатии исходных данных. Это можно сделать по-разному, но мы воспользуемся методикой на основе хэш-таблиц из zlib, который предлагается в RFC 1951.

Будем применять хэш-таблицу с позициями трёхсимвольных префиксов, которые ранее встречались в строке (более короткие обратные ссылки пользы не приносят). В Deflate допускаются обратные ссылки в рамках предыдущих 32 768 символов — это называется окном. Это обеспечивает потоковое сжатие: входные данные подвергаются небольшой обработке за раз, при условии, что окно с последними байтами хранится в памяти. Однако наша реализация предполагает, что нам доступны все входные данные и мы можем обработать их целиком за раз. Это позволяет сосредоточиться на сжатии, а не на учёте, который необходим для потоковой обработки.

Воспользуемся двумя массивами: в head содержится хэш-значение трёхсимвольного префикса для позиции во входных данных, а в prev содержится позиция предыдущей позиции с этим хэш-значением. По сути, head[h] — это заголовок связного списка позиций префиксов с хэшем h, а prev[x] получает элемент, предшествующий x в списке.

#define LZ_WND_SIZE 32768

#define LZ_MAX_LEN 258

#define HASH_SIZE 15

#define NO_POS SIZE_MAX

/* Perform LZ77 compression on the len bytes in src. Returns false as soon as

either of the callback functions returns false, otherwise returns true when

all bytes have been processed. */

bool lz77_compress(const uint8_t *src, size_t len,

bool (*lit_callback)(uint8_t lit, void *aux),

bool (*backref_callback)(size_t dist, size_t len, void *aux),

void *aux)

{

size_t head[1U << HASH_SIZE];

size_t prev[LZ_WND_SIZE];

uint16_t h;

size_t i, j, dist;

size_t match_len, match_pos;

size_t prev_match_len, prev_match_pos;

/* Initialize the hash table. */

for (i = 0; i < sizeof(head) / sizeof(head[0]); i++) {

head[i] = NO_POS;

}

Для вставки в хэш-таблицу новой строковой позиции prev обновляется, чтобы указывать на предыдущую head, а затем обновляется сама head:

static void insert_hash(uint16_t hash, size_t pos, size_t *head, size_t *prev)

{

prev[pos % LZ_WND_SIZE] = head[hash];

head[hash] = pos;

}

Обратите внимание на операцию по модулю при индексировании в prev: нас интересуют только те позиции, которые попадают в текущее окно.

Вместо того, чтобы с нуля вычислять хэш-значение для каждого трёхсимвольного префикса, мы воспользуемся кольцевым хэшем и будем постоянно обновлять его, чтобы в его значении отражались только три последних символа:

static uint16_t update_hash(uint16_t hash, uint8_t c)

{

hash <<= 5; /* Shift out old bits. */

hash ^= c; /* Include new bits. */

hash &= (1U << HASH_SIZE) - 1; /* Mask off excess bits. */

return hash;

}

Хэш-карту потом можно использовать для эффективного поиска предыдущих совпадений с последовательностью, как показано ниже. Поиск совпадений — самая ресурсозатратная операция сжатия, поэтому мы ограничим глубину поиска по списку.

Изменение различных параметров, вроде глубины поиска по списку префиксов и выполнения ленивого сравнения, как будет описано ниже, — это способ повышения скорости за счёт снижения степени сжатия. Настройки в нашем коде выбраны так, чтобы соответствовать максимальному уровню сжатия в zlib.

/* Find the longest most recent string which matches the string starting

* at src[pos]. The match must be strictly longer than prev_match_len and

* shorter or equal to max_match_len. Returns the length of the match if found

* and stores the match position in *match_pos, otherwise returns zero. */

static size_t find_match(const uint8_t *src, size_t pos, uint16_t hash,

size_t prev_match_len, size_t max_match_len,

const size_t *head, const size_t *prev,

size_t *match_pos)

{

size_t max_match_steps = 4096;

size_t i, l;

bool found;

if (prev_match_len == 0) {

/* We want backrefs of length 3 or longer. */

prev_match_len = 2;

}

if (prev_match_len >= max_match_len) {

/* A longer match would be too long. */

return 0;

}

if (prev_match_len >= 32) {

/* Do not try too hard if there is already a good match. */

max_match_steps /= 4;

}

found = false;

i = head[hash];

while (max_match_steps != 0) {

if (i == NO_POS) {

/* No match. */

break;

}

assert(i < pos && "Matches should precede pos.");

if (pos - i > LZ_WND_SIZE) {

/* The match is outside the window. */

break;

}

l = cmp(src, i, pos, prev_match_len, max_match_len);

if (l != 0) {

assert(l > prev_match_len);

assert(l <= max_match_len);

found = true;

*match_pos = i;

prev_match_len = l;

if (l == max_match_len) {

/* A longer match is not possible. */

return l;

}

}

/* Look further back in the prefix list. */

i = prev[i % LZ_WND_SIZE];

max_match_steps--;

}

if (!found) {

return 0;

}

return prev_match_len;

}

/* Compare the substrings starting at src[i] and src[j], and return the length

* of the common prefix. The match must be strictly longer than prev_match_len

* and shorter or equal to max_match_len. */

static size_t cmp(const uint8_t *src, size_t i, size_t j,

size_t prev_match_len, size_t max_match_len)

{

size_t l;

assert(prev_match_len < max_match_len);

/* Check whether the first prev_match_len + 1 characters match. Do this

* backwards for a higher chance of finding a mismatch quickly. */

for (l = 0; l < prev_match_len + 1; l++) {

if (src[i + prev_match_len - l] !=

src[j + prev_match_len - l]) {

return 0;

}

}

assert(l == prev_match_len + 1);

/* Now check how long the full match is. */

for (; l < max_match_len; l++) {

if (src[i + l] != src[j + l]) {

break;

}

}

assert(l > prev_match_len);

assert(l <= max_match_len);

assert(memcmp(&src[i], &src[j], l) == 0);

return l;

}

Можно завершить функцию lz77_compress этим кодом для поиска предыдущих совпадений:

/* h is the hash of the three-byte prefix starting at position i. */

h = 0;

if (len >= 2) {

h = update_hash(h, src[0]);

h = update_hash(h, src[1]);

}

prev_match_len = 0;

prev_match_pos = 0;

for (i = 0; i + 2 < len; i++) {

h = update_hash(h, src[i + 2]);

/* Search for a match using the hash table. */

match_len = find_match(src, i, h, prev_match_len,

min(LZ_MAX_LEN, len - i), head, prev,

&match_pos);

/* Insert the current hash for future searches. */

insert_hash(h, i, head, prev);

/* If the previous match is at least as good as the current. */

if (prev_match_len != 0 && prev_match_len >= match_len) {

/* Output the previous match. */

dist = (i - 1) - prev_match_pos;

if (!backref_callback(dist, prev_match_len, aux)) {

return false;

}

/* Move past the match. */

for (j = i + 1; j < min((i - 1) + prev_match_len,

len - 2); j++) {

h = update_hash(h, src[j + 2]);

insert_hash(h, j, head, prev);

}

i = (i - 1) + prev_match_len - 1;

prev_match_len = 0;

continue;

}

/* If no match (and no previous match), output literal. */

if (match_len == 0) {

assert(prev_match_len == 0);

if (!lit_callback(src[i], aux)) {

return false;

}

continue;

}

/* Otherwise the current match is better than the previous. */

if (prev_match_len != 0) {

/* Output a literal instead of the previous match. */

if (!lit_callback(src[i - 1], aux)) {

return false;

}

}

/* Defer this match and see if the next is even better. */

prev_match_len = match_len;

prev_match_pos = match_pos;

}

/* Output any previous match. */

if (prev_match_len != 0) {

dist = (i - 1) - prev_match_pos;

if (!backref_callback(dist, prev_match_len, aux)) {

return false;

}

i = (i - 1) + prev_match_len;

}

/* Output any remaining literals. */

for (; i < len; i++) {

if (!lit_callback(src[i], aux)) {

return false;

}

}

return true;

}

Этот код ищет самую длинную обратную ссылку, которая может быть сгенерирована на текущей позиции. Но прежде чем её выдать, программа решает, можно ли на следующей позиции найти ещё более длинное совпадение. В zlib это называется оценкой с помощью ленивого сравнения. Это всё ещё жадный алгоритм: он выбирает самое длинное совпадение, даже если текущее более короткое позволяет позднее получить совпадение ещё длиннее и достичь более сильного сжатия.

Сжатие Lempel-Ziv может работать как быстро, так и медленно. Zopfli потратил много времени на поиски оптимальных обратных ссылок, чтобы выжать дополнительные проценты сжатия. Это полезно для данных, которые сжимаются один раз и потом многократно используются, например, для статичной информации на веб-сервере. На другой стороне шкалы находятся такие компрессоры, как Snappy и LZ4, которые сравнивают только с последним 4-байтным префиксом и работают очень быстро. Такой тип сжатия полезен в базах данных и RPC-системах, в которых время, потраченное на сжатие, окупается экономией времени при отправке данных по сети или на диск.

Идея использовать исходные данные в качестве словаря очень элегантна, но и от статичного словаря можно получить пользу. Brotli — алгоритм на основе LZ77, но он также использует большой статичный словарь из строковых, которые часто встречаются в сети.

Код LZ77 можно посмотреть в lz77.h и lz77.c.

Код Хаффмана

Вторым алгоритмом Zip-сжатия является код Хаффмана.

Термин код в данном контексте является отсылкой к системе представления данных в какой-то другой форме. В данном случае нас интересует код, с помощью которого можно эффективно представлять литералы и обратные ссылки, сгенерированные алгоритмом Lempel-Ziv.

Традиционно англоязычный текст представляют с помощью American Standard Code for Information Interchange (ASCII). Эта система присваивает каждому символу число, которые обычно хранятся в 8-битном представлении. Вот ASCII-коды для прописных букв английского алфавита:

Один байт на символ — это удобный способ хранения текста. Он позволяет легко обращаться к частям текста или изменять их, и всегда понятно, сколько байтов требуется для хранения N символов, или сколько символов хранится в N байтов. Однако это не самый эффективный способ с точки зрения занимаемого объёма. Например, в английском языке буква E используется чаще всего, а Z — реже всего. Поэтому с точки зрения объёма эффективнее использовать более короткое битовое представление для E и более длинное для Z, а не присваивать каждому символу одинаковое количество битов.

Код, который разным исходным символам задаёт кодировки разной длины, называется кодом переменной длины. Самый известный пример — азбука Морзе, в которой каждый символ кодируется точками и тире, изначально передававшимися по телеграфу короткими и длинными импульсами:

Одним из недостатков азбуки Морзе является то, что одно кодовое слово может быть префиксом другого. Например, • • − • не имеет уникального декодирования: это может быть F или ER. Это решается с помощью пауз (длиной в три точки) между буквами в ходе передачи. Однако было бы лучше, если бы кодовые слова не могли являться префиксами других слов. Такой код называется беспрефиксным. ASCII-код фиксированной длины является беспрефиксным, потому что кодовые слова всегда одной длины. Но коды переменной длины тоже могут быть беспрефиксными. Телефонные номера чаще всего беспрефиксные. Прежде чем в Швеции ввели телефон экстренной помощи 112, пришлось поменять все номера, начинавшиеся со 112. А в США нет ни одного телефонного номера, начинающегося с 911.

Для минимизации размера закодированного сообщения лучше использовать беспрефиксный код, в котором часто встречающиеся символы имеют более короткие кодовые слова. Оптимальным кодом будет такой, который генерирует самый короткий возможный результат — сумма длин кодовых слов, умноженная на их частоту появления, будет минимально возможной. Это называется беспрефиксным кодом с минимальной избыточностью, или кодом Хаффмана, в честь изобретателя эффективного алгоритма для генерирования таких кодов.

Алгоритм Хаффмана

Изучая материалы для написания своей докторской диссертации по электронной инженерии в MIT, Дэвид Хаффман прослушал курс по теории информации, который читал Роберт Фано. Согласно легенде, Фано позволил своим слушателям выбирать: писать финальный экзамен или курсовую. Хаффман выбрал последнее, и ему дали тему поиска беcпрефиксных кодов с минимальной избыточностью. Предполагается, что он не знал о том, что над этой задачей в то время работал сам Фано (самым известный методом в те годы был алгоритм Шеннона-Фано). Работа Хаффмана была опубликована в 1952-м под названием A Method for the Construction of Minimum-Redundancy Codes in 1952. И с тех пор его алгоритм получил широкое распространение.

Дэвид Хаффман пресс-релиз UC Santa Cruz.

Алгоритм Хаффмана создаёт беспрефиксный код с минимальной избыточностью для набора символов и их частоты использования. Алгоритм многократно выбирает два символа, которые реже всего встречаются в исходных данных, — допустим, Х и Y — и заменяет их на составной символ, означающий «X или Y». Частотой появления составного символа является сумма частот двух исходных символов. Кодовые слова для X и Y могут быть любыми кодовыми словами, которые присвоены составному символу «X или Y», за которым идёт 0 или 1, чтобы отличать друг от друга исходные символы. Когда входные данные уменьшаются до одного символа, алгоритм прекращает работу (видеообъяснение).

Вот пример работы алгоритма на маленьком наборе символов:

Первая итерация обработки:

Два самых редких символа, C и D, убираются из набора и заменяются составным символом, частота которого является суммой частот C и D:

Теперь самыми редкими символами стали B и составной символ с частотой 5. Они убираются из набора и заменяются составным символом с частотой 9:

Наконец, A и составной символ с частотой 9 объединяются в новый символ с частотой 15:

Весь набор свёлся к одному символу, обработка завершена.

Алгоритм создал структуру, которая называется деревом Хаффмана. Входные символы — это листья, а чем больше частота у символа, тем выше он расположен. Начиная от корня дерева можно сгенерировать кодовые слова для символов, добавляя 0 или 1, когда переходим влево или вправо соответственно. Получится так:

Ни одно кодовое слово не является префиксом для какого-то другого. Чем чаще встречается символ, тем короче его кодовое слово.

Дерево можно использовать и для декодирования: начинаем с корня и идём направо или налево для значение с 0 или 1 перед символом. Например, строка 010100 декодируется в ABBA.

Обратите внимание, что длина каждого кодового слова эквивалентна глубине соответствующего узла дерева. Как мы увидим в следующей части, нам не нужно настоящее дерево для присвоения кодовых слов. Достаточно знать длину самих слов. Таким образом, результатом работы нашей реализации алгоритма Хаффмана будут длины кодовых слов.

Для хранения набора символов и эффективного нахождения наименьших частот мы воспользуемся структурой данных двоичная куча. В частности, нас интересует min-куча, поскольку минимальное значение должно быть наверху.

/* Swap the 32-bit values pointed to by a and b. */

static void swap32(uint32_t *a, uint32_t *b)

{

uint32_t tmp;

tmp = *a;

*a = *b;

*b = tmp;

}

/* Move element i in the n-element heap down to restore the minheap property. */

static void minheap_down(uint32_t *heap, size_t n, size_t i)

{

size_t left, right, min;

assert(i >= 1 && i <= n && "i must be inside the heap");

/* While the ith element has at least one child. */

while (i * 2 <= n) {

left = i * 2;

right = i * 2 + 1;

/* Find the child with lowest value. */

min = left;

if (right <= n && heap[right] < heap[left]) {

min = right;

}

/* Move i down if it is larger. */

if (heap[min] < heap[i]) {

swap32(&heap[min], &heap[i]);

i = min;

} else {

break;

}

}

}

/* Establish minheap property for heap[1..n]. */

static void minheap_heapify(uint32_t *heap, size_t n)

{

size_t i;

/* Floyd's algorithm. */

for (i = n / 2; i >= 1; i--) {

minheap_down(heap, n, i);

}

}

Чтобы отслеживать частоту n символов, будем использовать кучу из n элементов. Также при каждом создании составного символа мы хотим «связывать» с ним оба исходных символа. Поэтому каждый символ будет иметь «элемент связи».

Для хранения n-элементной кучи и n элементов связи будем использовать массив из n * 2 + 1 элементов. Когда два символа в куче заменяются одним, мы будем использовать второй элемент для сохранения ссылки на новый символ. Этот подход основан на реализации Managing Gigabytes Уиттена, Моффата и Белла.

В каждом узле куче мы будем использовать 16 старших битов для хранения частоты символа, а 16 младших — для хранения индекса элемента связи символа. За счёт использования старших битов разница частот будет определяться результатом 32-битного сравнения между двумя элементами кучи.

Из-за такого представления нам нужно удостовериться, что частота символов всегда укладывается в 16 битов. После завершения работы алгоритма финальный составной символ будет иметь частоту всех объединённых символов, то есть эта сумма должна помещаться в 16 битов. Наша реализация Deflate будет проверять это с помощью одновременной обработки до 64 535 символов.

Символы с нулевой частотой будут получать кодовые слова нулевой длины и не станут участвовать в составлении кодировки.

Если кодовое слово достигнет заданной максимальной глубины, мы «сгладим» распределение частот, наложив частотное ограничение, и попробуем опять (да, с помощью goto). Есть и более сложные способы выполнения ограниченного по глубине кодирования Хаффмана, но этот прост и эффективен.

#define MAX_HUFFMAN_SYMBOLS 288 /* Deflate uses max 288 symbols. */

/* Construct a Huffman code for n symbols with the frequencies in freq, and

* codeword length limited to max_len. The sum of the frequencies must be <=

* UINT16_MAX. max_len must be large enough that a code is always possible,

* i.e. 2 ** max_len >= n. Symbols with zero frequency are not part of the code

* and get length zero. Outputs the codeword lengths in lengths[0..n-1]. */

static void compute_huffman_lengths(const uint16_t *freqs, size_t n,

uint8_t max_len, uint8_t *lengths)

{

uint32_t nodes[MAX_HUFFMAN_SYMBOLS * 2 + 1], p, q;

uint16_t freq;

size_t i, h, l;

uint16_t freq_cap = UINT16_MAX;

#ifndef NDEBUG

uint32_t freq_sum = 0;

for (i = 0; i < n; i++) {

freq_sum += freqs[i];

}

assert(freq_sum <= UINT16_MAX && "Frequency sum too large!");

#endif

assert(n <= MAX_HUFFMAN_SYMBOLS);

assert((1U << max_len) >= n && "max_len must be large enough");

try_again:

/* Initialize the heap. h is the heap size. */

h = 0;

for (i = 0; i < n; i++) {

freq = freqs[i];

if (freq == 0) {

continue; /* Ignore zero-frequency symbols. */

}

if (freq > freq_cap) {

freq = freq_cap; /* Enforce the frequency cap. */

}

/* High 16 bits: Symbol frequency.

Low 16 bits: Symbol link element index. */

h++;

nodes[h] = ((uint32_t)freq << 16) | (uint32_t)(n + h);

}

minheap_heapify(nodes, h);

/* Special case for less than two non-zero symbols. */

if (h < 2) {

for (i = 0; i < n; i++) {

lengths[i] = (freqs[i] == 0) ? 0 : 1;

}

return;

}

/* Build the Huffman tree. */

while (h > 1) {

/* Remove the lowest frequency node p from the heap. */

p = nodes[1];

nodes[1] = nodes[h--];

minheap_down(nodes, h, 1);

/* Get q, the next lowest frequency node. */

q = nodes[1];

/* Replace q with a new symbol with the combined frequencies of

p and q, and with the no longer used h+1'th node as the

link element. */

nodes[1] = ((p & 0xffff0000) + (q & 0xffff0000))

| (uint32_t)(h + 1);

/* Set the links of p and q to point to the link element of

the new node. */

nodes[p & 0xffff] = nodes[q & 0xffff] = (uint32_t)(h + 1);

/* Move the new symbol down to restore heap property. */

minheap_down(nodes, h, 1);

}

/* Compute the codeword length for each symbol. */

h = 0;

for (i = 0; i < n; i++) {

if (freqs[i] == 0) {

lengths[i] = 0;

continue;

}

h++;

/* Link element for the i'th symbol. */

p = nodes[n + h];

/* Follow the links until we hit the root (link index 2). */

l = 1;

while (p != 2) {

l++;

p = nodes[p];

}

if (l > max_len) {

/* Lower freq_cap to flatten the distribution. */

assert(freq_cap != 1 && "Cannot lower freq_cap!");

freq_cap /= 2;

goto try_again;

}

assert(l <= UINT8_MAX);

lengths[i] = (uint8_t)l;

}

}

Элегантной альтернативой варианту с двоичной кучей является сохранение символов в двух очередях. Первая содержит исходные символы, отсортированные по частоте. Когда создаётся составной символ, он добавляется во вторую очередь. Таким образом символ с наименьшей частотой всегда будет на первой позиции одной из очередей. Этот подход описан Jan van Leeuwen в On the Construction of Huffman Trees (1976).

Кодирование Хаффмана оптимально для беспрефиксных кодов, но в других случаях есть более эффективные способы: арифметическое кодирование и асимметричные системы счисления.

Канонические коды Хаффмана

В примере выше мы построили дерево Хаффмана: