Скачать White Paper [PDF]

Основные положения

Появление протокола NVMe расширило горизонты возможностей для систем хранения данных. Новые накопители не только сохраняют все полезные свойства традиционных SSD, но и демонстрируют совершенно новый уровень производительности и времени отклика.

Благодаря своим характеристикам NVMe-накопители являются отличным решением для многих передовых технологий. Многомерная аналитика, комплексные системы планирования ресурсов предприятия, машинное обучение и автономные производственные цепочки по-прежнему требуют серьезных долгосрочных инвестиций, но теперь их внедрение становится значительно проще и доступнее.

При этом повсеместное распространение NVMe-накопителей имеет ряд объективных ограничений, с которыми сталкиваются все производители СХД и системные интеграторы. Для enterprise-сегмента критически важным является отказоустойчивость массива и использование технологии NVMe-oF для его сетевого подключения к клиентам.

Существующие программные и аппаратные технологии создания отказоустойчивых массивов либо используют чрезмерную избыточность в виде зеркалирования, либо теряют до 65% производительности при работе в RAID 5 или RAID 6. При этом далеко не все из них имеют возможность реализовать функционал сетевого доступа к накопителям через NVMe-oF.

RAIDIX ERA является программным массивом, который разрабатывался с учетом всех особенностей NVMe. Благодаря ряду технологических инноваций и внимательному отношению к возможностям нового протокола, наш программный RAID способен продемонстрировать в RAID 6 до 97% суммарной производительности накопителей, обеспечивая минимальное время задержки даже в условиях смешанных нагрузок.

В этом документе мы рассмотрим основные особенности протокола NVMe, оценим его сильные стороны и недостатки, расскажем о возможностях RAIDIX ERA и сценариях его использования с различными типами прикладных приложений.

Протокол NVMe (Non-Volatile Memory Express) — это первый протокол, созданный специально для работы с твердотельными накопителями. Традиционные SAS и SATA разрабатывались с учетом сложной механики жесткого диска. Эти протоколы используют большое количество служебных команд, необходимых для корректного управления подвижными элементами и их бесперебойную работу.

Для flash-памяти такие команды обычно сложны и избыточны. SAS и SATA протоколы обращаются к данным на SSD по процедуре работы с жесткими дисками, которая не учитывает физические особенности flash-памяти. Протокол NVMe, наоборот, опирается на эти особенности и использует их для достижения максимальной производительности.

Высокая скорость и низкая задержка

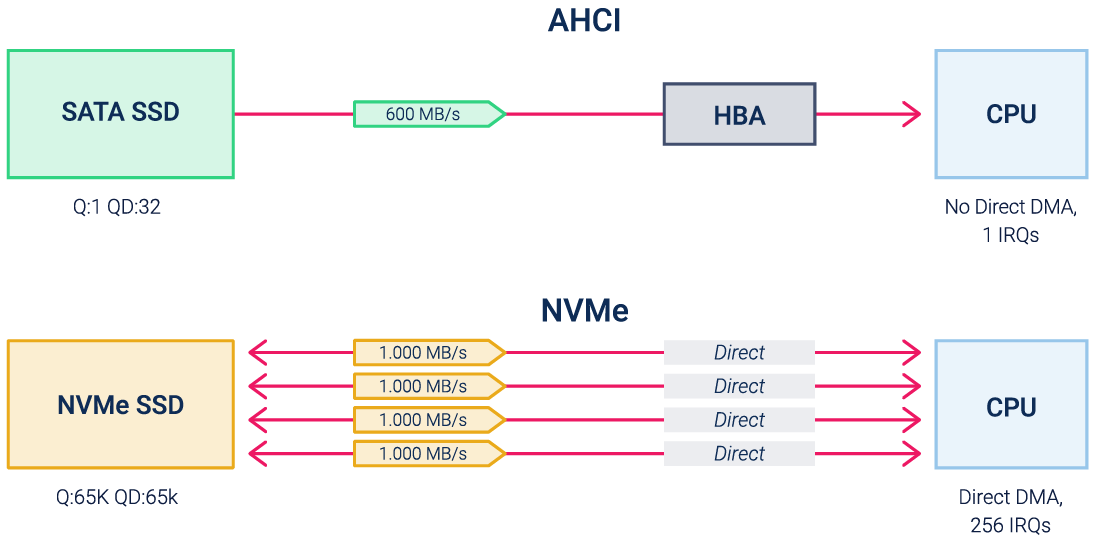

VMe работает на основе интерфейса PCIe. Протокол использует набор PCIe команд, с помощью которых приложения взаимодействуют с центральным процессором. Благодаря этому между накопителем и CPU нет уровня HBA, который увеличивает data path за счет преобразования SAS/SATA команды в PCIe.

Рисунок 1. Сравнение программных интерфейсов AHCI и NVMe

Помимо этого контроллер NVMe-накопителя поддерживает до 65 тысяч очередей передачи данных в процессор, каждая из которых может содержать более 65 тысяч команд. В SATA/SAS интерфейсах возможна лишь одна очередь с 32 или 254 командами соответственно.

Такие характеристики позволяют NVMe SSD снизить уровень задержки в два раза и в несколько раз увеличить скорость чтения и записи на случайных и смешанных нагрузках по сравнению с традиционными SSD. Благодаря этому NVMe-накопители являются основой для эффективной работы с требовательными бизнес-приложениями и такими технологиями как AI & ML, OLTP, Edge-computing и др.

NVMe-oF для сетевого доступа к данным

NVMe SSD имеет неоспоримые преимущества над SATA/SAS SSD при прямом размещении в сервере на шине PCIe. Но локальное использование накопителей подходит далеко не для всех бизнес-задач: при нем не выполняются минимальные требования по отказоустойчивости, и существуют ограничения по масштабированию и гибкости распределения ресурсов.

Поэтому технологию стоит оценивать также в контексте сетевого использования, где из-за распространения протоколов предыдущего поколения NVMe не может демонстрировать свою эффективность. Для решения этой задачи разработано расширение NVMe-oF (NVMe Over Fabric), которое позволяет использовать NVMe с транспортом Ethernet, Fiber Channel или InfiniBand.

NVMe-oF позволяет приложению на сервере взаимодействовать с внешним NVMe-массивом практически с локальным уровнем задержки. Технология предполагает также сохранение высокой производительности в сети, но на данным этапе это ограничивается возможностями сетевых адаптеров.

Поэтому для полноценного использования протокола NVMe в enterprise-сегменте важнейшим условием является поддержка NVMe-oF другими компонентами существующей инфраструктуры.

Программный RAID для NVMe

Если говорить про использование NVMe за пределами пользовательских устройств, то практически во всех сценариях требуется RAID-массив, обеспечивающий защиту данных при сбое диска. Эту цель можно достигнуть с помощью программных инструментов на уровне ОС или аппаратных RAID-контроллеров, к которым подключаются накопители. При этом, с учетом стоимости накопителей, разумным выбором будет RAID 5 или RAID 6.

Но в таком случае потребуются ресурсы на вычисление контрольных сумм и общая производительность массива будет существенно ниже суммарной производительности накопителей.

| 1 NVMe | 6 NVMe | 6 NVMe в RAID 6 |

| 800 000 IOps | 4 800 000 IOps | до 2 400 000 IOps |

В компании «Рэйдикс» мы разработали RAIDIX ERA — собственный программный RAID для NVMe и SSD, в котором расчет четности учитывает основные особенности нового протокола. Это позволяет обеспечить массиву до 97% суммарной производительности NVMe-накопителей.

| 1 NVMe | 6 NVMe | 6 NVMe в RAID 6 (RAIDIX ERA) |

| 800 000 IOps | 4 800 000 IOps | 4 600 000 IOps |

Быстрый RAID для Linux

RAIDIX ERA представляет собой модуль ядра Linux, который создает из накопителей массив и предоставляет его клиенту в виде блочного устройства. Поддержка POSIX API обеспечивает ему универсальность использования, устраняя необходимость модифицировать приложения или файловые системы.

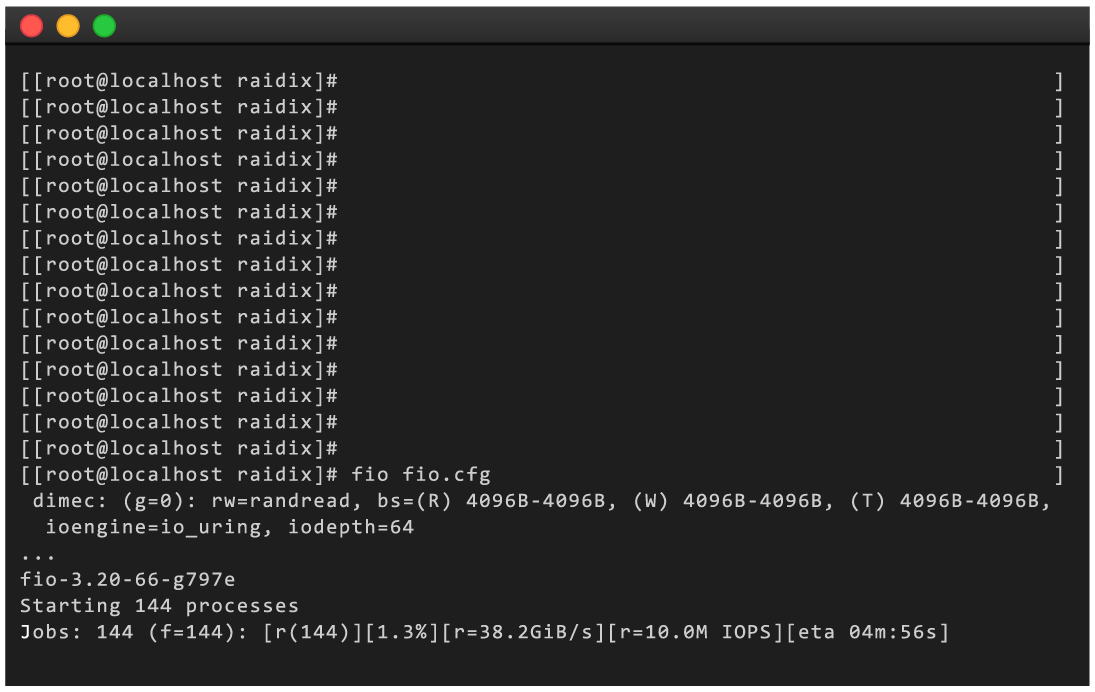

RAIDIX ERA использует технологию параллелизации вычислений и lockless-архитектуру для снижения барьеров внутри массива, благодаря чему собранный RAID может демонстрировать скорость работы до 10M IOps и 55 GBps. Массив сохраняет высокую производительность и низкую задержку (< 0.5ms) даже в режиме смешанной нагрузки.

Для обеспечения отказоустойчивости RAIDIX ERA предлагает разные уровни массива: RAID 1/0/5/6/7.3/50/60/70. При этом при отказе накопителя массив показывает минимальную просадку производительности, которая не угрожает качеству работы приложений. Это достигается за счет инновационного подхода к векторным вычислениям в erasure coding.

Рисунок 2. Скриншот терминала с результатами тестирования RAIDIX ERA

Сравнение RAIDIX ERA с другими решениями

Мы разрабатывали RAIDIX ERA с четким пониманием того, что продукт должен быть не только производительным, но и удобным для использования. Именно поэтому он свободно работает практически на любом серверном оборудовании, не привязан к какому-то определенному бренду накопителей и легко встраивается в состав уже существующего программно-аппаратного решения.

Также в RAIDIX ERA решена главная проблема программных массивов — чрезмерное потребление вычислительных ресурсов системы. При максимальной производительности массива нагрузка на CPU не превышает 20%, а для эффективной работы требуется менее 4 GB оперативной памяти. Также для более эффективного использования системы в RAIDIX ERA предусмотрена возможность выставления процента потребления RAM.

| Аппаратный RAID-контроллер | Программный RAID | RAIDIX ERA | |

| Производительность | Средняя | Средняя | Высокая |

| Приобретение оборудования | Да | Нет | Нет |

| Физический износ и моральное устаревание | Да | Нет | Нет |

| Неограниченное кол-во подключаемых накопителей | Нет | Да | Да |

| Поддержка NVMe-oF | Нет | Да | Да |

| Использование ресурсов RAM | — | Высокое | Низкое |

| Использование ресурсов CPU | — | Высокое | Низкое |

| Настройка приоритета использования вычислительных ресурсов | — | Нет | Да |

| Совместимость с различными серверными платформами | Нет | Да | Да |

| Совместимость с накопителями любых производителей | Нет | Да | Да |

| Легкая интеграция в решение другого вендора | Нет | Опционально | Да |

Использование RAIDIX ERA для enterprise-приложений

RAIDIX ERA позволяет создавать из NVMe-накопителей быстрый массив с высокими показателями отказоустойчивости. Он хорошо подходит для работы с требовательными enterprise-приложениями, эффективность которых напрямую зависит от времени задержки и пропускной способности back-end инфраструктуры.

Базы данных для аналитики и исследований

Анализ больших массивов данных является ключевым аспектом эффективного управления в крупных современных предприятиях и при проведении масштабных фундаментальных исследований.

Большинство аналитических приложений для таких задач имеют характерный паттерн нагрузки на систему хранения: небольшие и регулярные запросы на запись и постоянные запросы на чтение больших блоков данных. За счет высокой пропускной способности (до 55 ГБ/с) RAIDIX ERA позволяет базам данных быстрее передавать аналитическим приложениям запрашиваемые массивы данных. Это повышает итоговую эффективность всего процесса и сокращает время получения аналитических результатов.

Обработка транзакций в режиме реального времени (OLTP)

OLTP-приложения являются одним из ключевых технологических решений в финансовом секторе, автоматизированных производственных цепочках крупных предприятий, системах учета и планирования ресурсов. С точки зрения инфраструктуры, для эффективной работы таких приложений требуется низкое время отклика и высокая скорость обработки множества мелких запросов.

NVMe-массив на базе RAIDIX ERA в качестве back-end устройства обеспечивает минимальное время отклика для транзакционных запросов и позволяет приложению выполнять большее количество операций в секунду. Помимо этого, он сохраняет высокую производительность даже в условиях интенсивных смешанных нагрузок.

Производство видео в разрешении 8K

Распространение разрешения 8K, технология HDR и повышение частоты кадров до 60 fps серьезно увеличили требования к технологическому оснащению пост-продакшн студий. Хранилище видеоматериала является в нем узким местом, от пропускной способности которого зависит не только комфорт и скорость работы команды, но и защита от возможной потери кадров при монтаже.

RAIDIX ERA используется в решениях для видеопроизводства в качестве подсистемы хранения, обеспечивая высокую скорость чтения и записи данных для одновременной работы с нескольких монтажных станций. Использование RAIDIX ERA позволяет устранить какие-либо задержки при совместном редактировании материала и предотвратить возможную потерю кадров при его обработке.

Edge-компьютинг в IoT

Периферийные вычисления или Edge-компьютинг представляет собой один из вариантов организации интернета вещей (IoT, Internet of Things). В нем вычислительные ресурсы распределенной системы размещаются в непосредственной близости от датчиков и сенсоров действующего объекта. Такая технология используется в беспилотных автомобилях и позволяет искусственному интеллекту получать сведения о дорожной ситуации с минимальной задержкой.

RAIDIX ERA применяется в беспилотных автомобилях в качестве компонента вычислительной платформы. ПО управляет NVMe-массивом и позволяет демонстрировать минимальный уровень задержки и высокую производительность даже с ограниченного количеств накопителей.

Заключение

Протокол NVMe работает на основе шины PCIe, используя более подходящий для flash-накопителей набор команд. Это дает возможность передавать данные через 65 тысяч параллельных потоков и избегать дополнительных барьеров при работе с запросами приложения.

Чтобы сохранить максимум производительности NVMe-накопителей в отказоустойчивом массиве, мы разработали RAIDIX ERA — программный RAID, который демонстрирует высокую скорость работы и низкую задержку даже в условиях интенсивной смешанной нагрузки. Продукт легко встраивается в программную среду существующих систем и способен работать с широким перечнем серверным платформ и накопителей.

Применение RAIDIX ERA в enterprise-сегменте открывает бизнесу доступ к преимуществам передовых технологий без лишних затрат на избыточную инфраструктуру. Для производителей СХД и системных интеграторов RAIDIX ERA является простым и доступным способом получить технологическое преимущество при создании производительных NVMe-решений.

В данной статье мы расскажем про разные способы организации RAID-массивов, а также покажем один из первых аппаратных RAID-контроллеров с поддержкой NVMe.

Все разнообразие применений технологии RAID встречается в серверном сегменте. В клиентском сегменте чаще всего используется исключительно программный RAID0 или RAID1 на два диска.

В этой статье будет краткий обзор технологии RAID, небольшая инструкция по созданию RAID-массивов с помощью трех разных инструментов и сравнение производительности виртуальных дисков при использовании каждого из способов.

Что такое RAID?

Википедия дает исчерпывающее определение технологии RAID:

RAID (англ. Redundant Array of Independent Disks — избыточный массив независимых (самостоятельных) дисков) — технология виртуализации данных для объединения нескольких физических дисковых устройств в логический модуль для повышения отказоустойчивости и производительности.

Конфигурация дисковых массивов и используемые при этом технологии зависят от выбранного уровня RAID (RAID level). Уровни RAID стандартизированы в спецификации Common RAID Disk Data Format. Она описывает множество уровней RAID, однако самыми распространенными принято считать RAID0, RAID1, RAID5 и RAID6.

RAID0, или Stripes, — это уровень RAID, который объединяет два или более физических диска в один логический. Объем логического диска при этом равен сумме объемов физических дисков, входящих в массив. На этом уровне RAID отсутствует избыточность, а выход из строя одного диска может привести к потере всех данных в виртуальном диске.

Уровень RAID1, или Mirror, создает идентичные копии данных на двух и более дисках. Объем виртуального диска при этом не превышает объема минимального из физических дисков. Данные на виртуальном диске RAID1 будут доступны, пока хотя бы один физический диск из массива работает. Использование RAID1 добавляет избыточности, но является достаточно дорогим решением, так как в массивах из двух и более дисков доступен объем только одного.

Уровень RAID5 решает проблему дороговизны. Для создания массива с уровнем RAID5 необходимо как минимум 3 диска, при этом массив устойчив к выходу из строя одного диска. Данные в RAID5 хранятся блоками с контрольными суммами. Нет строгого деления на диски с данными и диски с контрольными суммами. Контрольные суммы в RAID5 — это результат операции XOR, примененной к N-1 блокам, каждый из которых взят со своего диска.

Хотя RAID-массивы повышают избыточность и предоставляют резервирование, они не подходят для хранения резервных копий.

После краткого экскурса по видам RAID-массивов можно переходить к устройствам и программам, которые позволяют собирать и использовать дисковые массивы.

Виды RAID-контроллеров

Существует два способа создать и использовать RAID-массивы: аппаратный и программный. Мы рассмотрим следующие решения:

- Linux Software RAID.

- Intel® Virtual RAID On CPU.

- LSI MegaRAID 9460-8i.

Отметим, что решение Intel® работает на чипсете, из-за чего возникает вопрос, аппаратное это решение или программное. Так, например, гипервизор VMWare ESXi считает VROC программным и не поддерживает официально.

Linux Software RAID

Программные RAID-массивы в семействе ОС Linux — достаточно распространенное решение как в клиентском сегменте, так и в серверном. Все, что нужно для создания массива, — утилита mdadm и несколько блочных устройств. Единственное требование, которое предъявляет Linux Software RAID к используемым накопителям, — быть блочным устройством, доступным системе.

Отсутствие затрат на оборудование и программное обеспечение — очевидное преимущество данного способа. Linux Software RAID организует дисковые массивы ценой процессорного времени. Список поддерживаемых уровней RAID и состояние текущих дисковых массивов можно посмотреть в файле mdstat, который находится в корне procfs:

root@grindelwald:~# cat /proc/mdstat

Personalities : [linear] [multipath] [raid0] [raid1] [raid10]

unused devices: <none>

Поддержка уровней RAID добавляется подключением соответствующего модуля ядра, например:

root@grindelwald:~# modprobe raid456

root@grindelwald:~# cat /proc/mdstat

Personalities : [linear] [multipath] [raid0] [raid1] [raid10] [raid6] [raid5] [raid4]

unused devices: <none>Все операции с дисковыми массивами производятся через утилиту командной строки mdadm. Сборка дискового массива производится в одну команду:

mdadm --create --verbose /dev/md0 --level=1 --raid-devices=2 /dev/nvme1n1 /dev/nvme2n1После выполнения этой команды в системе появится блочное устройство /dev/md0, которое представляет из тебя виртуальный диск.

Intel® Virtual RAID On CPU

Intel® VROC Standard Hardware Key

Intel® Virtual RAID On CPU (VROC) — это программно-аппаратная технология для создания RAID-массивов на базе чипсетов Intel®. Данная технология доступна в основном для материнских плат с поддержкой процессоров Intel® Xeon® Scalable. По умолчанию VROC недоступен. Для его активации необходимо установить аппаратный лицензионный ключ VROC.

Стандартная лицензия VROC позволяет создавать дисковые массивы с 0, 1 и 10 уровнями RAID. Премиальная версия расширяет этот список поддержкой RAID5.

Технология Intel® VROC в современных материнских платах работает совместно с Intel® Volume Management Device (VMD), которая обеспечивает возможность горячей замены для накопителей с интерфейсом NVMe.

Intel® VROC со стандартной лицензией Настройка массивов производится через Setup Utility при загрузке сервера. На вкладке Advanced появляется пункт Intel® Virtual RAID on CPU, в котором можно настроить дисковые массивы.

Создание массива RAID1 на двух накопителях

Технология Intel® VROC имеет свои «козыри в рукаве». Дисковые массивы, собранные с помощью VROC, совместимы с Linux Software RAID. Это означает, что состояние массивов можно отслеживать в /proc/mdstat, а администрировать — через mdadm. Эта «особенность» официально поддерживается Intel. После сборки RAID1 в Setup Utility можно наблюдать синхронизацию накопителей в ОС:

root@grindelwald:~# cat /proc/mdstat

Personalities : [raid1] [linear] [multipath] [raid0] [raid6] [raid5] [raid4] [raid10]

md126 : active raid1 nvme2n1[1] nvme1n1[0]

1855832064 blocks super external:/md127/0 [2/2] [UU]

[>....................] resync = 1.3% (24207232/1855832064) finish=148.2min speed=205933K/sec

md127 : inactive nvme1n1[1](S) nvme2n1[0](S)

10402 blocks super external:imsm

unused devices: <none>Отметим, что через mdadm нельзя собирать массивы на VROC (собранные массивы будут Linux SW RAID), но можно менять в них диски и разбирать массивы.

LSI MegaRAID 9460-8i

Внешний вид контроллера LSI MegaRAID 9460-8i

RAID-контроллер является самостоятельным аппаратным решением. Контроллер работает только с накопителями, подключенными непосредственно к нему. Данный RAID-контроллер поддерживает до 24 накопителей с интерфейсом NVMe. Именно поддержка NVMe выделяет этот контроллер из множества других.

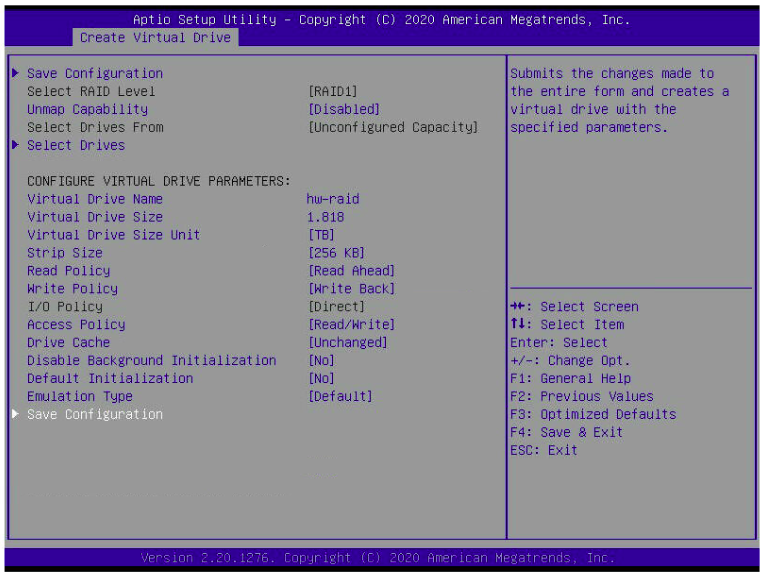

Главное меню аппаратного контроллера

При использовании режима UEFI настройки контроллера интегрируются в Setup Utility. В сравнении с VROC меню аппаратного контроллера выглядит значительно сложнее.

Создание RAID1 на двух дисках

Объяснение настройки дисковых массивов на аппаратном контроллере является достаточно тонкой темой и может стать поводом для полноценной статьи. Здесь же мы просто ограничимся созданием RAID0 и RAID1 с настройками по умолчанию.

Диски, подключенные в аппаратный контроллер, не видны операционной системе. Вместо этого контроллер «маскирует» все RAID-массивы под SAS-накопители. Накопители, подключенные в контроллер, но не входящие в состав дискового массива, не будут доступны ОС.

root@grindelwald:~# smartctl -i /dev/sda

smartctl 7.1 2019-12-30 r5022 [x86_64-linux-5.4.0-48-generic] (local build)

Copyright (C) 2002-19, Bruce Allen, Christian Franke, www.smartmontools.org

=== START OF INFORMATION SECTION ===

Vendor: AVAGO

Product: MR9460-8i

Revision: 5.14

Compliance: SPC-3

User Capacity: 1,999,844,147,200 bytes [1.99 TB]

Logical block size: 512 bytes

Rotation Rate: Solid State Device

Logical Unit id: 0x000000000000000000000000000000

Serial number: 00000000000000000000000000000000

Device type: disk

Local Time is: Sun Oct 11 16:27:59 2020 MSK

SMART support is: Unavailable - device lacks SMART capability.Несмотря на маскировку под SAS-накопители, массивы с NVMe будут работать на скорости PCIe. Однако такая особенность позволяет загружаться с NVMe в Legacy.

Тестовый стенд

Каждый из способов организации дисковых массивов имеет свои физические плюсы и минусы. Но есть ли разница в производительности при работе с дисковыми массивами?

Для достижения максимальной справедливости все тесты будут проведены на одном и том же сервере. Его конфигурация:

- 2x Intel® Xeon® 6240;

- 12x DDR4-2666 16 GB;

- LSI MegaRAID 9460-8i;

- Intel® VROC Standard Hardware Key;

- 4x Intel® SSD DC P4510 U.2 2TB;

- 1x Samsung 970 EVO Plus M.2 500GB.

Тестируемыми выступают P4510, из которых одна половина подключена к материнской плате, а вторая — к RAID-контроллеру. На M.2 установлена операционная система Ubuntu 20.04, а тесты будут выполняться при помощи fio версии 3.16.

Тестирование

В первую очередь проверим задержки при работе с диском. Тест выполняется в один поток, размер блока 4 КБ. Каждый тест длится 5 минут. Перед началом для соответствующего блочного устройства выставляется none в качестве планировщика I/O. Команда fio выглядит следующим образом:

fio --name=test --blocksize=4k --direct=1 --buffered=0 --ioengine=libaio --iodepth=1 --loops=1000 --runtime=300 --rw=<mode> --filename=<blkdev>Из результатов fio мы берем clat 99.00%. Результаты приведены в таблице ниже.

Помимо задержек при обращении к данным, хочется увидеть производительность виртуальных накопителей и сравнить с производительностью физического диска. Команда для запуска fio:

fio --name=test --blocksize=4k --direct=1 --buffered=0 --ioengine=libaio --loops=1000 --runtime=300 --iodepth=<threads> --rw=<mode> --filename=<blkdev>Производительность измеряется в количестве операций ввода-вывода. Результаты представлены в таблице ниже.

Легко заметить, что использование аппаратного контроллера дает увеличение задержек и просадку по производительности в сравнении с программными решениями.

Заключение

Использование аппаратных решений для создания дисковых массивов из двух дисков выглядит нерационально. Тем не менее, существуют задачи, где использование RAID-контроллеров оправдано. С появлением контроллеров с поддержкой интерфейса NVMe у пользователей появляется возможность использовать более быстрые SSD в своих проектах.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

Вы используете RAID-решения?

35.54% Да, аппаратные решения86

43.39% Да, программные решения105

Проголосовали 242 пользователя. Воздержались 34 пользователя.

Этот раздел адресуется тем, кто планирует систему со скоростным хранилищем большой емкости. Когда требуемый объем содержит группу NVMe SSD, объединенных в RAID массив.

Рассмотрим варианты объединения NVMe SSD в RAID и производительность каждого решения.

Доступны четыре варианта построения системы:

— программный средствами ОС;

— программно-аппаратный Intel VROC;

— аппаратный контроллер Broadcom MegaRAID;

— программно-определяемое хранилище (SDS).

Сценарии использования накопителя или массива NVMe SSD накопителей приведены в отдельной заметке.

В общей «картине» системы хранения не стоит забывать, что скоростные возможности интерфейса — это важный, но только один из множества параметров, влияющих на общую производительность.

Корпоративное основное хранилище ОБЯЗАНО быть защищенным избыточностью — это не обсуждается. Другое дело — что цена (в широком смысле, не только «стоимость») защищенности должна рассматриваться в комплексе. Принцип всех времен и народов: «Быстро, дешево, надежно — выбери два из трех!» никто не отменял.

Варианты строительства RAID массива из накопителей NVMe существенно различаются по стоимости реализации и производительности.

В нашем случае, когда подсистема NVMe является скоростной частью системы хранения сервера или группы серверов, производительность ставится во главу угла. Иначе — зачем вообще городить огород?

Максимальную скорость NVMe накопители показывают при непосредственном подключении к хост-контроллеру.

Без особенных потерь происходит объединение накопителей в RAID0, базирующееся на драйверах хост-контроллера или функциях операционной системы.

Производительность в RAID0 растет практически пропорционально количеству накопителей.

Не удивительно, что накопители в RAID0 представляются в тестах производительности систем в маркетинговых материалах, поскольку позволяют показать «красивые» цифры.

Однако, в реальной жизни организациям чаще требуется основное хранилище с защитой от потери данных. А это значит — RAID1, 5, 6, 50, 60.

Итак, смотрим плюсы-минусы вариантов, приняв во внимание предыдущие рассуждения об требуемом уровне RAID.

Показатели производительности подсистемы NVMe

В разных тестах используются SSD различных производителей и разные платформы тестирования. Но информационная база сейчас не настолько обширна, чтобы собрать воедино данные по всем вариантам использования конкретного накопителя. Приходится пользоваться тем — что есть. Важно понимать качественные изменения параметров.

В качестве показателей производительности для NVMe SSD и подсистемы NVMe в целом принят ряд метрик, показывающих скоростные характеристики для различных сценариев нагрузки (параметры и методики их измерения описаны в спецификации SNIA):

— IOPS (Input/Output Operations Per Second) — количество операций ввода/вывода в секунду. Это показатель скорости системы на случайных коротких запросах. Он зависит от размера блока, внутреннего устройства накопителя и настроек хост-контроллера;

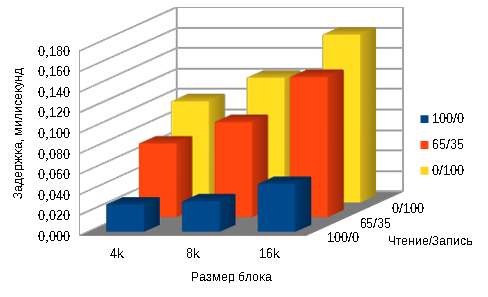

— средняя и максимальная задержка передачи. Время, затраченное подсистемой хранения на получение запроса и подготовку ответа. Во многом определяется внутренним устройством контроллера накопителя. Средняя задержка замеряется на блоках трех размеров (8KiB, 4KiB, 0.5KiB) и в трех соотношениях чтение/запись (100/0, 65/35, 0/100) при глубине очереди =1;

— пропускная способность системы. Показатель скорости последовательного чтения/записи. Измеряется на операциях с блоками большого размера — 128k и 1m. Этот параметр больше относится к тестированию накопителей и показывает максимальную скорость выдачи последовательных данных без ограничений со стороны интерфейса. В тестах пропускная способность рассматривается с точки зрения влияния на нее программного обеспечения.

Эти показатели относятся к «синтетическим» тестовым системам. Группа тестовых программ пытается привязать показатели производительности к реальному применению. Они эмулируют «средние по больнице» сценарии, например, для баз данных или нагрузку, создаваемую пулом виртуальных машин.

Отдельный NVMe SSD

Нам нужна отправная точка. Какая-то печка, от которой можно плясать.

Показатели тестов скорости Intel SSD DC D3700 Series взяты у коллег из Рэйдикс (https://habr.com/ru/company/raidix/blog/420837/).

Тестировался 800GB SSD в 2.5″ исполнении с интерфейсом PCIe 3.0 2×2. В основе — MLC технология флеш.

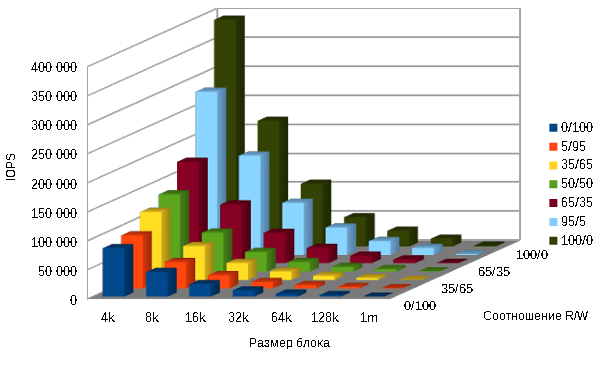

В таблице измерение IOPS 800GB Intel DC D3700 Series накопителя.

Значения IOPS убывают почти пропорционально размеру блока передаваемых данных (391 000 — 1 700). Генерируемый при этом поток данных, который является произведением этих величин, остается, практически, постоянным.

Динамика кривой убывания IOPS при увеличении доли запросов на запись (391 000 — 84 000) менее крутая, но приводит к снижению показателя в 4,6 раза. Это объясняется внутренней логикой и процессами чтения/записи собственно накопителя SSD и к интерфейсу не имеет отношения.

| Block size / R/W |

0/100 | 5/95 | 35/65 | 50/50 | 65/35 | 95/5 | 100/0 |

| 4k | 84 018 | 91 394 | 117 272 | 133 059 | 175 087 | 281 131 | 390 969 |

| 8k | 42 603 | 45 736 | 58 980 | 67 321 | 101 357 | 171 317 | 216 551 |

| 16k | 21 619 | 22 835 | 29 704 | 33 821 | 52 553 | 89 731 | 108 347 |

| 32k | 10 929 | 11 322 | 14 787 | 16 811 | 26 578 | 47 185 | 50 671 |

| 64k | 5 494 | 5 672 | 7 343 | 8 286 | 13 130 | 23 884 | 27 249 |

| 128k | 2 748 | 2 805 | 3 618 | 4 295 | 6 507 | 11 998 | 13 631 |

| 1m | 352 | 355 | 451 | 685 | 830 | 1 574 | 1 703 |

Для более наглядного представления, данные выведены в диаграмме:

Задержка также зависит от размера блока и соотношения Чтение/Запись, но масштаб изменений значительно меньше.

Средняя задержка накопителя 800GB Intel DC D3700 Series в зависимости от размера блока и доли запросов на чтение в миллисекундах:

| Block size/ R/W |

100/0 | 65/35 | 0/100 |

| 4k | 0,027 | 0,072 | 0,099 |

| 8k | 0,030 | 0,093 | 0,122 |

| 16k | 0,047 | 0,137 | 0,164 |

Максимальная задержка в миллисекундах:

| Block size/ R/W |

100/0 | 65/35 | 0/100 |

| 4k | 1,510 | 4,715 | 6,985 |

| 8k | 1,409 | 4,312 | 7,000 |

| 16k | 1,106 | 4,644 | 7,007 |

Пропускная способность подсистемы с одним NVMe SSD:

1MB последовательная запись — 634 MBps.

1MB последовательное чтение — 1707 MBps.

128kB последовательная запись — 620 MBps.

128kB последовательное чтение — 1704 MBps.

Теперь мы представляем как размер блока и соотношение Чтение/Запись влияют на скоростные показатели накопителя NVMe. В дальнейшем можно рассматривать сокращенные результаты испытаний (чтобы не загромождать обилием цифр), а в некоторых случаях оценочно экстраполировать результаты неполных испытаний на сочетание параметров, с которым тесты не проводились.

Группа из 12 NVMe SSD (JBOD)

Еще одна отправная точка — несколько накопителей не объединенных ни в какой массив. Она нужна для сравнения производительности. JBOD — группа накопителей без чередования (в отличие от RAID0), в котором единое логическое пространство распределено по жёстким дискам последовательно.

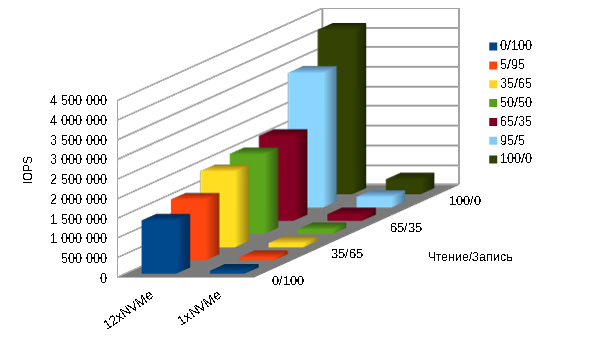

Сравнительные результаты по показателю IOPS для одного NVMe SSD и группы из 12 приведены в таблице и показаны на диаграмме ниже:

| Чтение/запись 4k |

0/100 | 5/95 | 35/65 | 50/50 | 65/35 | 95/5 | 100/0 |

| 12xNVMe | 1 363 079 | 1 562 345 | 1 944 105 | 2 047 612 | 2 176 476 | 3 441 311 | 4 202 364 |

| 1xNVMe | 84 018 | 91 394 | 117 272 | 133 059 | 175 087 | 281 131 | 390 969 |

Пропускная способность NVMe подсистемы из 12 накопителей практически линейно увеличивается пропорционально их числу:

1MБ последовательная запись — 8612 MBps.

1MБ последовательное чтение — 20481 MBps.

128Kб последовательная запись — 7500 MBps.

128Kб последовательное чтение — 20400 MBps.

Программные RAID средствами ОС и файловой системы

Стоимость решения: низкая (бесплатно).

ОС: Linux.

Производительность: приемлемая (RAID0, преимущественное чтение), невысокая-низкая (RAID5, 6, высокая доля записи).

Применение: хранилище временной информации, кэш системы, основное хранилище небольшой емкости с защитой зеркалом (RAID1, RAID10).

Производительность программных реализаций RAID массива рассмотрена в заметке «Сравнение производительности программных RAID«.

Решения, построенные на утилите mdadm операционной системы Linux и на встроенных средствах файловой системы ZFX самые дешевые. По производительности только RAID0 mdadm можно рекомендовать для использования в качестве кэш или временного накопителя и RAID6 mdadm для основного хранилища с 90-100% долей операций чтения.

Решение на Intel VROC

Стоимость решения: низкая.

ОС: Linux, Windows.

Производительность: средняя (RAID0, 1, 10), невысокая (RAID5).

Применение: хранилище временной информации, кэш системы, основное хранилище.

VROC описан на отдельной странице.

Это не очень дорогое (15 — 30 тысяч рублей) программное решение на уровне драйвера. Позволяет формировать RAID0, 1, 10 (стандартная конфигурация) или в том числе RAID5 (премиум).

На диаграмме ниже представлены результаты тестов системы из 24 NVMe SSD Ultrastar DC SN620, объединенных в RAID5 при помощи Intel VROC.

Показатель IOPS очень резко (в восемь раз) падает при соотношении Чтение/Запись 90/10. Еще в три раза — при увеличении доли записи до 30%.

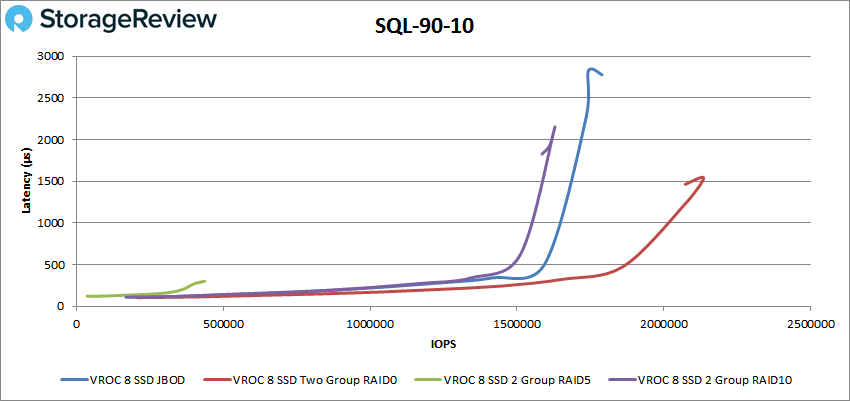

Еще одно исследование производительности NVMe системы представлено на StorageReview

Испытывалась система с восемью Intel DC P4510 NVMe SSD под управлением Intel VROC.

В презентации другие системы координат и другое представление результатов.

Вывод, выведенный изданием: «Intel VROC реализован хорошо и обеспечивает ожидаемые результаты на хорошо спроектированной платформе».

При этом, правда, в резюме умалчиваются достижения в RAID5, поскольку они невысоки.

Ниже — один из слайдов с итогами теста «SQL 90-10» (чтение-запись)

RAID массив на SAS/SATA/NVMe контроллере

Стоимость решения: невысокая.

ОС: Linux, Windows.

Производительность: сравнима с решением на VROC.

Применение: основное хранилище с защитой (RAID5, RAID6).

Контроллеры Broadcom описаны в разделе Оборудование. MegaRAID допускает прямое подключение до 4 накопителей или большее количество через коммутатор. Его имеет смысл ставить в систему в двух случаях: 1) сервер не поддерживает NVMe интерфейс; 2) не хочется забирать мощности центральных процессоров для непрофильной загрузки.

Для реализации решения помимо собственно контроллера (30 — 70 тыс. руб.) требуется корпус или корзина в корпус для установки SSD выбранного форм-фактора (как правило, U.2, но есть решения даже для M.2 накопителей — корзины ICY DOCK, например) и набор соответствующих кабелей.

Тестов производительности контроллера Broadcom в паре с NVMe накопителями практически не опубликовано. Мы представляем сравнительные тесты с VROC: Сравнение производительности Tri-Mode Broadcom MegaRAID 9460-16i и Intel VROC.

Про уровень производительности новых контроллеров от самого производителя известно лишь очень общее: «задержка снижена на 50%, производительность увеличена на 60% по сравнению с предыдущим поколением контроллеров». (https://www.broadcom.com/solutions/enterprise-storage/nvme)

Программно-определяемое хранилище (SDS).

Стоимость решения: высокая.

ОС: Linux, Windows.

Производительность: высокая.

Применение: Масштабируемое основное хранилище большой емкости с защитой данных от потери. Высокоскоростное хранилище для группы серверов.

Программно-определяемое хранилище — отдельная обширная тема. Она рассматривается в разделе Программно-определяемое хранилище.

SDS использует мощности современных процессоров и распределение нагрузки между узлами. За счет этого SDS может показывать производительность, значительно превышающую возможности аппаратных дисковых контроллеров.

С учетом того, что аппаратных NVMe RAID контроллеров, мягко говоря, немного, приходится меряться с тем — что есть.

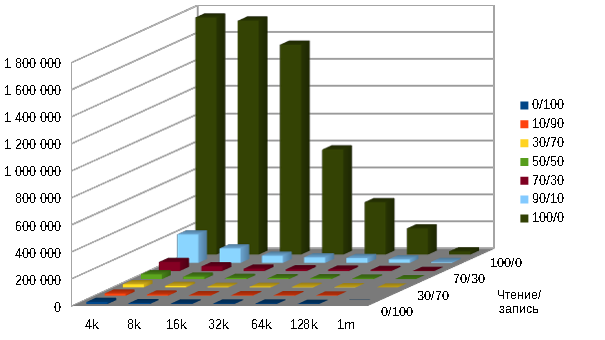

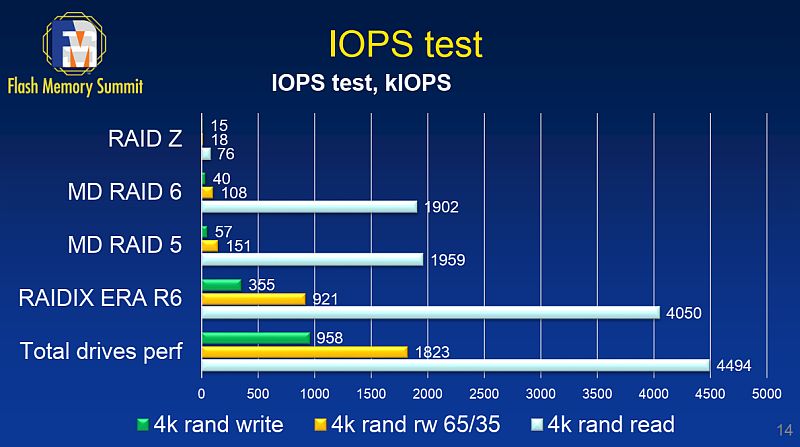

Есть сравнительные тесты RAIDIX ERA компании Рэйдикс с программными RAID на сервере с 12х Intel DC D3700 SSD (материалы Flash Memory Summit 2018)

RAIDZ (аналог RAID6 в файловой системе ZFS)

RAID6 средствами mdadm Linux

RAID5 средствами mdadm Linux

RAID6 средствами RAIDIX ERA

Суммарная предельная скорость 12 накопителей — аппаратный предел

Подробно тесты и результаты описаны в упоминавшемся уже отчете на habr, на основе которых мы сравнивали программные RAID.

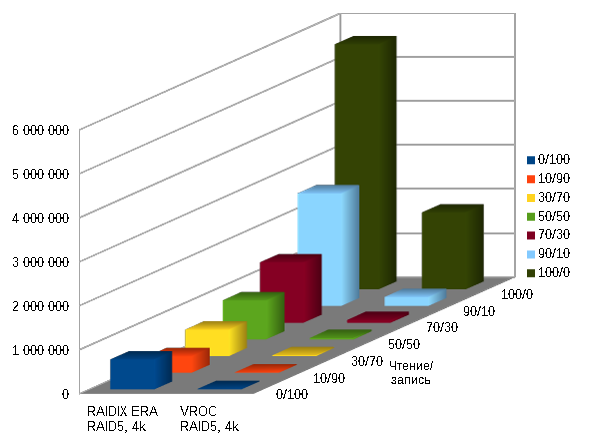

На следующей диаграмме — сравнение того же RAIDIX ERA с Intel VROC на сервере с 24х Ultrastar DC SN620 3.2TB объединенных в RAID5.

RAIDIX ERA RAID5, 4k

Intel VROC RAID5, 4k

Некоторые тесты производительности различных решений на NVMe SSD приводятся в NVMe хранилище. Тесты производительности.

Привет, друзья. Эта статья для заядлых энтузиастов компьютерной темы и, в частности, темы возможностей современных устройств информации. Возможно, для вас не являются пределом скорости современных высокопроизводительных SSD NVMe с интерфейсом PCI-E 3.0. Возможно, вы посматриваете в сторону накопителей NVMe с интерфейсом PCI-E 4.0. Такие способны на невероятную по сегодняшним меркам производительность: даже в потребительском сегменте они могут развивать скорость чтения и записи, соответственно, 7000 Мб/с и 5000 Мб/с. «Чего же желать ещё?» — можете спросить вы. Отвечаем: накопитель NVMe PCI-E 4.0. можно заставить работать ещё быстрее на 40-100%. Для этого необходимо создать дисковый массив RAID 0 из двух накопителей PCI-E 4.0. Ниже предлагаю рассмотреть конкретный пример создания такого массива из двух накопителей Samsung 980 PRO. Мы создадим и настроим RAID 0, установим на него Windows 10. Ну и, конечно же, произведём тесты его скорости чтения и записи данных.

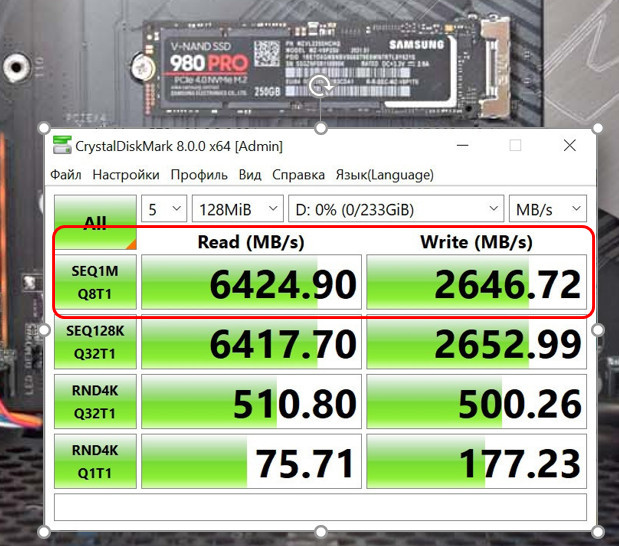

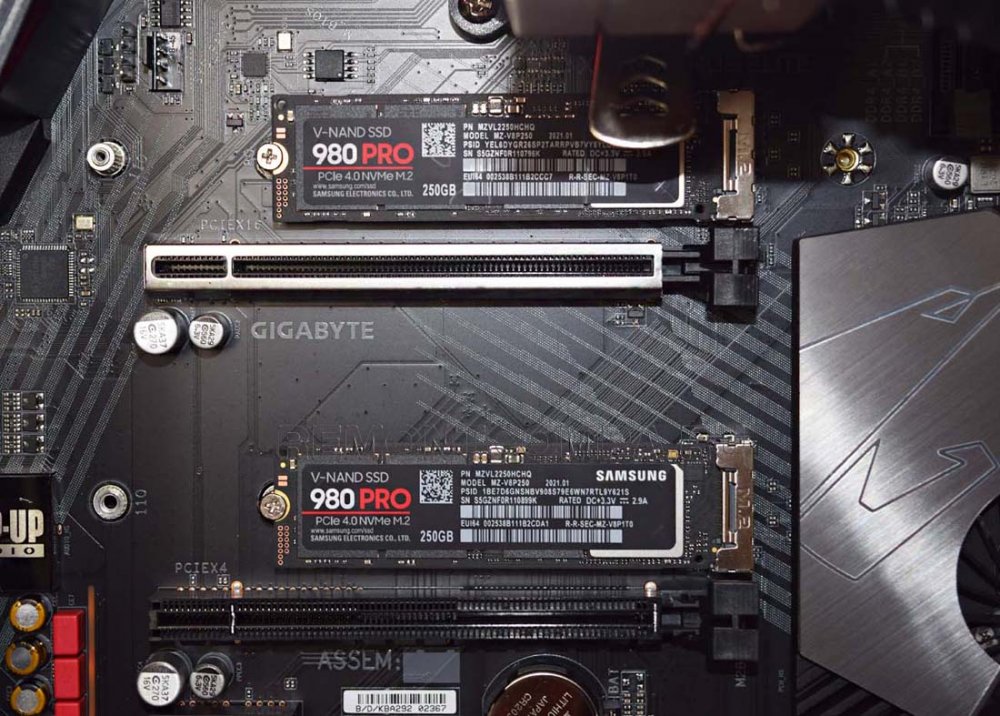

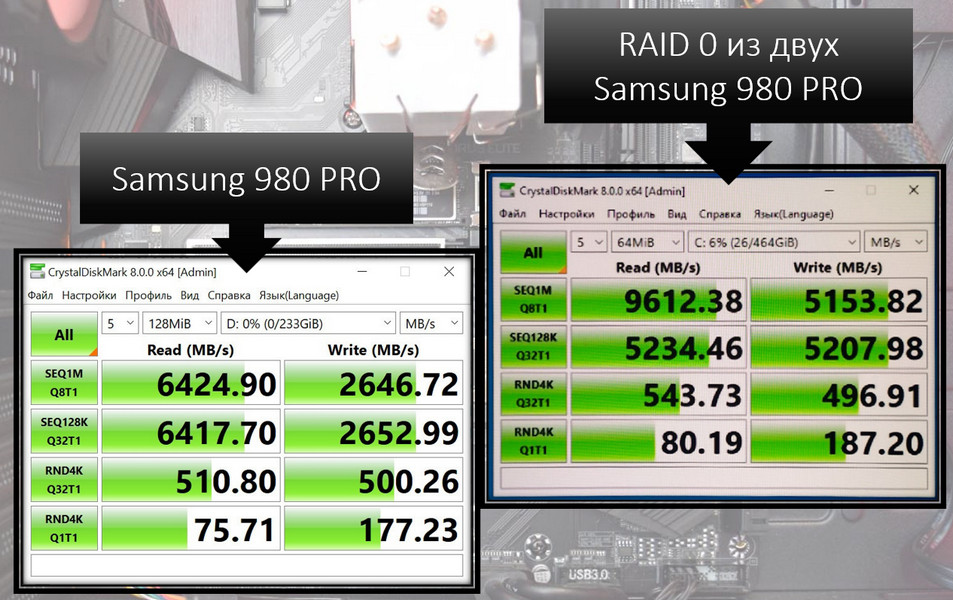

Итак, друзья, RAID 0 из двух SSD PCI-E 4.0. Если вы не особо осведомлены в теме современных накопителей M.2 PCI-E с технологией передачи данных NVMe, смотрите подборку материалов сайта по этой теме — что это за устройства, какие бывают, какие у них значимые характеристики, как выбрать и подобрать. В RAID-массиве будем использовать два идентичных высокопроизводительных накопителя, работающих с интерфейсом PCI-E 4.0 — Samsung 980 PRO на 250 Гб. Вообще-то Samsung 980 PRO является самым быстрым на сегодняшний день потребительским SSD-накопителем на базе флеш-памяти, быстрее него только дорогостоящие накопители Intel Optane на памяти 3D XPoint и серверные на флеш-памяти с 8-ю линиями PCI-E. Так, модель Samsung 980 PRO на 1 Тб читает и записывает данные с максимальной скоростью, соответственно, 7000 Мб/с и 5000 Мб/с. Если интересно, можете посмотреть детальный обзор этого накопителя на нашем сайте в статье «M.2 накопитель Samsung 980 PRO». Модель на 250 Гб, которую мы будем использовать в RAID-массиве, из-за малого объёма не такая быстрая, как модель на 1 Тб, но всё равно её возможности впечатляют, и в чтении она, в общем-то, раскрывает потенциал PCI-E 4.0: у Samsung 980 PRO на 250 Гб заявленная производителем максимальная скорость чтения 6400 Мб/с, записи — 2700 Мб/с. В синтетических тестах CrystalDiskMark накопитель почти достигает заявленных скоростей.

И вот, друзья, что будет, если и без того быстрый Samsung 980 PRO на 250 Гб поставить в паре с таким же в RAID 0 – конфигурацию дискового массива с удвоенной скоростью чтения и записи данных? Какую скорость выдаст такой массив? Давайте создавать RAID 0 и смотреть.

Примечание: у нас на сайте есть подборка статей о RAID-массивах разной избыточности. В этих статьях рассказывается об основах аппаратного и программного RAID и на конкретных примерах рассматривается их создание и настройка.

RAID 0 (striping, т.е. чередование) – это дисковый массив из двух или более устройств информации без отказоустойчивости, но с увеличенной производительностью, где скорость считывания и записи данных увеличивается в столько раз, сколько дисковых устройств отдано в массив. И если в нашем массиве будет два SSD, то, соответственно, они удвоят весь свой скоростной потенциал. При записи на массив RAID 0 информация будет распределяться на блоки и записываться одновременно на два SSD. И потом же эта информация будет считываться одновременно с двух SSD. Уязвимость RAID 0 — риск потери всей информации при выходе из строя хотя бы одного устройства информации, с рисками справляемся регулярными бэкапами.

RAID 0 мы будем создавать аппаратный, за счёт возможностей материнской платы, поддерживающей создание дисковых массивов, в частности, в конфигурации RAID 0. Возможность реализации аппаратных массивов RAID есть у многих современных материнок, за исключением разве что самых бюджетных. Но в случае с RAID-массивом из SSD M.2 PCI-E 4.0, коль мы используем накопители с PCI-E 4.0 и рассчитываем на эффект от их удвоенной скорости, материнка и процессор должны поддерживать работу обоих накопителей на интерфейсе PCI-E 4.0, а это пока что редкость и роскошь. И ещё в процессе установки операционной системы на RAID-массив нам потребуется подсунуть драйверы RAID. Друзья, даже современная Windows 10 не всегда может установить сама драйверы на RAID-массив. Например, когда мы создавали RAID 0 из двух SSD M.2 PCI-E 3.0 Samsung 970 EVO Plus, мы это делали на базе железа Intel и с накопителями PCI-E 3.0, не являющимися чем-то новым, и тогда Windows 10 в процессе установки сама решила вопрос с драйверами. Сейчас же мы будем работать с новейшими железом AMD и накопителями PCI-E 4.0, и с кое-какими заморочками насчёт драйверов RAID нам нужно будет справиться самостоятельно, но всё это решаемо.

Итак, вот что нам нужно для создания RAID 0 из двух SSD M.2 PCI-E 4.0:

Материнская плата с поддержкой аппаратного RAID 0, с поддержкой интерфейса PCI-E 4.0 и работы накопителей на интерфейсе PCI-E 4.0. В нашем случае будет использоваться Gigabyte X570 Aorus Elite;

Процессор с поддержкой PCI-E 4.0. Мы будем использовать процессор последнего поколения AMD Ryzen 5 5600X;

Два накопителя M.2 PCI-E 4.0. В нашем случае это два Samsung 980 PRO на 250 Гб. Оба накопителя подключены к компьютеру, готовы к участию в дисковом массиве, на них нет никакой ценной информации, ибо таковая в процессе создания RAID 0 теряется;

Установочный носитель с Windows 10 и драйверами RAID под используемое железо. С накопителями PCI-E 4.0 работает только современнейшее компьютерное железо, для которого драйверы обычно предоставляются только на Windows 10, посему выбор операционной системы у нас предопределён. Создаём установочную флешку UEFI Windows 10. Далее помещаем на неё драйверы RAID-контроллера. Но где их взять? Нужно зайти на страничку спецификаций материнской платы и там скачать драйверы предустановки RAID (RAID Preinstall Driver). Скачать и распаковать в какую-то отдельную папку на флешке.

Ну и давайте уже создавать RAID 0 из Samsung 980 PRO.

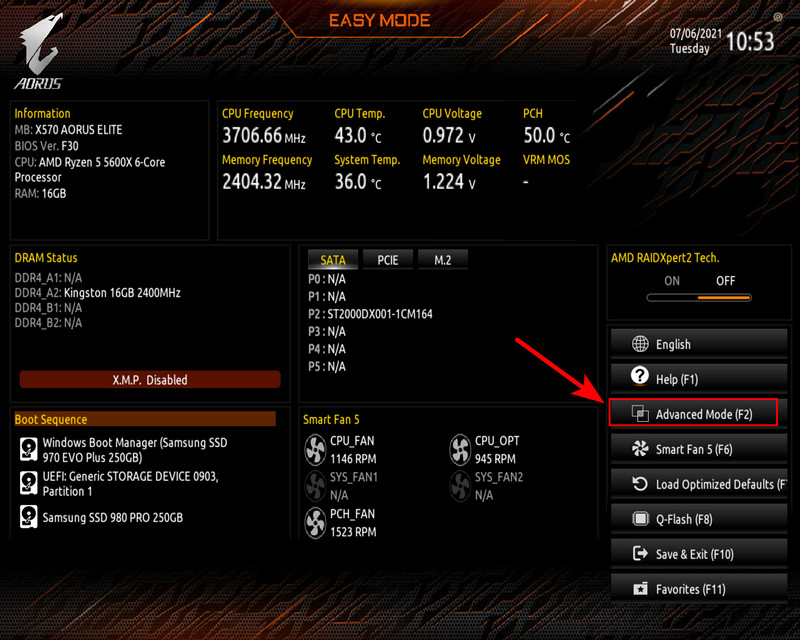

Создаётся аппаратный RAID в BIOS. Входим в BIOS материнки Gigabyte X570 Aorus Elite, идём в расширенные настройки «Advanced Mode».

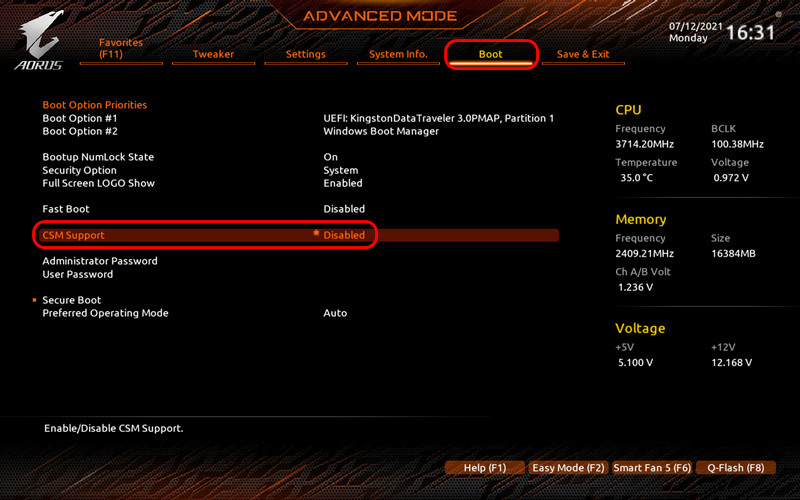

Сначала нам нужно настроить компьютер так, чтобы он работал в режиме только UEFI. Только в режиме UEFI будет функционировать RAID из SSD M.2, тогда как RAID, в составе которого будут обычные SATA SSD, может работать и в режиме совместимости UEFI/Legacy. Но у нас массив из накопителей M.2, поэтому мы идём на вкладку настроек «Boot». И опцию функции совместимости UEFI и Legacy «CSM Support» выставляем в положение «Disabled». При таком раскладе загрузка будет только в режиме UEFI.

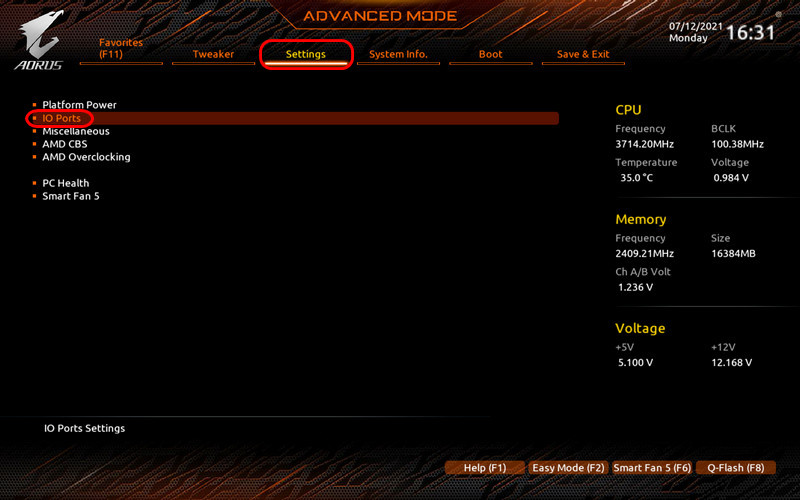

Теперь задействуем RAID. Переходим на вкладку настроек «Settings», идём в раздел «IO Ports».

Далее выбираем «SATA Configuration».

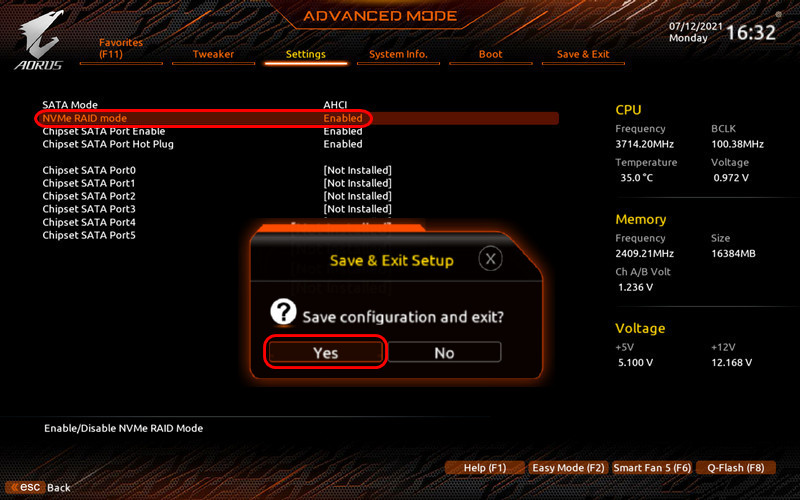

Здесь выставляем опцию «NVMe RAID mode» в положение «Enabled». Нажимаем F10, дабы сохранить произведённые нами в BIOS настройки, и перезагружаемся.

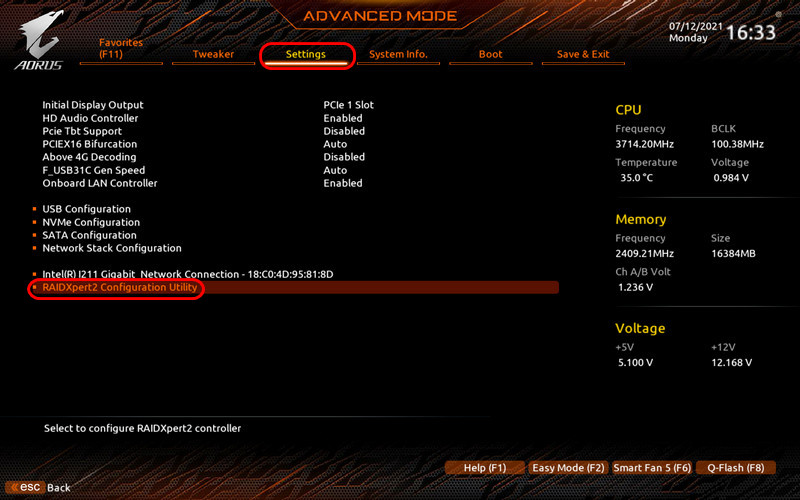

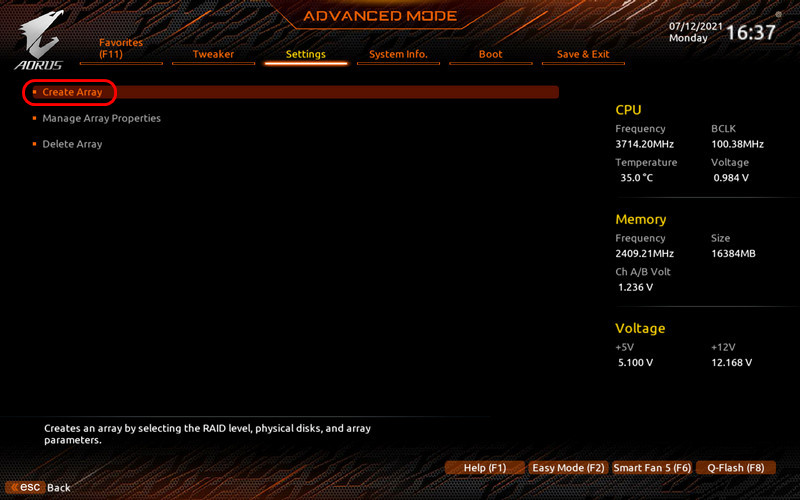

Далее снова входим в BIOS и в разделе «Settings» открываем «RAIDXpert2 Configuration Utility».

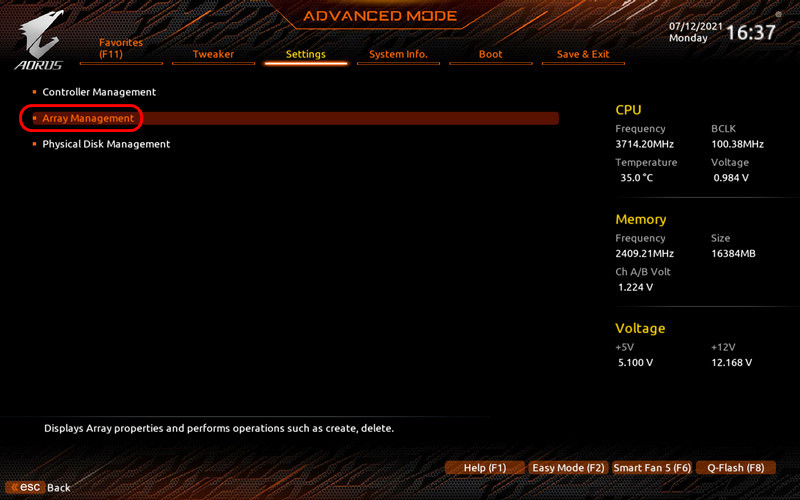

Дальше открываем управление массивом «Array Management».

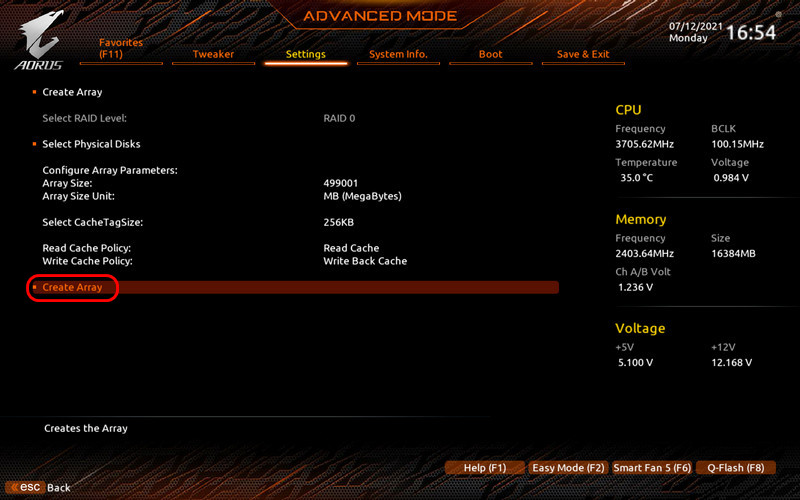

Запускаем создание массива «Create Array».

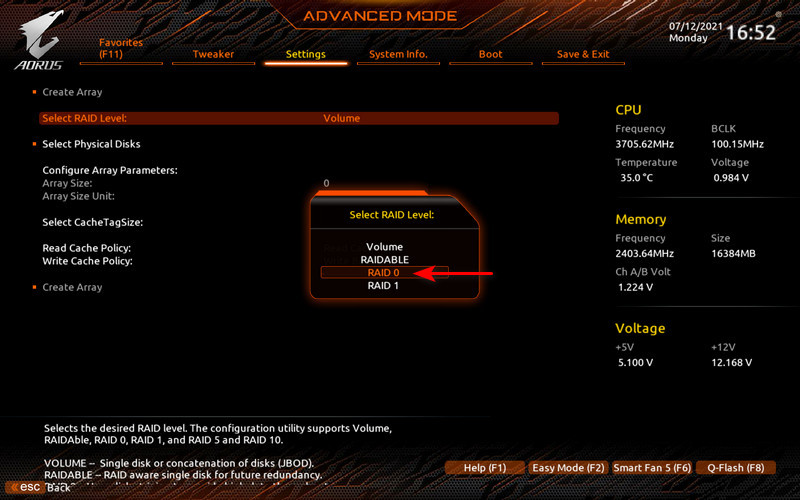

В окошке «Select a RAID level» выбираем уровень RAID, т.е. нужную нам конфигурацию RAID, в нашем случае это RAID 0.

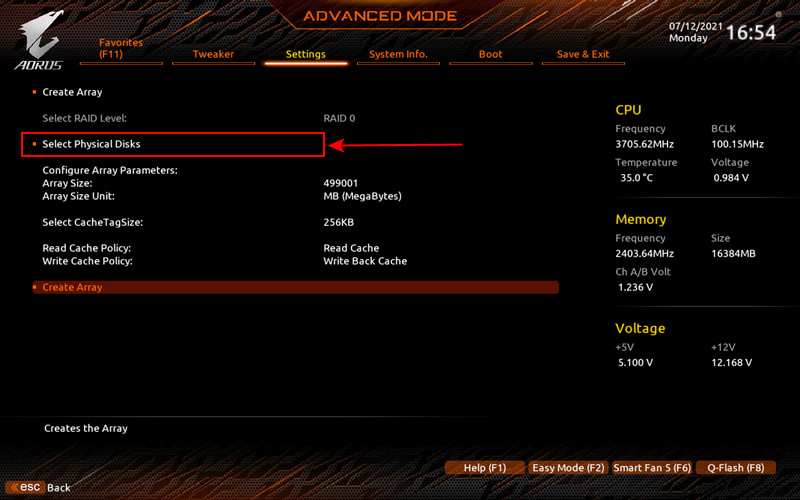

Далее нам кликаем пункт выбора физических дисков «Select Physical Disks».

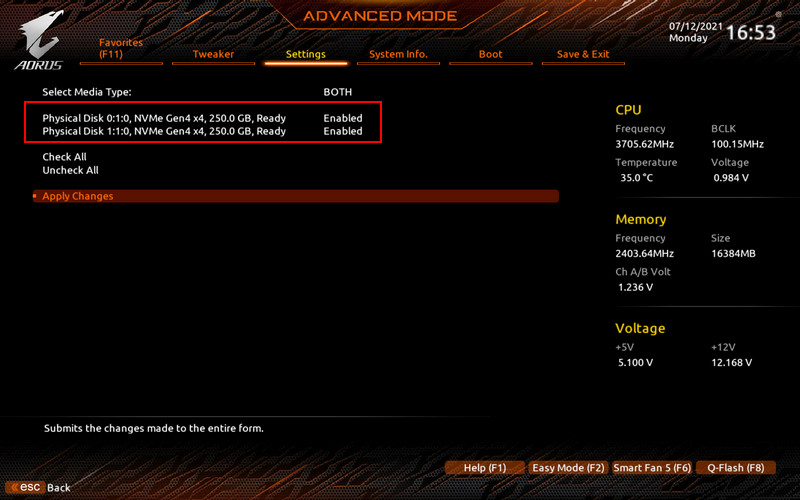

Здесь будут отображаться все SSD M.2, которые могут быть включены в массив RAID. Включаем накопители в массив установкой для них положения «Enabled» (включено).

Возвращаемся на предыдущий шаг, в раздел «Settings», кликаем создание массива «Create Array».

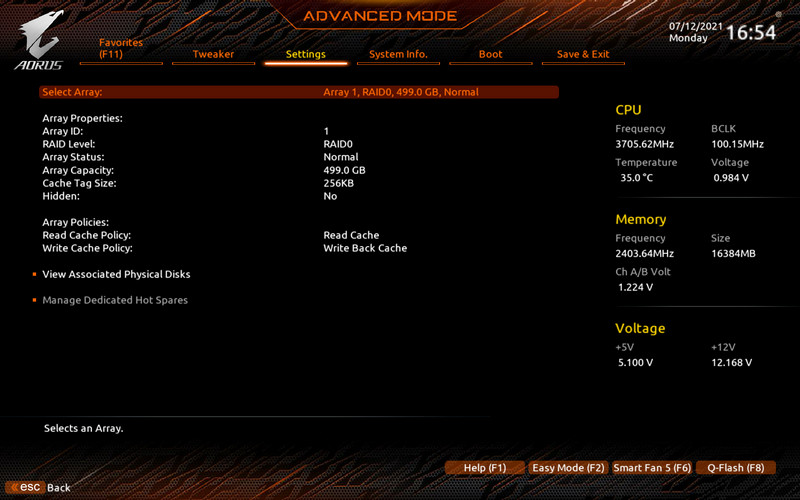

Всё, RAID 0 создан. В разделе управления свойств массивами «Manage Array Properties» теперь можем видеть информацию о созданном массиве.

Здесь отображается имя массива, ёмкость, статус работоспособности и прочие сведения.

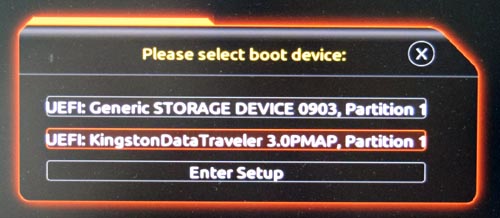

Нажимаем F10, дабы сохранить произведённые нами в BIOS настройки, и перезагружаемся. На этапе запуска компьютера вызываем Boot-меню BIOS. В нём уже значится наш RAID 0 как дисковое пространство, с которого можно загружаться. Но на этом пространстве ещё нет операционной системы, и в Boot-меню BIOS мы выбираем установочную флешку UEFI Windows 10.

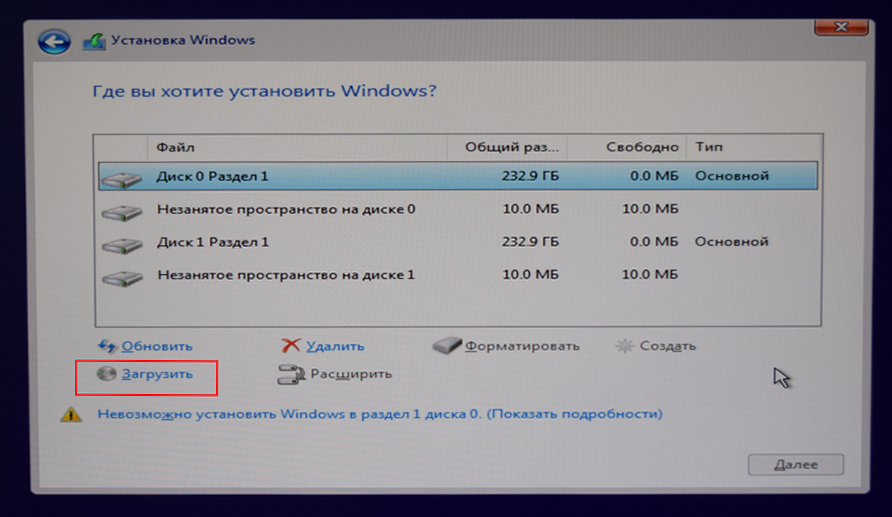

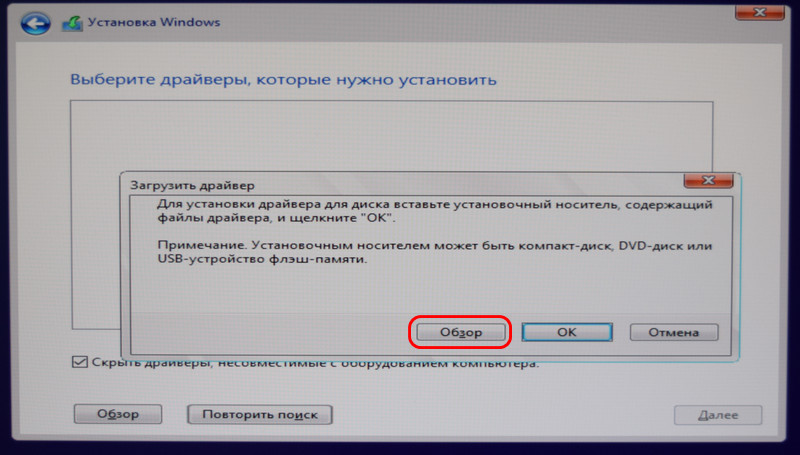

В процессе установки Windows 10 проходим первичные этапы. На этапе выбора места установки операционной системы в идеале наш дисковый массив должен значиться как одно нераспределённое пространство. Но в нашем случае установщик Windows 10 видит два разных диска, непригодных для установки операционной системы. Это из-за того, что, как упоминалось, системный установщик не всегда содержит в себе необходимые драйверы RAID-контроллера, и наш случай как раз из таковых. Но драйверы RAID у нас подготовлены и имеются на установочной флешке, добавим их. Жмём «Загрузить».

Жмём кнопку обзора.

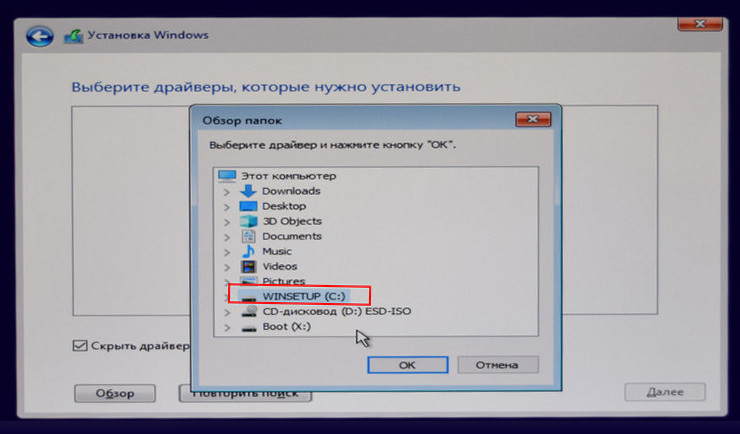

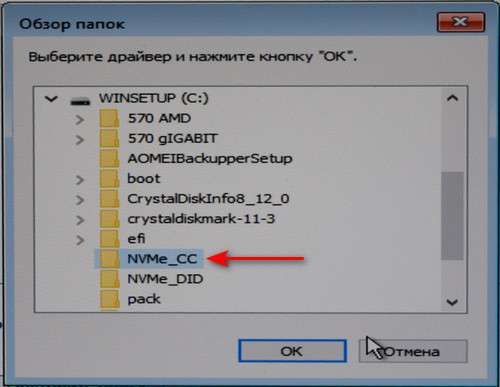

Открываем флешку.

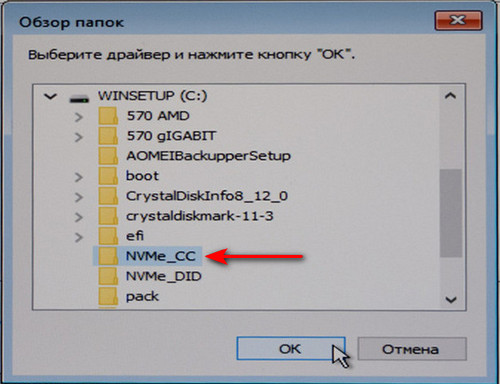

Указываем папку с распакованными драйверами RAID-контроллера.

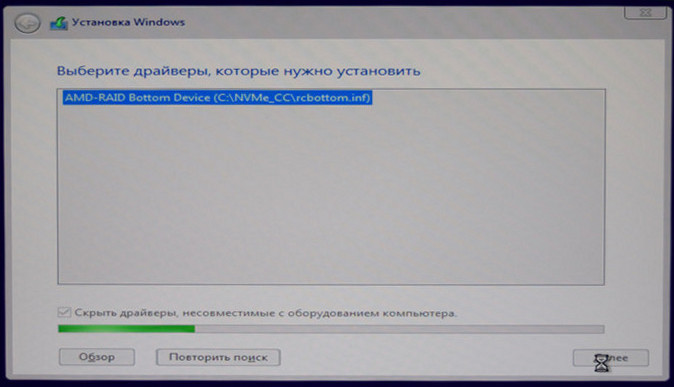

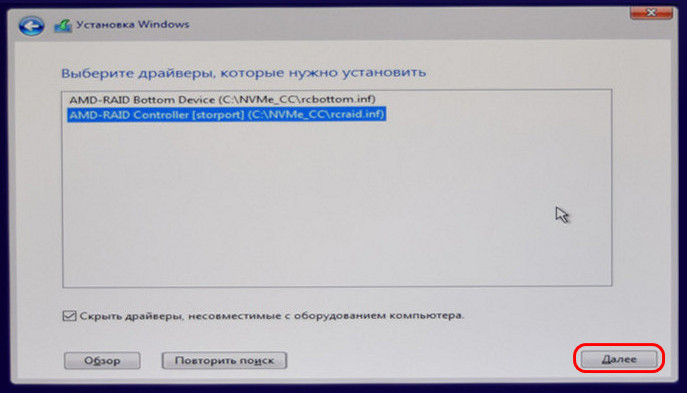

Происходит добавление драйверов на флешку.

Опять жмём кнопку обзора. И добавляем ещё один драйвер.

Жмём «Далее».

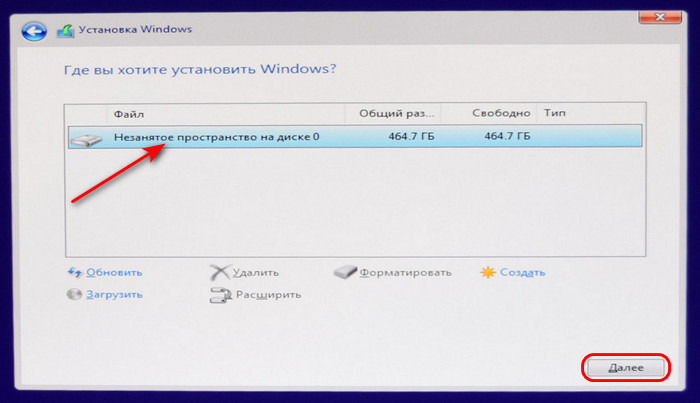

И устанавливаем Windows 10 прямо на нераспределённое пространство, коим теперь видится наш дисковый массив.

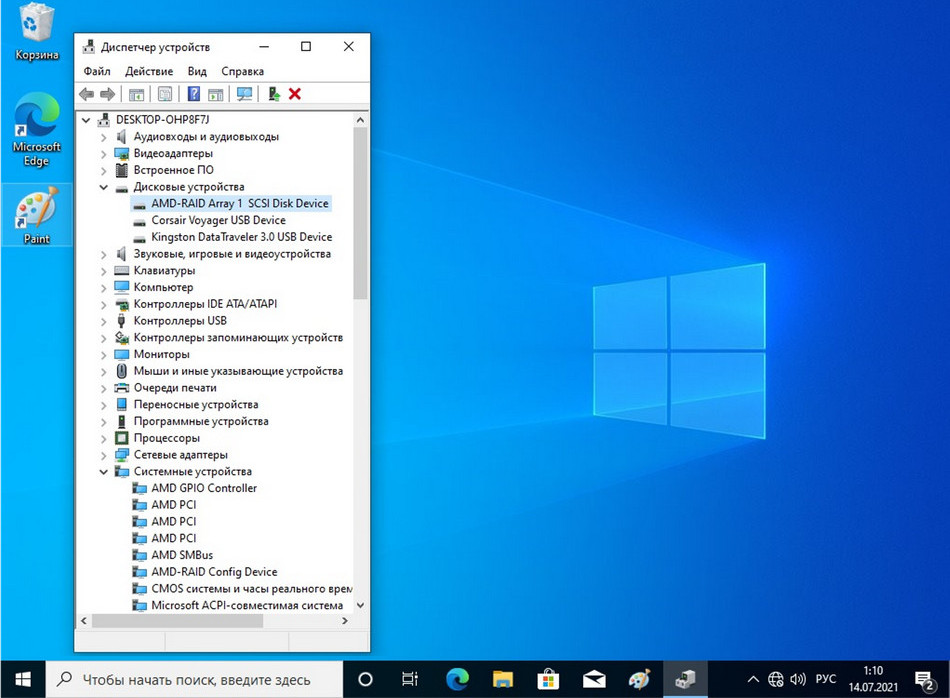

Далее устанавливаем Windows 10 как обычно. После устанавливаем все необходимые драйверы внутри операционной системы.

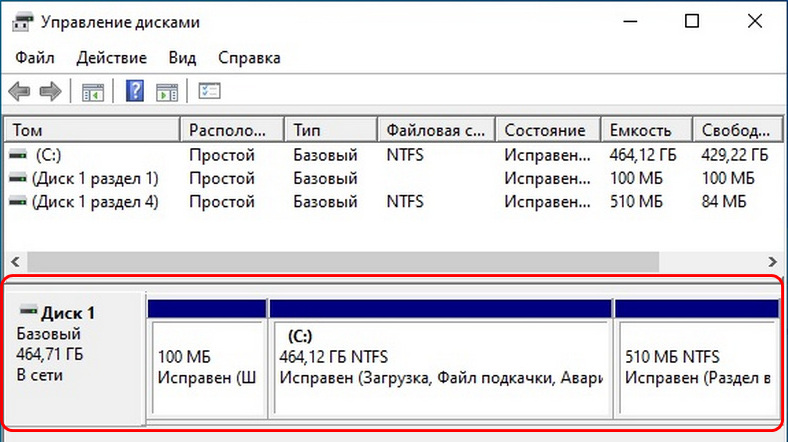

Ну и давайте посмотрим на наш массив RAID 0 в системном управлении дисками. Он значится как единое дисковое пространство, как единый диск, правда, объём его указывается как суммарный двух накопителей Samsung 980 PRO на 250 Гб — 464,71 Гб. Этот нюанс просто нужно учитывать при создании несистемных разделов с использованием системного управления дисками, либо формировать разделы с использованием профильного стороннего софта.

Ну и, друзья, самые сливки всех проделанных нами процедур – скорость массива. Какая же скорость у RAID 0 из двух SSD PCI-E 4.0? В синтетических тестах CrystalDiskMark его последовательная скорость чтения достигла неимоверных 9612 Мб/с. В последовательном чтении с глубиной очереди 8 RAID 0 оказался быстрее одного Samsung 980 PRO на 49% — 9612 Мб/с против 6424 Мб/с. Последовательная запись с глубиной очереди 8 у RAID 0 на 94%, т.е. почти вдвое быстрее, чем у одного Samsung 980 PRO — 5153 Мб/с против 2646 Мб/с.

В последовательной обработке небольших 128-килобайтных данных с глубиной 32 RAID 0 выдал только преимущество в скорости записи, также почти двукратное (на 96%) – 5207 Мб/с против 2652 Мб/с. Ну а в рандомной обработке 4-килобайтных данных RAID 0 не получил никакого перевеса, разность скоростей массива и одного накопителя Samsung 980 PRO составила лишь мелкие колебания на уровне погрешности теста. 4 Кб – это слишком маленький кусок информации, и массив попросту записывает его на один накопитель и, соответственно, читает с одного.

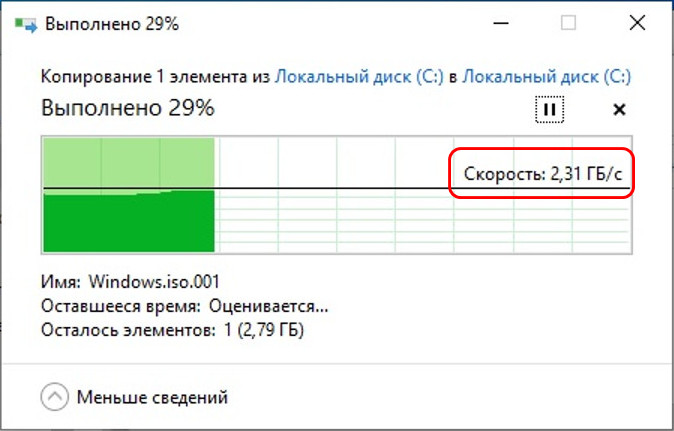

В реальном тесте копирования данных внутри массива RAID 0 он справился с ISO-файлом со средней скоростью 2,31 Гб/с, тогда как один накопитель Samsung 980 PRO эту же операцию производил со скоростью 1,2 Гб/с. Т.е. не в синтетике, а при реальной работе с данными с абсолютно разным весом мы имеем удвоенный ресурс работы накопителей Samsung 980 PRO.

Ну вот такой он, друзья, RAID 0 из двух SSD M.2 PCI-E 4.0 Samsung 980 PRO. Массив прекрасно справился с задачей последовательной записи данных, задействовав по-полной возможности обоих накопителей. Последовательное чтение в RAID 0 ускорилось только в 1,5 раза, однако результат, согласитесь, всё равно впечатляет. Для сравнения: два Samsung 980 PRO на 250 Гб, стоя каждый 6,3 тыс. руб., а вместе, соответственно, 12,6 тыс. руб., в RAID 0 могут развить скорость чтения более 9600 Мб/с. Тогда как один из самых быстро читающих на сегодняшний день накопителей Samsung PM1735 сам развивает скорость чтения только 8000 Мб/с. Но это серверный накопитель с 8-линиями PCI-E 4.0, с объёмом 12,8 Тб и стоимостью почти 274 тыс. руб. При этом максимальная запись у него лишь 3800 Мб/с. А наш RAID 0 пишет со скоростью более 5200 Мб/с. Наш массив из Samsung 980 PRO быстрее и дешевле.

Install Windows 10 or Server, have both drives installed into the system.

Disable hibernation function

powercfg.exe /h off

Start Windows and open disk management

Note the Disk #, in this case its Disk 1. You’ll need this later.

now right click on your current boot drive and select properties

verify you have an UEFI based system here, it should be GUID/GPT

open cmd.exe as admin,

Type the following: (use correct desk # from step 1 above)

diskpart select disk 1 select partition 1 detail partition

Write down the Type ID of the recovery partition and its size

Now convert the disk you would like to mirror to GPT and create a recovery partition. (use the correct disk # and size)

Select disk 2

convert gpt

select partition 1

delete partition override

create partition primary size=300

format fs=ntfs quick label=Recovery

select partition 1

set id={use your drives ID}

Now assign drive letters to both disks (using your correct disk #’s)

select disk 1 select partition 1 assign letter=x select disk 2 select partition 1 assign letter=y exit

Copy the data,

robocopy x:\ y:\ * /e /copyall /dcopy:t /xd "System Volume Information"

Now to mirror system volume,

diskpart select disk 1 list part

Write down size of system and reserved partitions from your current boot drive.

now create system and reserved partitions on the drive you would like to be the mirror,

select disk 2 create partition efi size=99 format fs=fat32 quick assign letter=w create partition msr size=128

now assign a drive letter on your current boot drive

select disk 1 select part 2 assign letter=z exit

Almost done now… Don’t you wish your system had an nvme m.2 raid controller?

Now copy EFI from boot to the mirror,

robocopy z:\ w:\ * /e /copyall /dcopy:t /xf BCD.* /xd "System Volume Information"

now close cmd and open the disk manager, diskmgmt.msc or from computer management.

right click on your boot disk and choose convert to dynamic disk

the correct disk should already be selected, click OK, Convert, and then finally Yes.

Now do the same with the disk that will be the mirror,

again the correct disk will be selected already, click OK, Convert, then Yes.

At last, we can setup the mirror,

right click on your boot drive partition and choose Add Mirror, select the correct drive and click Add Mirror.

Now open diskpart and remove the extra drive letters,

diskpart select disk 1 select part 1 remove letter=x select part 2 remove letter=z select disk 2 select part 1 remove letter=y select part 2 remove letter=w

You’re done!