В пятницу Microsoft дала производителям компьютеров отсрочку на шесть месяцев для продаж Windows XP на вновь поставляемых ПК. Это не касается промышленного использования, поскольку лицензионные соглашения позволяют IT-службам продолжать устанавливать Windows XP еще долгие годы, что становится еще одним гвоздем, вбитым в гроб Vista.

Репутация Vista давно испорчена, что молчаливо признают даже в Microsoft в своей рекламной кампании.

IT-службы практически игнорируют Vista. В июне (через 18 месяцев после выпуска Vista) исследование Forrester Research показало, что лишь 8,8% корпоративных ПК во всем мире работают под управлением Vista. Тем временем Microsoft опубликовала ускоренный план выпуска Windows 7, которая может быть выпущена уже в 2010 году. Это лишь утверждает IT-службы во мнении, что следует просто пропустить Vista и подождать, пока со временем Windows 7 станет стандартом ОС для бизнеса.

Как же Vista осталась с носом? Давайте рассмотрим пять основных причин провала Vista.

5. Apple успешно демонизировала Vista

Грамотная рекламная кампания I’m a Mac от Apple успешно создала образ Vista как глючной, надоедливой и сложной в использовании системы. Только после двух лет безжалостного избиения, Microsoft недавно ответила своей кампанией I’m a PC, чтобы хоть как-то поддержать честь Windows. Похоже, им удалось вернуть немного шарма брендам ПК и Windows, но уже слишком поздно чтобы исправить никудышний образ Vista.

4. Windows XP слишком глубоко укоренилась.

В 2001 году, когда была выпущена Windows XP, в мире насчитывалось около 600 миллионов компьютеров. Более 80% из них работали под управлением Windows, но они были разделены между двумя основными платформами: Windows 9x (65%) и Windows NT/2000 (26%). Одной из главных целей Windows XP было объединить платформы и эта цель со временем была достигнута.

В 2008 году, в мире уже более 1,1 миллиарда компьютеров и более 70% под управлением Windows XP. Это означает, что почти на 800 миллионах компьютеров используется XP, что делает ее самой широко распространенной операционной системой всех времен! Это огромная инертность, которую надо преодолеть, особенно среди IT-отделов, которые построили свои разработки и приложения на базе Windows XP.

Хотите верьте, хотите нет, Windows XP может существенно увеличить свое присутствие на рынке в следующие несколько лет. За счет чего? За счет дешевых нетбуков, которые захватывают рынок. Эти недорогие машины достаточно мощны, чтобы обеспечить работу в интернет для большинства пользователей, но они не обладают достаточными ресурсами, чтобы запустить Windows Vista, поэтмоу они работают под Windows XP либо под Linux. Intel надеется, что этот рынок ожидает взрывной рост в ближайшие годы.

3. Vista слишком медленная

Многие годы Microsoft подвергается критике разработчиков и IT-профессионалов за «раздувание софта» — добавление слишком большого числа функций в их программы сделало код огромным, а приложения неповоротливыми. Однако, это никогда не имело значительного влияния на продажи программ. И только в случае с Vista «раздувание софта» наконец настигло Microsoft.

Vista состоит из 50 миллионов строк кода, в XP было 35 миллионов строк на момент релиза, затем она выросла примерно до 40 миллионов. «Раздувание софта» привело к существенному замедлению Vista, особенно при работе на чем-то кроме самого нового и быстрого железа. Несмотря ни на что, последняя версия Windows XP существенно производительнее последней версии Vista. Никто не захочет пользоваться новым компьютером, который будет медленнее, чем его старый компьютер.

2. Vista никто не ждал

Сейчас уже забылось, но когда в Microsoft запускали Windows XP, они старались поменять бизнес-модель распространения ОС, чтобы перейти от коробочного ПО и сменить покупателей на подписчиков. Поэтому они отказались от традиционных наименований Windows 95, Windows 98 и Windows 2000. Взамен было выбрано название Windows XP.

XP значило «experience» (опыт) и являлось частью долговременной стратегии Microsoft. Основной задачей стратегии было добиться от пользователей и организаций ежегодной платы за использование Windows — XP была по существу постоянно развивающимся продуктом, но включала в себя все обновления до тех пор, пока вы платите за подписку. Разумеется, Windows переставала работать на вашем ПК, если вы перестанете платить. Именно поэтому активация продукта пришла в паре с Windows XP.

В Microsoft выпустили Windows XP и Office XP одновременно в 2001 году, они оба включали активацию и со временем должны были привести к миграции на подписку. Однако, в конце 2001 года в Microsoft отказались от концепции подписки для Office, а вскоре вернулись к бизнес-модели коробочного ПО и к старой модели разработки для обоих продуктов.

Идея выпуска дополнительных релизов и обновлений ПО взамен глобальным коробочным релизам каждые 3-5 лет была хорошей концепцией. Microsoft просто не просчитала, как заставить эту бизнес-модель работать, и не смотря на то, что идея считалась верной, оказалось проще вернуться к старой модели, которая была просто не слишком подходящей для реалий сегодняшнего мира IT.

1. Слишком многое сломалось

Одной из главных причин популярности Windows XP стало объединение совместимости с железом, программами и драйверами, как у Windows 9x и стабильности и промышленной мощи линейки Windows NT. Проблемы совместимости были огромными. Получение одной платформы с высокой совместимостью упростило работу для пользователей, IT-служб, производителей ПО и железа.

В Microsoft забыли или пренебрегли тем фактом, что когда была выпущена Vista, несмотря на долгий бета-период, большое количество существующих программ и железа не были совместимы с Vista. Из-за этого многие распространенные программы и периферийные устройства были бесполезны в Vista, что сделало невозможным ее использование для большинства IT-отделов. Многие проблемы несовместимости возникли из-за повышенной безопасности.

После того, как Windows была атакована злобной цепочкой вирусов, червей и других деструктивных программ в начале 2000-ых, Microsoft выступила с инициативой Защищенных Информационных Систем (Trustworthy Computing), чтобы сделать свои продукты более безопасными. Одним из результатов этого стал выпуск Windows XP SP2, который проложил для XP путь к тому, чтобы оказаться самой широко распространенной ОС в мире.

Другой большой частью Защищенных Информационных Систем была еще-более-закрытая версия Windows, которую Microsoft выпустила как Vista. Это была действительно самая безопасная ОС, какую Microsoft выпускала когда либо, но ценой этого стали раздражающие пользователя функции, такие как UAC, требующие множества запутанных подтверждений для выполнения простейших действий, а также проблемы с программной несовместимостью. Одним словом, Vista сломала слишком много вещей, который пользователи привыкли делать в XP.

Заключение

Многие утверждают, что Vista на сегодня более широко распространена, чем XP на той же стадии после выпуска, поэтому похоже Vista со временем заменит XP в корпоративном сегменте. Я несогласен. У XP были прозрачные аргументы для миграции: перевести машины с Windows 9x на более стабильную и безопасную ОС, а машины с Windosw NT/2000 на ОС с лучшей совместимостью. И разумеется, вы получали преимущества использования одной ОС на всех машинах, что облегчало обслуживание.

У Vista нет существенных преимуществ для IT чтобы занять место XP. Безопасность уже не является большой проблемой, потому что XP SP2 является весьма стабильной и большинство IT-служб хорошо ее защитили. Microsoft придется отказаться от стратегии выпуска новой OS каждые 3-5 лет и просто сконцентрироваться на одной версии Windows и выпускать обновления, патчи и добавлять новые функции на регулярной основе. Большинство IT-отделов по существу уже подписаны на сервисы Microsoft, поэтому бизнес-стратегия уже готова.

Чтобы применить модель подписки для малого бизнеса и индивидуальных покупателей, вместо выключения Windows на пользовательском ПК, если он не продлил подписку, следует просто не разрешать получать новые обновления, если подписка не обновлена. Microsoft может даже работать с OEM-поставщиками, продавая что-то вроде трехлетней подписки на Windows с каждым новым ПК. Пользователь будет иметь выбор, продлевать ли свою подписку после завершения этого срока.

История Windows полна радостных возгласов и негодований пользователей — в какие-то периоды подавляющее большинство единогласно восхищалось платформой Microsoft, а иногда откровенно критиковало её. В сети даже была шутка, что каждая вторая версия Windows становится ужасной. Если постараться взглянуть на историю этой операционной системы максимально объективно, то некоторые обновления действительно кажутся неудачными. Именно о трёх самых провальных версиях Windows и написана эта статья.

Windows ME

Должна была стать Millennium Edition, но оказалась Mistake Edition

Windows Millennium Edition была выпущена в честь нового тысячелетия («millennium» переводится как «тысячелетие»), но громкая маркетинговая привязка не соответствовала действительности — операционная система оказалась провальной, а авторитетный зарубежный журнал PC World даже расшифровал аббревиатуру ME как Mistake Edition («Ошибочное издание»).

Успех Windows ME не предвещался даже на этапе создания. В начале 2000 года Microsoft выпустила Windows 2000, но эта версия предназначалась в основном для корпоративного рынка. В то же время Windows 98 было уже несколько лет, а Windows XP ещё находилась в разработке. Именно поэтому, как сейчас читают, Microsoft захотела выпустить что-то новое для обычных пользователей и, торопясь, представила Windows ME — она стала своеобразным неловким мостиком между семейством Windows 9x и будущей Windows XP.

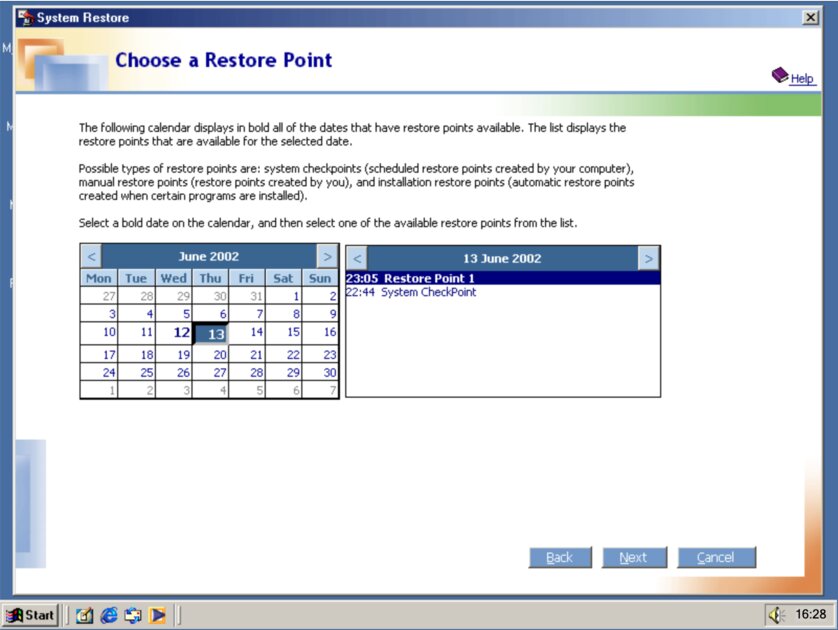

По сути, Windows ME была всё той же Windows 98, только с небольшим перечнем новых функций. Из самых важных выделялась опция «Восстановление системы» (System Restore), однако поначалу она работала с ошибками — функция иногда восстанавливала вместе с системой и вирусы, которые ранее удалил пользователь (а при выключении System Restore все точки восстановления стирались).

Каких-либо ключевых нововведений, помимо улучшенной защиты системы, не было. Более того, в Windows ME заблокировали реальный режим MS-DOS, из-за чего пользователи не могли воспользоваться определёнными старыми программами. В то время это было существенным недостатком для многих.

Однако главным недостатком Windows ME была, пожалуй, стабильность. Пользователи сталкивались с частыми сбоями, медленной работой и странными проблемами с производительностью. Разработчиков заваливали жалобами о том, что спустя несколько дней система начинала сбоить, а некоторые пользователи сталкивались с «синими экранами смерти» буквально каждые час или два.

🔴 Windows ME мало чем отличалась от Windows 98, а ключевое нововведение (точки восстановления) поначалу работало с ошибками. Более того, система была очень глючной и нестабильной, а опытных пользователей отпугивала ещё и невозможность запускать старые программы через MS-DOS.

Windows Vista

Vista — худшая версия Windows для тех, кто никогда не пользовался Windows ME. Но она этого не заслужила

Предыстории Windows Vista и Windows ME существенно отличались друг от друга. Хотя Vista тоже анонсировали впопыхах, у неё не было настолько серьёзных проблем со стабильностью — в этом плане система работала, наоборот, хорошо. Однако у неё был существенный недостаток, который повлёк за собой все проблемы, в том числе и возрошие системные требования.

Поскольку в Windows XP было множество проблем с безопасностью, Microsoft постаралась сделать Vista как можно более защищённой. И у неё это получилось во многом за счёт изменения модели драйверов — система стала не только безопаснее, но и стабильнее. На практике это выражалось в существенном уменьшении количества появлений «синих экранов смерти» и в возможности восстановиться после сбоев графических драйверов, чем XP похвастаться не могла.

Однако такое существенное обновление одной части «начинки» системы не могло не затронуть другие её компоненты. Во-первых, драйверы для Windows XP не работали с новой системой драйверов в Vista — старое ПО, а также многие периферийные устройства попросту были несовместимы с Vista, пока их разработчики и производители не выпустили обновления. Во-вторых, Microsoft реализовала новую архитектуру графических драйверов — WVDDM. Она и стала причиной провала Vista, которую вряд ли можно было предугадать.

Проблема заключалась в том, что очень популярный в то время чипсет Intel i915 не поддерживал WVDDM. Осознавая, что выход Vista попросту «убьёт» i915 как рыночный продукт, Intel убедила Microsoft искусственно смягчить системные требования специально ради этого чипсета, чтобы производители компьютеров могли использовать значок Vista Capable («Совместим с Vista») в своих устройствах на базе Intel i915 и подобных. На практике это привело к тому, что рынок заполонили компьютеры, которые по факту были несовместимы с Windows Vista, из-за чего система работала на них крайне медленно, и пользователи разочаровывались в работе новой операционной системы.

Из этой истории вытекло два других скандала, которые также попали в интернет. Во-первых, чипсеты AMD были готовы к архитектуре WVDDM, и это должно было бы существенно популяризировать её продукцию на рынке. Во-вторых, ещё до выхода Vista компания HP инвестировала большие средства в то, чтобы её предстоящие ноутбуки оснащались новыми чипсетами и смогли использовать метку Vista Capable — производитель хотел сделать это преимуществом на фоне моделей своих конкурентов. Однако когда Microsoft снизила системные требования, совместимость с Vista стала обыденным делом. Таким образом, сохранив крепкое партнёрство с Intel, компания Microsoft подпортила отношения с AMD и HP.

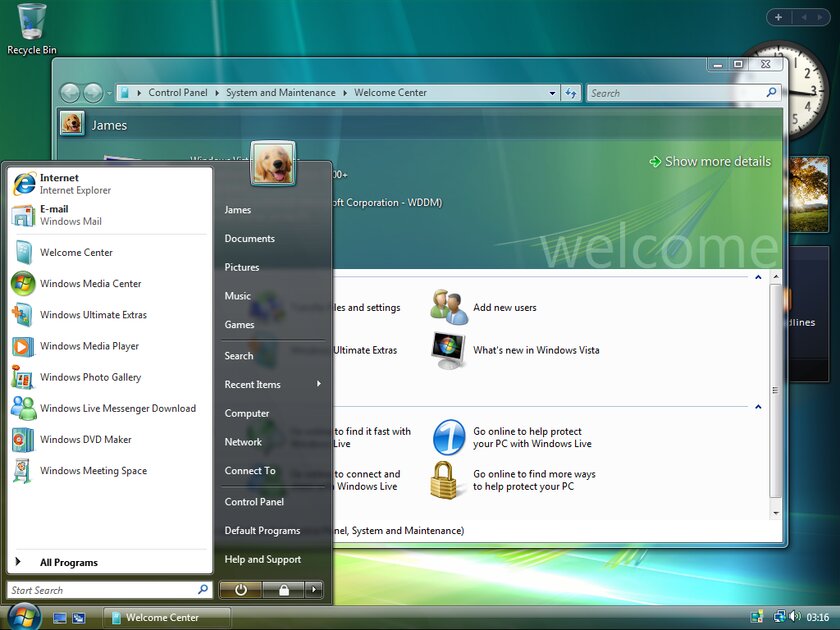

Со стороны обычных пользователей Windows Vista существенно преобразилась по сравнению с XP, но стремление Microsoft вывести безопасность на новый уровень коснулось даже обычного взаимодействия с системой. В ней появился «Контроль учётных записей пользователей» (User Account Control, UAC). Поскольку люди зачастую использовали учётную запись администратора (большая часть ПО не работала с правами обычного пользователя), это нововведение предназначалось в качестве дополнительного уровня защиты — пользователь, даже являясь администратором, должен был постоянно подтверждать своё намерение запустить «программу, которая может внести изменения в компьютер».

UAC присутствует в Windows и по сей день, но в Vista эта опция была максимально назойливой. Диалоговое окно с подтверждением действия появлялось чуть ли не в каждом уголке системы, что очень мешало как обычным, так и продвинутым пользователям. Эта функция стала настолько раздражающей особенностью Vista, что Apple даже высмеивала её в своей знаменитой рекламной кампании Get a Mac («Перейди на компьютер Mac»). Это, безусловно, тоже сыграло свою роль в формировании общественного мнения о Vista.

🔴 Windows Vista стала жертвой сохранения партнёрства между Microsoft и Intel. Она действительно имела крайне высокие системные требования, но если бы их искусственно не занизили, заполонив рынок по факту несовместимыми с ней компьютерами, пользователи слабых устройств попросту не попробовали бы её и не столкнулись бы с низкой производительностью.

Windows 8

Операционная система для сенсорных устройств. Но мониторы не сенсорные, как и большинство ноутбуков того времени

Среди всех худших версий Windows именно «Восьмёрка» наиболее свежа в памяти современных пользователей, ведь она вышла в 2012 году. Её главная проблема в том, что она появилась нежданно и принесла кардинальные изменения. Негативный эффект усугубил и тот факт, что она стала преемницей Windows 7 — после неудачной Vista и откровенно постаревшей XP люди очень полюбили «Семёрку», которая свежо выглядела и быстро работала.

Одна из главных проблем Windows 8 — отказ от меню «Пуск». Он поставил в тупик большинство пользователей, которые не могли понять, как взаимодействовать с компьютером. Некоторые даже не могли найти кнопку выключения.

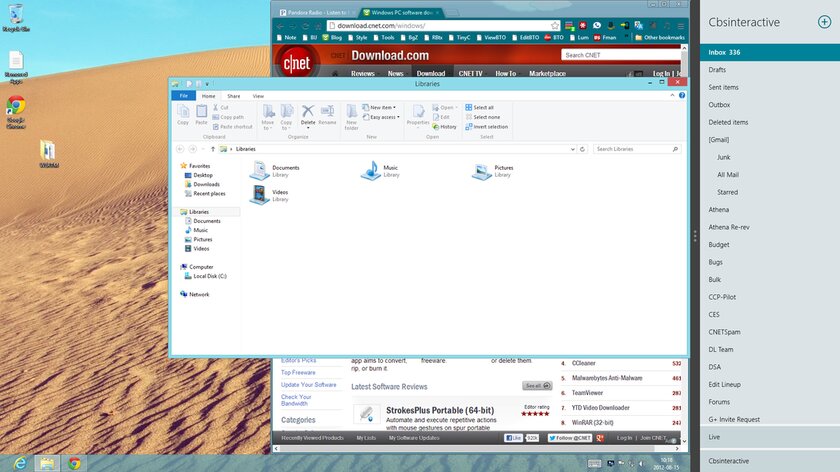

Ещё одна проблема Windows 8 — двуликость. Microsoft сохранила рабочий стол из Windows 7, но добавила совершенно новое плиточное меню приложений, которое явно предназначалось для сенсорных экранов, но было включено абсолютно на всех устройствах. Стремление Microsoft выпустить универсальную систему для компьютеров и планшетов и стало причиной провала Windows 8, поскольку логика взаимодействия с системой на сенсорных гаджетах оказалась совсем не удобной на компьютерах. К примеру, на планшетах «Чудо-панель» (Charms Bar) открывалась простым свайпом, но на компьютерах с мышкой выдвинуть её было крайне не удобно.

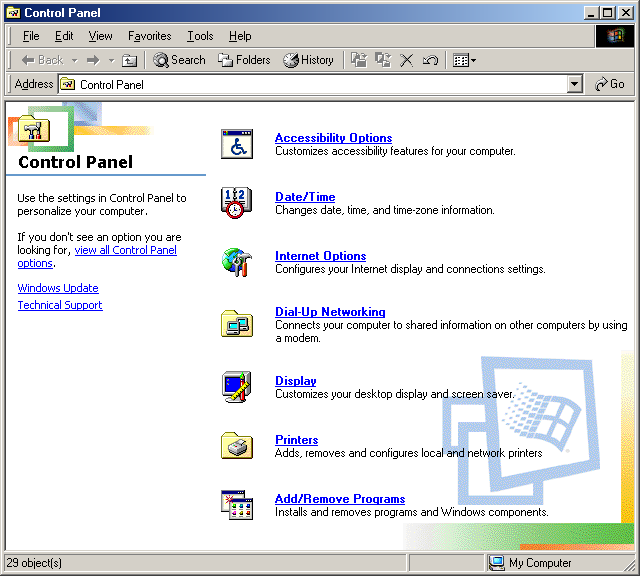

Всё усугубляли ещё и Metro-приложения — оптимизированные под сенсорные экраны программы, отличающиеся крупными элементами интерфейса и порой ограниченным функционалом. Помимо того, что они смотрелись несуразно на обычных компьютерах, они часто выступали как дополнение к обычным программам. Пользователям приходилось искать, где находится нужный им параметр системы — в Metro-приложении «Настройки» или в стандартной «Панели управления». А при открытии фотографии на рабочем столе запускался не знакомый просмотрщик, а Metro-приложение «Фото».

Ещё одним оказавшимся неудачным решением Microsoft, реализованным в Windows 8, стал магазин приложений Windows Store. Он задумывался как центральное место для загрузки программного обеспечения для устройств на Windows, но быстро наполнился «мусором», а подавляющее число разработчиков так и не поддержало инициативу Microsoft.

🔴 Windows 8 — продукт неудачной или не доведённой до ума идеи разработчиков. Microsoft хотела захватить рынок планшетов и создать сегмент ноутбуков-трансформеров, но сделала это за счёт ухудшения пользовательского опыта владельцев обычных компьютеров. Разработчики не очень быстро осознали оплошность, только спустя год выпустив Windows 8.1, которая устраняла главные недочёты предшественницы.

Итог: так какая версия Windows стала худшей?

ME — провальная, Vista — жертва партнёрства с Intel, Windows 8 — сенсорная

Если оценивать версии Windows объективно, нельзя судить об их преимуществах и недостатках только по пользовательскому интерфейсу и видимым рядовому пользователю элементам — каждая новая операционная система получала ещё и существенные изменения «под капотом», которые улучшали безопасность, повышали стабильность и открывали невиданные ранее возможности.

Но ключевые причины провала самых неудачных версий Windows лежат на поверхности:

- Windows ME — была выпущена в спешке как промежуточный мостик между староватой Windows 98 и революционной Windows XP, до выхода которой оставался ещё год;

- Windows Vista — если бы не уступки для Intel со стороны Microsoft, эта система не запомнилась бы пользователям как самая медлительная, требовательная и неоптимизированная Windows в истории;

- Windows 8 — разработчики выпустили эту Windows скорее для планшетов и ноутбуков-трансформеров, чем для обычных компьютеров. Это отразилось во всех уголках системы, но пользователи могли бы и смириться с таким раскладом, если бы не пропавшее меню «Пуск».

Одной из самых ожидаемых операционных систем от Microsoft была Windows Vista, выпущенная в январе 2007 года. Компания заявляла, что Vista предложит абсолютно новый уровень удобства и безопасности. Однако, несмотря на амбициозные планы, Vista оказалась одной из худших версий Windows, вызвав волну критики со стороны пользователей и экспертов. Почему операционная система, которая должна была стать шагом вперед, стала крупным провалом?

Одной из самых распространенных причин недовольства пользователей стала несовместимость с программами и оборудованием. Многие, обновившие свои системы для Vista, обнаружили, что привычные программы больше не работают, а принтеры, сканеры и другие устройства не могли взаимодействовать с новой системой. Это вызвало у пользователей недовольство и растерянность, поскольку они ожидали улучшений, а столкнулись с серьезными неудобствами.

Также, Vista оказалась слишком «тяжелой» для большинства устройств, доступных на момент её выхода. Хотя Microsoft рекомендовала 1 ГБ оперативной памяти и 15 ГБ на жестком диске лишь в качестве минимальных требований, на практике для эффективной работы требовалось гораздо больше ресурсов. Многие пользователи, чьи компьютеры были рассчитаны для работы с Windows XP, столкнулись с невозможностью использования Vista. Медленная работа, зависания и сбои отпугнули многих, кто ожидал большего от новой системы.

Высокие системные требования сопровождались и сниженной производительностью. Даже на новых компьютерах Vista не всегда работала так, как ожидалось. Пользователи сталкивались с медленным откликом на самые простые операции и часто наблюдали зависания при запуске приложений. Это вызывало у пользователей дополнительное разочарование.

В Vista представили систему контроля учётных записей (UAC) — своего рода инфраструктуру безопасности, которая, хотя и была полезна в теории, раздражала многих пользователей из-за постоянных запросов на подтверждение действий. Каждое изменение или установка программы сопровождались всплывающими окнами, требующими одобрения, так что вскоре многим это надоело и они отключили UAC.

Восприятие пользователями

Несмотря на широкомасштабную рекламную кампанию, многие пользователи быстро разочаровались в Vista. На форумах и в интернете стали появляться отзывы, критика и предостережения об обновлении. Это довольно быстро создало отрицательный образ системы, что негативно сказалось на продажах и общей популярности.

Проблемы Vista сыграли на руку и её конкурентам; для многих пользователей, действительно разочарованных в Windows, другие операционные системы, такие как Mac OS X и Linux, стали намного привлекательнее. Это нанесло дополнительный удар по репутации Microsoft и заставило многих задуматься об отказе от их продукта.

Провал Windows Vista стал важным уроком для Microsoft. Осознав ошибки, допущенные на этапе разработки, Microsoft должна была понять, что продукт был недостаточно зрелым. Эти изменения сыграли важную роль в разработке Windows 7, где многие из ошибок Vista были исправлены, и она была встречена пользователями гораздо теплее.

Конец «гонки мегагерцев», или Почему провалилась «Виста»?

Привень А.И.

Аннотация

Высказаны соображения по поводу главной причины провала операционной системы Windows Vista – одного из наиболее значительных по масштабу коммерческих провалов в истории Microsoft, проглядевшей достижение критически важной подсистемой компьютера – процессором – физического предела по главному параметру, каковым на тот момент являлась тактовая частота. На основании данных современной рыночной статистики показано, что, несмотря на исчерпание ресурса повышения тактовой частоты, а также переход от стационарных компьютеров к портативным и от локальных вычислений к «облачным», производительность процессора по-прежнему остается наиболее важным его параметром среди тех, улучшение которых востребовано покупателями персональных компьютеров.

Введение

Процесс смены главного тренда развития технической системы, чем бы она ни была вызвана, всегда несет в себе некоторый элемент непредсказуемости, а прогноз развития событий во время этого процесса никогда не бывает до конца определенным. В истории техники подобные вещи происходили много раз, и всегда это событие было в какой-то мере ожидаемым и в какой-то мере – неожиданным для его непосредственных участников.

Были ли способы упредить такое развитие событий, и в какой момент (и на каком именно основании) нужно было бить тревогу? На эти вопросы наверняка будет столько же мнений, сколько и участников дискуссии. Тем не менее, автор рискнет высказать свою точку зрения, исходя из тенденций развития «процессоростроения» для персональных компьютеров, наблюдаемых в течение последних десятилетий.

Не будучи специалистом в области электроники, автор может уповать лишь на то, что используемые им объективные исторические данные, наряду с весьма простыми математическими выкладками, позволят ему избежать грубых ошибок.

Как это было: хроника провала «Висты»

В многочисленных публикациях ([1, 2] и др.) приводится множество причин коммерческого провала операционной системы Windows Vista от Microsoft – по некоторым оценкам, самого значительного провала в истории компании. Автор, однако, не нашел в этих публикациях описания того, что могло бы стать подлинной причиной этого провала. Описываются лишь следствия – низкая производительность, несовместимость с предыдущими версиями, медлительность загрузки системы и т.д. Эти дефекты можно было ожидать, однако, от любого другого разработчика – только не Microsoft!

В самом деле, именно в компании Билла Гейтса всегда уделяли повышенное внимание обеспечению совместимости с предыдущими версиями операционных систем – и вплоть до Windows XP поддерживали программы, написанные под любую из этих версий, начиная с 16-разрядной MS DOS. А в Висте вдруг отказались от поддержки даже предыдущей версии Windows XP, доминировавшей на тот момент на рынке! И именно в корпорации Microsoft всегда уделяли максимум внимания тому, чтобы скорость работы программ оставалась на приемлемом для пользователя уровне, и, начиная, по меньшей мере, с 1993 года (Windows 3.1), не допускали в этом отношении серьезных просчетов – что бы по этому поводу ни говорили оппоненты.

А первопричина, в общем-то, лежит на поверхности, если мы сопоставим время разработки Windows Vista с событиями, происходившими в это время в индустрии микропроцессоров для персональных компьютеров.

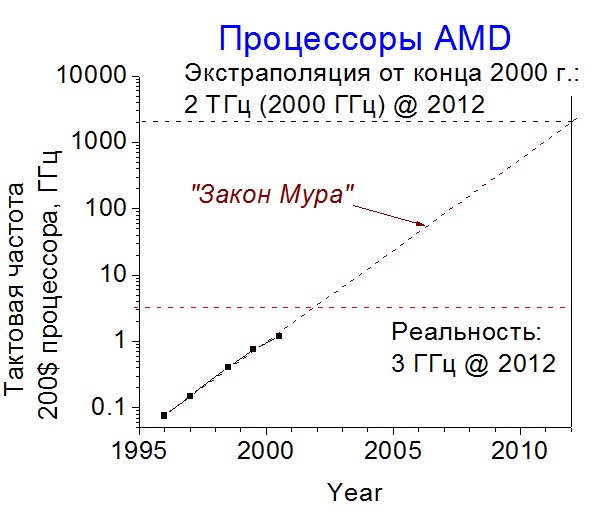

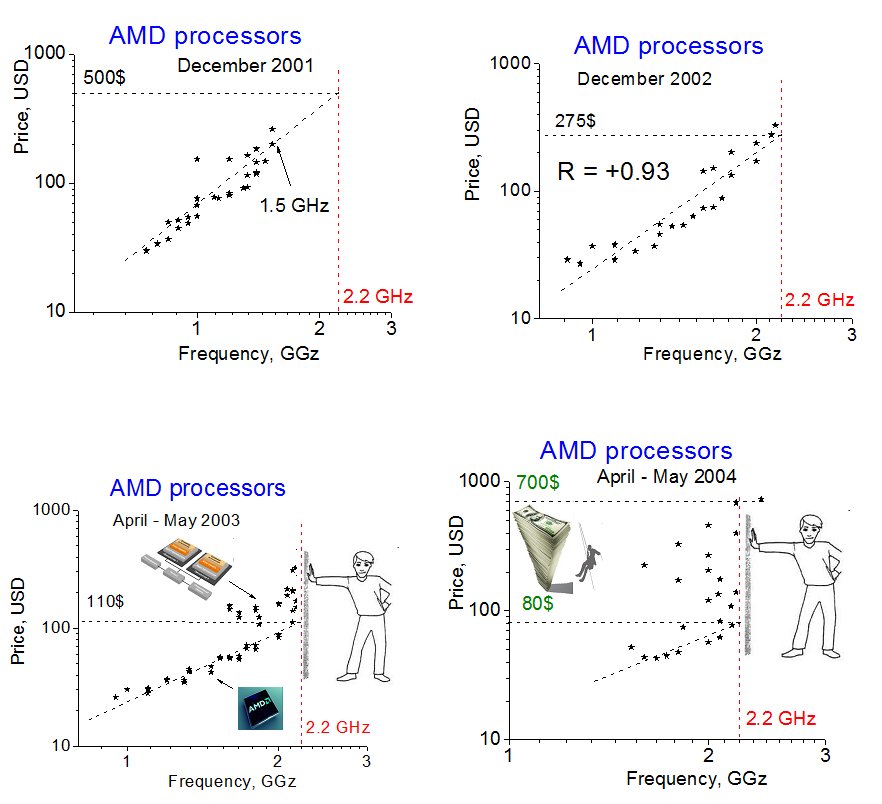

Вплоть до конца 2000 года ничто, казалось бы, не предвещало здесь бурных перемен. «Закон Мура», исправно действовавший в течение 40 предыдущих лет, продолжал действовать. Согласно одной из его формулировок, производительность процессора увеличивается вдвое каждые 18 месяцев [3]. Хотя понятие «производительность процессора» является не вполне однозначным (эта величина зависит от многих факторов, в том числе и от решаемой задачи), вполне приемлемой ее оценкой в то время была тактовая частота ядра процессора. В течение 1990-х годов эта величина у персональных компьютеров росла даже чуть быстрее вышеуказанного темпа, удваиваясь в среднем каждые 14-15 месяцев (рис. 1). Здесь и в дальнейшем автор опирается на данные корпорации AMD [4, 5], поскольку в этих сведениях, помимо технических характеристик выпускаемых процессоров разных лет, указаны тогдашние цены и, соответственно, есть возможность понять, какие из этих процессоров были реально доступными для массового пользователя. К сожалению, аналогичных данных для компании Intel автор найти не смог.

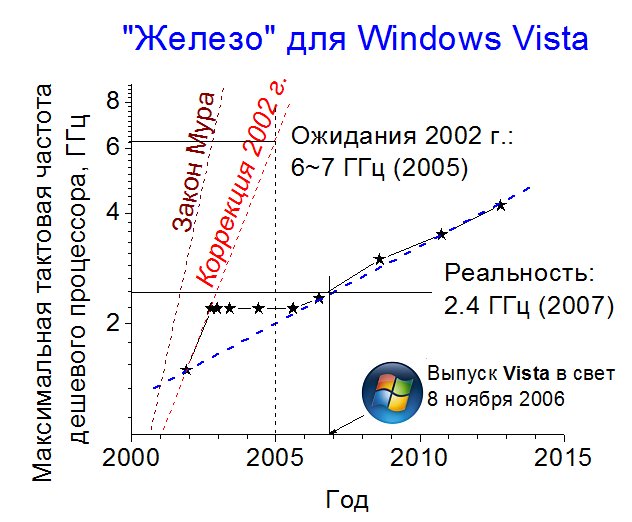

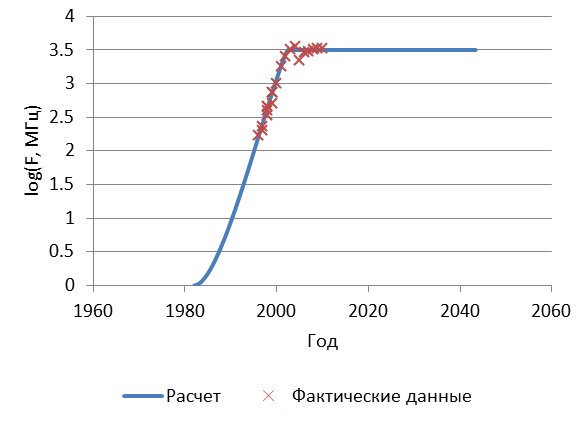

Рис. 1. Экстраполяция «закона Мура» для тактовой частоты с конца 2000 г. на начало 2012 г.

Источник данных: [4, 5]

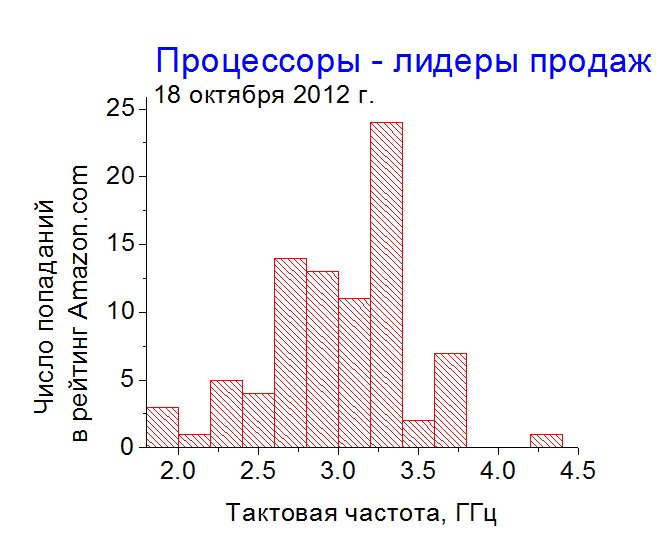

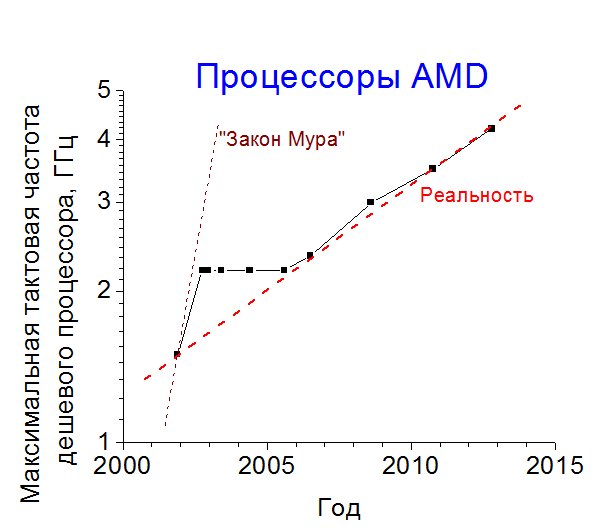

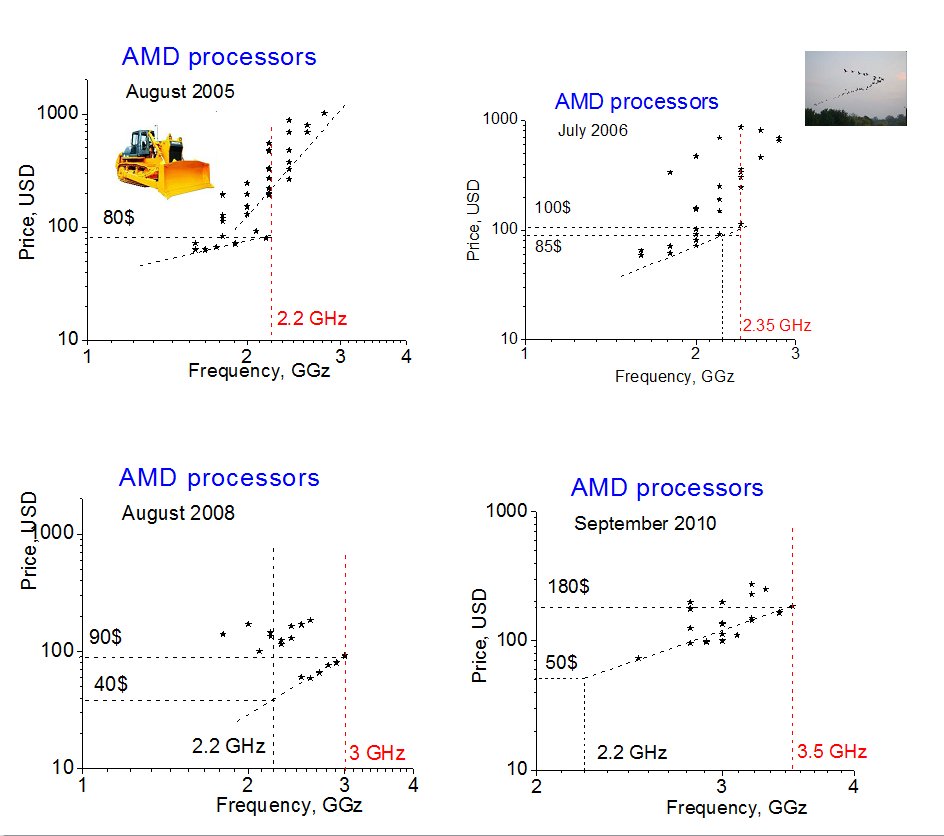

Если бы вышеуказанная закономерность продолжалась и сейчас, нынешние «персоналки» имели бы терагерцовые частоты (1 терагерц, ТГц = 1,000,000,000,000 герц = 1000 гигагерц, ГГц), превзойдя показатели 12-летней давности примерно в 1000 раз. В действительности, однако, процесс пошел куда медленнее, и тактовая частота сегодняшних процессоров лишь примерно вдвое выше тогдашней (с учетом многоядерности, производительность доступных по цене процессоров с тех пор выроса раз в 6-6-8) – см. рис. 2. Темпы реального роста тактовой частоты за последние 10 лет показаны на рис. 3.

Рис. 2. Тактовые частоты наиболее популярных микропроцессоров в октябре 2012 г.

Источник данных: amazon.com

Рис. 3. Рост максимальной тактовой частоты доступных по цене (до 150-200$) процессоров корпорации AMD в 2001-2012 гг.

Источник данных: [4, 5]

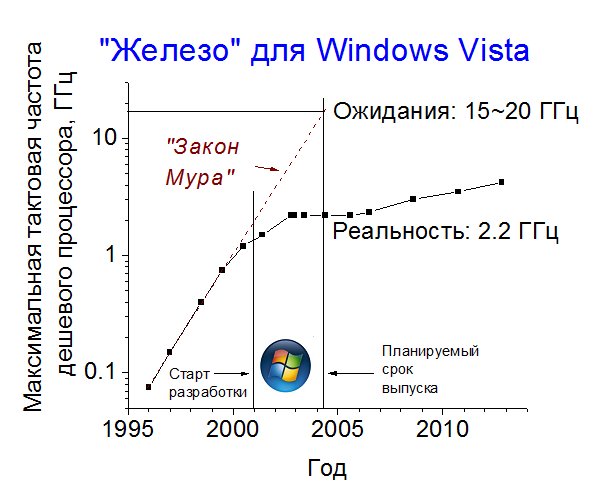

Если мы теперь «наложим» эти данные на деятельность корпорации Microsoft (рис. 4), то предполагаемая причина провала операционной системы Windows Vista станет вполне понятной. В самом деле, начиная эту разработку еще в 2001 г. (и, следовательно, готовя обоснование проекта, по всей видимости, еще в 2000-м) с расчетом на выпуск в 2004-м, специалисты корпорации обязаны были учитывать рост характеристик компьютерного «железа» в течение срока разработки. Разумеется, они это всегда делали: в противном случае операционные системы от Microsoft всегда «летали бы, как птички», поскольку за время их разработки (обычно порядка 3 лет) тактовые частоты успевали увеличиться в 4-5 раз. Судя по тому, что работа Windows никогда не была слишком быстрой (но была, тем не менее, вполне приемлемой для большинства пользователей), прогнозы специалистов Microsoft в целом вполне оправдывались. А прогнозы эти, разумеется, строились на вышеупомянутом «законе Мура».

Увы, информация о том, как реагировали в компании Microsoft на дальнейшие события, видимо, останется тайной. Мы попытаемся, однако, восстановить логику действий компании в предположении, что руководство компании отслеживало текущее состояние в процессорной индустрии и пыталось прогнозировать ее развитие в ближайшем будущем путем линейной экстраполяции наблюдаемых трендов – то есть так, как это обычно и делается при краткосрочном прогнозировании. Как видно из рис. 4, при экстраполяции с 2000-2001 на 2004 г. такой прогноз дал роковой сбой, завысив ожидаемую частоту процессоров примерно раз в восемь по сравнению с реальностью (впрочем, тогда еще не известной).

Рис. 4. Экстраполяция тактовой частоты процессоров по «закону Мура» с 2001 на 2004 г.

Источник данных: [4, 5]

Если бы «Висту» выпустили с такими характеристиками, как это следовало из результатов вышеописанной экстраполяции, то она, скорее всего, не смогла бы запускаться вообще. Разумеется, в корпорации Microsoft это понимали, и выпуск операционной системы несколько раз откладывался. Понять неизбежность этого шага в корпорации должны были не позднее, чем в 2002-м году, когда стало уже вполне ясно, что рост производительности «железа» заметно отстает от прогнозов (рис. 5). Однако еще оставалась надежда, что пусть не к 2004, но к 2005 г. тактовая частота достигнет 6-7 гигагерц. По всей видимости, именно на это и были нацелены разработчики этой системы, отложив ее выпуск вначале на 2005, а затем и на 2006 год.

Рис. 5. Коррекция «закона Мура» по данным на 2002 г.

Источник данных: [4, 5]

Только 8 ноября 2006 г. было, наконец, объявлено о выпуске этой операционной системы в свет [6]. Однако, как видно из рисунка, частота доступных по цене процессоров с 2002 года увеличилась к тому времени лишь на 10% — с 2.2 до 2.4 ГГц, вместо ожидаемых 6-7 ГГц. Появившиеся в то время двухъядерные процессоры повысили «эффективную» производительность, максимум, до 3.5-4 ГГц, и стоили они тогда весьма недешево (см. ниже).

Понятно, что в течение последних лет подготовки операционной системы к выпуску специалисты компании должны были максимум сил бросить на ускорение работы программы. До конца им это сделать все равно не удалось, а то, что удалось, было явно сделано за счет отказа от ряда первоначальных требований. В их числе – совместимость с предыдущими версиями системы, прежде всего с ХР; другими словами, поддержка работы программ, написанных для Windows XP, без изменения их кода. Поддержка совместимости требовала дополнительного времени на разработку программ и к тому же несколько снижала общую производительность работы системы – и то, и другое было для корпорации в данных условиях неприемлемо.

Фактический (хотя и всячески скрываемый поначалу) отказ от поддержки совместимости со старыми программами привел к тому, что реально под этой операционной системой работали только те программы, которые были специально для нее написаны, в частности, Microsoft Office 2007 – еще один по существу провальный продукт, разрабатываемый примерно в те же сроки, что и Vista, разработчики которого, правда, сделали вдобавок к вышеописанному еще ряд серьезных просчетов, описание которых, однако, выходит за рамки нашего повествования. Заметим лишь, что предыдущая версия этого продукта – MS Office XP – работала под Вистой только после установки специального «пакета совместимости». Другими словами, без изменения исходного кода под Вистой не работали (или работали крайне неустойчиво) даже предыдущие программы самой Microsoft.

Не будем подробно рассматривать здесь поистине драконовские, антирыночные меры, которые были предприняты корпорацией Microsoft для спасения продукта, в частности, фактический запрет вендорам предустанавливать предыдущую систему Windows XP на новые компьютеры. Заметим лишь, что уже менее чем через два года после старта продаж была в форсированном темпе подготовлена к выпуску следующая, уже намного более удачная операционная система Windows 7, при разработке которой корпорация изначально «закладывалась» на реальные возможности компьютерного «железа», показанные на предыдущих рисунках.

А мы постараемся проанализировать, можно ли было (и если можно, то как) увидеть в «спокойной» обстановке периода смены тысячелетий признаки надвигающейся скорой катастрофы.

Предел подкрался незаметно…

Ра рис. 6 показана динамика изменения цен на микропроцессоры компании AMD в период с 2001 по 2010 годы.

Как видно из рисунка, в 2001-2002 годах практически единственным параметром, определявшим рыночную цену процессора, была как раз его тактовая частота. Ее коэффициент корреляции с ценой наиболее продаваемых процессоров составлял свыше 0.9, дойдя до +0.93 в декабре 2002 г. Другими словами, покупатели охотно платили дополнительные деньги за более производительные процессоры. Понятно, что все усилия разработчиков были на увеличение этого показателя, по возможности без удорожания продукта. И вплоть до конца 2002 года разработчикам, как видно из рис. 4, это вполне удавалось.

Резкие изменения наступили в 2003 году. Отметка 2.2 ГГц оказалась как будто заколдованной: переступить через нее удалось лишь в 2004 году, подняв цену процессора с 80 до 700 (!) долларов. После этого все усилия были главным образом направлены на удешевление многоядерных процессоров, в чем корпорация в итоге весьма преуспела. Однако шести- и даже восьмиядерные процессоры увеличили производительность, максимум, в 3-4 раза по сравнению с одноядерными (это следует из значений «эффективной производительности», указанных самим производителем), и сегодня большинство наиболее популярных процессоров содержит только три-четыре ядра. За это же время тактовая частота доступных по цене процессоров выросла, максимум, до 3.5-4 ГГц (см. рис. 1), что в совокупности дало «эффективную» производительность, соответствующую одноядерному процессору с частотой порядка 10 ГГц или чуть больше.

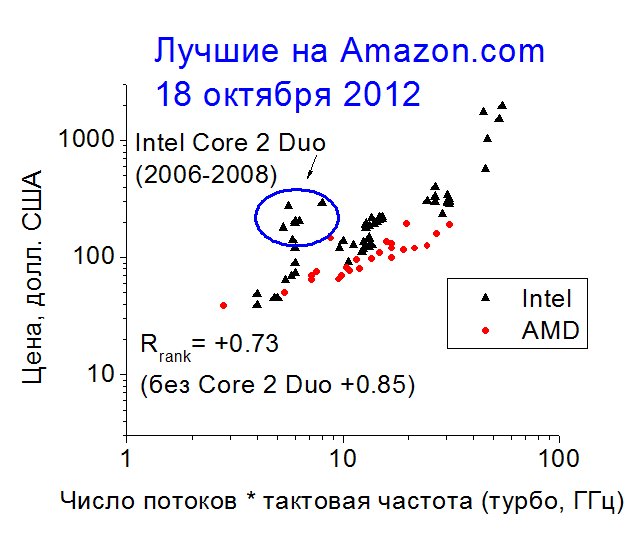

При этом производительность по-прежнему остается если не самым важным, то одним из важнейших параметров процессора, о чем свидетельствует достаточно высокий коэффициент корреляции произведения максимальной тактовой частоты на число потоков данных (приближенная оценка производительности) с ценой, равный +0.73, а за вычетом нескольких старых моделей +0.85 (рис. 7). Другими словами, массовый покупатель по-прежнему платит больше денег за более производительные процессоры. Не просто «готов платить» — а реально платит.

Рис. 6. Динамика цен наиболее популярных процессоров производства AMD в 2001-2010 гг.

Источник данных: [4, 5]

Рис. 7. Взаимосвязь между рыночной ценой и производительностью наиболее продаваемых микропроцессоров по данным amazon.com на 18 октября 2012 г.

Производительность оценивалась как произведение числа потоков на максимальную тактовую частоту процессора (в турбо-режиме там, где он есть).

Источники данных о параметрах процессоров здесь и далее: [4, 5, 7]

Итак, мы видим, что внезапный обвал роста производительности процессоров в 2003 году не имел под собой «рыночных» причин. Рынок желал продолжения роста этой характеристики тогда и продолжает желать сейчас. Это свидетельствует о том, что причиной прекращения роста послужило достижение некоего физического предела.

Обычно, однако, в таких случаях еще до достижения предельных значений главного параметра системы (на повышение которого прежде всего направлены усилия разработчиков) наблюдаются признаки замедления темпов его роста, когда каждое новое приращение дается дороже и медленнее, чем предыдущее. Как результат этого процесса, повышение главного параметра системы (чаще комплексного [8], но иногда и индивидуального) описывается S-образной кривой, хорошо известной из многочисленных публикаций (см., в частности, [9]).

Почему в случае микропроцессоров предел наступил практически внезапно, без каких-либо предвестников замедления темпов роста? Для ответа на этот вопрос попытаемся смоделировать ситуацию с учетом интересов как покупателей, так и производителей компьютеров и программных продуктов.

Игра – двигатель прогресса?

Для чего покупают персональные компьютеры? Ответ на этот вопрос можно легко получить, исходя из того, какие программы больше всего времени работают на компьютерах их пользователей. Ответ (во всяком случае, по состоянию на 2003 год) весьма очевиден:

- операционная система и «системные» программы (включая интернет-браузеры и антивирусную защиту);

- компьютерные игры;

- офисные программы.

Несложно понять, что корпорация Microsoft вкупе с несколькими ведущими разработчиками компьютерных игр являются главными бенефициарами рынка программ для персональных компьютеров. Аналогичная ситуация и с микропроцессорами: почти все они производятся компаниями Intel и AMD.

Самое важное для нас состоит в том, что коммерческий интерес всех вышеуказанных компаний «замыкается» на одном и том же параметре, и этот параметр – производительность процессора. Чтобы это понять, будем исходить из самоочевидного:

- Производителям персональных компьютеров необходимо постоянно продавать новые компьютеры. При этом у большинства платежеспособных покупателей компьютеры уже есть, их функционал в целом вполне приемлем, и до физического износа еще очень далеко.

- Производителям игровых и офисных программ нужно продавать новые версии своих программ. При этом у большинства платежеспособных покупателей прежние версии таких программ уже есть, их функционал в целом вполне приемлем, и они могут работать в течение неограниченного времени (мы по-прежнему рассматриваем ситуацию до 2003 г., когда программ, распространяемых по срочной подписке, еще почти не было).

В этой ситуации быстрый рост производительности процессоров позволил одним махом убить двух зайцев сразу. Разработчики программ, прежде всего игровых, каждую новую версию делали так, чтобы в полной мере использовать рост производительности процессора.

это давало возможность сделать алгоритмы более сложными и интересными, действие более динамичным, а поведение персонажей более «живым». При этом, естественно, работать такие программы могли только на новых, более быстрых компьютерах: для них писать программы было, при прочих равных, еще и проще. В свою очередь, разработчики процессоров и прочего «железа» делали всё возможное, чтобы новые компьютеры как можно более превосходили по своим возможностям старые: только в этом случае их можно было продать покупателям, уже имеющим «старый», а в действительности совсем еще недавно купленный и вполне работоспособный компьютер.

С учетом этого обстоятельства, затраты разработчиков на совершенствование процессоров переставали быть критическим фактором, способным сдержать темпы роста параметров: огромный спрос на всё более быстрые процессоры – вне зависимости от текущих значений их производительности! – делал такие разработки экономически оправданными при практически любых затратах.

Как говорят в таких случаях физики, образовалась система с доминирующей положительной обратной связью, когда увеличение какого-либо параметра является само по себе стимулом к его дальнейшему увеличению. Многочисленные примеры из естественных наук свидетельствуют, что в таких случаях изменение этого параметра во времени подчиняется экспоненциальному закону. Так развивается популяция живых организмов при избытке ресурсов в отсутствие хищников [10, 11], по этой же кривой растет тепловыделение при взрыве [12] и так далее. Стоит ли удивляться, что по той же самой кривой изменялась и производительность компьютерных процессоров, сделав реальностью вышеупомянутый «закон Мура»?

Однако взрыв не продолжается вечно – он прекращается намного динамичнее, чем развивается. Аналогично, популяция живых организмов быстро прекращает свой рост с истощением ресурсов [13]. Точно так же и рост производительности процессоров был остановлен только тогда, когда повысить их тактовую частоту до ожидаемых покупателями значений стало не просто трудно или дорого, но практически невозможно.

Пока система имела ресурсы для роста – этот рост обеспечивался фактически любой ценой. Рост прекратился, когда цена стала стремительно приближаться к бесконечности – что мы и видим на рис. 6 на графиках за 2003-2004 годы.

«Прогноз» доктора Мура, который можно было сделать 30 лет назад

В 2007 году, когда «закон Мура» для тактовой частоты процессоров персональных компьютеров перестал действовать уже четыре года назад (см. рис. 4), автор этого «закона» Гордон Мур заявил, что «закон, очевидно, скоро перестанет действовать из-за атомарной природы вещества и ограничения скорости света» [3]. И он, конечно же, был прав в своем «прогнозе» — точнее, в объяснении причин произошедшего. В самом деле, предел был обусловлен ничем иным, как «ограничением скорости света».

В течение всего времени, пока продолжалась «гонка мегагерцев», лишь один значимый параметр микропроцессоров, который «в теории» можно было улучшить, оставался практически постоянным: этим параметром был физический размер ядра. Постоянство этого параметра диктовалось тем, что он был «завязан» на противоречие (рис. 8): при увеличении размера ядра у разработчиков появлялась возможность увеличить число элементов электрической схемы, что давало выигрыш в функционале и производительности (положительные эффекты), но при этом увеличивалась стоимость и, кроме того, повышалось потребление энергии, которую было необходимо куда-то отвести во избежание перегрева процессора и его выхода из строя, и, в случае мобильных устройств, это снижало ресурс их работы (нежелательные эффекты). Как число элементов схемы, так и потребляемая ими энергия с увеличением размера процессора росли, в первом приближении, пропорционально квадрату его диагонали. В этой ситуации было нельзя (или очень невыгодно) ни сильно увеличивать размер процессора, ни сильно уменьшать его. Компромиссное значение порядка 1 сантиметра продержалось с момента появления первых «персоналок» до наших дней практически неизменным.

Рис. 8. Схема противоречия в требованиях к микропроцессорам

Однако при любой тактовой частоте процессора, естественно, необходимо, чтобы за один такт электрический сигнал успел «пробежать» от центра процессора до его края и обратно. С учетом скорости света (300,000 км/с) получаем минимальное время прохождения расстояния 1.4 см (диагональ квадрата со стороной 1 см), равное примерно 0.05 наносекунды, что соответствует предельно возможной тактовой частоте примерно 20 гигагерц.

«Но, позвольте, ведь рост тактовой частоты реально остановился на цифрах вдесятеро меньших!» — возразит внимательный читатель, и будет прав. «Другая» правда, однако, состоит в том, что при приближении к физическому пределу на определенное расстояние стоимость дальнейших шагов в этом направлении начинает возрастать очень резко. Так называемый «закон Парето» [14] (называемый часто «правилом 20:80») гласит, что критическим значением обычно является достижение примерно 80% от предельного значения. Из многочисленных причин отметим в данном случае хотя бы то, что скорость распространения электрического сигнала в твердом теле существенно ниже скорости света в вакууме, — впрочем, сделанная выше «оценка сверху» является в любом случае весьма приближенной.

В данном случае представляется логичным считать «расстояние» до предельного значения параметра по логарифмической шкале, поскольку именно эта шкала (в соответствии с вышеупомянутым «законом Мура») лучше всего отражала временной ход развития системы: логарифм тактовой частоты изменялся пропорционально времени. Принимая тактовую частоту первых более-менее массовых персональных компьютеров (IBM PC XT) равной примерно 1 мегагерцу (на тот момент были уже доступны 6-мегагерцовые компьютеры, но они стоили очень дорого), получаем, что по шкале десятичных логарифмов расстояние до физического предела тогда составляло 4.3 единицы. 80% от этого значения соответствуют 3.4 единицы десятичного логарифма, что равносильно увеличению значения параметра в 10^3.4=2750 раз. Другими словами, по весьма грубым прикидкам, резкого замедления процесса роста тактовой частоты можно было ожидать на отметке чуть ниже 3 ГГц.

Последняя величина почти идеально соответствует фактическим данным, показанным на рис. 6. В самом деле, разница между 2.75 ГГц и 2.2 ГГц соответствует примерно 0.1 единицы десятичного логарифма, что составляет менее 3% от общего прироста этой величины за два десятилетия (с 1981 по 2002) и соответствует примерно 5 месяцам роста в соответствии с «законом Мура». Другими словами, еще в 1980-х годах можно было в принципе предсказать дату окончания действия «закона Мура» для тактовой частоты микропроцессоров с точностью до 5 месяцев?! Если даже это и не совсем так, то провал Windows Vista трудно объяснить чем-либо, кроме «ляпа» проектировщиков.

Отметим, что с помощью недавно разработанной нами модели [15, 16] можно было предсказать неизбежный кризис «закона Мура» и без содержательного анализа его причин. Проведенные нами расчеты по этой модели показали, что единственно возможным вариантом развития событий в ситуации экспоненциального роста главного параметра системы является резкое, практически прекращение этого роста по достижении некоторого значения (рис. 9). И хотя модель сама по себе не дает ответа на вопрос, при каком именно значении и, соответственно, в какой именно момент времени это должно произойти, сам по себе прогноз внезапного прекращения роста мог бы стимулировать к поиску возможных причин такого «поведения» системы. Как знать – если бы эксперты из Microsoft имели в своем распоряжении эту достаточно простую модель, быть может, Билл Гейтс был бы сейчас на несколько миллиардов богаче…

Рис. 9. Аппроксимация кривой роста тактовой частоты процессоров персональных компьютеров с помощью предлагаемой модели (рисунок воспроизведен из [15, 16])

Заключение

Проведенный анализ показал, что причины громкого коммерческого провала операционной системы Windows Vista могут получить достаточно простое и вполне естественное объяснение, если предположить, что эксперты корпорации Microsoft при проектировании этой системы грубо ошиблись в прогнозе темпов роста тактовой частоты процессоров персональных компьютеров, многократно завысив прогнозное значение этой характеристики по сравнению с реально достижимым на момент начала продаж новой операционной системы. Такая ошибка, в свою очередь, легко объяснима в предположении, что указанные эксперты основывали свои прогнозы на так называемом «законе Мура», диктующем, в частности, удвоение тактовой частоты процессоров каждые 15-18 месяцев. Действие вышеуказанного «закона», неукоснительно соблюдавшегося до тех пор в течение всех двух десятилетий существования персональных компьютеров на массовом рынке, резко, практически мгновенно оборвалось буквально сразу же после начала разработки Windows Vista. Как результат, экстраполяция указанного «закона» всего на несколько ближайших лет приводила к значениям тактовой частоты, оказавшимся в итоге почти на порядок выше реальных. В этой ситуации попытки спасти продукт, изначально спроектированный под совершенно нереальные характеристики компьютерного «железа», могли привести только к половинчатым и не слишком удачным решениям, что мы и наблюдали.

Преодолеть последствия ошибок проектирования компании Microsoft удалось лишь в следующей операционной системе Windows 7, которая изначально разрабатывалась уже с учетом реальных, значительно менее высоких темпов роста производительности процессоров в «пост-Муровскую» эпоху.

С другой стороны, прекращение роста тактовой частоты процессоров было хотя и внезапным, но достаточно предсказуемым. В пользу того, что всё произойдет именно так, свидетельствовал, в частности, длительный экспоненциальный рост тактовой частоты, не демонстрировавший никаких признаков замедления. Эта ситуация является для развития технических систем не вполне естественной. Автор не утверждает, что предполагаемый им механизм, приведший к именно этой зависимости тактовой частоты (и других характеристик) от времени, является исчерпывающим или единственно возможным. Однако ситуация в любом случае требовала дополнительного анализа, который, судя по всему, заинтересованными сторонами проведен не был.

После того, как неизбежное случилось и «закон Мура» в отношении тактовой частоты процессоров прекратил свое действие, компьютерная индустрия была вынуждена приспосабливаться к новым реалиям, в которых, однако, по-прежнему требовалось как-то повышать производительность работы компьютеров. Для этого процессоры «обзавелись» несколькими ядрами (некоторые из них стали к тому же многопоточными), а часть наиболее трудоемких вычислений была перенесена на удаленные «облачные» сервера, для которых проблема повышения производительности так остро не стоит.

Переход к «облачным» вычислениям, однако, не привел к смене приоритетов в совершенствовании процессоров персональных компьютеров. Анализ самых последних рыночных данных показывает, что производительность процессора по-прежнему остается его главным параметром, улучшение которого наиболее востребовано массовым покупателем. Произойдет ли для этого показателя «насыщение», за которым интерес покупателей к нему упадет? По всей видимости, да. Но пока еще говорить о такой перспективе преждевременно.

Литература

- Vista величайший провал в истории Microsoft, http://viennaos.net/articles/1355-vista-velichajshij-proval-v-istorii-microsoft.html

- Microsoft признает провал Windows Vista, http://habrahabr.ru/post/7668/

- Закон Мура. Википедия, http://ru.wikipedia.org/wiki/%D0%97%D0%B0%D0%BA%D0%BE%D0%BD_%D0%9C%D1%83%D1%80%D0%B0

- AMD product information, http://products.amd.com

- CPU World, http://www.cpu-world.com

- Development of Windows Vista. Wikipedia, http://en.wikipedia.org/wiki/Development_of_Windows_Vista

- Intel product information, http://ark.intel.com

- Кынин А.Т., Леняшин В.А., Фейгенсон Н.Б. Выбор параметров для описания развития технических систем вдоль «линии жизни». Труды конф. ТРИЗФест-2009, http://www.metodolog.ru/node/294

- Любомирский А., Литвин С. Законы развития технических систем, 2003, http://www.metodolog.ru/00767/00767.html

- Структура и свойства популяций. Проект «Вся биология», http://sbio.info/page.php?id=161

- Седова Г.П. Закономерности роста биологических объектов. 2004, http://www.smolensk.ru/user/sgma/MMORPH/N-10-html/sedova/Sedova2004.htm

- Корольченко А.Я. Процессы горения и взрыва. http://nashaucheba.ru/v28231/%D0%BA%D0%BE%D1%80%D0%BE%D0%BB%D1%8C%D1%87%D0%B5%D0%BD%D0%BA%D0%BE_%D0%B0.%D1%8F._%D0%BF%D1%80%D0%BE%D1%86%D0%B5%D1%81%D1%81%D1%8B_%D0%B3%D0%BE%D1%80%D0%B5%D0%BD%D0%B8%D1%8F_%D0%B8_%D0%B2%D0%B7%D1%80%D1%8B%D0%B2%D0%B0?page=3

- Klein D.R. the introduction, increase, and crash of reindeer on St. Matthew island, http://www.greatchange.org/footnotes-overshoot-st_matthew_island.html

- Закон Парето. Википедия, http://ru.wikipedia.org/wiki/%D0%97%D0%B0%D0%BA%D0%BE%D0%BD_%D0%9F%D0%B0%D1%80%D0%B5%D1%82%D0%BE

- Priven A.I., Kynin A.T. Simple phenomenological model of “S-curve” growth in engineering systems. – In: Proc. 2nd Int. Conf. on Systematic Innovation (ICSI) & AITRI Innovation Week, Shanghai, 2011.

- Привень А.И., Кынин А.Т. Модель роста параметров технических систем с учетом изменения надсистемных запросов. Metodolog.ru, http://www.metodolog.ru/node/1171

Ни для кого не секрет, что большое количество организаций намерены переждать «эпоху Висты» и дождаться Windows 7.

Согласно исследованиям Forrester Research, новая ОС Microsoft установлена лишь на 8,8% корпоративных ПК. Главный редактор сайта TechRepublic Джейсон Хайнер сформулировал пять наиболее очевидных причин, которые помешали миру по достоинству оценить Висту.

Vista была успешно очернена компанией Apple.

Проведенная корпорацией Apple рекламная кампания «I’m a Mac» смогла убедить владельцев домашних ПК в том, что Windows Vista является глючной, скучной и сложной операционкой.

Пользователи привыкли к Windows XP

В 2001 году, когда Windows XP впервые увидела свет, в мире насчитывалось около 600 млн. компьютеров. Более 80% из них работали под управлением операционных систем Microsoft: на долю Windows 95/98 приходилось 65%, приверженцы Windows NT/2000 составляли 26%. Одной из главных целей Windows XP было объединение этих двух групп, и новая операционная система успешно справилась с поставленной задачей.

Сегодня в мире насчитывается более 1,1 миллиарда ПК и на 70 процентах из них уже установлена Windows XP. Таким образом, требуется некоторое время для того, чтобы 800 миллионов пользователей смогли оценить преимущества «Висты» и подготовить корпоративные ИТ-инфраструктуры к переходу на новую ОС.

Низкая производительность Vista

Большое количество нареканий вызвали непомерно высокие требования «Висты» к ресурсам системы и низкая производительность при запуске на любом «железе», за исключением «навороченного».

Появление Vista на свет не планировалось

С выпуском Windows XP корпорация Microsoft попыталась внедрить новую модель распространения программного обеспечения, в рамках которой все покупатели превращались в подписчиков, имеющих право на получение обновлений, патчей и различных услуг.

Идея с инкрементным обновлением и апгрейдом программного обеспечения в рамках подписки вместо выпуска новой ОС с периодичностью в несколько лет казалась многообещающей. Однако Microsoft не смогла обеспечить достаточной жизнеспособности этой бизнес-модели и предпочла вернуться в проторенную колею.

Проблемы несовместимости

Несмотря на продолжительное бета-тестирование, огромное количество существующего ПО и оборудования оказались несовместимым с Vista на момент ее выхода в январе 2007 года. Именно это обстоятельство помешало сотрудникам ИТ-подразделений рассматривать «Висту» в качестве полноценной замены Windows XP. Многие из обнаруженных недостатков стали результатом повышенного внимания разработчиков ко встроенным механизмам защиты. Именно воспеваемая разработчиками защищенность новой ОС стала одной из наиболее явных причин ее низкой жизнеспособности.