| Автор | Сообщение | ||

|---|---|---|---|

|

|||

|

Member Статус: Не в сети |

После нескольких часов разглядывания синих экранов, прошу помощи гуру. Пытаюсь перенести ранее установленную систему на «RAID 0». Для этого: При первой загрузке система начинает искать драйверы и вываливается в синий экран после установки одного из них. Кажется, asahci64.sys. Если не ошибаюсь, то под какую-то Скази железку в момент вылета ищется драйвер. Что я делаю не так? Может быть, нужно как-то почистить систему перед ее резервированием? |

| Реклама | |

|

Партнер |

|

d1keee |

|

|

Junior Статус: Не в сети |

Вечный пользователь писал(а): После нескольких часов разглядывания синих экранов, прошу помощи гуру. Пытаюсь перенести ранее установленную систему на «RAID 0». Для этого: При первой загрузке система начинает искать драйверы и вываливается в синий экран после установки одного из них. Кажется, asahci64.sys. Если не ошибаюсь, то под какую-то Скази железку в момент вылета ищется драйвер. Что я делаю не так? Может быть, нужно как-то почистить систему перед ее резервированием? Была установлена система на один из 160Гб диск? Или вообще на другой? |

|

Вечный пользователь |

|

|

Member Статус: Не в сети |

d1keee Система была установлена на один жесткий диск 160 Гбт. Добавил второй. Образ старой системы хранится на третьем винте. Пробовал при восстановлении отключать опцию MBR, но тогда после переноса на два винта, вообще не работает. |

|

Вадим1976 |

|

|

Member Статус: Не в сети |

был опыт переноса наоборот.тоесть с рэйда на ссд.акронис тоже не помог.пробуйте из под лайв сиди прогой парагон мигрейт ту сиди.мне помогло. |

|

Вечный пользователь |

|

|

Member Статус: Не в сети |

Вадим1976 Не думаю, что дело в программе. Система у меня переносится нормально. Синий экран возникает, когда Винда при первом запуске устанавливает драйверы RAID-контроллера и SATA. Вот тут мне и непонятно. Ведь драйверы рэйд уже должны стоять, иначе бы ось вообще не загрузилась. |

|

Вадим1976 |

|

|

Member Статус: Не в сети |

переносилось у меня тоже нормально.только не грузилось. плюс если винда-торрент эдишн с кряком от loader extrim edition,тоже при попытке загрузить крякнутую версию вылетает в синьку.надо в выборе систем грузить обычную винду. |

|

Вечный пользователь |

|

|

Member Статус: Не в сети |

Вадим1976 Полностью согласен. Я тоже сталкивался, что RAID не на каждую сборку поставишь. |

|

Вадим1976 |

|

|

Member Статус: Не в сети |

Вечный пользователь писал(а): не на каждую сборку нe меня не сборка.чистая.но крякнутая. даже проходит валидацию на сайте майкрософта. |

|

Grayhaund |

|

|

Member Статус: Не в сети |

Цитата: Как правильно перенести Windows 7 на RAID? Никак. Ставить по новой. Идея переноса существующей системы в данном случае порочна по своей сути. И без разницы, сборка-несборка, лицензионная или крякнутая. |

|

Вадим1976 |

|

|

Member Статус: Не в сети |

Grayhaund писал(а): Никак. Ставить по новой. Идея переноса существующей системы в данном случае порочна по своей сути. И без разницы, сборка-несборка, лицензионная или крякнутая. Зачем по новой?Когда уже всё настроено под себя???Переносил несколько раз.Всё работает без проблем. |

|

Nitroacid |

|

|

Member Статус: Не в сети |

скопируй на РАЙД акронисом, дрова на рейд уже должны стоять в загрузке, загружайсо с диска установочного и делай воссстановление (как вариант «починить загрузку» или чето такое). можно поверх поставить, у меня прокатывало. |

—

Кто сейчас на конференции |

|

Сейчас этот форум просматривают: нет зарегистрированных пользователей и гости: 8 |

| Вы не можете начинать темы Вы не можете отвечать на сообщения Вы не можете редактировать свои сообщения Вы не можете удалять свои сообщения Вы не можете добавлять вложения |

При создании RAID-массивов на контроллерах HPE Smart Array не допускается комбинированное использование дисков с разными интерфейсами (SAS и SATA) в рамках одного массива. Поэтому, в случае, если ранее операционная система сервера была установлена на RAID-массив, состоящий из дисков одного типа (например SAS HDD), то в случае необходимости переноса ОС на диски другого типа (например SATA SSD), нам потребуется создать отдельный RAID-массив из дисков такого типа. Здесь мы рассмотрим пример подобного переноса ОС Windows Server 2012 R2, развёрнутой на сервере HPE ProLiant Gen9, без необходимости переустановки ОС, то есть с минимальным временем простоя сервера.

Исходные данные, используемые в нашем примере:

- В сервере установлен RAID-контроллер HPE Smart Array P440ar и включена загрузка UEFI;

- Загружаемая ОС сервера установлена на массив RAID-1 из пары дисков SAS HDD 72GB;

- Необходимо перенести ОС сервера на массив RAID-1 из пары дисков SATA SSD 150GB;

Минимальные условия:

- В дисковой корзине сервера имеется хотя бы один свободный слот для установки дополнительного диска (только на время переноса ОС);

- На сервере установлена утилита HPE Smart Storage Administrator (SSA). Загрузить актуальную версию можно здесь;

- Имеются загрузочные образы:

- HPE Smart Storage Administrator Offline

- MiniTool Partition Wizard (Free Edition)

Используемый в нашем случае вариант плана действий по переносу ОС:

- Делаем резервные копии всего, что можно сделать;

- Снимаем с сервера продуктивную нагрузку и переводим сервер в режим обслуживания в системах управления, таких как SCVMM и SCOM;

- Выключаем сервер, штатно завершая работу ОС;

- Извлекаем из дисковой корзины сервера один из дисков SAS HDD из текущего массива RAID-1;

- Включаем сервер и, игнорируя сообщения об аварии в RAID, дожидаемся успешной загрузки Windows Server;

- В свободный слот дисковой корзины сервера устанавливаем первый диск SATA SSD;

- Заходим в утилиту HPE SSA и создаём с установленным в п.6 SSD-диском новый массив RAID-0;

- Выключаем сервер, штатно завершая работу ОС;

- (Опционально) Отсоединяем сервер от SAN;

- Загружаем сервер с образа MiniTool Partition Wizard;

- В среде MiniTool копируем разделы со старого RAID-1 на новый RAID-0;

- Завершаем работу среды MiniTool и выключаем сервер;

- Извлекаем из дисковой корзины сервера второй диск SAS HDD из старого массива RAID-1;

- Загружаем сервер с образа HPE SSA Offline;

- В среде SSA Offline удаляем ссылку на старый массив RAID-1 из отсутствующих дисков SAS HDD;

- В среде SSA Offline определяем массив RAID-0, как загрузочный.

- Завершаем работу среды SSA Offline и выключаем сервер;

- Включаем сервер и убеждаемся в успешной загрузке Windows Server с нового массива RAID-0;

- В высвободившийся ранее слот дисковой корзины сервера устанавливаем второй диск SATA SSD;

- Заходим в утилиту HPE SSA и конвертируем массив RAID-0 в RAID-1 с присоединением второго диска SATA SSD.

Пройдёмся по пунктам этого плана.

Подготовка сервера

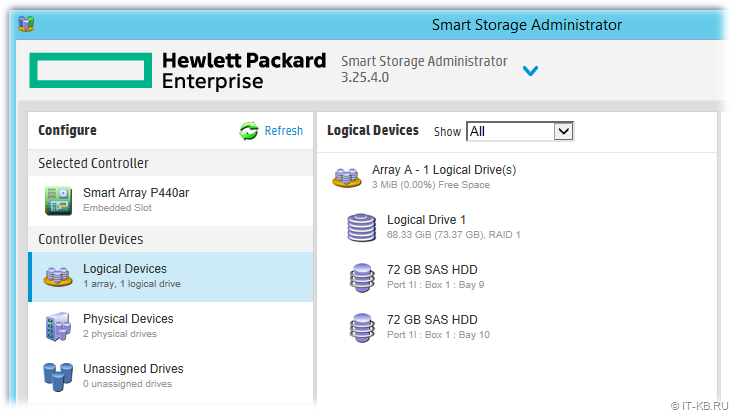

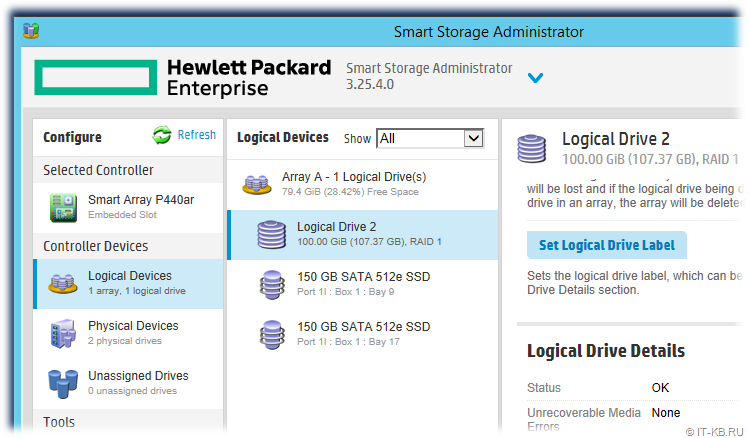

Сюда входят пункты 1-2 нашего плана. Особых комментариев по поводу этих пунктов нет, так как смысл их понятен каждому. Единственное, на что стоит обратить внимание перед началом манипуляций с RAID-массивами, так это на то, что контроллер Smart Array должен функционировать в штатном режиме без каких-либо ошибок. Для этого заглянем в утилиту HPE Smart Storage Administrator (SSA) и проверим текущую конфигурацию RAID.

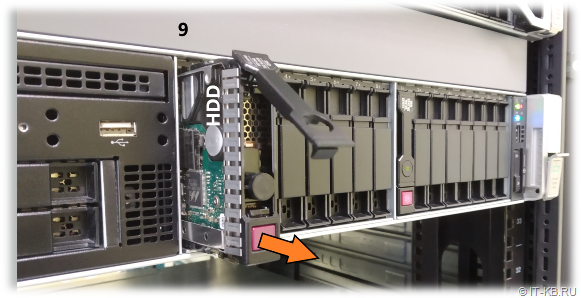

В нашем случае массив RAID-1 состоит из двух дисков SAS HDD, установленных в 9 и 10 слотах дисковой корзины сервера.

Массив работает в штатном режиме.

Изменение конфигурации RAID-массивов

Сюда входят пункты 3-9 нашего плана.

Выключаем сервер, штатно завершая работу ОС.

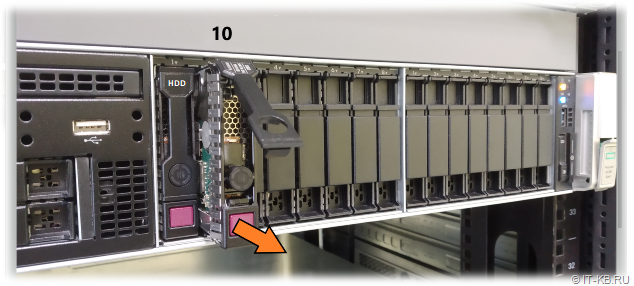

Извлекаем из дисковой корзины сервера один из дисков SAS HDD из

текущего массива RAID-1. В нашем примере извлекается диск из слота 10.

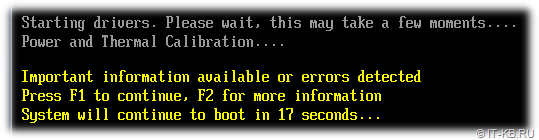

Включаем сервер и, игнорируя сообщения об аварии в RAID, дожидаемся успешной

загрузки Windows Server.

Не смотря на аварийное состояние нашего текущего RAID-1, операционная система должна успешно загрузиться с доступного диска в слоте 9.

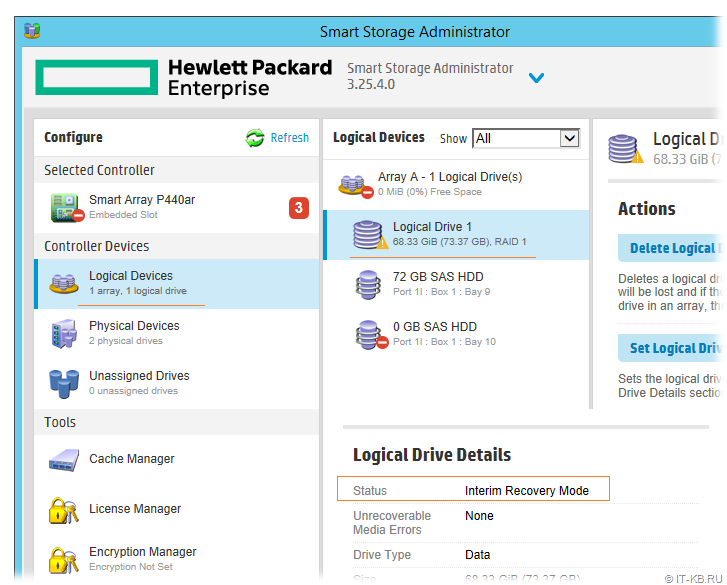

Запускаем утилиту SSA и видим, что статус массива изменился на критический, так как система запущена без зеркального диска

Массив перешёл в режим Interim Recovery Mode и всё ещё находится в работоспособном состоянии.

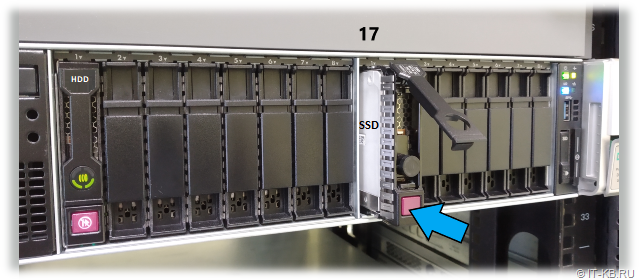

В свободный слот дисковой корзины сервера устанавливаем первый диск SATA

SSD. В нашем примере SSD диск установлен в 17 слот.

Здесь важно использовать для установки нового SSD диска слот корзины, отличный от того, из которого мы только что вытащили SAS HDD. Если вставить диск в тот же слот, то контроллер будет переводить этот диск в состояние ошибки.

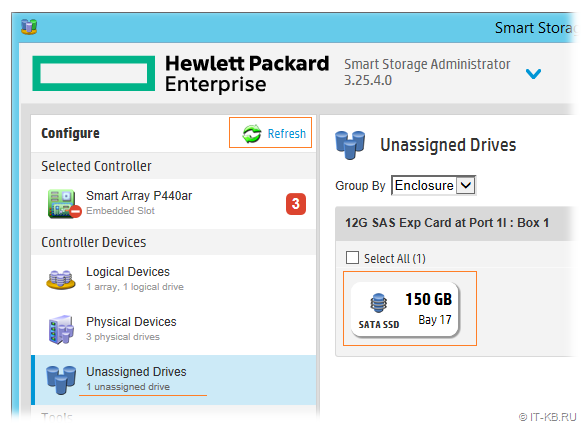

Жмём кнопку Refresh или просто перезапускаем утилиту SSA, чтобы получить обновлённую информацию. Добавленный SSD диск должен появится в разделе Unassigned Drives

Создаём с членством этого SSD диска новый

массив RAID-0

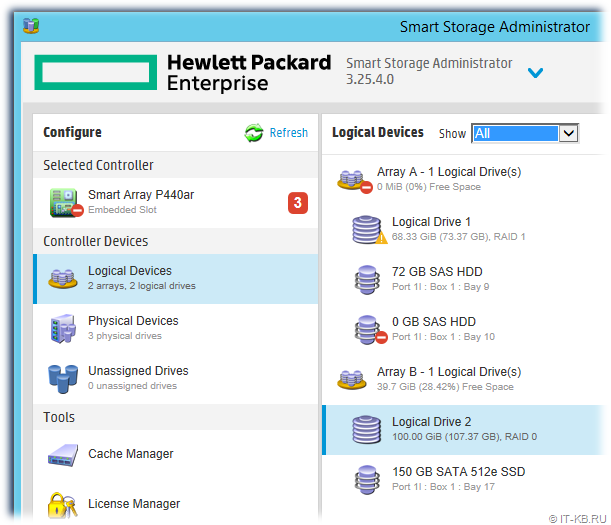

В нашем случае на базе нового RAID-массива создан логический диск, меньшего размера (~107GB), чем позволяет физическая ёмкость диска (150GB) намеренно. Несмотря на то, что производители серверных SSD-дисков уже изначально закладывают некоторый запас резервных ячеек при производстве дисков, есть мнение, что при возможности лучше всё же оставлять небольшой процент неразмеченного пространства дисковой ёмкости. По крайней мере в дальнейшем расширить диск при необходимости нет никаких проблем, так как эта операция давно поддерживается в онлайн-режиме и на уровне самих контроллеров Smart Array и на уровне файловой системы NTFS в Windows Server.

После того, как создан новый массив RAID-0, выключаем сервер, штатно завершая работу ОС.

Если сервер имеет подключения к внешним дисковым массивам через SAN, то на данном этапе желательно отключить сервер от SAN, чтобы избежать потенциальных проблем при последующей работе с загрузочными утилитами для работы с дисковыми разделами.

Копирование дисковых разделов с HDD на SSD

Сюда входят пункты 10-12 нашего плана. Нам предстоит выполнить копирование разделов диска с операционной системой сервера со старого полу-разобранного массива RAID-1 на только что созданный массив RAID-0.

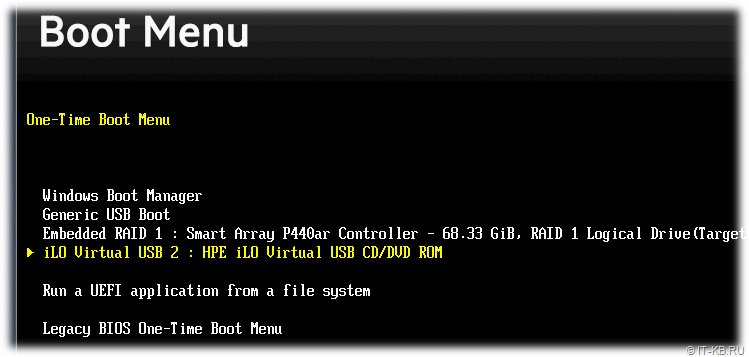

Загружаем сервер с образа MiniTool Partition Wizard. Для этого можно использовать, например, возможность загрузки ISO-образов по сети через интерфейс управления сервером HPE iLO.

В процессе загрузки сервера жмём F11 Boot Menu, чтобы попасть в загрузочное меню.

В меню загрузки указываем загрузочный накопитель. В нашем случае это ISO-образ смонтированный через интерфейс iLO.

Дожидаемся окончания процесса загрузки среды MiniTool Partition Wizard. Сообщение об ограниченности загруженной бесплатной версии MiniTool можем проигнорировать, так как это не помешает нам выполнить копирование разделов.

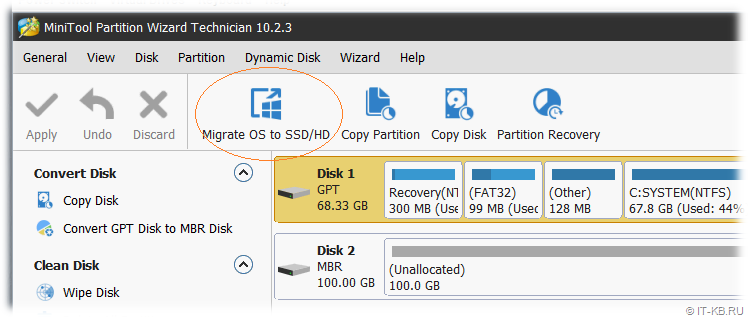

Здесь выбираем исходный диск на массиве RAID-1 и жмём на верхней панели кнопку Migrate OS to SSD/HD.

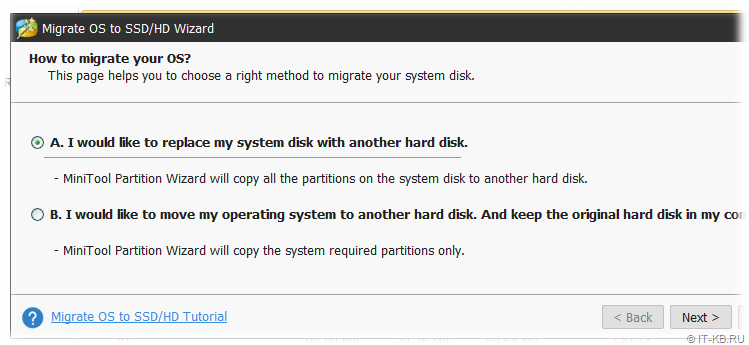

В открывшемся окне мастера миграции выбираем вариант A, чтобы вся структура разделов была скопирована с исходного диска на целевой диск.

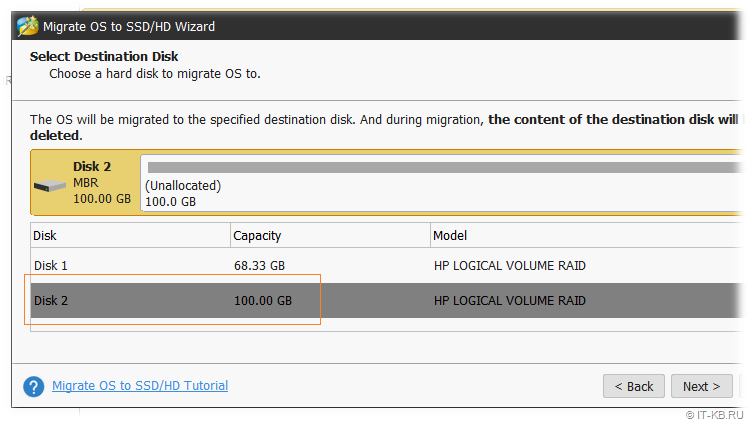

На следующем шаге выбираем целевой диск. В нашем случае это массив RAID-0.

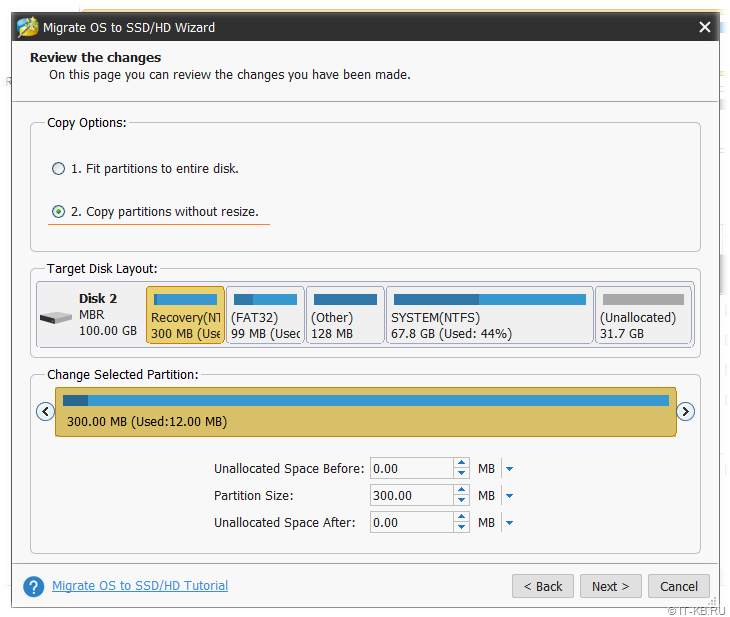

Далее выбираем опции копирования разделов. В нашем случае разделы копируются без масштабирования под новую увеличенную ёмкость диска.

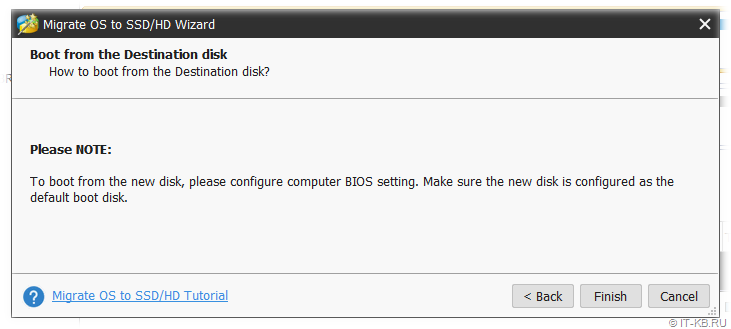

На следующем шаге мастер обращаем внимание на уведомление о том, что после копирования может потребоваться переопределение загрузочного диска в настройках микрокода BIOS. В нашем случае выбор загрузочного диска определяется на уровне RAID-контроллера и мы сделаем это позже (п.16 плана).

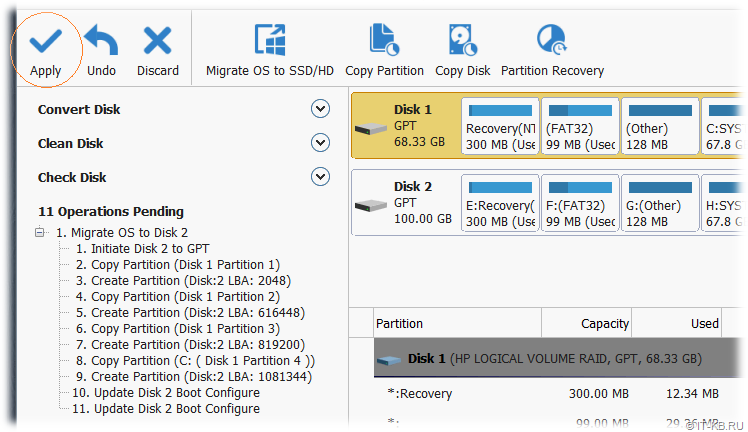

Мастер миграции будет закрыт, а в главном окне MiniTool Partition Wizard в разделе Operations Pending появится запланированная последовательность действий с дисковыми разделами. Нажимаем кнопку Apply, чтобы запустить фактическое выполнение запланированных действий.

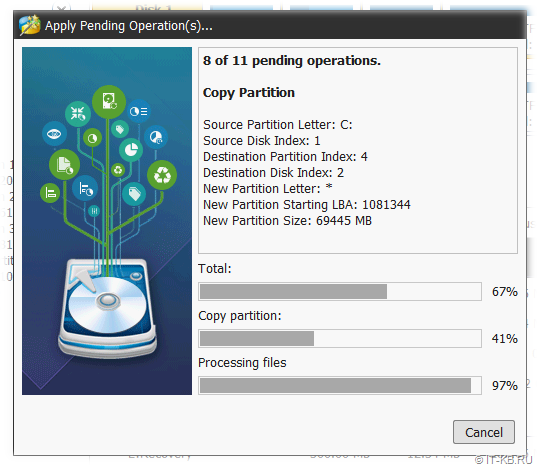

Время выполняемых операций будет напрямую зависеть от скорости исходного и целевого дисков.

Дожидаемся успешного завершения копирования разделов, после чего завершаем работу среды MiniTool Partition Wizard и выключаем сервер.

Удаление массива SAS HDD

На этом этапе выполняем пункты 13-17 нашего плана.

Извлекаем из дисковой корзины сервера второй диск SAS HDD из

старого массива RAID-1. В нашем примере извлекается HDD диск из слота 9.

Загружаем сервер с образа HPE SSA Offline. Опять же, для этого можно использовать возможность загрузки ISO-образов по сети через интерфейс управления сервером HPE iLO.

В процессе загрузки сервера, как и ранее, получим предупреждение о критическом состоянии конфигурации RAID-массива на контроллере Smart Array. Игнорируем его и продолжаем процесс загрузки.

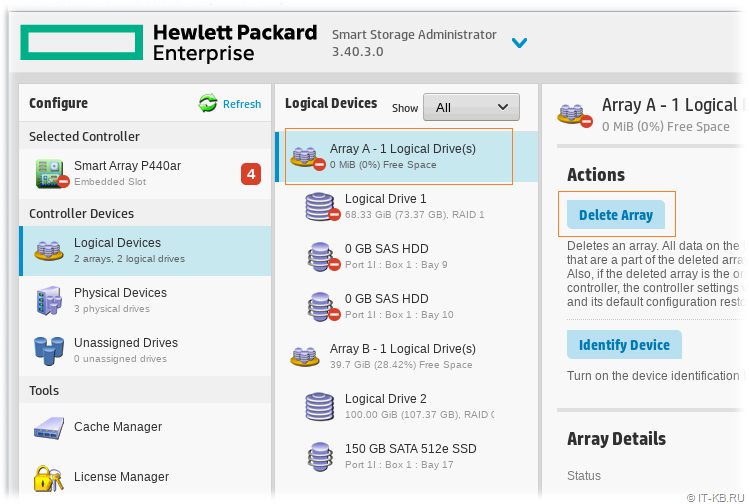

В загрузившейся среде SSA Offline удаляем ссылку на старый массив RAID-1 из

отсутствующих дисков SAS HDD – Delete Array

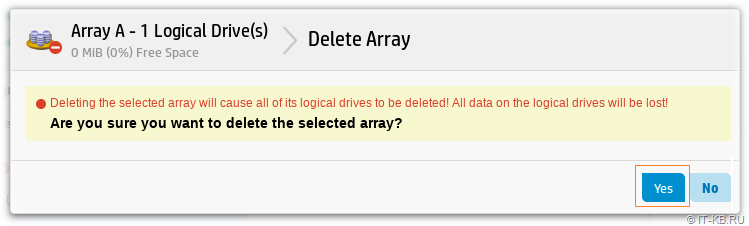

Понимая что мы делаем, подтверждаем удаление ссылки на RAID-массив

На самом деле здесь только удаляется ссылка на RAID-массив из метаданных, хранящихся в энергонезависимой памяти сервера. При наличии дисков, которые ранее были членами массива, массив может быть автоматически воссоздан, если, например, установить эти диски в этот же или другой сервер с контроллером Smart Array. Поэтому извлечённые нами ранее диски SAS HDD можно сохранять на всякий случай до тех пор, пока все пункты нашего плана не будут выполнены успешно.

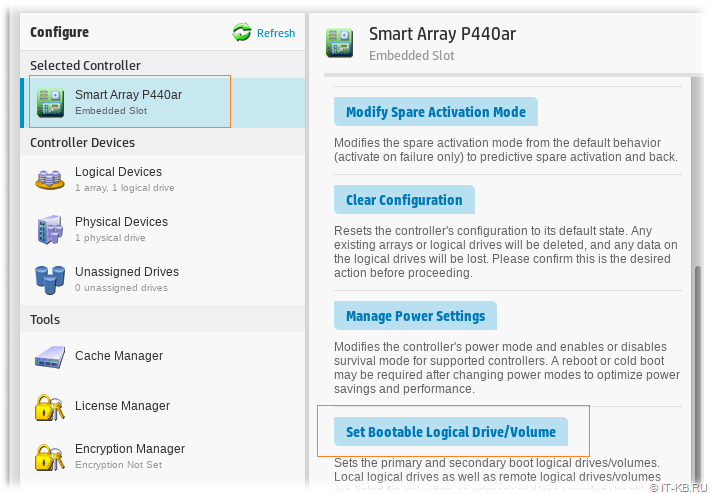

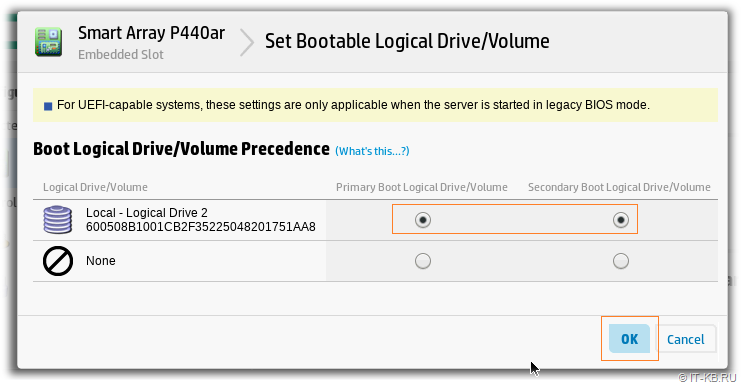

В среде SSA Offline, выбрав раздел настроек RAID-контроллера Smart Array, пройдём по ссылке Set Bootable Logical Drive/Volume для того, чтобы определить созданный нами ранее массив RAID-0, как загрузочный.

Выбираем единственный оставшийся у нас логический диск Smart Array, как загрузочный.

После этого завершаем работу среды SSA Offline и выключаем сервер.

Конвертация массива RAID-0 в RAID-1

В эту заключительную стадию входят пункты 18-20 нашего плана.

Включаем сервер и убеждаемся в успешной загрузке Windows Server с нового

массива RAID-0, который мы только что обозначили в качестве загрузочного. На этот раз сервер должен загрузиться без сообщений об ошибках конфигурации RAID.

После того, как ОС успешно загрузится, в высвободившийся ранее слот дисковой корзины сервера (в нашем случае это 9 слот) устанавливаем второй диск SATA SSD.

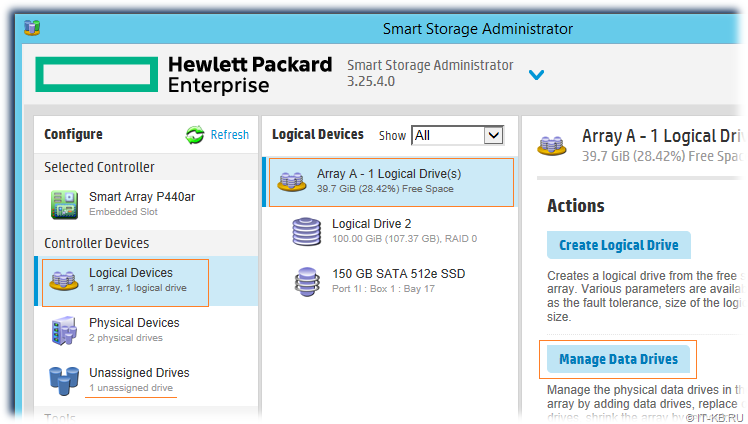

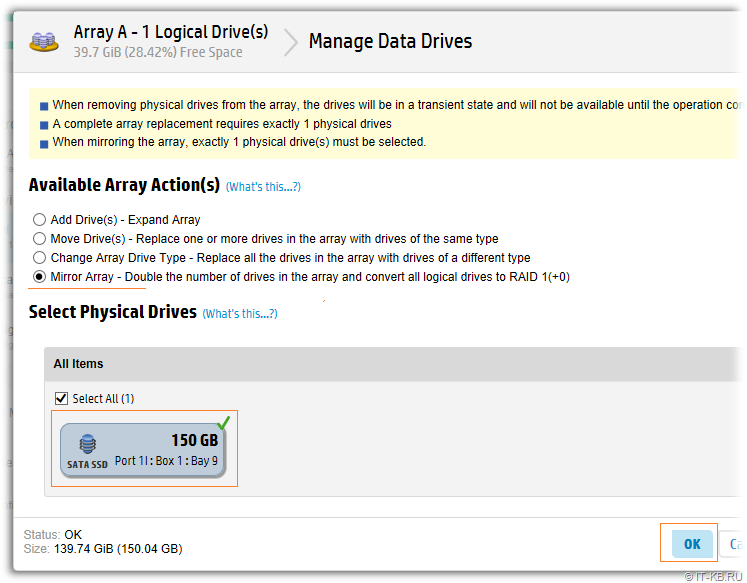

Запускаем утилиту HPE SSA и конвертируем массив RAID-0 в RAID-1 с

присоединением второго, только что установленного, диска SATA SSD. Для этого выбираем RAID-массив и в меню действий используем ссылку Manage Data Drives.

В форме управления дисками нашего массива RAID-0 выбираем тип преобразования в зеркальный массив RAID-1 — Mirror Array и отмечаем добавляемый диск.

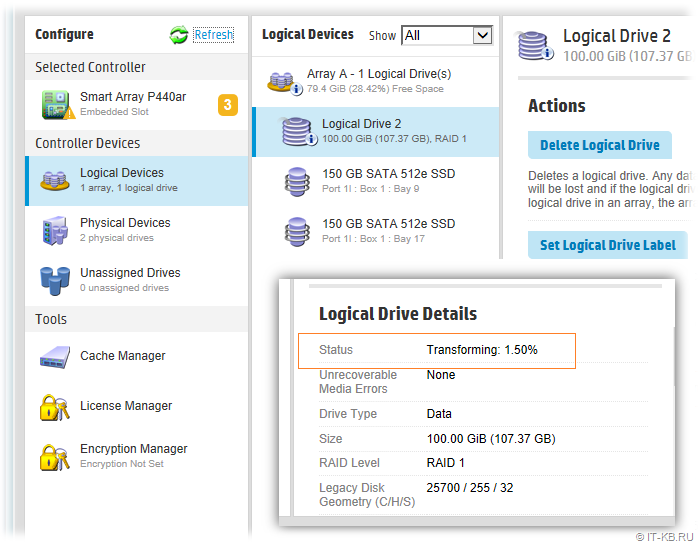

Дожидаемся окончания процесса трансформации, которая будет запущена сразу и пройдёт в онлайн-режиме.

В результате мы получим штатно работающий массив RAID-1 из пары дисков SATA SSD.

Можно считать, что поставленная задача выполнена. Теперь остаётся только подключить сервер к SAN, если ранее выполнялось отключение на этапе п.9.

Добрый день. Есть установленная рабочая Windows Server 2022. Скажем так, на обычном компьютере с AHCI (понятно, что это не совсем правильно, но так уж получилось). Есть ли рабочие варианты переноса системы на сервер с аппаратным RAID (в данном случае Avago MegaRaid)?

Пробовал перенести, выдаёт INACCESSIBLE_BOOT_DEVICE. Пробовал в настройках RAID устанавливать JBOD, ничего не меняется, всё равно синий экран.

-

Вопрос задан

-

183 просмотра

Перед переносом, необходимо установить драйвера на этот рейдконтроллер (вы бы хотя бы модель контроллера сказали).

p.s. если это дешевый рейд контроллер за условную тысячу рублей, то смысла в нем не много, и возможно удобнее будет установить систему на програмный рейд, тем более windows его поддерживает… заодно не привяжете установку к конкретному вендору контроллера.

Пригласить эксперта

для начала попробуйте восстановить загрузчик на новом железе

грузитесь с ISO\флешки и проверяете, видите ли вы вообще данные на диске

затем восстановление (или создание нового) загрузчика

Возможно, системе еще не будет хватать драйверов того самого Avago MegaRaid

Перед переносом нужно настроить загрузку драйвера в процессе начальной загрузки системы. Требуется сделать следующее

1. Установить драйвер для RAID-контроллера

2. Установить для драйвера тип запуска boot, например — командой sc config имя_драйвера start= boot

Имя_драйвера можно найти, посмотрев список драйверов командой sc query type= driver (возможно, чтобы увидеть весь список потребуется увеличить размер буфера параметром bufsize= ).

Установить Hyper-V сервер на железо с рейд контроллером и виртуализировать в него текущий. Будет быстро, красиво и управляемо.

Войдите, чтобы написать ответ

-

Показать ещё

Загружается…

Минуточку внимания

Задача[]

Произвести перенос рабочей операционной системы на RAID массив любого уровня по следующей схеме:

- Структура разделов на физических носителях GPT (снимает ограничение в 2 Тб на носитель)

- 1 раздел для обеспечения поддержки загрузки BIOS компьютера и размещения менеджера загрузки Linux

- 2. раздел является хранилищем зеркального тома RAID1 и расположен на каждом физическом диске

- 3. раздел является хранилищем RAID любого уровня внутри которого располагается LVM структура

- LVM содержит том для данных и для файла подкачки.

Загрузка и обновление компонентов[]

apt-get update apt-get install -y mdadm initramfs-tools lvm2 atop htop sysstat smartmontools rsync parted jfsutils

Определения[]

Проверим список доступных в системе дисков

fdisk -l|grep Диск

Уточним, какой диск является рабочим, то-есть диск, с которого загрузилась система

echo Системный `df -h|grep -Po "/dev/..."`

Задаем диски, который будем готовить под RAID

workdsk=sda # Системный newdsk=sdb # Новый (дополнительный) диск, на который будем копировать данные

Очищаем таблицу разделов на указанном жестком диске и размечаем диск в GPT.

dd if=/dev/zero of=/dev/$newdsk bs=512 count=1 parted /dev/$newdsk mklabel gpt

Определяем максимальный размер диска и создаем разделы на нем

sizedsk=`parted /dev/$newdsk print -m | grep "/dev/$newdsk" | awk -F ":" '{print $2}'`

parted /dev/$newdsk mkpart primary 1M 10M

parted /dev/$newdsk set 1 bios_grub on

parted /dev/$newdsk mkpart primary 10М 128M

parted /dev/$newdsk mkpart primary 128M $sizedsk

parted /dev/$newdsk print

Предварительная настройка RAID в режиме деградации[]

Создаем массивы в деградированном состоянии на диске sdb:

- md0 для загрузки (обязательно зеркало -level=1) расположен во 2м разделе GPT

- md1 массив для данных, может быть любого уровня (в примере 1) расположен в 3м, наибольшем разделе GPT

mdadm --create /dev/md0 --metadata=0.90 --level=1 --raid-devices=2 missing /dev/${newdsk}2

mdadm --create /dev/md1 --metadata=0.90 --level=1 --raid-devices=2 missing /dev/${newdsk}3

Сохраним параметры массива в конфигурационном файле:

mdadm --detail --scan >> /etc/mdadm/mdadm.conf

LVM[]

Создадим структуру разделов в LVM:

- lv_swap для подкачки в начале диска размером 8 Гб (8192 Мб)

lv_swap=8192

- Выделим отдельный раздел lv_add для хранения данных, которые могут переполнить диск под, например /var/spool и установим ему размер 70% от размера диска. Это позволит избежать ситуаций с переполнением диска и отказом всей системы.

lv_add_dir=/var/spool lv_add_size=70%FREE

- lv_root оставшееся место под корневую систему

pvcreate /dev/md1 vgcreate lv /dev/md1 lvcreate -L$lv_swap lv -n lv_swap lvcreate -l$lv_add_size lv -n lv_add lvcreate -l100%FREE lv -n lv_root vgchange -a y lv

Работа с дополнительным диском[]

Форматирование разделов

- Загрузочный раздел форматируем в ext2, корень системы в ext4, а рабочие данные будут в файловой системе jfs

mkfs.ext2 /dev/md0 mkfs.ext4 /dev/lv/lv_root mkfs.jfs /dev/lv/lv_add -ff mkswap /dev/lv/lv_swap

Создадим точки монтирования созданных разделов и примонтируем их

mkdir /mnt/lv_boot mkdir /mnt/lv_root mkdir /mnt/lv_add mount /dev/md0 /mnt/lv_boot mount /dev/lv/lv_root /mnt/lv_root mount /dev/lv/lv_add /mnt/lv_add

Произведем копирование загрузочных файлов и остальных данных исключая служебные каталоги в соответвтующие разделы

rsync -aHEAXh --progress /boot/* /mnt/lv_boot

rsync -aHEAXh --progress / /mnt/lv_root \ --exclude '/boot' \ --exclude '/mnt' \ --exclude '/proc' \ --exclude '/dev' \ --exclude 'lost+found' \ --exclude '/sys' \ --exclude $lv_add_dir

rsync -aHEAXh --progress $lv_add_dir/* /mnt/lv_add

Создадим новые служебные каталоги и назначим на них права

mkdir /mnt/lv_root/dev mkdir /mnt/lv_root/proc mkdir /mnt/lv_root/sys mkdir /mnt/lv_root/boot mkdir /mnt/lv_root/mnt mkdir /mnt/lv_root/$lv_add_dir

Войдем в окружение созданой копии системы

mount /dev /mnt/lv_root/dev -o bind mount /proc /mnt/lv_root/proc -o bind mount /sys /mnt/lv_root/sys -o bind echo "export workdsk=$workdsk" > /mnt/lv_root/tmp/wvars echo "export newdsk=$newdsk">> /mnt/lv_root/tmp/wvars echo "export lv_add_dir=$lv_add_dir">> /mnt/lv_root/tmp/wvars

Переходим в окружение скопированной системы[]

chroot /mnt/lv_root /bin/bash

Восстанавливаем переменные

`cat < /tmp/wvars`

Создадим файл монтирования файловых систем при загрузке

echo "" > /etc/fstab echo "proc /proc proc nodev,noexec,nosuid 0 0" >> /etc/fstab echo "/dev/md0 /boot ext2 defaults 0 2" >> /etc/fstab echo "/dev/lv/lv_swap none swap sw 0 0" >> /etc/fstab echo "/dev/lv/lv_root / ext4 errors=remount-ro 0 1" >> /etc/fstab echo "/dev/lv/lv_add $lv_add_dir jfs errors=remount-ro 0 1" >> /etc/fstab

Разрешим системе автоматически запускаться, если один из дисков вышел из строя или отсутствует (по умолчанию при загрузке будет выдаваться запрос на разрешение запуска)

echo "BOOT_DEGRADED=true" > /etc/initramfs-tools/conf.d/mdadm

Подмонтируем загрузочный раздел в соответствии с указанными параметрами fstab с генерируем загрузочное ядро

mount /boot mkinitramfs -o /boot/initrd.img-`uname -r`

Отключим графический режим загрузчика из-за которого система может не загружаться с рейда.

echo "GRUB_TERMINAL=console" >> /etc/default/grub

Выполним запись в загрузочный сектор второго жесткого диска и обновление параметров загрузчика

grub-install --recheck /dev/$newdsk update-grub

В результате проделанных действий мы получили систему, которая должна запускать с RAID массива, но при этом сам массив находится в состоянии деградации и ожидает, когда будет доступен новый физический диск. В качестве такого диска теперь можно использовать как новый диск, так и диск с исходной системой, который надо предварительно очистить.

Очищаем таблицу разделов на исходном диске. Все данные на нем будут уничтожены! Все изменения в файлах произошедшие со времени начала копирования данных с него на второй диск будут потеряны.

dd if=/dev/zero of=/dev/$workdsk bs=512 count=1

Перезагружаем систему.

reboot

ВНИМАНИЕ. Если процесс выполняется удаленно, что выполнено условие:

В БИОС компьютера должен быть настроен режим последовательной загрузки с жестких дисков, т.е. если загрузиться с первого диска не удалось, должна произойти автоматическая загрука со второго. Если это не так, и система не загружается, необходимо переключить загрузку на второй диск или поменять местами интерфейсные кабели.

Подключение или замена диска в RAID[]

- Далее все действия идентичны как для первичного добавления диска, так и для замены вышедшего из строя

Проверим список дисков в системе

fdisk -l 2>/dev/null|grep -s Диск|grep -s -Pv "md|lv"

Диск который будет добавляться в массив, на данном этапе не должен быть быть членом рейда. Проверим, какой диск в рейде:

cat /proc/mdstat|grep md0|grep -Po "raid1 ..."

Чтобы не ошибиться в дальнейших действиях и не испортить данные создадим переменные с именами дисков.

workdsk=sdb # Диск, который подключен к массиву и содержит систему cleandsk=sda # чистый (пустой) диск, который будет добавлен

Произведем копирование структуры разделов с рабочего на чистый диск и подключим его к массиву

dd if=/dev/$workdsk of=/dev/$cleandsk bs=512 count=34

blockdev --rereadpt /dev/$cleandsk

mdadm --add /dev/md0 /dev/${cleandsk}2

mdadm --add /dev/md1 /dev/${cleandsk}3

Установим загрузчик на добавленный диск

grub-install /dev/$cleandsk

На этом действия по переносу системы на рейд массив завершены, осталось дождаться окончания синхронизации массива. Контролировать процесс можно с помощью команды:

watch cat /proc/mdstat

- Уменьшить размер раздела через Gparted через Ubuntu Live CD.

- Загрузиться и проверить, что все ОК. Скорей всего запустится

chkdskи будет испрвлять ошибки. - Сделать образ РАЗДЕЛОВ в clonezilla.

- Собрать рейд и установить винду на рейд, используя драйвера.

- Отключить рейд контроллер и подключить винты в материнскую плату.

- Восстановить из образа clonezilla содержимое разделов, не трогая MBR!

Возможно 100Мб раздел не нужно восстанавливать, т.к. туда были установлены драйвера для рейда, а в сохраненном образе их НЕТ!

Следовательно средство восстановления запуска не получится запустить в дальнейшем…

Чтобы избежать этой проблемы лучше не восстаналивать 100Мб раздел… Хотя не уверен! Нужно проверить. - Подключить обратно рейд контроллер и винты.

- Загрузиться и проверить, что все работает

Скорей всего запустится

chkdskи будет испрвлять ошибки.

P.S. Это сырая статья.

Скорей всего запустится

Скорей всего запустится