Table of Contents

- 1. Introduction

- 1.1. Audience

- 1.2. Supported Virtual Machine Operating Systems

- 1.3. Virtual Machine Performance Parameters

- 1.4. Installing Supporting Components on Client Machines

- 1.4.1. Installing Console Components

- 2. Installing Enterprise Linux Virtual Machines

- 2.1. Creating a virtual machine

- 2.2. Starting the Virtual Machine

- 2.2.1. Starting a Virtual Machine

- 2.2.2. Opening a console to a virtual machine

- 2.2.3. Opening a Serial Console to a Virtual Machine

- 2.2.4. Automatically Connecting to a Virtual Machine

- 2.3. Enabling the Required Repositories

- 2.4. Installing Guest Agents and Drivers

- 2.4.1. oVirt Guest agents, tools, and drivers

- 2.4.2. Installing the Guest Agents and Drivers on Enterprise Linux

- 3. Installing Windows virtual machines

- 3.1. Creating a virtual machine

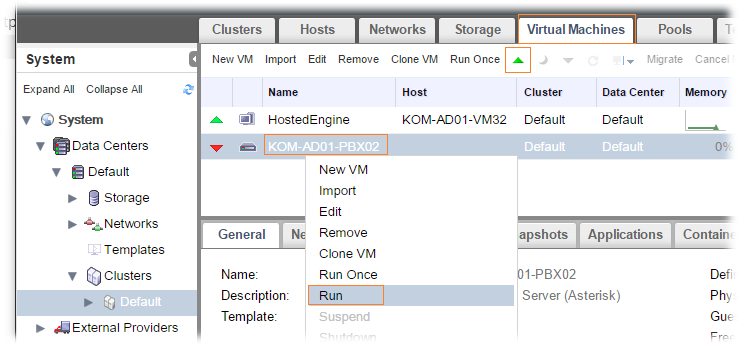

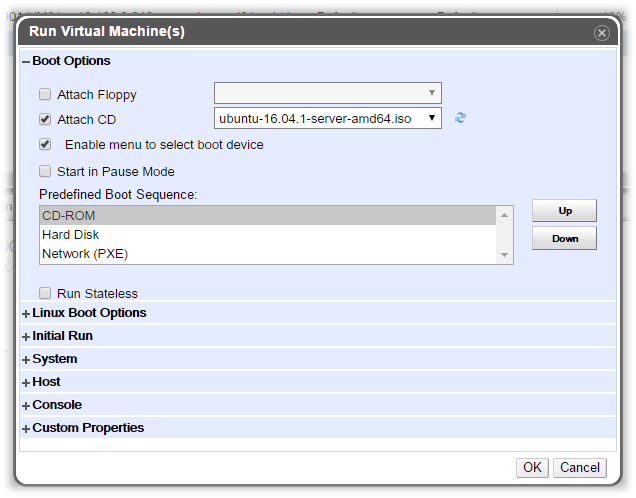

- 3.2. Starting the virtual machine using Run Once

- 3.2.1. Installing Windows on VirtIO-optimized hardware

- 3.2.2. Opening a console to a virtual machine

- 3.3. Installing guest agents and drivers

- 3.3.1. oVirt Guest agents, tools, and drivers

- 3.3.2. Installing the guest agents, tools, and drivers on Windows

- 3.3.3. Values for ADDLOCAL to customize virtio-win command-line installation

- 4. Additional Configuration

- 4.1. Configuring Operating Systems with osinfo

- 4.2. Configuring Single Sign-On for Virtual Machines

- 4.2.1. Configuring Single Sign-On for Enterprise Linux Virtual Machines Using IPA (IdM)

- 4.2.2. Configuring single sign-on for Windows virtual machines

- 4.2.3. Disabling Single Sign-on for Virtual Machines

- 4.3. Configuring USB Devices

- 4.3.1. Using USB Devices on a Windows Client

- 4.3.2. Using USB Devices on a Enterprise Linux Client

- 4.4. Configuring Multiple Monitors

- 4.4.1. Configuring Multiple Displays for Enterprise Linux Virtual Machines

- 4.4.2. Configuring Multiple Displays for Windows Virtual Machines

- 4.5. Configuring Console Options

- 4.5.1. Console Options

- 4.5.2. Accessing Console Options

- 4.5.3. SPICE Console Options

- 4.5.4. VNC Console Options

- 4.5.5. RDP Console Options

- 4.5.6. Remote Viewer Options

- 4.6. Configuring a Watchdog

- 4.6.1. Adding a Watchdog Card to a Virtual Machine

- 4.6.2. Installing a Watchdog

- 4.6.3. Confirming Watchdog Functionality

- 4.6.4. Parameters for Watchdogs in watchdog.conf

- 4.7. Configuring Virtual NUMA

- 4.8. Configuring Satellite errata viewing for a virtual machine

- 4.9. Configuring Headless Virtual Machines

- 4.10. Configuring High Performance Virtual Machines, Templates, and Pools

- 4.10.1. Creating a High Performance Virtual Machine, Template, or Pool

- 4.10.2. Configuring the Recommended Manual Settings

- 4.11. Configuring the time zone

- 5. Editing Virtual Machines

- 5.1. Editing Virtual Machine Properties

- 5.2. Network Interfaces

- 5.2.1. Adding a New Network Interface

- 5.2.2. Editing a Network Interface

- 5.2.3. Hot Plugging a Network Interface

- 5.2.4. Removing a Network Interface

- 5.2.5. Configuring a virtual machine to ignore NICs

- 5.3. Virtual Disks

- 5.3.1. Adding a New Virtual Disk

- 5.3.2. Attaching an Existing Disk to a Virtual Machine

- 5.3.3. Extending the Available Size of a Virtual Disk

- 5.3.4. Hot Plugging a Virtual Disk

- 5.3.5. Removing a Virtual Disk from a Virtual Machine

- 5.3.6. Importing a Disk Image from an Imported Storage Domain

- 5.3.7. Importing an Unregistered Disk Image from an Imported Storage Domain

- 5.4. Virtual Memory

- 5.4.1. Hot Plugging Virtual Memory

- 5.4.2. Hot Unplugging Virtual Memory

- 5.5. Hot Plugging vCPUs

- 5.6. Pinning a Virtual Machine to Multiple Hosts

- 5.7. Viewing Virtual Machines Pinned to a Host

- 5.8. Changing the CD for a Virtual Machine

- 5.9. Smart Card Authentication

- 6. Administrative Tasks

- 6.1. Shutting Down a Virtual Machine

- 6.2. Suspending a Virtual Machine

- 6.3. Rebooting or Resetting a Virtual Machine

- 6.4. Removing a Virtual Machine

- 6.5. Cloning a Virtual Machine

- 6.6. Updating Virtual Machine Guest Agents and Drivers

- 6.6.1. Updating the Guest Agents and Drivers on Enterprise Linux

- 6.6.2. Updating Windows drivers with Windows Update

- 6.6.3. Updating Windows guest agents and drivers using the command prompt

- 6.7. Viewing Red Hat Satellite Errata for a Virtual Machine

- 6.8. Virtual Machines and Permissions

- 6.8.1. Managing System Permissions for a Virtual Machine

- 6.8.2. Virtual Machine Administrator Roles Explained

- 6.8.3. Virtual Machine User Roles Explained

- 6.8.4. Assigning Virtual Machines to Users

- 6.8.5. Removing Access to Virtual Machines from Users

- 6.9. Snapshots

- 6.9.1. Creating a Snapshot of a Virtual Machine

- 6.9.2. Using a Snapshot to Restore a Virtual Machine

- 6.9.3. Creating a Virtual Machine from a Snapshot

- 6.9.4. Deleting a Snapshot

- 6.10. Host Devices

- 6.10.1. Adding a Host Device to a Virtual Machine

- 6.10.2. Removing Host Devices from a Virtual Machine

- 6.10.3. Pinning a Virtual Machine to Another Host

- 6.10.4. NVDIMM host devices

- 6.11. Affinity Groups

- 6.11.1. Affinity Groups

- 6.11.2. Creating an Affinity Group

- 6.11.3. Editing an Affinity Group

- 6.11.4. Removing an Affinity Group

- 6.11.5. Affinity Groups Examples

- 6.11.6. Affinity Groups Troubleshooting

- 6.12. Affinity Labels

- 6.12.1. About Affinity Labels

- 6.12.2. Creating an Affinity Label

- 6.12.3. Editing an Affinity Label

- 6.12.4. Deleting an Affinity Label

- 6.13. Exporting and Importing Virtual Machines and Templates

- 6.13.1. Exporting a Virtual Machine to the Export Domain

- 6.13.2. Exporting a Virtual Machine to a Data Domain

- 6.13.3. Importing a Virtual Machine from the Export Domain

- 6.13.4. Importing a Virtual Machine from a Data Domain

- 6.13.5. Importing a Virtual Machine from a VMware Provider

- 6.13.6. Exporting a Virtual Machine to a Host

- 6.13.7. Importing a Virtual Machine from a Host

- 6.13.8. Importing a virtual machine from a RHEL 5 Xen host

- 6.13.9. Importing a Virtual Machine from a KVM Host

- 6.13.10. Importing a Red Hat KVM Guest Image

- 6.14. Migrating Virtual Machines Between Hosts

- 6.14.1. Live Migration Prerequisites

- 6.14.2. Configuring Virtual Machines with SR-IOV-Enabled vNICs to Reduce Network Outage during Migration

- 6.14.3. Configuring Virtual Machines with SR-IOV-Enabled vNICs with minimal downtime

- 6.14.4. Optimizing Live Migration

- 6.14.5. Guest Agent Hooks

- 6.14.6. Automatic Virtual Machine Migration

- 6.14.7. Preventing Automatic Migration of a Virtual Machine

- 6.14.8. Manually Migrating Virtual Machines

- 6.14.9. Setting Migration Priority

- 6.14.10. Canceling Ongoing Virtual Machine Migrations

- 6.14.11. Event and Log Notification upon Automatic Migration of Highly Available Virtual Servers

- 6.15. Improving Uptime with Virtual Machine High Availability

- 6.15.1. What is High Availability?

- 6.15.2. High Availability Considerations

- 6.15.3. Configuring a Highly Available Virtual Machine

- 6.16. Other Virtual Machine Tasks

- 6.16.1. Enabling SAP Monitoring

- 6.16.2. Configuring Enterprise Linux 5.4 and later Virtual Machines to use SPICE

- 6.16.3. KVM Virtual Machine Timing Management

- 6.16.4. Adding a Trusted Platform Module device

- 7. Templates

- 7.1. About Templates

- 7.2. Sealing Virtual Machines in Preparation for Deployment as Templates

- 7.2.1. Sealing a Linux Virtual Machine for Deployment as a Template

- 7.2.2. Sealing a Windows Virtual Machine for Deployment as a Template

- 7.3. Creating a Template

- 7.4. Editing a Template

- 7.5. Deleting a Template

- 7.6. Exporting Templates

- 7.6.1. Migrating Templates to the Export Domain

- 7.6.2. Copying a Template’s Virtual Hard Disk

- 7.7. Importing Templates

- 7.7.1. Importing a Template into a Data Center

- 7.7.2. Importing a Virtual Disk from an OpenStack Image Service as a Template

- 7.8. Templates and Permissions

- 7.8.1. Managing System Permissions for a Template

- 7.8.2. Template Administrator Roles Explained

- 7.8.3. Assigning an Administrator or User Role to a Resource

- 7.8.4. Removing an Administrator or User Role from a Resource

- 7.9. Using Cloud-Init to Automate the Configuration of Virtual Machines

- 7.9.1. Cloud-Init Use Case Scenarios

- 7.9.2. Installing Cloud-Init

- 7.9.3. Using Cloud-Init to Prepare a Template

- 7.9.4. Using Cloud-Init to Initialize a Virtual Machine

- 7.10. Using Sysprep to Automate the Configuration of Virtual Machines

- 7.10.1. Configuring Sysprep on a Template

- 7.10.2. Using Sysprep to Initialize a Virtual Machine

- 7.11. Creating a Virtual Machine Based on a Template

- 7.12. Creating a Cloned Virtual Machine Based on a Template

- Appendix A: Reference: Settings in Administration Portal and VM Portal Windows

- Explanation of Settings in the New Virtual Machine and Edit Virtual Machine Windows

- Virtual Machine General Settings Explained

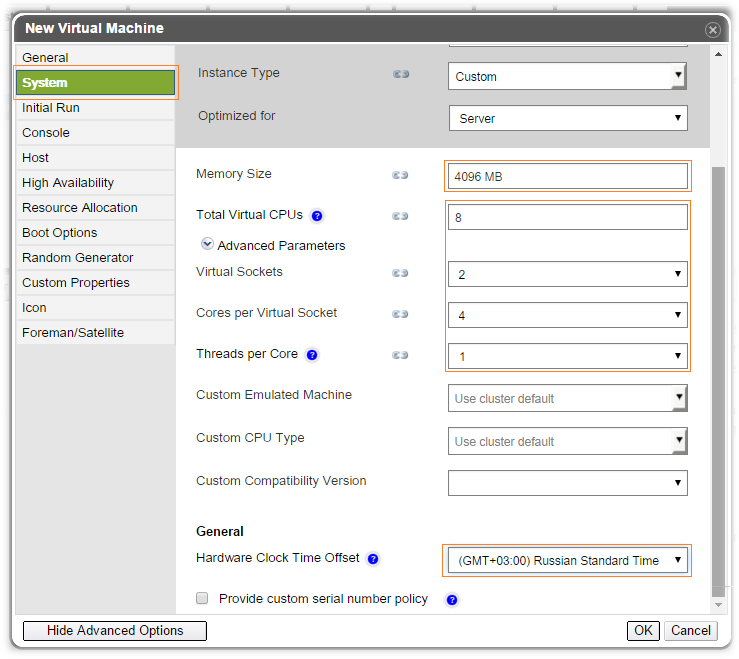

- Virtual Machine System Settings Explained

- Virtual Machine Initial Run Settings Explained

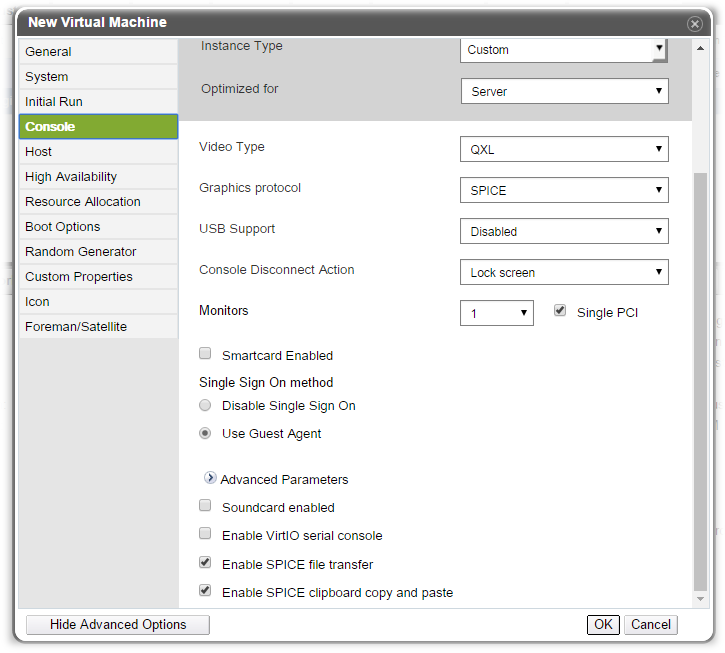

- Virtual Machine Console Settings Explained

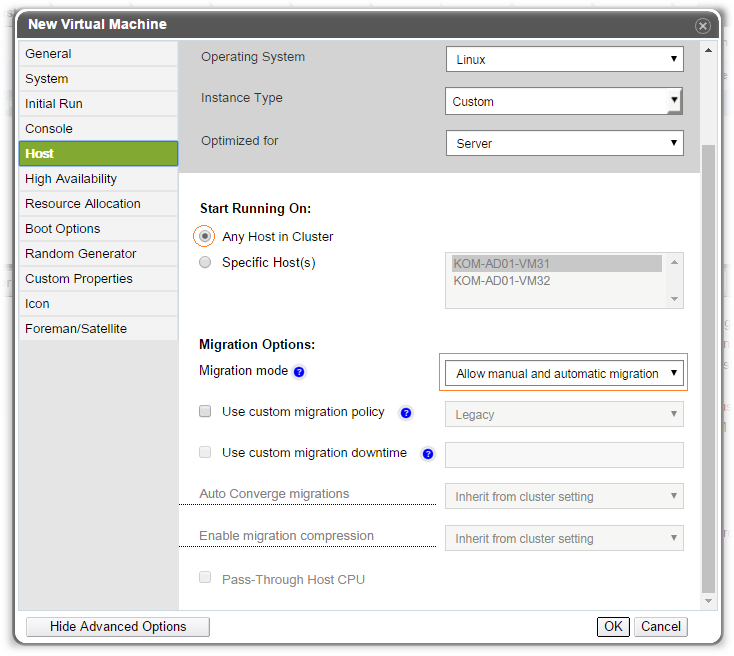

- Virtual Machine Host Settings Explained

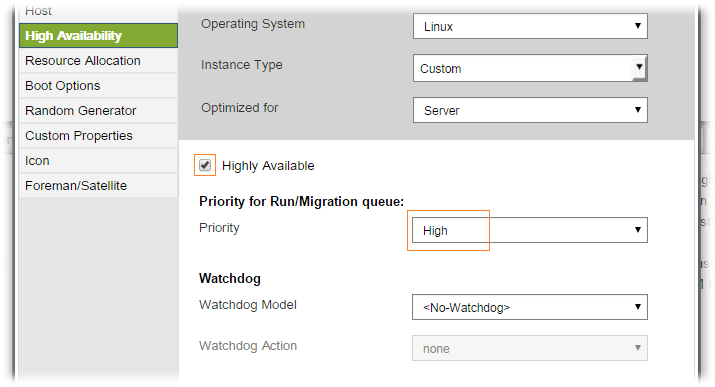

- Virtual Machine High Availability Settings Explained

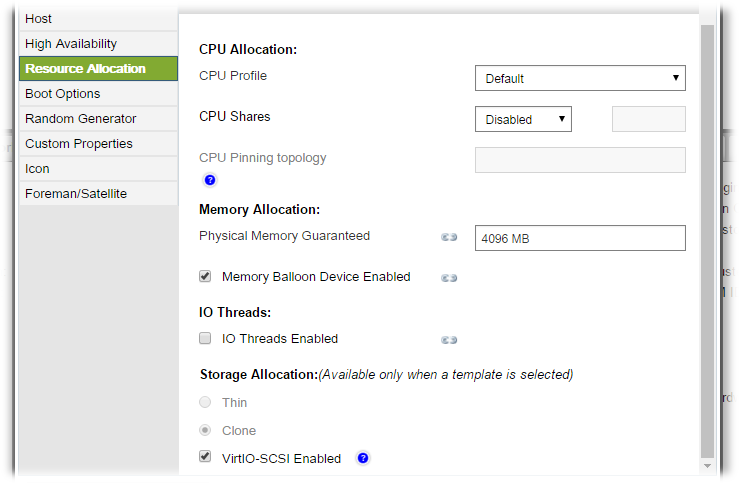

- Virtual Machine Resource Allocation Settings Explained

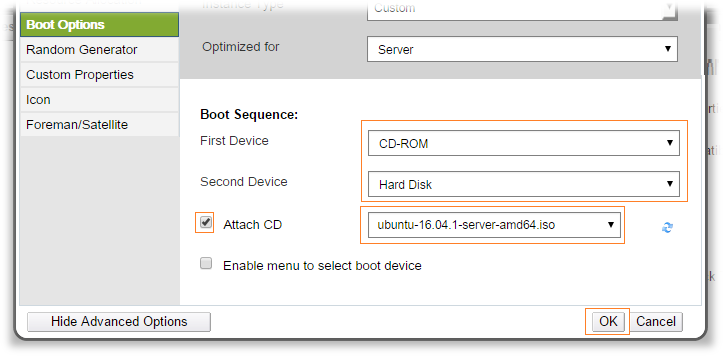

- Virtual Machine Boot Options Settings Explained

- Virtual Machine Random Generator Settings Explained

- Virtual Machine Custom Properties Settings Explained

- Virtual Machine Icon Settings Explained

- Virtual Machine Foreman/Satellite Settings Explained

- Explanation of settings in the Run Once window

- Explanation of Settings in the New Network Interface and Edit Network Interface Windows

- Explanation of settings in the New Virtual Disk and Edit Virtual Disk windows

- Explanation of Settings in the New Template Window

- Explanation of Settings in the New Virtual Machine and Edit Virtual Machine Windows

- Appendix B:

virt-sysprepOperations - Appendix C: Legal notice

1. Introduction

A virtual machine is a software implementation of a computer. The oVirt environment enables you to create virtual desktops and virtual servers.

Virtual machines consolidate computing tasks and workloads. In traditional computing environments, workloads usually run on individually administered and upgraded servers. Virtual machines reduce the amount of hardware and administration required to run the same computing tasks and workloads.

1.1. Audience

Most virtual machine tasks in oVirt can be performed in both the VM Portal and Administration Portal. However, the user interface differs between each portal, and some administrative tasks require access to the Administration Portal. Tasks that can only be performed in the Administration Portal will be described as such in this book. Which portal you use, and which tasks you can perform in each portal, is determined by your level of permissions. Virtual machine permissions are explained in Virtual Machines and Permissions.

The Administration Portal’s user interface is described in the Administration Guide.

The creation and management of virtual machines through the oVirt REST API is documented in the REST API Guide.

1.2. Supported Virtual Machine Operating Systems

1.3. Virtual Machine Performance Parameters

1.4. Installing Supporting Components on Client Machines

1.4.1. Installing Console Components

A console is a graphical window that allows you to view the start up screen, shut down screen, and desktop of a virtual machine, and to interact with that virtual machine in a similar way to a physical machine. In oVirt, the default application for opening a console to a virtual machine is Remote Viewer, which must be installed on the client machine prior to use.

Installing Remote Viewer on Enterprise Linux

The Remote Viewer application provides users with a graphical console for connecting to virtual machines. Once installed, it is called automatically when attempting to open a SPICE session with a virtual machine. Alternatively, it can also be used as a standalone application. Remote Viewer is included in the virt-viewer package provided by the base Enterprise Linux Workstation and Enterprise Linux Server repositories.

Procedure

-

Install the

virt-viewerpackage:# dnf install virt-viewer -

Restart your browser for the changes to take effect.

You can now connect to your virtual machines using either the SPICE protocol or the VNC protocol.

Installing Remote Viewer on Windows

The Remote Viewer application provides users with a graphical console for connecting to virtual machines. Once installed, it is called automatically when attempting to open a SPICE session with a virtual machine. Alternatively, it can also be used as a standalone application.

Installing Remote Viewer on Windows

-

Open a web browser and download one of the following installers according to the architecture of your system.

-

Virt Viewer download page

-

-

Open the folder where the file was saved.

-

Double-click the file.

-

Click Run if prompted by a security warning.

-

Click Yes if prompted by User Account Control.

Remote Viewer is installed and can be accessed via Remote Viewer in the VirtViewer folder of All Programs in the start menu.

Installing usbdk on Windows

usbdk is a driver that enables remote-viewer exclusive access to USB devices on Windows operating systems. Installing usbdk requires Administrator privileges. Note that the previously supported USB Clerk option has been deprecated and is no longer supported.

Installing usbdk on Windows

-

Open a web browser and download one of the following installers according to the architecture of your system.

-

usbdkdownload page

-

-

Open the folder where the file was saved.

-

Double-click the file.

-

Click Run if prompted by a security warning.

-

Click Yes if prompted by User Account Control.

2. Installing Enterprise Linux Virtual Machines

Installing a Enterprise Linux virtual machine involves the following key steps:

-

Create a virtual machine. You must add a virtual disk for storage, and a network interface to connect the virtual machine to the network.

-

Start the virtual machine and install an operating system. See your operating system’s documentation for instructions.

-

Enterprise Linux 6: Installing Red Hat Enterprise Linux 6.9 for all architectures

-

Enterprise Linux 7: Installing Red Hat Enterprise Linux 7 on all architectures

-

Enterprise Linux Atomic Host 7: Red Hat Enterprise Linux Atomic Host 7 Installation and Configuration Guide

-

Enterprise Linux 8: Installing Red Hat Enterprise Linux 8 using the graphical user interface

-

-

Enable the required repositories for your operating system.

-

Install guest agents and drivers for additional virtual machine functionality.

2.1. Creating a virtual machine

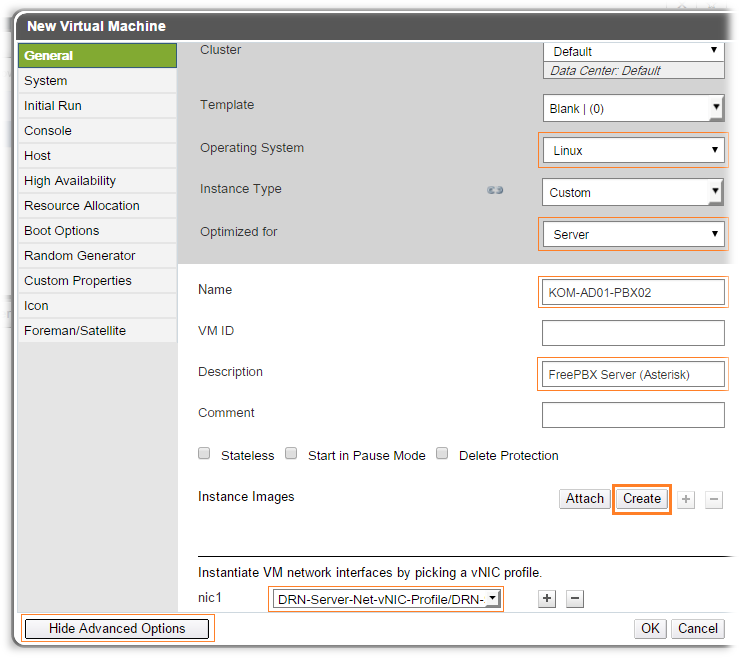

When creating a new virtual machine, you specify its settings. You can edit some of these settings later, including the chipset and BIOS type. For more information, see UEFI and the Q35 chipset in the Administration Guide.

.Prerequisites

|

Before you can use this virtual machine, you must:

|

Procedure

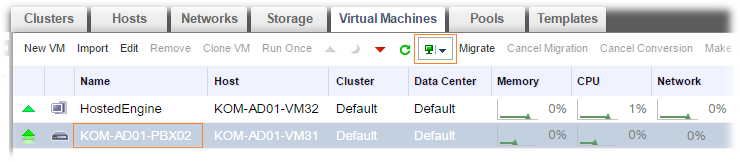

-

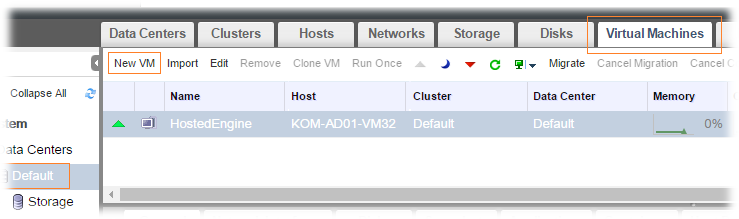

Click .

-

Click New. This opens the New Virtual Machine window.

-

Select an Operating System from the drop-down list.

If you selected Enterprise Linux CoreOS as the operating system, you may need to set the initialization method by configuring Ignition settings in the Advanced Options

Initial Runtab. See Configuring Ignition. -

Enter a Name for the virtual machine.

-

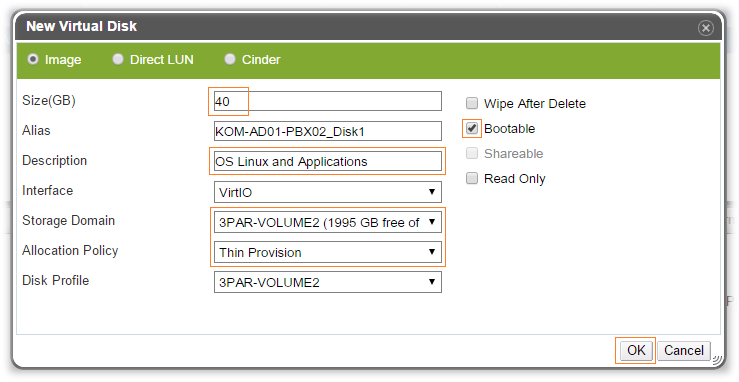

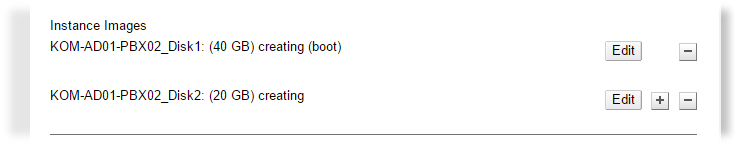

Add storage to the virtual machine: under Instance Images, click Attach or Create to select or create a virtual disk .

-

Click Attach and select an existing virtual disk.

or

-

Click Create and enter a Size(GB) and Alias for a new virtual disk. You can accept the default settings for all other fields, or change them if required. See Explanation of settings in the New Virtual Disk and Edit Virtual Disk windows for more details on the fields for all disk types.

-

-

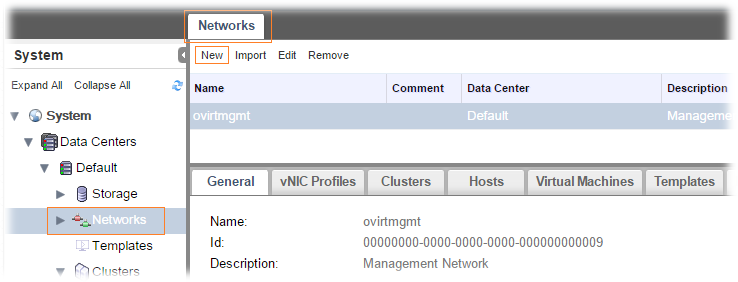

Connect the virtual machine to the network. Add a network interface by selecting a vNIC profile from the nic1 drop-down list at the bottom of the General tab.

-

Specify the virtual machine’s Memory Size on the System tab.

-

In the Boot Options tab, choose the First Device that the virtual machine will use to boot.

-

You can accept the default settings for all other fields, or change them if required. For more details on all fields in the New Virtual Machine window, see Explanation of settings in the New Virtual Machine and Edit Virtual Machine Windows.

-

Click OK.

The new virtual machine is created and displays in the list of virtual machines with a status of Down.

Configuring Ignition

Ignition is the utility that is used by Enterprise Linux CoreOS to manipulate disks during initial configuration. It completes common disk tasks, including partitioning disks, formatting partitions, writing files, and configuring users. On first boot, Ignition reads its configuration from the installation media or the location that you specify and applies the configuration to the machines.

|

Once Ignition has been configured as the initialization method, it cannot be reversed or re-configured. |

-

In the

Add Virtual MachineorEdit Virtual Machinescreen, click Show Advanced Options. -

In the

Initial Runtab, select the Ignition 2.3.0 option and enter the VM Hostname. -

Expand the Authorization option, enter a hashed (SHA-512) password, and enter the password again to verify.

-

If you are using SSH keys for authorization, enter them in the space provided.

-

You can also enter a custom Ignition script in JSON format in the Ignition Script field. This script will run on the virtual machine when it starts. The scripts you enter in this field are custom JSON sections that are added to those produced by the Engine, and allow you to use custom Ignition instructions.

If the Enterprise Linux CoreOS image you are using contains an Ignition version different than 2.3.0, you need to use a script in the Ignition Script field to enforce the Ignition version included in your Enterprise Linux CoreOS image.

When you use an Ignition script, the script instructions take precedence over and override any conflicting Ignition settings you configured in the UI.

2.2. Starting the Virtual Machine

2.2.1. Starting a Virtual Machine

Procedure

-

Click and select a virtual machine with a status of

Down. -

Click Run.

The Status of the virtual machine changes to Up, and the operating system installation begins. Open a console to the virtual machine if one does not open automatically.

|

A virtual machine will not start on a host with an overloaded CPU. By default, a host’s CPU is considered overloaded if it has a load of more than 80% for 5 minutes, but these values can be changed using scheduling policies. See Scheduling Policies in the Administration Guide for more information. |

Troubleshooting

Scenario — the virtual machine fails to boot with the following error message:

Boot failed: not a bootable disk - No Bootable devicePossible solutions to this problem:

-

Make sure that hard disk is selected in the boot sequence, and the disk that the virtual machine is booting from must be set as Bootable.

-

Create a Cloned Virtual Machine Based on a Template.

-

Create a new virtual machine with a local boot disk managed by oVirt that contains the OS and application binaries.

-

Install the OS by booting from the Network (PXE) boot option.

Scenario — the virtual machine on IBM POWER9 fails to boot with the following error message:

qemu-kvm: Requested count cache flush assist capability level not supported by kvm, try appending -machine cap-ccf-assist=offDefault risk level protections can prevent VMs from starting on IBM POWER9. To resolve this issue:

-

Create or edit the

/var/lib/obmc/cfam_overrideson the BMC. -

Set the firmware risk level to

0:# Control speculative execution mode 0 0x283a 0x00000000 # bits 28:31 are used for init level -- in this case 0 Kernel and User protection (safest, default) 0 0x283F 0x20000000 # Indicate override register is valid

-

Reboot the host system for the changes to take affect.

|

Overriding the risk level can cause unexpected behavior when running virtual machines. |

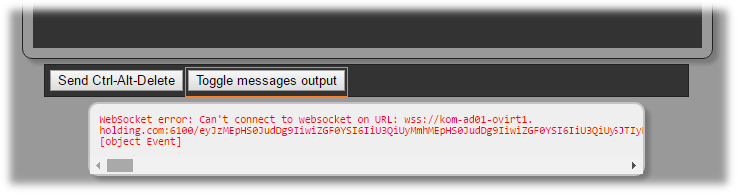

2.2.2. Opening a console to a virtual machine

Use Remote Viewer to connect to a virtual machine.

|

To allow other users to connect to the VM, make sure you shutdown and restart the virtual machine when you are finished using the console. Alternatively, the administrator can Disable strict user checking to eliminate the need for reboot between users. See Virtual Machine Console Settings Explained for more information. |

Procedure

-

Install Remote Viewer if it is not already installed. See Installing Console Components.

-

Click and select a virtual machine.

-

Click Console. By default, the browser prompts you to download a file named

console.vv. When you click to open the file, a console window opens for the virtual machine. You can configure your browser to automatically open these files, such that clicking Console simply opens the console.

|

|

2.2.3. Opening a Serial Console to a Virtual Machine

You can access a virtual machine’s serial console from the command line instead of opening a console from the Administration Portal or the VM Portal. The serial console is emulated through VirtIO channels, using SSH and key pairs. The Engine acts as a proxy for the connection, provides information about virtual machine placement, and stores the authentication keys. You can add public keys for each user from either the Administration Portal or the VM Portal. You can access serial consoles for only those virtual machines for which you have appropriate permissions.

|

To access the serial console of a virtual machine, the user must have UserVmManager, SuperUser, or UserInstanceManager permission on that virtual machine. These permissions must be explicitly defined for each user. It is not enough to assign these permissions to Everyone. |

The serial console is accessed through TCP port 2222 on the Engine. This port is opened during engine-setup on new installations. To change the port, see ovirt-vmconsole/README.md.

You must configure the following firewall rules to allow a serial console:

-

Rule «M3» for the Engine firewall

-

Rule «H2» for the host firewall

The serial console relies on the ovirt-vmconsole package and the ovirt-vmconsole-proxy on the Engine and the ovirt-vmconsole package and the ovirt-vmconsole-host package on the hosts.

These packages are installed by default on new installations. To install the packages on existing installations, reinstall the hosts.

Enabling a Virtual Machine’s Serial Console

-

On the virtual machine whose serial console you are accessing, add the following lines to /etc/default/grub:

GRUB_CMDLINE_LINUX_DEFAULT="console=tty0 console=ttyS0,115200n8" GRUB_TERMINAL="console serial" GRUB_SERIAL_COMMAND="serial --speed=115200 --unit=0 --word=8 --parity=no --stop=1"GRUB_CMDLINE_LINUX_DEFAULTapplies this configuration only to the default menu entry. UseGRUB_CMDLINE_LINUXto apply the configuration to all the menu entries.If these lines already exist in /etc/default/grub, update them. Do not duplicate them.

-

Rebuild /boot/grub2/grub.cfg:

-

BIOS-based machines:

# grub2-mkconfig -o /boot/grub2/grub.cfg -

UEFI-based machines:

# grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfg

-

-

On the client machine from which you are accessing the virtual machine serial console, generate an SSH key pair. The Engine supports standard SSH key types, for example, an RSA key:

# ssh-keygen -t rsa -b 2048 -f .ssh/serialconsolekeyThis command generates a public key and a private key.

-

In the Administration Portal, click or click the user icon on the header bar and click Account Settings to open the Account Settings screen.

OR

In the VM Portal, click the Settings icon on the header bar to open the Account Settings screen.

-

In the User’s Public Key text field (Administration Portal) or SSH Key field (VM Portal), paste the public key of the client machine that will be used to access the serial console.

-

Click and select a virtual machine.

-

Click Edit.

-

In the Console tab of the Edit Virtual Machine window, select the Enable VirtIO serial console check box.

Connecting to a Virtual Machine’s Serial Console

On the client machine, connect to the virtual machine’s serial console:

-

If a single virtual machine is available, this command connects the user to that virtual machine:

# ssh -t -p 2222 ovirt-vmconsole@Manager_FQDN -i .ssh/serialconsolekey Enterprise Linux Server release 6.7 (Santiago) Kernel 2.6.32-573.3.1.el6.x86_64 on an x86_64 USER login: -

If more than one virtual machine is available, this command lists the available virtual machines and their IDs:

# ssh -t -p 2222 ovirt-vmconsole@Manager_FQDN -i .ssh/serialconsolekey list 1. vm1 [vmid1] 2. vm2 [vmid2] 3. vm3 [vmid3] > 2 Enterprise Linux Server release 6.7 (Santiago) Kernel 2.6.32-573.3.1.el6.x86_64 on an x86_64 USER login:Enter the number of the machine to which you want to connect, and press

Enter. -

Alternatively, connect directly to a virtual machine using its unique identifier or its name:

# ssh -t -p 2222 ovirt-vmconsole@Manager_FQDN connect --vm-id vmid1# ssh -t -p 2222 ovirt-vmconsole@Manager_FQDN connect --vm-name vm1

Disconnecting from a Virtual Machine’s Serial Console

Press any key followed by ~ . to close a serial console session.

If the serial console session is disconnected abnormally, a TCP timeout occurs. You will be unable to reconnect to the virtual machine’s serial console until the timeout period expires.

2.2.4. Automatically Connecting to a Virtual Machine

Once you have logged in, you can automatically connect to a single running virtual machine. This can be configured in the VM Portal.

Procedure

-

In the Virtual Machines page, click the name of the virtual machine to go to the details view.

-

Click the pencil icon beside Console and set Connect automatically to ON.

The next time you log into the VM Portal, if you have only one running virtual machine, you will automatically connect to that machine.

2.3. Enabling the Required Repositories

To install packages signed by Red Hat you must register the target system to the Content Delivery Network. Then, use an entitlement from your subscription pool and enable the required repositories.

Enabling the Required Repositories Using Subscription Engine

-

Register your system with the Content Delivery Network, entering your Customer Portal user name and password when prompted:

# subscription-manager register -

Locate the relevant subscription pools and note down the pool identifiers:

# subscription-manager list --available -

Use the pool identifiers to attach the required subscriptions:

# subscription-manager attach --pool=pool_id -

When a system is attached to a subscription pool with multiple repositories, only the main repository is enabled by default. Others are available, but disabled. Enable any additional repositories:

# subscription-manager repos --enable=repository -

Ensure that all packages currently installed are up to date:

2.4. Installing Guest Agents and Drivers

2.4.1. oVirt Guest agents, tools, and drivers

The oVirt guest agents, tools, and drivers provide additional functionality for virtual machines, such as gracefully shutting down or rebooting virtual machines from the VM Portal and Administration Portal. The tools and agents also provide information for virtual machines, including:

-

Resource usage

-

IP addresses

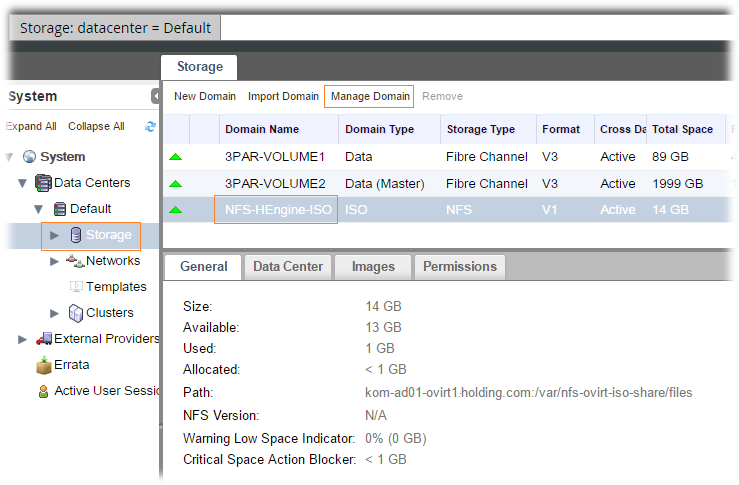

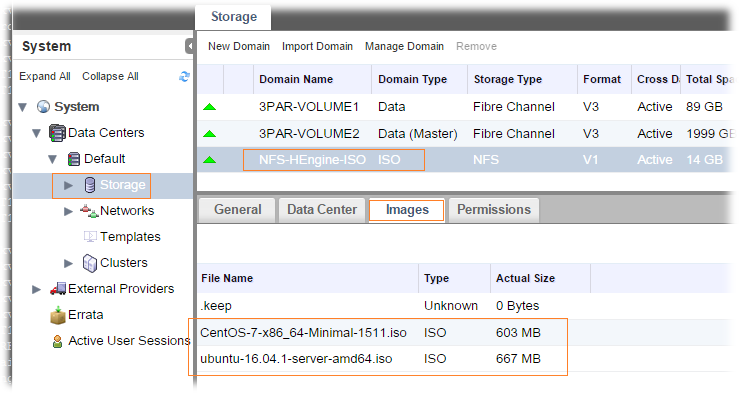

The guest agents, tools and drivers are distributed as an ISO file that you can attach to virtual machines. This ISO file is packaged as an RPM file that you can install and upgrade from the Engine machine.

You need to install the guest agents and drivers on a virtual machine to enable this functionality for that machine.

Table 1. oVirt Guest drivers

| Driver | Description | Works on |

|---|---|---|

|

|

Paravirtualized network driver provides enhanced performance over emulated devices like rtl. |

Server and Desktop. |

|

|

Paravirtualized HDD driver offers increased I/O performance over emulated devices like IDE by optimizing the coordination and communication between the virtual machine and the hypervisor. The driver complements the software implementation of the virtio-device used by the host to play the role of a hardware device. |

Server and Desktop. |

|

|

Paravirtualized iSCSI HDD driver offers similar functionality to the virtio-block device, with some additional enhancements. In particular, this driver supports adding hundreds of devices, and names devices using the standard SCSI device naming scheme. |

Server and Desktop. |

|

|

Virtio-serial provides support for multiple serial ports. The improved performance is used for fast communication between the virtual machine and the host that avoids network complications. This fast communication is required for the guest agents and for other features such as clipboard copy-paste between the virtual machine and the host and logging. |

Server and Desktop. |

|

|

Virtio-balloon is used to control the amount of memory a virtual machine actually accesses. It offers improved memory overcommitment. |

Server and Desktop. |

|

|

A paravirtualized display driver reduces CPU usage on the host and provides better performance through reduced network bandwidth on most workloads. |

Server and Desktop. |

Table 2. oVirt Guest agents and tools

| Guest agent/tool | Description | Works on |

|---|---|---|

|

|

Used instead of |

Server and Desktop. |

|

|

The SPICE agent supports multiple monitors and is responsible for client-mouse-mode support to provide a better user experience and improved responsiveness than the QEMU emulation. Cursor capture is not needed in client-mouse-mode. The SPICE agent reduces bandwidth usage when used over a wide area network by reducing the display level, including color depth, disabling wallpaper, font smoothing, and animation. The SPICE agent enables clipboard support allowing cut and paste operations for both text and images between client and virtual machine, and automatic guest display setting according to client-side settings. On Windows-based virtual machines, the SPICE agent consists of vdservice and vdagent. |

Server and Desktop. |

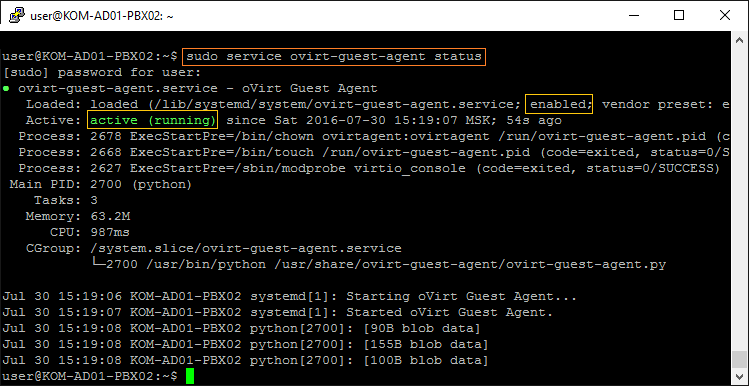

2.4.2. Installing the Guest Agents and Drivers on Enterprise Linux

The oVirt guest agents and drivers are provided by the oVirt Agent repository.

|

Enterprise Linux 8 virtual machines use the |

Procedure

-

Log in to the Enterprise Linux virtual machine.

-

Enable the oVirt Agent repository:

-

For Enterprise Linux 6

-

For CentOS Linux 7

# yum install -y centos-release-ovirt43 -

For Red Hat Enterprise Linux 7

# subscription-manager repos --enable=rhel-7-server-rh-common-rpms -

For Enterprise Linux 8 and 9 the AppStream repository is enabled by default

-

-

Install the guest agent and dependencies:

-

For Enterprise Linux 6 or 7, install the ovirt guest agent:

# yum install ovirt-guest-agent-common -

For Enterprise Linux 8 and 9, install the qemu guest agent:

# yum install qemu-guest-agent

-

-

Start and enable the

ovirt-guest-agentservice:-

For Enterprise Linux 6

# service ovirt-guest-agent start # chkconfig ovirt-guest-agent on -

For Enterprise Linux 7

# systemctl start ovirt-guest-agent # systemctl enable ovirt-guest-agent

-

-

Start and enable the

qemu-guest-agentservice:-

For Enterprise Linux 6

# service qemu-ga start # chkconfig qemu-ga on -

For Enterprise Linux 7, 8 or 9

# systemctl start qemu-guest-agent # systemctl enable qemu-guest-agent

-

The guest agent now passes usage information to the oVirt Engine. You can configure the oVirt guest agent in the /etc/ovirt-guest-agent.conf file.

3. Installing Windows virtual machines

Installing a Windows virtual machine involves the following key steps:

-

Create a blank virtual machine on which to install an operating system.

-

Add a virtual disk for storage.

-

Add a network interface to connect the virtual machine to the network.

-

Attach the Windows guest tools CD to the virtual machine so that VirtIO-optimized device drivers can be installed during the operating system installation.

-

Install a Windows operating system on the virtual machine. See your operating system’s documentation for instructions.

-

During the installation, install guest agents and drivers for additional virtual machine functionality.

When all of these steps are complete, the new virtual machine is functional and ready to perform tasks.

3.1. Creating a virtual machine

When creating a new virtual machine, you specify its settings. You can edit some of these settings later, including the chipset and BIOS type. For more information, see UEFI and the Q35 chipset in the Administration Guide.

.Prerequisites

|

Before you can use this virtual machine, you must:

|

Procedure

-

You can change the default virtual machine name length with the

engine-configtool. Run the following command on the Engine machine:# engine-config --set MaxVmNameLength=integer -

Click .

-

Click New. This opens the New Virtual Machine window.

-

Select an Operating System from the drop-down list.

-

Enter a Name for the virtual machine.

-

Add storage to the virtual machine: under Instance Images, click Attach or Create to select or create a virtual disk .

-

Click Attach and select an existing virtual disk.

or

-

Click Create and enter a Size(GB) and Alias for a new virtual disk. You can accept the default settings for all other fields, or change them if required. See Explanation of settings in the New Virtual Disk and Edit Virtual Disk windows for more details on the fields for all disk types.

-

-

Connect the virtual machine to the network. Add a network interface by selecting a vNIC profile from the nic1 drop-down list at the bottom of the General tab.

-

Specify the virtual machine’s Memory Size on the System tab.

-

In the Boot Options tab, choose the First Device that the virtual machine will use to boot.

-

You can accept the default settings for all other fields, or change them if required. For more details on all fields in the New Virtual Machine window, see Explanation of settings in the New Virtual Machine and Edit Virtual Machine Windows.

-

Click OK.

The new virtual machine is created and displays in the list of virtual machines with a status of Down.

3.2. Starting the virtual machine using Run Once

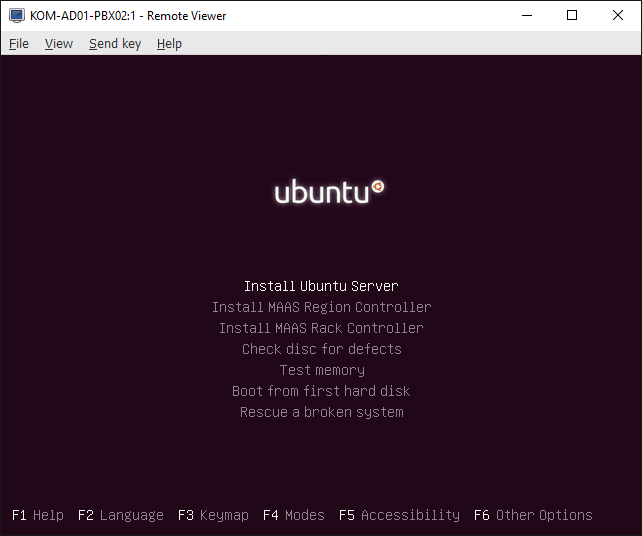

3.2.1. Installing Windows on VirtIO-optimized hardware

Install VirtIO-optimized disk and network device drivers during your Windows installation by attaching the virtio-win_version.iso file to your virtual machine. These drivers provide a performance improvement over emulated device drivers.

Use the Run Once option to attach the virtio-win_version.iso file in a one-off boot different from the Boot Options defined in the New Virtual Machine window.

Prerequisites

The following items were added to the virtual machine:

-

A Red Hat VirtIO network interface

-

A disk that uses the VirtIO interface

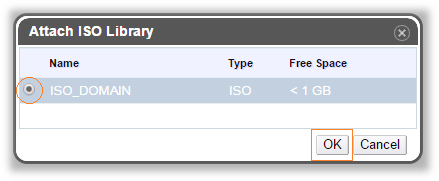

You can upload virtio-win_version.iso to a data storage domain.

|

oVirt recommends uploading ISO images to the data domain with the Administration Portal or with the REST API. For more information, see Uploading Images to a Data Storage Domain in the Administration Guide. If necessary, you can upload the |

Procedure

To install the virtio-win drivers when installing Windows, complete the following steps:

-

Click and select a virtual machine.

-

Click .

-

Expand the Boot Options menu.

-

Select the Attach CD check box, and select a Windows ISO from the drop-down list.

-

Select the Attach Windows guest tools CD check box.

-

Move CD-ROM to the top of the Boot Sequence field.

-

Configure other Run Once options as required. See Virtual Machine Run Once settings explained for more details.

-

Click OK. The status of the virtual machine changes to Up, and the operating system installation begins.

Open a console to the virtual machine if one does not open automatically during the Windows installation.

-

When prompted to select a drive onto which you want to install Windows, click Load driver and OK.

-

Under Select the driver to install, select the appropriate driver for the version of Windows. For example, for Windows Server 2019, select Red Hat VirtIO SCSI controller (E:\amd64\2k19\viostor.inf)

-

Click Next.

The rest of the installation proceeds as normal.

3.2.2. Opening a console to a virtual machine

Use Remote Viewer to connect to a virtual machine.

|

To allow other users to connect to the VM, make sure you shutdown and restart the virtual machine when you are finished using the console. Alternatively, the administrator can Disable strict user checking to eliminate the need for reboot between users. See Virtual Machine Console Settings Explained for more information. |

Procedure

-

Install Remote Viewer if it is not already installed. See Installing Console Components.

-

Click and select a virtual machine.

-

Click Console. By default, the browser prompts you to download a file named

console.vv. When you click to open the file, a console window opens for the virtual machine. You can configure your browser to automatically open these files, such that clicking Console simply opens the console.

|

|

3.3. Installing guest agents and drivers

3.3.1. oVirt Guest agents, tools, and drivers

The oVirt guest agents, tools, and drivers provide additional functionality for virtual machines, such as gracefully shutting down or rebooting virtual machines from the VM Portal and Administration Portal. The tools and agents also provide information for virtual machines, including:

-

Resource usage

-

IP addresses

The guest agents, tools and drivers are distributed as an ISO file that you can attach to virtual machines. This ISO file is packaged as an RPM file that you can install and upgrade from the Engine machine.

You need to install the guest agents and drivers on a virtual machine to enable this functionality for that machine.

Table 3. oVirt Guest drivers

| Driver | Description | Works on |

|---|---|---|

|

|

Paravirtualized network driver provides enhanced performance over emulated devices like rtl. |

Server and Desktop. |

|

|

Paravirtualized HDD driver offers increased I/O performance over emulated devices like IDE by optimizing the coordination and communication between the virtual machine and the hypervisor. The driver complements the software implementation of the virtio-device used by the host to play the role of a hardware device. |

Server and Desktop. |

|

|

Paravirtualized iSCSI HDD driver offers similar functionality to the virtio-block device, with some additional enhancements. In particular, this driver supports adding hundreds of devices, and names devices using the standard SCSI device naming scheme. |

Server and Desktop. |

|

|

Virtio-serial provides support for multiple serial ports. The improved performance is used for fast communication between the virtual machine and the host that avoids network complications. This fast communication is required for the guest agents and for other features such as clipboard copy-paste between the virtual machine and the host and logging. |

Server and Desktop. |

|

|

Virtio-balloon is used to control the amount of memory a virtual machine actually accesses. It offers improved memory overcommitment. |

Server and Desktop. |

|

|

A paravirtualized display driver reduces CPU usage on the host and provides better performance through reduced network bandwidth on most workloads. |

Server and Desktop. |

Table 4. oVirt Guest agents and tools

| Guest agent/tool | Description | Works on |

|---|---|---|

|

|

Used instead of |

Server and Desktop. |

|

|

The SPICE agent supports multiple monitors and is responsible for client-mouse-mode support to provide a better user experience and improved responsiveness than the QEMU emulation. Cursor capture is not needed in client-mouse-mode. The SPICE agent reduces bandwidth usage when used over a wide area network by reducing the display level, including color depth, disabling wallpaper, font smoothing, and animation. The SPICE agent enables clipboard support allowing cut and paste operations for both text and images between client and virtual machine, and automatic guest display setting according to client-side settings. On Windows-based virtual machines, the SPICE agent consists of vdservice and vdagent. |

Server and Desktop. |

3.3.2. Installing the guest agents, tools, and drivers on Windows

Procedure

To install the guest agents, tools, and drivers on a Windows virtual machine, complete the following steps:

-

On the Engine machine, install the

virtio-winpackage:# dnf install virtio-win*After you install the package, the ISO file is located in

/usr/share/virtio-win/virtio-win_version.isoon the Engine machine. -

Upload

virtio-win_version.isoto a data storage domain. See Uploading Images to a Data Storage Domain in the Administration Guide for details. -

In the Administration or VM Portal, if the virtual machine is running, use the Change CD button to attach the

virtio-win_version.isofile to each of your virtual machines. If the virtual machine is powered off, click the Run Once button and attach the ISO as a CD. -

Log in to the virtual machine.

-

Select the CD Drive containing the

virtio-win_version.isofile. You can complete the installation with either the GUI or the command line. -

Run the installer.

- To install with the GUI, complete the following steps

-

-

Double-click

virtio-win-guest-tools.exe. -

Click Next at the welcome screen.

-

Follow the prompts in the installation wizard.

-

When installation is complete, select Yes, I want to restart my computer now and click Finish to apply the changes.

-

- To install silently with the command line, complete the following steps

-

-

Open a command prompt with Administrator privileges.

-

Enter the

msiexeccommand:D:\ msiexec /i "_PATH_TO_MSI_" /qn [/l*v "_PATH_TO_LOG_"][/norestart] ADDLOCAL=ALLOther possible values for ADDLOCAL are listed below.

For example, to run the installation when

virtio-win-gt-x64.msiis on theD:\drive, without saving the log, and then immediately restart the virtual machine, enter the following command:D:\ msiexec /i "virtio-win-gt-x64.msi" /qn ADDLOCAL=ALL

-

After installation completes, the guest agents and drivers pass usage information to the oVirt Engine and enable you to access USB devices and other functionality.

3.3.3. Values for ADDLOCAL to customize virtio-win command-line installation

When installing virtio-win-gt-x64.msi or virtio-win-gt-x32.msi with the command line, you can install any one driver, or any combination of drivers.

You can also install specific agents, but you must also install each agent’s corresponding drivers.

The ADDLOCAL parameter of the msiexec command enables you to specify which drivers or agents to install. ADDLOCAL=ALL installs all drivers and agents. Other values are listed in the following tables.

Table 5. Possible values for ADDLOCAL to install drivers

| Value for ADDLOCAL | Driver Name | Description |

|---|---|---|

|

|

|

Paravirtualized network driver provides enhanced performance over emulated devices like rtl. |

|

|

|

Controls the amount of memory a virtual machine actually accesses. It offers improved memory overcommitment. |

|

|

|

QEMU pvpanic device driver. |

|

|

|

QEMU FWCfg device driver. |

|

|

|

QEMU PCI serial device driver. |

|

|

|

A paravirtualized display driver reduces CPU usage on the host and provides better performance through reduced network bandwidth on most workloads. |

|

|

|

VirtIO Input Driver. |

|

|

|

VirtIO RNG device driver. |

|

|

|

VirtIO SCSI pass-through controller. |

|

|

|

VirtIO Serial device driver. |

|

|

|

VirtIO Block driver. |

Table 6. Possible values for ADDLOCAL to install agents and required corresponding drivers

| Agent | Description | Corresponding driver(s) | Value for ADDLOCAL |

|---|---|---|---|

|

Spice Agent |

Supports multiple monitors, responsible for client-mouse-mode support, reduces bandwidth usage, enables clipboard support between client and virtual machine, provide a better user experience and improved responsiveness. |

|

|

Examples

The following command installs only the VirtIO SCSI pass-through controller, the VirtIO Serial device driver, and the VirtIO Block driver:

D:\ msiexec /i "virtio-win-gt-x64.msi" /qn ADDLOCAL=`FE_vioscsi_driver,FE_vioserial_driver,FE_viostor_driverThe following command installs only the Spice Agent and its required corresponding drivers:

D:\ msiexec /i "virtio-win-gt-x64.msi" /qn ADDLOCAL = FE_spice_Agent,FE_vioserial_driver,FE_spice_driverThe Microsoft Developer website:

-

Windows Installer

-

Command-Line Options for the Windows installer

-

Property Reference for the Windows installer

4. Additional Configuration

4.1. Configuring Operating Systems with osinfo

oVirt stores operating system configurations for virtual machines in /etc/ovirt-engine/osinfo.conf.d/00-defaults.properties. This file contains default values such as os.other.devices.display.protocols.value = spice/qxl,vnc/vga,vnc/qxl.

There are only a limited number of scenarios in which you would change these values:

-

Adding an operating system that does not appear in the list of supported guest operating systems

-

Adding a product key (for example,

os.windows_10x64.productKey.value =) -

Configuring the

syspreppath for a Windows virtual machine (for example,os.windows_10x64.sysprepPath.value = ${ENGINE_USR}/conf/sysprep/sysprep.w10x64)

|

Do not edit the actual 00-defaults.properties file. Changes will be overwritten if you upgrade or restore the Engine. Do not change values that come directly from the operating system or the Engine, such as maximum memory size. |

To change the operating system configurations, create an override file in /etc/ovirt-engine/osinfo.conf.d/. The file name must begin with a value greater than 00, so that the file appears after /etc/ovirt-engine/osinfo.conf.d/00-defaults.properties, and ends with the extension, .properties.

For example, 10-productkeys.properties overrides the default file, 00-defaults.properties. The last file in the file list has precedence over earlier files.

For virtual machines with Windows Server 2016,

on each oVirt host, modify the /etc/modprobe.d/kvm.conf configuration file by adding the line: options kvm ignore_msrs=1

4.2. Configuring Single Sign-On for Virtual Machines

Configuring single sign-on, also known as password delegation, allows you to automatically log in to a virtual machine using the credentials you use to log in to the VM Portal. Single sign-on can be used on both Enterprise Linux and Windows virtual machines.

|

Single sign-on is not supported for virtual machines running Enterprise Linux 8.0. |

|

If single sign-on to the VM Portal is enabled, single sign-on to virtual machines will not be possible. With single sign-on to the VM Portal enabled, the VM Portal does not need to accept a password, thus the password cannot be delegated to sign in to virtual machines. |

4.2.1. Configuring Single Sign-On for Enterprise Linux Virtual Machines Using IPA (IdM)

To configure single sign-on for Enterprise Linux virtual machines using GNOME and KDE graphical desktop environments and IPA (IdM) servers, you must install the ovirt-guest-agent package on the virtual machine and install the packages associated with your window manager.

|

The following procedure assumes that you have a working IPA configuration and that the IPA domain is already joined to the Engine. You must also ensure that the clocks on the Engine, the virtual machine and the system on which IPA (IdM) is hosted are synchronized using NTP. |

|

Single sign-on with IPA (IdM) is deprecated for virtual machines running Enterprise Linux version 7 or earlier and unsupported for virtual machines running Enterprise Linux 8 or Windows operating systems. |

Configuring Single Sign-On for Enterprise Linux Virtual Machines

-

Log in to the Enterprise Linux virtual machine.

-

Enable the repository:

-

For Enterprise Linux 6:

# subscription-manager repos --enable=rhel-6-server-rhv-4-agent-rpms -

For Enterprise Linux 7:

# subscription-manager repos --enable=rhel-7-server-rh-common-rpms

-

-

Download and install the guest agent, single sign-on, and IPA packages:

# yum install ovirt-guest-agent-common ovirt-guest-agent-pam-module ovirt-guest-agent-gdm-plugin ipa-client -

Run the following command and follow the prompts to configure

ipa-clientand join the virtual machine to the domain:# ipa-client-install --permit --mkhomedirIn environments that use DNS obfuscation, this command should be:

# ipa-client-install --domain=FQDN --server=FQDN -

For Enterprise Linux 7.2 and later:

# authconfig --enablenis --updateEnterprise Linux 7.2 has a new version of the System Security Services Daemon (SSSD), which introduces configuration that is incompatible with the oVirt Engine guest agent single sign-on implementation. This command ensures that single sign-on works.

-

Fetch the details of an IPA user:

-

Record the IPA user’s UID and GID:

ipa-user:*:936600010:936600001::/home/ipa-user:/bin/sh -

Create a home directory for the IPA user:

-

Assign ownership of the directory to the IPA user:

# chown 936600010:936600001 /home/ipa-user

Log in to the VM Portal using the user name and password of a user configured to use single sign-on and connect to the console of the virtual machine. You will be logged in automatically.

4.2.2. Configuring single sign-on for Windows virtual machines

To configure single sign-on for Windows virtual machines, the Windows guest agent must be installed on the guest virtual machine. The virtio-win ISO image provides this agent. If the virtio-win_version.iso image is not available in your storage domain, contact your system administrator.

Procedure

-

Select the Windows virtual machine. Ensure the machine is powered up.

-

On the virtual machine, locate the CD drive and open the CD.

-

Launch

virtio-win-guest-tools. -

Click Options

-

Select Install oVirt Guest Agent.

-

Click OK.

-

Click Install.

-

When the installation completes, you are prompted to restart the machine to apply the changes.

Log in to the VM Portal using the user name and password of a user configured to use single sign-on and connect to the console of the virtual machine. You will be logged in automatically.

4.2.3. Disabling Single Sign-on for Virtual Machines

The following procedure explains how to disable single sign-on for a virtual machine.

Disabling Single Sign-On for Virtual Machines

-

Select a virtual machine and click Edit.

-

Click the Console tab.

-

Select the Disable Single Sign On check box.

-

Click OK.

4.3. Configuring USB Devices

A virtual machine connected with the SPICE protocol can be configured to connect directly to USB devices.

The USB device will only be redirected if the virtual machine is active, in focus and is run from the VM Portal. USB redirection can be manually enabled each time a device is plugged in or set to automatically redirect to active virtual machines in the Console Options window.

|

Note the distinction between the client machine and guest machine. The client is the hardware from which you access a guest. The guest is the virtual desktop or virtual server which is accessed through the VM Portal or Administration Portal. |

USB redirection Enabled mode allows KVM/SPICE USB redirection for Linux and Windows virtual machines. Virtual (guest) machines require no guest-installed agents or drivers for native USB. On Enterprise Linux clients, all packages required for USB redirection are provided by the virt-viewer package. On Windows clients, you must also install the usbdk package. Enabled USB mode is supported on the following clients and guests:

|

If you have a 64-bit architecture PC, you must use the 64-bit version of Internet Explorer to install the 64-bit version of the USB driver. The USB redirection will not work if you install the 32-bit version on a 64-bit architecture. As long as you initially install the correct USB type, you can access USB redirection from both 32- and 64-bit browsers. |

4.3.1. Using USB Devices on a Windows Client

The usbdk driver must be installed on the Windows client for the USB device to be redirected to the guest. Ensure the version of usbdk matches the architecture of the client machine. For example, the 64-bit version of usbdk must be installed on 64-bit Windows machines.

|

USB redirection is only supported when you open the virtual machine from the VM Portal. |

Procedure

-

When the

usbdkdriver is installed, click and select a virtual machine that is configured to use the SPICE protocol. -

Click the Console tab.

-

Select the USB enabled checkbox and click OK.

-

Click .

-

Select the Enable USB Auto-Share check box and click OK.

-

Start the virtual machine from the VM Portal and click Console to connect to that virtual machine.

-

Plug your USB device into the client machine to make it appear automatically on the guest machine.

4.3.2. Using USB Devices on a Enterprise Linux Client

The usbredir package enables USB redirection from Enterprise Linux clients to virtual machines. usbredir is a dependency of the virt-viewer package, and is automatically installed together with that package.

|

USB redirection is only supported when you open the virtual machine from the VM Portal. |

Procedure

-

Click .

-

Select a virtual machine that has been configured to use the SPICE protocol and click Edit. This opens the Edit Virtual Machine window.

-

Click the Console tab.

-

Select the USB enabled checkbox and click OK.

-

Click .

-

Select the Enable USB Auto-Share check box and click OK.

-

Start the virtual machine from the VM Portal and click Console to connect to that virtual machine.

-

Plug your USB device into the client machine to make it appear automatically on the guest machine.

4.4. Configuring Multiple Monitors

4.4.1. Configuring Multiple Displays for Enterprise Linux Virtual Machines

A maximum of four displays can be configured for a single Enterprise Linux virtual machine when connecting to the virtual machine using the SPICE protocol.

-

Start a SPICE session with the virtual machine.

-

Open the View drop-down menu at the top of the SPICE client window.

-

Open the Display menu.

-

Click the name of a display to enable or disable that display.

|

By default, Display 1 is the only display that is enabled on starting a SPICE session with a virtual machine. If no other displays are enabled, disabling this display will close the session. |

4.4.2. Configuring Multiple Displays for Windows Virtual Machines

A maximum of four displays can be configured for a single Windows virtual machine when connecting to the virtual machine using the SPICE protocol.

-

Click and select a virtual machine.

-

With the virtual machine in a powered-down state, click Edit.

-

Click the Console tab.

-

Select the number of displays from the Monitors drop-down list.

This setting controls the maximum number of displays that can be enabled for the virtual machine. While the virtual machine is running, additional displays can be enabled up to this number.

-

Click OK.

-

Start a SPICE session with the virtual machine.

-

Open the View drop-down menu at the top of the SPICE client window.

-

Open the Display menu.

-

Click the name of a display to enable or disable that display.

By default, Display 1 is the only display that is enabled on starting a SPICE session with a virtual machine. If no other displays are enabled, disabling this display will close the session.

4.5. Configuring Console Options

4.5.1. Console Options

Connection protocols are the underlying technology used to provide graphical consoles for virtual machines and allow users to work with virtual machines in a similar way as they would with physical machines. oVirt currently supports the following connection protocols:

SPICE

Simple Protocol for Independent Computing Environments (SPICE) is the recommended connection protocol for both Linux virtual machines and Windows virtual machines. To open a console to a virtual machine using SPICE, use Remote Viewer.

VNC

Virtual Network Computing (VNC) can be used to open consoles to both Linux virtual machines and Windows virtual machines. To open a console to a virtual machine using VNC, use Remote Viewer or a VNC client.

RDP

Remote Desktop Protocol (RDP) can only be used to open consoles to Windows virtual machines, and is only available when you access a virtual machines from a Windows machine on which Remote Desktop has been installed. Before you can connect to a Windows virtual machine using RDP, you must set up remote sharing on the virtual machine and configure the firewall to allow remote desktop connections.

|

SPICE is not supported on virtual machines running Windows 8 or Windows 8.1. If a virtual machine running one of these operating systems is configured to use the SPICE protocol, it detects the absence of the required SPICE drivers and runs in VGA compatibility mode. |

4.5.2. Accessing Console Options

You can configure several options for opening graphical consoles for virtual machines in the Administration Portal.

Procedure

-

Click and select a running virtual machine.

-

Click .

|

You can configure the connection protocols and video type in the Console tab of the Edit Virtual Machine window in the Administration Portal. Additional options specific to each of the connection protocols, such as the keyboard layout when using the VNC connection protocol, can be configured. See Virtual Machine Console settings explained for more information. |

4.5.3. SPICE Console Options

When the SPICE connection protocol is selected, the following options are available in the Console Options window.

SPICE Options

-

Map control-alt-del shortcut to ctrl+alt+end: Select this check box to map the

Ctrl+Alt+Delkey combination toCtrl+Alt+Endinside the virtual machine. -

Enable USB Auto-Share: Select this check box to automatically redirect USB devices to the virtual machine. If this option is not selected, USB devices will connect to the client machine instead of the guest virtual machine. To use the USB device on the guest machine, manually enable it in the SPICE client menu.

-

Open in Full Screen: Select this check box for the virtual machine console to automatically open in full screen when you connect to the virtual machine. Press

SHIFT+F11to toggle full screen mode on or off. -

Enable SPICE Proxy: Select this check box to enable the SPICE proxy.

4.5.4. VNC Console Options

When the VNC connection protocol is selected, the following options are available in the Console Options window.

Console Invocation

-

Native Client: When you connect to the console of the virtual machine, a file download dialog provides you with a file that opens a console to the virtual machine via Remote Viewer.

-

noVNC: When you connect to the console of the virtual machine, a browser tab is opened that acts as the console.

VNC Options

-

Map control-alt-delete shortcut to ctrl+alt+end: Select this check box to map the

Ctrl+Alt+Delkey combination toCtrl+Alt+Endinside the virtual machine.

4.5.5. RDP Console Options

When the RDP connection protocol is selected, the following options are available in the Console Options window.

Console Invocation

-

Auto: The Engine automatically selects the method for invoking the console.

-

Native client: When you connect to the console of the virtual machine, a file download dialog provides you with a file that opens a console to the virtual machine via Remote Desktop.

RDP Options

-

Use Local Drives: Select this check box to make the drives on the client machine accessible on the guest virtual machine.

4.5.6. Remote Viewer Options

Remote Viewer Options

When you specify the Native client console invocation option, you will connect to virtual machines using Remote Viewer. The Remote Viewer window provides a number of options for interacting with the virtual machine to which it is connected.

Table 7. Remote Viewer Options

| Option | Hotkey |

|---|---|

|

File |

|

|

View |

|

|

Send key |

|

|

Help |

The About entry displays the version details of Virtual Machine Viewer that you are using. |

|

Release Cursor from Virtual Machine |

|

Remote Viewer Hotkeys

You can access the hotkeys for a virtual machine in both full screen mode and windowed mode. If you are using full screen mode, you can display the menu containing the button for hotkeys by moving the mouse pointer to the middle of the top of the screen. If you are using windowed mode, you can access the hotkeys via the Send key menu on the virtual machine window title bar.

|

If |

Manually Associating console.vv Files with Remote Viewer

If you are prompted to download a console.vv file when attempting to open a console to a virtual machine using the native client console option, and Remote Viewer is already installed, then you can manually associate console.vv files with Remote Viewer so that Remote Viewer can automatically use those files to open consoles.

Manually Associating console.vv Files with Remote Viewer

-

Start the virtual machine.

-

Open the Console Options window:

-

In the Administration Portal, click .

-

In the VM Portal, click the virtual machine name and click the pencil icon beside Console.

-

-

Change the console invocation method to Native client and click OK.

-

Attempt to open a console to the virtual machine, then click Save when prompted to open or save the console.vv file.

-

Click the location on your local machine where you saved the file.

-

Double-click the console.vv file and select Select a program from a list of installed programs when prompted.

-

In the Open with window, select Always use the selected program to open this kind of file and click the Browse button.

-

Click the C:\Users_[user name]_\AppData\Local\virt-viewer\bin directory and select remote-viewer.exe.

-

Click Open and then click OK.

When you use the native client console invocation option to open a console to a virtual machine, Remote Viewer will automatically use the console.vv file that the oVirt Engine provides to open a console to that virtual machine without prompting you to select the application to use.

4.6. Configuring a Watchdog

4.6.1. Adding a Watchdog Card to a Virtual Machine

You can add a watchdog card to a virtual machine to monitor the operating system’s responsiveness.

Procedure

-

Click and select a virtual machine.

-

Click Edit.

-

Click the High Availability tab.

-

Select the watchdog model to use from the Watchdog Model drop-down list.

-

Select an action from the Watchdog Action drop-down list. This is the action that the virtual machine takes when the watchdog is triggered.

-

Click OK.

4.6.2. Installing a Watchdog

To activate a watchdog card attached to a virtual machine, you must install the watchdog package on that virtual machine and start the watchdog service.

Installing Watchdogs

-

Log in to the virtual machine on which the watchdog card is attached.

-

Install the

watchdogpackage and dependencies: -

Edit the /etc/watchdog.conf file and uncomment the following line:

watchdog-device = /dev/watchdog -

Save the changes.

-

Start the

watchdogservice and ensure this service starts on boot:-

Enterprise Linux 6:

# service watchdog start # chkconfig watchdog on -

Enterprise Linux 7:

# systemctl start watchdog.service # systemctl enable watchdog.service

-

4.6.3. Confirming Watchdog Functionality

Confirm that a watchdog card has been attached to a virtual machine and that the watchdog service is active.

|

This procedure is provided for testing the functionality of watchdogs only and must not be run on production machines. |

Confirming Watchdog Functionality

-

Log in to the virtual machine on which the watchdog card is attached.

-

Confirm that the watchdog card has been identified by the virtual machine:

# lspci | grep watchdog -i -

Run one of the following commands to confirm that the watchdog is active:

-

Trigger a kernel panic:

# echo c > /proc/sysrq-trigger -

Terminate the

watchdogservice:

-

The watchdog timer can no longer be reset, so the watchdog counter reaches zero after a short period of time. When the watchdog counter reaches zero, the action specified in the Watchdog Action drop-down menu for that virtual machine is performed.

4.6.4. Parameters for Watchdogs in watchdog.conf

The following is a list of options for configuring the watchdog service available in the /etc/watchdog.conf file. To configure an option, you must uncomment that option and restart the watchdog service after saving the changes.

|

For a more detailed explanation of options for configuring the |

Table 8. watchdog.conf variables

| Variable name | Default Value | Remarks |

|---|---|---|

|

|

N/A |

An IP address that the watchdog attempts to ping to verify whether that address is reachable. You can specify multiple IP addresses by adding additional |

|

|

N/A |

A network interface that the watchdog will monitor to verify the presence of network traffic. You can specify multiple network interfaces by adding additional |

|

|

|

A file on the local system that the watchdog will monitor for changes. You can specify multiple files by adding additional |

|

|

|

The number of watchdog intervals after which the watchdog checks for changes to files. A |

|

|

|

The maximum average load that the virtual machine can sustain over a one-minute period. If this average is exceeded, then the watchdog is triggered. A value of |

|

|

|

The maximum average load that the virtual machine can sustain over a five-minute period. If this average is exceeded, then the watchdog is triggered. A value of |

|

|

|

The maximum average load that the virtual machine can sustain over a fifteen-minute period. If this average is exceeded, then the watchdog is triggered. A value of |

|

|

|

The minimum amount of virtual memory that must remain free on the virtual machine. This value is measured in pages. A value of |

|

|

|

The path and file name of a binary file on the local system that will be run when the watchdog is triggered. If the specified file resolves the issues preventing the watchdog from resetting the watchdog counter, then the watchdog action is not triggered. |

|

|

N/A |

The path and file name of a binary file on the local system that the watchdog will attempt to run during each interval. A test binary allows you to specify a file for running user-defined tests. |

|

|

N/A |

The time limit, in seconds, for which user-defined tests can run. A value of |

|

|

N/A |

The path to and name of a device for checking the temperature of the machine on which the |

|

|

|

The maximum allowed temperature for the machine on which the |

|

|

|

The email address to which email notifications are sent. |

|

|

|

The interval, in seconds, between updates to the watchdog device. The watchdog device expects an update at least once every minute, and if there are no updates over a one-minute period, then the watchdog is triggered. This one-minute period is hard-coded into the drivers for the watchdog device, and cannot be configured. |

|

|

|

When verbose logging is enabled for the |

|

|

|

Specifies whether the watchdog is locked in memory. A value of |

|

|

|

The schedule priority when the value of |

|

|

|

The path and file name of a PID file that the watchdog monitors to see if the corresponding process is still active. If the corresponding process is not active, then the watchdog is triggered. |

4.7. Configuring Virtual NUMA

In the Administration Portal, you can configure virtual NUMA nodes on a virtual machine and pin them to physical NUMA nodes on one or more hosts. The host’s default policy is to schedule and run virtual machines on any available resources on the host. As a result, the resources backing a large virtual machine that cannot fit within a single host socket could be spread out across multiple NUMA nodes. Over time these resources may be moved around, leading to poor and unpredictable performance. Configure and pin virtual NUMA nodes to avoid this outcome and improve performance.

Configuring virtual NUMA requires a NUMA-enabled host. To confirm whether NUMA is enabled on a host, log in to the host and run numactl --hardware. The output of this command should show at least two NUMA nodes. You can also view the host’s NUMA topology in the Administration Portal by selecting the host from the Hosts tab and clicking NUMA Support. This button is only available when the selected host has at least two NUMA nodes.

|

If you define NUMA Pinning, the default migration mode is Allow manual migration only by default. |

Configuring Virtual NUMA

-

Click and select a virtual machine.

-

Click Edit.

-

Click Show Advanced Options.

-

Click the Host tab.

-

Select the Specific Host(s) radio button and select the host(s) from the list. The selected host(s) must have at least two NUMA nodes.

-

Click NUMA Pinning.

-

In the NUMA Topology window, click and drag virtual NUMA nodes from the box on the right to host NUMA nodes on the left as required, and click OK.

-

Select Strict, Preferred, or Interleave from the Tune Mode drop-down list in each NUMA node. If the selected mode is Preferred, the NUMA Node Count must be set to

1. -

You can also set the NUMA pinning policy automatically by selecting Resize and Pin NUMA from the CPU Pinning Polcy drop-down list under the CPU Allocation settings in the Resource Allocation tab:

-

None— Runs without any CPU pinning. -

Manual— Runs a manually specified virtual CPU on a specific physical CPU and a specific host. Available only when the virtual machine is pinned to a Host. -

Resize and Pin NUMA— Resizes the virtual CPU and NUMA topology of the virtual machine according to the Host, and pins them to the Host resources. -

Dedicated— Exclusively pins virtual CPUs to host physical CPUs. Available for cluster compatibility level 4.7 or later. If the virtual machine has NUMA enabled, all nodes must be unpinned. -

Isolate Threads— Exclusively pins virtual CPUs to host physical CPUs. Each virtual CPU gets a physical core. Available for cluster compatibility level 4.7 or later. If the virtual machine has NUMA enabled, all nodes must be unpinned.

-

-

Click OK.

|

If you do not pin the virtual NUMA node to a host NUMA node, the system defaults to the NUMA node that contains the host device’s memory-mapped I/O (MMIO), provided that there are one or more host devices and all of those devices are from a single NUMA node. |

4.8. Configuring Satellite errata viewing for a virtual machine

In the Administration Portal, you can configure a virtual machine to display the available errata. The virtual machine needs to be associated with a Red Hat Satellite server to show available errata.

oVirt 4.4 supports viewing errata with Red Hat Satellite 6.6.

Prerequisites

-

The Satellite server must be added as an external provider.

-

The Engine and any virtual machines on which you want to view errata must all be registered in the Satellite server by their respective FQDNs. This ensures that external content host IDs do not need to be maintained in oVirt.

Virtual machines added using an IP address cannot report errata.

-

The host that the virtual machine runs on also needs to be configured to receive errata information from Satellite.

-

The virtual machine must have the

ovirt-guest-agentpackage installed. This package enables the virtual machine to report its host name to the oVirt Engine, which enables the Red Hat Satellite server to identify the virtual machine as a content host and report the applicable errata. -

The virtual machine must be registered to the Red Hat Satellite server as a content host.

-

Use Red Hat Satellite remote execution to manage packages on hosts.

|

The Katello agent is deprecated and will be removed in a future Satellite version. Migrate your processes to use the remote execution feature to update clients remotely. |

Procedure

-

Click and select a virtual machine.

-

Click Edit.

-

Click the Foreman/Satellite tab.

-

Select the required Satellite server from the Provider drop-down list.

-

Click OK.

Additional resources

-

Setting up Satellite errata viewing for a host in the Administration Guide

-

Installing the Guest Agents, Tools, and Drivers on Linux in the Virtual Machine Management Guide for Enterprise Linux virtual machines.

-

Installing the Guest Agents, Tools, and Drivers on Windows in the Virtual Machine Management Guide for Windows virtual machines.

4.9. Configuring Headless Virtual Machines

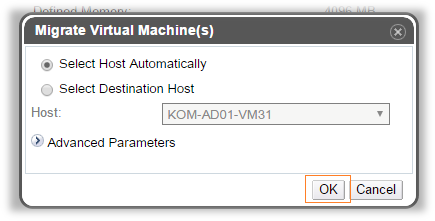

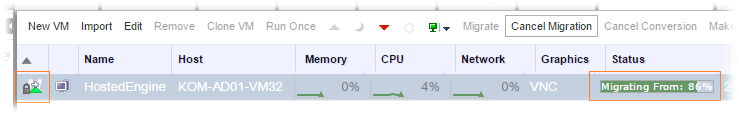

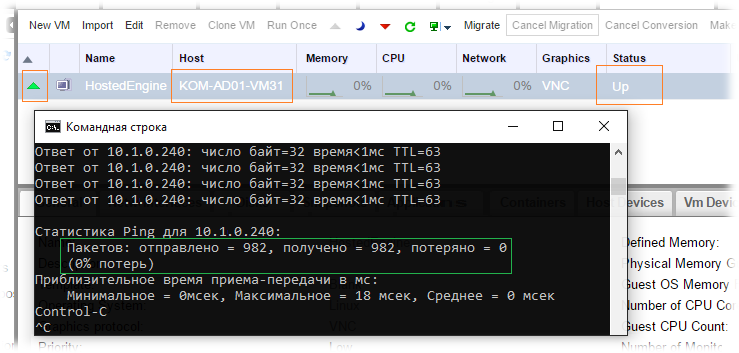

You can configure a headless virtual machine when it is not necessary to access the machine via a graphical console. This headless machine will run without graphical and video devices. This can be useful in situations where the host has limited resources, or to comply with virtual machine usage requirements such as real-time virtual machines.