-

bonding, lacp, windows, networking, windows server 2016, windows server 2019

- 12

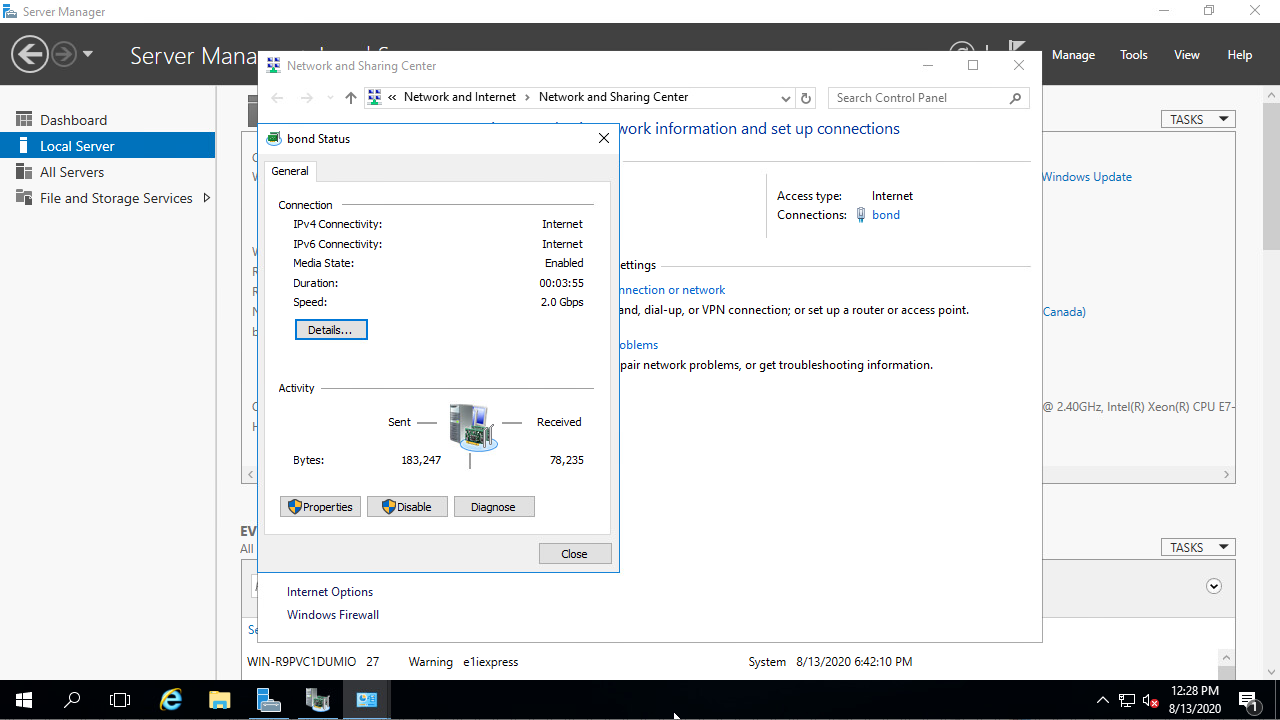

After installing Windows Server 2016/2019, LACP can be configuring by following the steps in this tutorial.

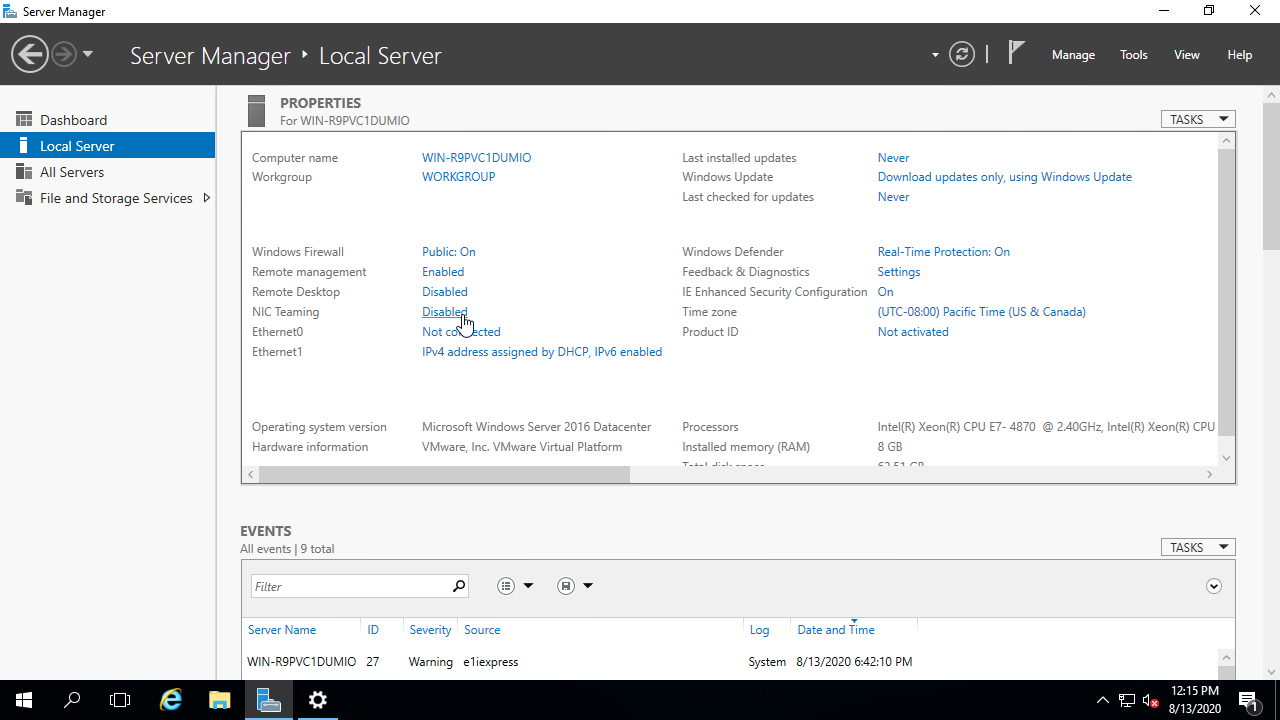

The Server Manager application should already be running, in case it is not, start it.

Step 1 — Opening the NIC teaming Interaface:

- Inside

Server Manager, navigate to Local Server (this option can be found in the left sidebar). - Proceed by clicking on the blue

Disabledlink next toNIC Teaming.

Step 2 — Set up the LACP interface

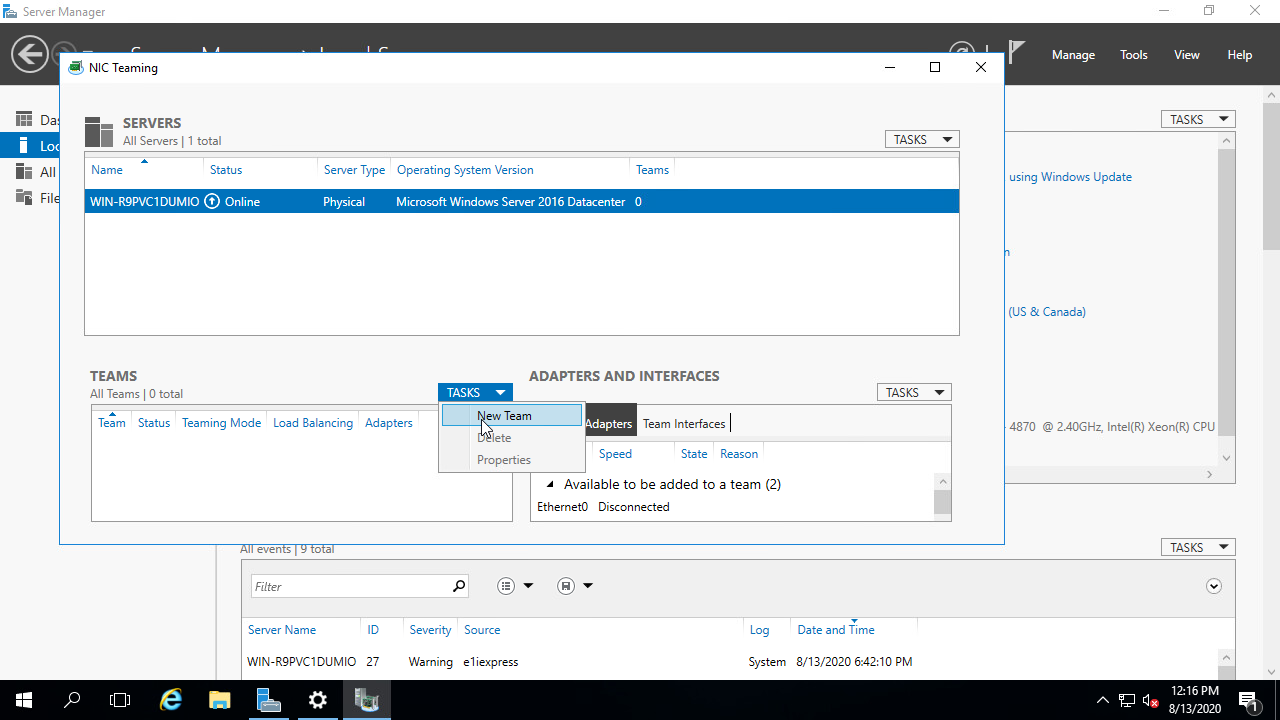

- In the top right corner of the

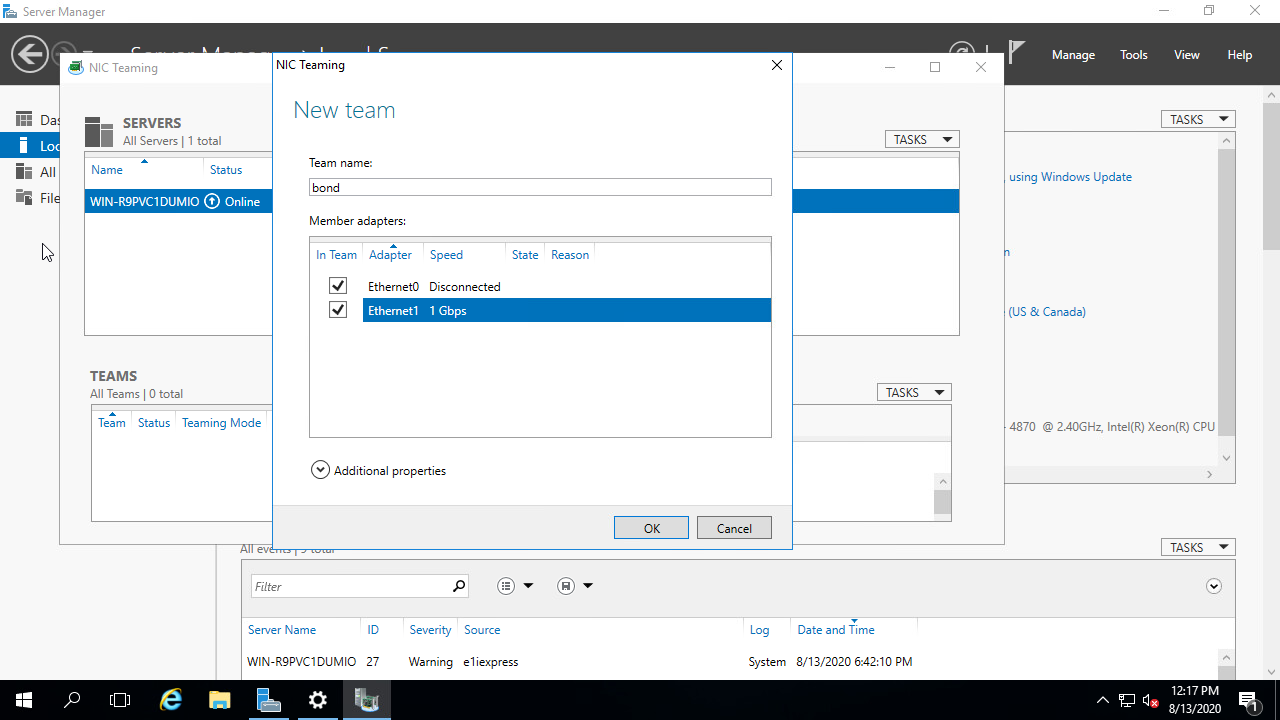

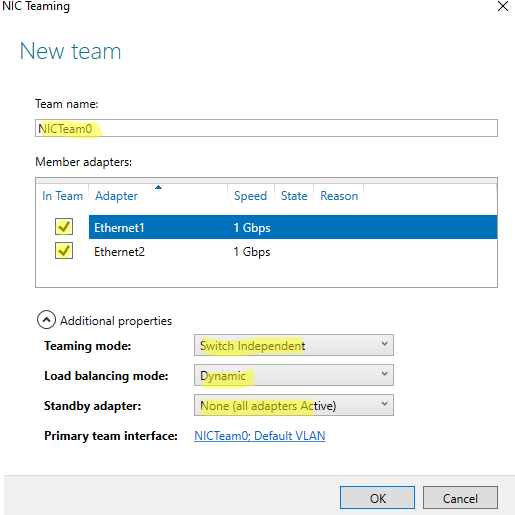

NIC Teamingwindow, click onTASKSand selectNew Team. - In the new interface that poped up, enter a name for the team (example: bond) and select the interfaces you want to use for the bond you are setting up by checking the checkboxes that appeared next to them.

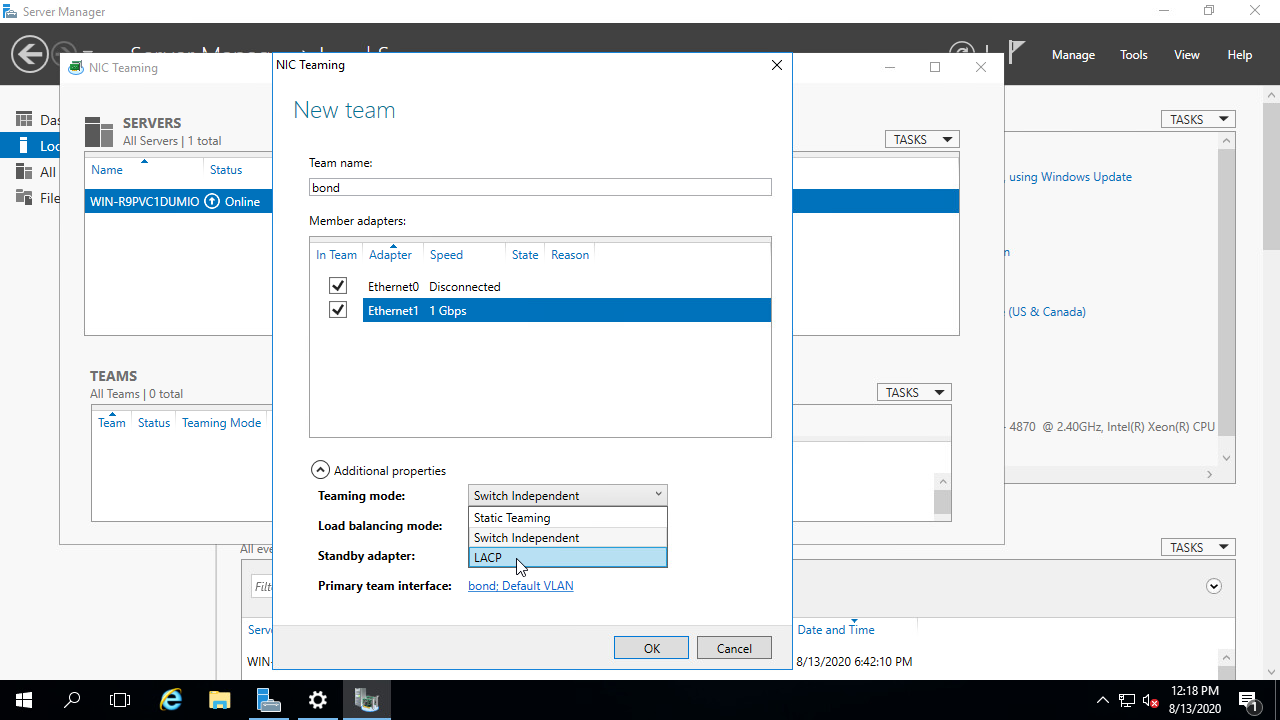

- Proceed by clicking on

Additional propertiesand selecting LACP as theTeaming mode. - After selecting LACP in the Teaming mode, click on OK and the interface will be created.

Step 3 — Configuring an IP address

This will not be covered in this guide, now you can go ahead and configure an IP address in on the bond interface like you would normally do on the standard interface in a server.

After this is done, your server should have internet connectivity.

In case you are running into issues, feel free to contacting our support department by creating a ticket or sending an e-mail to [email protected].

Was this answer helpful?

Технология NIC Teaming (или Load Balancing/Failover – LBFO, или NIC bonding) позволяет объединить несколько физических сетевых адаптеров (NIC) в одну логическую сетевую карту. В этой статье мы рассмотрим, как настроить NIC Teaming в Windows Server 2019/2016/2012R2 и в десктопых версиях Windows 10 и 11.

Содержание:

- Настройка NIC Teaming в Windows Server 2019

- Используем PowerShell для настройки NIC Teaming в Windows Server

- Создаем группу сетевых адаптеров NIC Teaming в Windows 10 и 11

Для чего может понадобится объединять сетевые адаптеры в группу NIC Teaming?

- Увеличение пропускной способности. Например, объединив две сетевые 1 Гб сетевые карты в одну группу NIC Teaming, вы получите общую полосу пропускания на логическом адаптере 2 Гбит/с;

- Управление балансировкой нагрузки на сетевые карты – можно управлять распределением трафика между NIC сервера;

- Отказоустойчивость – при выходе из строя любой из сетевых карт, добавленных в группу NIC teaming, остальные подхватывают ее функции, и связь с сервером не прерывается. Для критически важных серверов этот механизм может защитить от простоя сервиса во время выхода из строя сетевого коммутатора или Ethernet порта на нем, сетевого кабеля (которым ваш хост подключен к коммутатору). Для реализации такой возможности, достаточно подключить сетевые карты в разные физические коммутаторы.

В Windows Server 2012R2/2016/2019/2022 технология NIC Teaming не совместима с Single-root I/O virtualization (SR-IOV), TCP Chimney и Remote Direct Memory Access (RDMA).

Настройка NIC Teaming в Windows Server 2019

Вы можете настроить NIC Teaming в Windows Server начиная с версии 2012. Рассмотрим, как объединить несколько сетевых адаптеров в Windows Server 2019 в одну группу NIC Teaming. Режим NIC Teaming по умолчанию отключен в Windows Server.

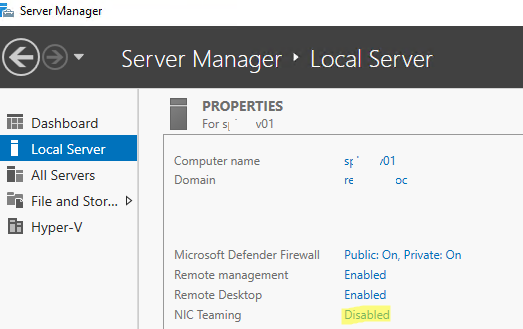

Чтобы включить его, откройте консоль Server Manager, выберите локальный сервер (Local Server) и в его свойствах выберите пункт “NIC Teaming: Disabled“.

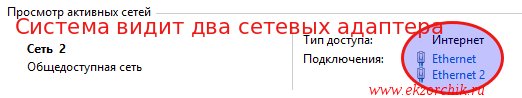

В появившемся окне в левой нижней панели выберите пункт Tasks -> New Team (Создать группу).

Далее нужно указать имя группы (Team Name) и выбрать сетевые адаптеры, которые будут входить в эту группу.

В Windows Server 2019 в одну NIC Teaming групп можно объединить до 32 физических сетевых адаптеров, главное, чтобы они работали на одной скорости.

Ниже можно настроить специальные параметры группы. От данных параметров зависит правила и эффективность NIC Teaming. Рассмотрим эти настройки подробнее.

Режим поддержки групп (Teaming Mode). Данный параметр определяет способ взаимодействия группы с сетевым оборудованием (коммутатором)

- Static Teaming (IEEE 802.3ad)— статический режим работы с зависимостью от сетевого оборудования. Все адаптеры группы должны быть подключены к одному коммутатору, Ethernet порты которого настроены на использование статической агрегации каналов (требуется настройка на коммутаторе);

- Switch Independent (режим по-умолчанию) – группа работает независимо от коммутатора, для реализации не нужно дополнительно настраивать сетевое оборудование. В этом режиме разные сетевые адаптеры группы можно подключить к разным коммутаторам для повышения отказоустойчивости (защита от сбоев в коммутаторах);

- LACP (Link Aggregation Control Protocol, LACP, IEEE 802.1ax) – режим также зависит от сетевого оборудования. Нужно включить и настроить на коммутаторе динамическую агрегацию каналов по протоколу LACP.

Режим балансировки нагрузки (Load Balancing mode) – задает как распределяется сетевой трафик по NIC в группе.

- Address Hash — для каждого из адаптеров вычисляется специальный хэш (на основании MAC или IP-адресов отправителя и получателя) и привязывается определенному физическому адаптеру. Весь трафик от данного отправителя будет идти через этот NIC;

- Hyper-V Port — режим можно использовать для сервера с ролью Hyper-V. Позволяет привязать конкретный адаптер группу NIC teaming к конкретному порту на виртуальном коммутаторе Hyper-V;

- Dynamic – опция по умолчанию, совмещает оба типа балансировки нагрузки.

Один из адаптеров в группе можно назначить резервным (Standby adapter). В обычном режиме работы данная NIC не используется для передачи трафика. При неполадке на любом другом адаптере в группе NIC Teaming, он тут-же занимает его место. В общем случае и без данной функции при выходе из строя любой сетевой карты, не будет простоя сервиса, т.к. ее нагрузка автоматически распределится между оставшимися картами в группе.

Выберите нужные параметры, нажмите ОК и новая группа Nic Teaming будет создана.

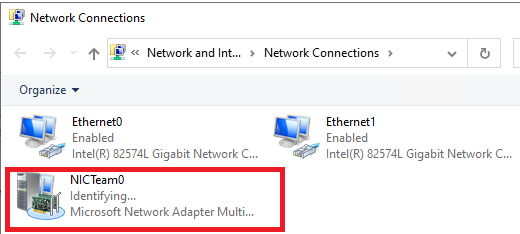

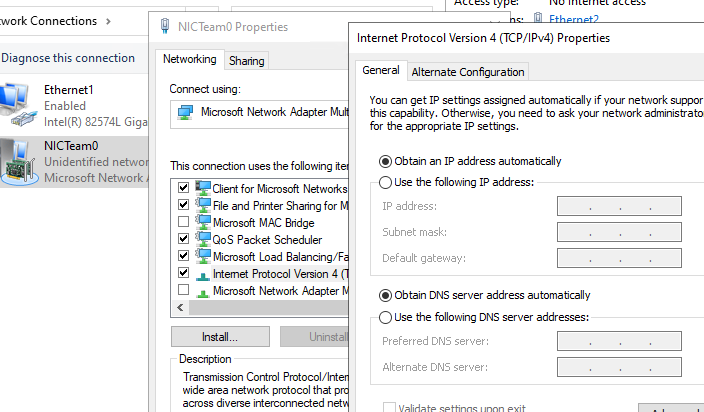

Откройте список сетевых подключения в панели управления Windows. Убедитесь, что в Windows Server появился новый сетевой адаптер Microsoft Network Adapter Multiplexor Driver (его иконка немного отличается). Это и есть виртуальный адаптер группы NIC Teaming.

Дальнейшая настройка параметров сетевой карты (протоколы, IPv4/v6 адрес) осуществляется теперь в свойствах этого адаптера.

У всех остальных сетевых адаптеров, которые вы добавили в группу NIC Teaming уже не будет собственных IP адресов.

При удалении группы NIC Teaming предыдущие настройки сетевых адаптеров восстанавливаются.

В дальнейшем вы можете добавить или удалить сетевые адаптеры в группу NIC Teaming.

Вы можете использовать группу NIC Teaming для настройки нескольких VLAN интерфейсов в Windows Server. Для этого можно даже создать группу NIC Teaming из одного сетевого адаптера.

Используем PowerShell для настройки NIC Teaming в Windows Server

Вы можете создавать и управлять группами NIC Teaming не только из графического интерфейса Windows, но и с помощью PowerShell. Вы можете использовать PowerShell для настройки NIC Teaming в Windows Server Core

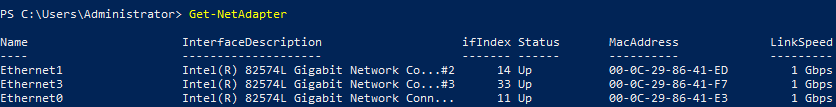

В Windows Server для управления MIC Teaming есть встроенный модуль NetLbfo. Выведите список сетевых адаптеров на сервере:

Get-NetAdapter

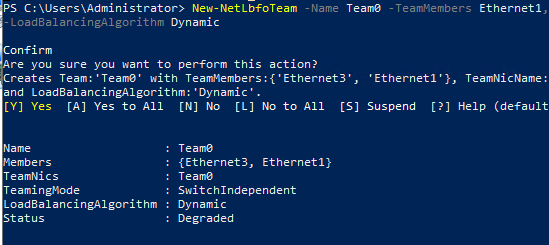

Создайте новую группу с Team0 из адаптеров с именами Ethernet1 и Ethernet3. Выберите режим работы NIC Teaming: Switch Independent с динамической балансировкой.

New-NetLbfoTeam -Name Team0 -TeamMembers Ethernet1,Ethernet3 -TeamingMode SwitchIndependent -LoadBalancingAlgorithm Dynamic

Доступные параметры:

- TeamingMode:

Static

,

SwitchIndependent

,

Lacp - LoadBalansingAlgorithm:

TransportPorts

,

IPAddresses

,

MacAddresses

,

HyperVPort

,

Dynamic

Информацию о группах NIC Teaming на сервере можно вывести с помощью команды:

Get-NetLbfoTeam

Name : Team0

Members : {Ethernet3, Ethernet1}

TeamNics : Team0

TeamingMode : SwitchIndependent

LoadBalancingAlgorithm : Dynamic

Status : Up

Можно настроить IP адрес интерфейса NIC Teaming с помощью PowerShell:

New-NetIPAddress -InterfaceAlias team0 -IPAddress 192.168.13.100 -PrefixLength 24 -DefaultGateway 192.168.13.1

Set-DnsClientServerAddress -InterfaceAlias team0 -ServerAddresses 192.168.13.10

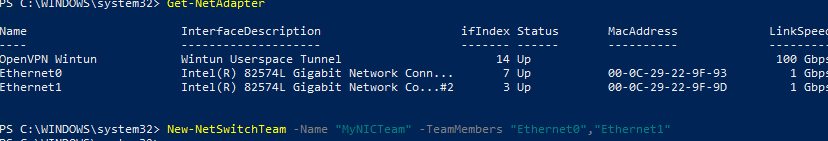

Выполните команду

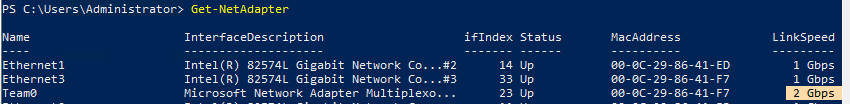

Get-NetAdapter

. Обратите внимание, что LinkSpeed сетевого адаптера группу NIC Teaming — 2 Гбит/с.

Чтобы изменить настройки группы NIC Teaming используется командлет Set-NetLbfoTeam:

Set-NetLbfoTeam -Name team0 -TeamingMode LACP

Если выполнить эту команду в ВМ, появится ошибка

Set-NetLbfoTeam : 'SwitchIndependent' is the only TeamingMode value supported in a Virtual Machine

Чтобы через NIC Teaming добавить отдельный VLAN интерфейс, используйте команду:

Add-NetLbfoTeamNIC -Team Team0 -VlanID 10

Удалить группу NIC Team можно командой:

Remove-NetLbfoTeam -Name Team0

Создаем группу сетевых адаптеров NIC Teaming в Windows 10 и 11

Вы можете использовать NIC Teaming для объединения сетевых карт не только в Windows Server, но и в клиентских версиях Windows 10 и 11. Главное, чтобы производитель вашей сетевой карты поддерживал для нее режим Link aggregation / NIC teaming/ LBFO.

Например, NIC Teaming работает из коробки с драйверами картами Realtek PCIe GbE Family Controller ( 10.35.510.2019) или Intel(R) 82574L Gigabit Network Connection.

Чтобы собрать группу NIC Teaming в Windows 10 (в этом примере это Windows 10 20H2), откройте консоль PowerShell и выведите список сетевых адаптеров:

Get-NetAdapter

Соберем группу NIC Team из адаптеров Ethernet0 и Ethernet1.

New-NetSwitchTeam -Name "MyNICTeam" -TeamMembers "Ethernet0","Ethernet1"

Проверьте, что в системе появился новый интерфейс NIC Teaming.

Get-NetSwitchTeam

Не забудьте задать для него сетевые настройки. Теперь у вас появился новый интерфейс с пропускной способностью 2 Гбит/с.

Для удаления созданной группы NIC Team, также нужно использовать PowerShell:

Remove-NetSwitchTeam -Name "MyNICTeam"

In my blog entitled “Inter-VLAN Routing Between Virtual Machines” I created two subnets and made the necessary configuration on the router and in Hyper-V Manager to communicate between hosts in two different VLANs. The configuration works great but there is one glaring limitation – scalability. If I wanted to add more VLANs and assign those VLANs to a subnet, I would need to add more NICs. To address this limitation, I will configure a NIC Team in Windows Server 2019 and specify in Hyper-V Manager what VLAN I want my VMs to use for network communication.

A NIC Team is a way to group together several physical interfaces into one logical interface for the purpose of improving network performance and redundancy. In Cisco IOS this is also called an EtherChannel.

For this task I purchased an Intel Pro 1000 PT 1Gb Quad Port Ethernet Server Adapter. My hope was that I would be able to put all the ports in a Team or create two Teams with two ports in each team but this computer is only able to see two of the 4 ports on the server adapter. After troubleshooting for a few hours I could not figure out why my computer is unable to see all the ports. Perhaps there is some kind of hardware limitation unique to the Dell Optiplex 7010. I decided to power through and just use the two ports I am able to use.

VLAN Aware vs VLAN Capable

One of the things that came up for me as I was accomplishing this task is distinguishing the difference between VLAN Awareness and VLAN Capability. In the Hyper-V Virtual Switch Manager you are given the option of specifying a VLAN however when using this, you are not actually creating a VLAN. VLANs are created on the port of the network switch (VLAN capable). However, what Windows Server 2019 can do is acknowledge that a packet is tagged with a specific VLAN and pass the traffic to the switch to make the appropriate forwarding decision (VLAN aware). This is great because typically computers drop packets that are tagged with a VLAN.

NIC Team Configuration

To create a NIC Team, open the Server Manager and with “Local Server” selected in the left navigation pane, select the NIC Teaming option under the server properties. Then select “Tasks” under the “Teams” section and you will be able to select the interfaces you would like to join your new NIC Team, the Teaming mode and the Load balancing mode. In figure 1-1 I have right clicked on the NIC Team I created and selected properties which is identical to the screen you see when creating a new NIC Team:

LACP or Link Aggregation Control Protocol allows the switch to dynamically negotiate which links between the switch and the host get added to the Link Aggregation Group (LAG). LACP in Windows Server operates in “active mode” so that means that on the switch I will also need to configure LACP in active mode. Im not overly concerned about load balancing performance so for the load balancing algorithm I went with Dynamic.

For this task I have also slightly amended the topology from my blog entitled “Inter-VLAN Routing Between Virtual Machines.” Since the EHWIC in my router does not support Link Aggregation, I will add a multilayer switch:

EtherChannel Configuration

Below are the commands issued on S1 to configure a L2 EtherChannel:

It is important first to make sure that both ports on the switch have the same configuration before creating the EtherChannel. I issued the #interface range command and grabbed both the fa1/0/1 and fa1/0/2 interface, configured the encapsulation protocol and set both to trunk mode. Then I created the etherchannel by issuing the #channel-group command and configured the negotiation protocol as “active” to specify to the switch that I want it to use LACP. Finally, I issued the #show etherchannel summary command to show that etherchannel is in an “up” state.

Confusingly, Cisco uses “etherchannel” , “channel group” , and “port channel” all to refer to the same thing. The output of this show command shows that I created a new logical interface called “Po1” and the protocol being used is LACP. The letters “S” and “U” are in parenthesis which according to the key in the show command output, indicate that this new logical interface is in use and is operating in L2. Success! The last thing to do now is specify in the Hyper-V Manager which VLANs I want to be used for network communication for the VLANs:

First I selected the Virtual Switch Manager and renamed my vSwitch. Then I chose the NIC Team which is represented as “Microsoft Network Adapter Multiplexor Driver” and binded this NIC Team to the External vSwitch. I want the Hyper-V Host to participate in this vSwitch so I also selected the option “Allow management operating system to share this network adapter” The final piece of configuration for this external vSwitch is to specify VLAN 100 as the VLAN I want the Hyper-V host to use to communicate on the network.

Next I needed to configure a static IP address to the virtual NIC:

The last piece of Hyper-V config is assigning each VM to the external switch “BH-vSwitch” and specifying the VLAN that I want each VM to use for network communication. BH-VM-SRV1 will be use VLAN 100 and BH-VM-SRV2 will use VLAN 110:

All that’s left is to test connectivity! From the Hyper-V host I was able to successfully ping the gateway of VLAN 100 as well as each VM as shown in figure 1-7 below. I was also able to successfully ping BH-VM-SRV1 from BH-VM-SRV2 and vice-versa.

Подключить и настроить Агрегирование каналов

Агрегирование каналов (bonding) — технологии объединения нескольких параллельных каналов передачи данных в сетях Ethernet. Опция поможет сбалансировать нагрузку на выделенном сервере и повысить отказоустойчивость.

Мы настраиваем агрегирование каналов по стандартному протоколу LACP. Услуга платная, актуальную стоимость можно уточнить в отделе продаж по почте sales@edgecenter.ru.

Для того, чтобы подключить услугу, выполните настройки, как описано ниже, после чего обратитесь к нам в техническую поддержку.

Предварительные условия

Перед настройкой агрегирования каналов:

1. Убедитесь, что знаете IP-адрес вашего сервера, IP-адрес шлюза, а также маску подсети — эта информация будет нужна для настройки сетевых интерфейсов.

IP-адрес вашего сервера и данные сети, к которой он принадлежит, можно найти в Панели управления. Для этого в разделе Товары/Услуги → Физические ресурсы выберите нужный сервер и нажмите IP-адреса.

2. Найдите активный IP-адрес сервера и запомните данные из колонок «IP-адрес», «Маска» и «Шлюз».

3. Закажите и оплатите услугу Агрегирование каналов.

В разделе Товары/Услуги → Агрегирование каналов нажмите Заказать и оплатите услугу.

Настройка на сервере

После заказа услуги необходимо подключиться к серверу и настроить сетевые интерфейсы, как описано ниже.

Пример настройки для Ubuntu 20.04

1. Обновите все пакеты Ubuntu.

2. Установите пакет ifenslave.

sudo apt-get install ifenslave 3. С помощью команды modprobe загрузите модуль bonding.

После этого вы можете выполнить команду lsmod | grep bonding. Если модуль загружен, то вы получите примерный ответ, который показан ниже.

4. Просмотрите информацию о доступных интерфейсах.

Пример ответа представлен ниже.

1: lo: <LOOPBACK,UP,LOWER_UP> ...

...

2: eno1: <BROADCAST,MULTICAST,UP,LOWER_UP> ...

...

3: eno2: <BROADCAST,MULTICAST> ...

...В данном случае физические интерфейсы имеют названия eno1 и eno2. Запомните эти названия — их нужно будет указать в файле /etc/network/interfaces.

5. Отредактируйте настройки сетевых интерфейсов. Для этого откройте файл /etc/network/interfaces с помощью редактора nano.

nano /etc/network/interfaces

Замените содержимое файла на указанное ниже и сохраните изменения.

auto eno1

iface eno1 inet manual

bond-master bond0

bond-primary eno1

bond-mode 4

auto eno2

iface eno2 inet manual

bond-master bond0

bond-mode 4

auto bond0

iface bond0 inet static

address x.x.x.x

netmask y.y.y.y

network x.x.x.0

gateway z.z.z.z

bond-slaves eno1 eno2

bond-mode 4

bond-miimon 100

bond-downdelay 200

bond-lacp-rate 1

dns-nameservers 8.8.8.8

dns-search comПри этом:

-

вместо eno1 и eno2 вставьте названия интерфейсов на вашем сервере;

-

вместо x.x.x.x вставьте IP-адрес вашего сервера;

-

вместо y.y.y.y вставьте маску подсети;

-

в x.x.x.0 вместо x.x.x вставьте три первых числа из IP-адреса сервера;

-

вместо z.z.z.z вставьте IP-адрес шлюза;

-

значения параметров bond-primary, bond-miimon, bond-downdelay, bond-lacp-rate, dns-nameservers и dns-search указаны для примера — вы можете задать свои значения.

6. Перезагрузите сеть, чтобы изменения вступили в силу.

/etc/init.d/networking restart

Если после выполненных действий интерфейсы не были объединены, перезагрузите ОС.

Статус объединённых интерфейсов можно проверить, как показано ниже.

cat /proc/net/bonding/bond0

Пример ответа указан ниже.

Ethernet Channel Bonding Driver: v3.1.1 (September 26, 2006)

Bonding Mode: IEEE 802.3ad Dynamic link aggregation

Transmit Hash Policy: layer2 (0)

MII Status: up

MII Polling Interval (ms): 100

Up Delay (ms): 0

Down Delay (ms): 0

802.3ad info

LACP rate: 1

Active Aggregator Info:

Aggregator ID: 1

<span class="code-object">Number</span> of ports: 2

Actor Key: 17

Partner Key: 1

Partner Mac Address: 00:77:54:71:a8:6f

Slave Interface: eno1

MII Status: up

Link Failure Count: 0

Permanent HW addr: 00:99:97:60:9d:48

Aggregator ID: 1

Slave Interface: eno2

MII Status: up

Link Failure Count: 0

Permanent HW addr: 00:00:85:60:9d:49

Aggregator ID: 1Пример настройки для Debian 11

1. Обновите все пакеты Debian.

2. Установите пакет ifenslave.

apt-get install ifenslave 3. С помощью команды modprobe загрузите модуль bonding.

После этого вы можете выполнить команду lsmod | grep bonding. Если модуль загружен, то вы получите примерный ответ, который показан ниже.

4. Просмотрите информацию о доступных интерфейсах.

Пример ответа представлен ниже.

1: lo: <LOOPBACK,UP,LOWER_UP> ...

...

2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> ...

...

3: eth1: <BROADCAST,MULTICAST> ...

...В данном случае физические интерфейсы имеют названия eth0 и eth1. Запомните эти названия — их нужно будет указать в файле /etc/network/interfaces.

5. Отредактируйте настройки сетевых интерфейсов. Для этого откройте файл /etc/network/interfaces с помощью редактора nano.

nano /etc/network/interfaces

Замените содержимое файла на указанное ниже и сохраните изменения.

source /etc/network/interfaces.d/*

auto lo

iface lo inet loopback

auto eth0

iface eth0 inet manual

bond-master bond0

bond-primary eth0

bond-mode 4

auto eth1

iface eth1 inet manual

bond-master bond0

bond-mode 4

auto bond0

iface bond0 inet static

address x.x.x.x

netmask y.y.y.y

network x.x.x.0

gateway z.z.z.z

bond-slaves eth0 eth1

bond-mode 4

bond-miimon 100

bond-downdelay 200

bond-lacp-rate 1

dns-nameservers 8.8.8.8

dns-search comПри этом:

-

вместо eth0 и eth1 вставьте названия интерфейсов на вашем сервере;

-

вместо x.x.x.x вставьте IP-адрес вашего сервера;

-

вместо y.y.y.y вставьте маску подсети;

-

в x.x.x.0 вместо x.x.x вставьте три первых числа из IP-адреса сервера;

-

вместо z.z.z.z вставьте IP-адрес шлюза;

-

значения параметров bond-primary, bond-miimon, bond-downdelay, bond-lacp-rate, dns-nameservers и dns-search указаны для примера — вы можете задать свои значения.

6. Перезагрузите сеть, чтобы изменения вступили в силу.

/etc/init.d/networking restart

Если после выполненных действий интерфейсы не были объединены, перезагрузите ОС.

Статус объединённых интерфейсов можно проверить, как показано ниже.

cat /proc/net/bonding/bond0

Пример ответа указан ниже.

Ethernet Channel Bonding Driver: v3.1.1 (September 26, 2006)

Bonding Mode: IEEE 802.3ad Dynamic link aggregation

Transmit Hash Policy: layer2 (0)

MII Status: up

MII Polling Interval (ms): 100

Up Delay (ms): 0

Down Delay (ms): 0

802.3ad info

LACP rate: 1

Active Aggregator Info:

Aggregator ID: 1

<span class="code-object">Number</span> of ports: 2

Actor Key: 17

Partner Key: 1

Partner Mac Address: 00:77:54:71:a8:6f

Slave Interface: eth0

MII Status: up

Link Failure Count: 0

Permanent HW addr: 00:99:97:60:9d:48

Aggregator ID: 1

Slave Interface: eth1

MII Status: up

Link Failure Count: 0

Permanent HW addr: 00:00:85:60:9d:49

Aggregator ID: 1Пример настройки для CentOS 7

1. Обновите все пакеты CentOS.

2. С помощью команды modprobe загрузите модуль bonding.

После этого вы можете выполнить команду lsmod | grep bonding. Если модуль загружен, то вы получите примерный ответ, который показан ниже.

3. Просмотрите информацию о доступных интерфейсах.

Пример ответа представлен ниже.

1: lo: <LOOPBACK,UP,LOWER_UP> ...

...

2: eno1: <BROADCAST,MULTICAST,UP,LOWER_UP> ...

...

3: eno2: <BROADCAST,MULTICAST> ...

...В данном случае физические интерфейсы имеют названия eno1 и eno2. Запомните эти названия — файлы с этими названиями нужно будет отредактировать.

5. Отредактируйте настройки сетевых интерфейсов.

Cоздайте и откройте файл /etc/sysconfig/network-scripts/ifcfg-bond0.

vi /etc/sysconfig/network-scripts/ifcfg-bond0Задайте содержимое файла, как показано ниже.

DEVICE=bond0

Type=Bond

NAME=bond0

BONDING_MASTER=yes

BOOTPROTO=none

ONBOOT=yes

IPADDR=x.x.x.x

PREFIX=y

GATEWAY=z.z.z.z

NM_CONTROLLED=no

BONDING_OPTS="mode=4 miimon=100 lacp_rate=1"При этом:

-

вместо x.x.x.x вставьте IP-адрес вашего сервера;

-

вместо y вставьте сетевой префикс без символа /, который соответствует маске. Например, таблицу соответствия масок и префиксов можно посмотреть здесь;

-

вместо z.z.z.z вставьте IP-адрес шлюза;

-

значения параметров miimon, lacp_rate указаны для примера — вы можете задать свои значения.

Откройте файл с конфигурациями первого интерфейса. В данном примере это /etc/sysconfig/network-scripts/ifcfg-eno1.

vi /etc/sysconfig/network-scripts/ifcfg-eno1Измените содержимое файла, как показано ниже.

DEVICE=eno1

TYPE=Ethernet

BOOTPROTO=none

ONBOOT=yes

NM_CONTROLLED=no

IPV6INIT=no

MASTER=bond0

SLAVE=yesОткройте файл с конфигурациями второго интерфейса. В данном примере это /etc/sysconfig/network-scripts/ifcfg-eno2.

vi /etc/sysconfig/network-scripts/ifcfg-eno2Измените содержимое файла, как показано ниже.

DEVICE=eno2

TYPE=Ethernet

BOOTPROTO=none

ONBOOT=yes

NM_CONTROLLED=no

IPV6INIT=no

MASTER=bond0

SLAVE=yes6. Перезагрузите сеть, чтобы изменения вступили в силу.

sudo systemctl restart network

Если после выполненных действий интерфейсы не были объединены, перезагрузите ОС.

Статус объединённых интерфейсов можно проверить, как показано ниже.

cat /proc/net/bonding/bond0

Пример ответа указан ниже.

Ethernet Channel Bonding Driver: v3.1.1 (September 26, 2006)

Bonding Mode: IEEE 802.3ad Dynamic link aggregation

Transmit Hash Policy: layer2 (0)

MII Status: up

MII Polling Interval (ms): 100

Up Delay (ms): 0

Down Delay (ms): 0

802.3ad info

LACP rate: 1

Active Aggregator Info:

Aggregator ID: 1

<span class="code-object">Number</span> of ports: 2

Actor Key: 17

Partner Key: 1

Partner Mac Address: 00:77:54:71:a8:6f

Slave Interface: eno1

MII Status: up

Link Failure Count: 0

Permanent HW addr: 00:99:97:60:9d:48

Aggregator ID: 1

Slave Interface: eno2

MII Status: up

Link Failure Count: 0

Permanent HW addr: 00:00:85:60:9d:49

Aggregator ID: 1

Пример настройки для Windows Server 2019

1. Откройте Server Manager.

2. В меню Local Server перейдите в настройку NIC Teaming.

3. В окне TEAMS откройте выпадающее меню TASKS и выберите New Team.

4. В появившемся окне:

-

в поле «Team name» задайте имя группы, которая будет включать объединённые физические интерфейсы;

-

в поле «Member adapters» отметьте интерфейсы, которые нужно объединить;

-

для настройки Teaming mode задайте значение LACP;

-

(опционально) с помощью настройки Load balancing mode задайте режим балансировки нагрузки на интерфейсы:

-

Dynamic (по умолчанию) — нагрузка на интерфейсы будет распределяться динамически;

-

Address hash — для каждого из интерфейсов вычисляется специальный хэш (на основании MAC или IP-адресов отправителя и получателя) и привязывается к определённому интерфейсу. Весь трафик от выбранного отправителя будет идти через этот интерфейс;

-

Hyper-V port — физический интерфейс или группа объединённых интерфейсов будет привязана к конкретному порту на виртуальном коммутаторе Hyper-V.

После настройки нажмите OK.

В результате в меню Network connections панели управления должен появиться новый интерфейс, который станет активен после настройки со стороны EdgeЦентр.

Настройка на стороне EdgeЦентр

После того, как вы настроили интерфейсы на сервере, напишите нам в поддержку — мы выполним все настройки с нашей стороны.

Прочитано: 6 355

Задача: Самостоятельно проработать, как поднять/организовать Nic Teaming средствами Windows Server 2016 в GUI составляющей. Ранее я уже делал, но использовал Windows Server 2008 R2, а тут хочу посмотреть также это все легко или есть определенные нюансы.

Итак, под Virtualbox развернута виртуальная система с осью на борту Windows Server 2016 Standard (Microsoft Windows [Version 10.0.14393]) с двумя сетевыми адаптерами.

Авторизуюсь в системе с правами, либо локального администратора, либо Администратора домена.

Win + R — cmd.exe с правами Администратора (Обязательно)

C:\Users\Администратор>netsh interface teredo set state disabled

C:\Users\Администратор>netsh interface isatap set state disabled

C:\Users\Администратор>netsh interface 6to4 set state disabled

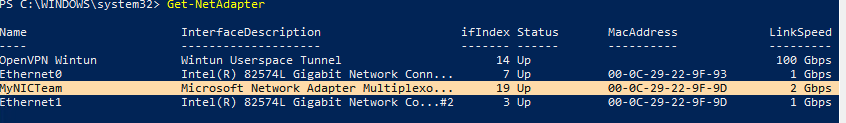

Win + R — control – Просмотр: Категория — Мелкие значки — Центр управления сетями и общим доступом и вижу, что система увидела два сетевых адаптера:

Чтобы сделать объединение сетевых интерфейсов в один для увеличения пропускной способности:

Win + R — control – Просмотр: Категория — Мелкие значки — Администрирование — Диспетчер серверов (ServerManager.exe) — Локальный сервер — по умолчанию настройка «Объединение сетевых карт» в состоянии «Отключено», щелкаю левой кнопкой мыши по настройке и перехожу в диалоговое окно «Объединение сетевых карт» (Приложение: LbfoAdmin.exe), в элементе «Группы» – «Задачи» – выбираю «Создать группу»

именую группу, к примеру:

Имя группы: nic

и отмечаю галочками сетевые интерфейсы которые буду объединять, также нужно через «Дополнительные свойства» указать режим работы объединенных интерфейсов:

- Режим поддержки групп: LACP или «Динамически» (но на коммутаторе куда подключен также нужно будет сделать объединение интерфейсов и назначить роль lacp)

- Режим балансировки нагрузки: → может принимать: Хэш адреса, Порт Hyper-V, Динамический, т. к. я не использую Hyper-V то и не указываю, а выбираю «Хэш адреса» это Вычисление хэша на основе портов позволяет распределять трафик более равномерно. Однако для трафика отличного от TCP или UDP применяется хэш на основе IP-адреса, для не IP-трафика – хэш на основе MAC-адресов.

- Резервный адаптер: выставлено и затемнено мастером “Нет (Все адаптеры активны)”. Если не указывать LACP, то можно сделать если линк на одном адаптере пропадает на его место встает другой.

Основной групповой интерфейс: nic (виртуальная локальная сеть по умолчанию)

и нажимаю кнопку «ОК»

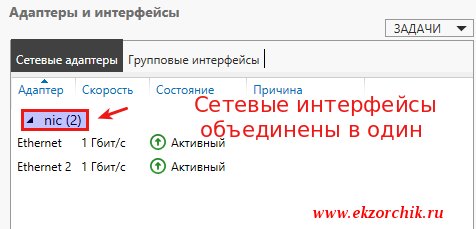

Итого объединение интерфейсов в системе сформировано:

Если переключиться в оснастку: «Центр управления сетями и общим доступом», то будет видно, что сформировался/появился новый интерфейс, где уже ему Вы задаете либо статический IP-адрес (Маска, Шлюз), либо настройками коммутатора/маршрутизатора.

В случае если линк обрывается на одном сетевом интерфейсе, доступ к системе Вы не теряете.

Если обратить внимание на свойства первого и второго сетевого адаптера, то у них выставлена всего лишь одна настройка «Протокол мультиплексора сетевого адаптера», а у нового с именем группы nic:

- Клиент для сетей Microsoft

- Общий доступ к файлам и принтерам

- Планировщик пакетов QoS

- Microsoft Load Balancing/Failower Provider

- IP версии 4 (TCP/IPv4)

- IP версии 6 (TCP/IPv6) — снимаю галочку, так как не использую во всей сети.

- Отвечающее устройство обнаружение топологии (делает компьютер видимым в сети)

Ответчик обнаружения топологии канального уровня (используется для обнаружения других компьютеров, устройств и компонентов в сети).

Смотрю текущие настройки сети от DHCP–сервиса в локальной сети:

Win + R — cmd.exe с правами Администратора (Обязательно)

C:\Users\Администратор>ipconfig

Настройка протокола IP для Windows

Адаптер Ethernet nic:

DNS-суффикс подключения . . . . . :

IPv4-адрес. . . . . . . . . . . . : 172.40.40.6

Маска подсети . . . . . . . . . . : 255.255.255.0

Основной шлюз. . . . . . . . . : 172.40.40.1

Как видно, сетевой адрес получает лишь общий интерфейс, а не вспомогательные.

На заметку: Если Ваши наблюдения показываю, что объединение интерфейсов требуют изменения, то все также через оснастку «Объединения сетевых карт» можно поменять настройки. Вот только желательно это делать имея к системе еще один вид подключения, к примеру консоль Hyper-V, vSphere Client, iDRAC, IPMI и т. д. Чтобы если что не остаться у разбитого корыта и подстраховаться.

На заметку: Если физическое железо может на уровне железа объединять интерфейсы или использует специализированное программное обеспечение, то лучше делать через него, чем средствами Windows, а если не хочется от него зависить, то средствами операционной системы и не важно Windows это или Linux.

Вот на этом я прощаюсь, как я мог убедиться нет ничего сложно в настройке объединения сетевых карт в системе Windows Server 2016. Если у меня буду какие-либо дополнения и наблюдения, то я постараюсь отразить их в этой заметке. А пока у меня всё, с уважением автор блога Олло Александр aka ekzorchik.