11.12.22

Содержание:

- Отказоустойчивый кластер Windows Server 2019

- Преимущества и особенности отказоустойчивого кластера

- Необходимое оборудование и требования к системе

- Шаги по установке и настройке кластера

- Настройка сети и хранения данных

- Тестирование и мониторинг кластера

- Рекомендации по поддержке и обновлению кластера

- Вопрос-ответ

В современном мире, где информационные технологии играют ключевую роль, обеспечение бесперебойной работы систем становится все более актуальным. Для крупных организаций и предприятий крайне важно минимизировать риски, связанные с отказами и сбоями оборудования. Это особенно актуально в условиях высокой конкуренции и необходимости круглосуточного предоставления услуг.

В данной статье мы рассмотрим, как построить устойчивую к сбоям архитектуру с помощью инструментов и технологий Microsoft. Особое внимание будет уделено возможностям, представленным в последней версии серверного программного обеспечения, выпущенной в 2018 году. Вы узнаете, как правильно организовать работу нескольких узлов для обеспечения непрерывности бизнеса и защиты данных.

Процесс создания такой системы требует тщательного планирования и понимания всех этапов внедрения. Мы обсудим ключевые шаги, начиная от первоначальной настройки и заканчивая мониторингом и управлением уже функционирующей структуры. Также рассмотрим преимущества и особенности использования новых функций и улучшений, представленных в этом программном решении.

Присоединяйтесь к нам в этом увлекательном путешествии по миру надежных и высокопроизводительных вычислительных систем. Узнайте, как новейшие разработки от Microsoft могут помочь вашему бизнесу оставаться на высоте, обеспечивая стабильную и эффективную работу всех критически важных приложений и сервисов.

Отказоустойчивый кластер Windows Server 2019

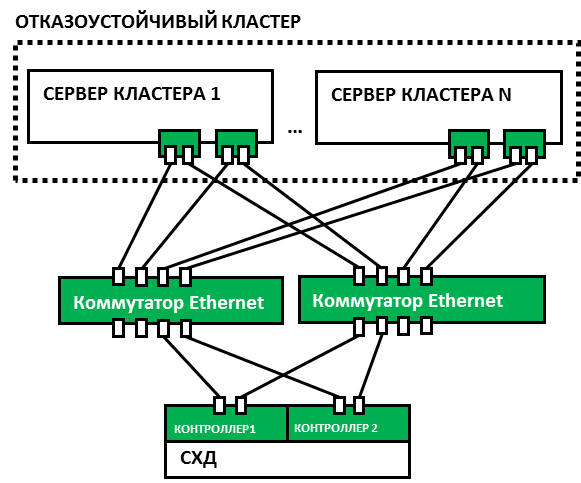

Использование данной технологии позволяет объединить несколько физических машин в единую систему, которая продолжает функционировать даже при выходе из строя отдельных компонентов. Это решение подходит как для крупных компаний, так и для средних предприятий, стремящихся обеспечить высокую доступность своих сервисов и приложений. Развертывание такого комплекса требует определенных знаний и навыков, о которых мы подробно расскажем ниже.

|

Преимущества |

Описание |

|

Высокая надежность |

Системы продолжают работать даже при отказе одного из узлов, обеспечивая минимальное время простоя. |

|

Гибкость |

Легкость в масштабировании и управлении ресурсами, что позволяет адаптировать систему под изменяющиеся потребности бизнеса. |

|

Централизованное управление |

Упрощение административных задач благодаря единой консоли управления и интеграции с другими продуктами Microsoft. |

|

Экономия ресурсов |

Эффективное использование оборудования и снижение затрат на обслуживание благодаря оптимизации ресурсов. |

Далее мы более подробно остановимся на этапах настройки и требованиях к аппаратному и программному обеспечению, необходимых для создания устойчивой к сбоям инфраструктуры. Понимание этих аспектов поможет вам эффективно использовать возможности новой операционной системы, обеспечивая бесперебойную работу ваших критически важных сервисов.

Преимущества и особенности отказоустойчивого кластера

Основные достоинства внедрения таких решений включают:

|

Преимущество |

Описание |

|

Повышенная доступность |

Группировка ресурсов позволяет значительно снизить время простоя и повысить общую производительность систем. |

|

Легкость управления |

Использование централизованных инструментов администрирования упрощает управление и мониторинг состояния компонентов. |

|

Масштабируемость |

Возможность добавления новых узлов без значительных затрат времени и ресурсов обеспечивает гибкость и рост инфраструктуры в зависимости от потребностей. |

|

Безопасность данных |

Механизмы репликации и синхронизации данных помогают защитить информацию от потерь при сбоях и других непредвиденных ситуациях. |

Особенности таких конфигураций включают:

|

Особенность |

Описание |

|

Резервирование |

Использование дублирующих компонентов, которые могут автоматически заменять вышедшие из строя узлы, обеспечивает непрерывность работы. |

|

Автоматическое восстановление |

Системы способны самостоятельно обнаруживать и устранять неисправности, что снижает необходимость вмешательства администратора. |

|

Гибкость конфигурации |

Поддержка различных сценариев развертывания и настройки позволяет адаптировать решения под специфические требования организации. |

|

Интеграция с другими технологиями |

Поддержка работы с различными системами и приложениями упрощает интеграцию и расширение функциональности. |

Таким образом, создание и использование современных решений для управления ресурсами позволяет обеспечить высокую надежность, производительность и гибкость IT-инфраструктуры, что особенно актуально в условиях постоянно растущих требований к качеству и непрерывности предоставляемых услуг.

Необходимое оборудование и требования к системе

Для создания надежной и эффективной IT-инфраструктуры важно правильно подобрать оборудование и учесть все системные требования. Это поможет обеспечить стабильную работу и максимальную производительность вашей системы. В данном разделе рассмотрим основные компоненты и параметры, которые необходимо учитывать при проектировании и развертывании вашей сети.

Основные элементы, которые понадобятся для организации такой инфраструктуры, включают в себя: высокопроизводительные серверы, системы хранения данных, сетевое оборудование и программное обеспечение. Каждое из этих устройств должно соответствовать определенным стандартам и требованиям, чтобы обеспечить корректное функционирование и интеграцию в общую структуру.

|

Компонент |

Требования |

|

Серверы |

Процессоры с высокой тактовой частотой, не менее 64 ГБ оперативной памяти, поддержка технологий виртуализации |

|

Системы хранения |

Высокоскоростные диски SSD, RAID-массивы для обеспечения безопасности данных, ёмкость от 1 ТБ и выше |

|

Сетевое оборудование |

Коммутаторы с поддержкой высоких скоростей передачи данных, резервные каналы связи, поддержка VLAN |

|

Программное обеспечение |

Лицензии на операционные системы и средства управления, актуальные версии ПО для мониторинга и администрирования |

Помимо технических характеристик, важным аспектом является совместимость оборудования между собой, а также с используемыми программными решениями. Правильная настройка и оптимизация всех компонентов позволит добиться высокой производительности и бесперебойной работы вашего IT-ландшафта.

Шаги по установке и настройке кластера

- Подготовка окружения:

- Убедитесь, что все серверы имеют необходимые обновления и патчи.

- Проверьте совместимость оборудования и программного обеспечения.

- Настройте сеть, обеспечив стабильное и быстрое соединение между всеми узлами.

- Настройка хранилища:

- Создайте общий пул дисков для хранения данных.

- Настройте резервирование данных для повышения надежности.

- Установка компонентов:

- Установите необходимые роли и функции на каждом узле.

- Настройте службы и приложения, которые будут обеспечивать работу инфраструктуры.

- Конфигурация сети:

- Настройте виртуальные коммутаторы для оптимизации трафика.

- Обеспечьте резервирование сетевых подключений для повышения отказоустойчивости.

- Создание и настройка кластера:

- Объедините серверы в единый комплекс, используя специализированные инструменты.

- Настройте мониторинг и управление, чтобы обеспечить контроль над работой всей системы.

- Проверка и тестирование:

- Проведите тесты на отказоустойчивость, имитируя различные сбои и проверяя реакцию системы.

- Убедитесь в правильной работе всех компонентов и устраните выявленные проблемы.

Следуя этим шагам, вы сможете создать надежную и стабильную серверную инфраструктуру, обеспечивающую непрерывную работу ваших критически важных приложений и сервисов.

Настройка сети и хранения данных

В данном разделе рассмотрим ключевые аспекты, связанные с конфигурацией сетевой инфраструктуры и системы хранения для обеспечения непрерывности работы. Эти элементы играют важную роль в поддержке стабильности и доступности всех ресурсов, а также в минимизации простоев.

Настройка сетевой инфраструктуры

Эффективная сетевая настройка включает в себя несколько важных шагов, которые обеспечивают бесперебойное взаимодействие между узлами и доступ к ресурсам. Рассмотрим основные этапы:

- Выбор сетевых адаптеров: Использование надежных и производительных сетевых карт, обеспечивающих высокую скорость передачи данных и низкую задержку.

- Разделение сетевых трафиков: Настройка отдельных сетевых каналов для различных типов данных, таких как трафик управления, данные приложений и синхронизация данных.

- Настройка VLAN: Виртуальные локальные сети позволяют сегментировать сеть, увеличивая её безопасность и управляемость.

- Использование LACP: Протокол агрегации каналов позволяет объединять несколько сетевых подключений для увеличения пропускной способности и обеспечения резервирования.

- Мониторинг и диагностика: Постоянный мониторинг состояния сетевых подключений и использование инструментов для диагностики проблем помогают быстро выявлять и устранять неполадки.

Организация системы хранения данных

Правильная настройка системы хранения данных обеспечивает высокую доступность и целостность информации. Рассмотрим основные моменты:

- Выбор хранилища: использование надежных и производительных систем хранения, таких как SAN (Storage Area Network) или NAS (Network Attached Storage), в зависимости от потребностей.

- Настройка RAID: использование различных уровней RAID для обеспечения избыточности и повышения производительности хранилища.

- Репликация данных: настройка репликации данных между узлами для обеспечения их доступности в случае сбоя одного из них.

- Резервное копирование: регулярное создание резервных копий данных и проверка их целостности для быстрого восстановления в случае необходимости.

Следуя данным рекомендациям, можно значительно повысить стабильность и доступность системы, минимизировать время простоя и обеспечить надежное хранение всех необходимых данных.

Тестирование и мониторинг кластера

Основные этапы тестирования

Для обеспечения корректной работы необходимо проводить регулярные тесты. Эти проверки позволяют выявить слабые места и убедиться в готовности системы к нагрузкам. Вот основные шаги:

- Подготовка тестовой среды. Создайте изолированное окружение, максимально приближенное к рабочему.

- Проведение стресс-тестов. Оцените, как система справляется с пиковыми нагрузками.

- Тестирование отказов. Проверьте, как система реагирует на различные сбои, включая отключение отдельных узлов.

- Восстановление данных. Убедитесь, что механизмы резервного копирования и восстановления работают корректно.

- Анализ результатов. Соберите и проанализируйте данные, чтобы выявить потенциальные проблемы и возможности для улучшения.

Инструменты для мониторинга

Для эффективного наблюдения за состоянием вашего кластера существует множество инструментов. Эти программы помогают в реальном времени отслеживать производительность и выявлять аномалии. Рассмотрим основные из них:

- Performance Monitor (PerfMon)– стандартный инструмент для отслеживания производительности. Позволяет мониторить ключевые показатели, такие как использование ЦП, оперативной памяти и дисковой подсистемы.

- System Center Operations Manager (SCOM) – мощное средство для мониторинга и управления, которое предоставляет подробные отчеты и уведомления о состоянии системы.

- Event Viewer– средство для анализа системных журналов. Помогает отслеживать и анализировать события, которые могут указывать на проблемы в работе системы.

- Windows Admin Center – интегрированная платформа для управления и мониторинга, которая позволяет контролировать состояние системы через удобный веб-интерфейс.

Практические советы по мониторингу

Чтобы обеспечить максимальную эффективность мониторинга, следуйте следующим рекомендациям:

- Настройте оповещения для критических событий, чтобы оперативно реагировать на проблемы.

- Регулярно анализируйте данные мониторинга для выявления тенденций и потенциальных узких мест.

- Используйте различные инструменты в комплексе, чтобы получить максимально полную картину состояния вашей системы.

- Обучите персонал работе с инструментами мониторинга, чтобы все члены команды могли оперативно реагировать на возникающие проблемы.

- Документируйте все процедуры и результаты тестирования и мониторинга для дальнейшего анализа и улучшения процессов.

Эффективное тестирование и мониторинг являются важными аспектами поддержания работоспособности вашего кластера. Своевременное выявление и устранение проблем поможет обеспечить стабильную и надежную работу всех системных компонентов.

Рекомендации по поддержке и обновлению кластера

Организация системы резервного копирования и восстановления – один из краеугольных камней поддержки кластера. Важно иметь надёжные механизмы создания резервных копий данных, а также проводить регулярные проверки и испытания процедур восстановления. Это обеспечит не только защиту от потери данных, но и минимальное время восстановления после возможного сбоя.

Обновление программного обеспечения – непременная часть поддержки кластера. Регулярные обновления операционной системы и прикладных программ помогут не только исправить уязвимости безопасности, но и повысят производительность и стабильность работы системы. Важно следить за релизами обновлений и вовремя их устанавливать, при этом учитывая возможные совместимости и зависимости между компонентами кластера.

Мониторинг и анализ состояния системы – ключевой элемент обновления и поддержки кластера. Важно иметь систему мониторинга, способную оперативно обнаруживать и реагировать на возможные проблемы в работе системы. Анализ данных, собранных в процессе мониторинга, позволит выявить узкие места и проблемные зоны, а также оптимизировать процессы поддержки и обновления кластера.

Вопрос-ответ

Какие преимущества предоставляет отказоустойчивый кластер Windows Server 2019?

Отказоустойчивый кластер Windows Server 2019 обеспечивает повышенную надежность и доступность вашего приложения или сервиса. Это достигается за счет автоматического переноса нагрузки с вышедшего из строя узла на работоспособные, что минимизирует простои и обеспечивает бесперебойную работу.

Как создать отказоустойчивый кластер на базе Windows Server 2019?

Для создания отказоустойчивого кластера на базе Windows Server 2019 необходимо выполнить ряд шагов. Во-первых, убедитесь, что серверы, которые вы планируете использовать в качестве узлов кластера, соответствуют требованиям по аппаратным характеристикам. Затем установите роли Failover Clustering и Hyper-V (если необходимо) на каждом узле. После этого используйте мастер создания кластера для настройки кластера и добавления узлов в него.

Какие компоненты необходимы для создания отказоустойчивого кластера Windows Server 2019?

Для создания отказоустойчивого кластера на базе Windows Server 2019 необходимо наличие нескольких компонентов. Это включает в себя несколько физических или виртуальных серверов, которые будут работать в качестве узлов кластера. Также потребуются диски для хранения данных, сеть с низкой задержкой и достаточной пропускной способностью для обмена данными между узлами, и конечно же, лицензии на Windows Server 2019 для каждого узла кластера.

Какие методы обеспечения отказоустойчивости используются в кластере Windows Server 2019?

В кластере Windows Server 2019 используются различные методы обеспечения отказоустойчивости. Один из основных методов – механизм автоматического переключения ресурсов с вышедшего из строя узла на работающий узел. Это может быть достигнуто с помощью технологии Failover Clustering, которая обеспечивает мониторинг состояния узлов и автоматический перенос служб или приложений в случае сбоя. Кроме того, используются дублированные и резервные компоненты, репликация данных и резервные источники питания для обеспечения непрерывной работы кластера.

Какие лучшие практики рекомендуется следовать при создании отказоустойчивого кластера Windows Server 2019?

При создании отказоустойчивого кластера Windows Server 2019 важно придерживаться нескольких лучших практик. Во-первых, перед началом установки убедитесь, что все узлы кластера находятся в сети одного домена Active Directory. Также рекомендуется использовать выделенные сетевые адаптеры для кластерной связи и управления. Важно также настроить правильную конфигурацию брандмауэра для обеспечения связности между узлами кластера. И, конечно, регулярно выполняйте обновления и резервное копирование конфигурации кластера для предотвращения потери данных и обеспечения безопасности.

Каковы основные преимущества отказоустойчивого кластера на Windows Server 2019?

Отказоустойчивый кластер на Windows Server 2019 предоставляет ряд значительных преимуществ, таких как непрерывная доступность сервисов и данных благодаря автоматическому переключению на резервные узлы в случае отказа основного, а также увеличение производительности и масштабируемости за счет распределения нагрузки между узлами кластера.

Читайте также:

- Создание отказоустойчивого кластера в 1С:Предприятие

- Отказоустойчивый кластер Windows для повышения надежности систем

- Как построить отказоустойчивый кластер для максимальной надежности

- Отказоустойчивый кластер Hyper V для повышения надежности систем

- Создание отказоустойчивого кластера MS SQL для обеспечения надежности и доступности данных

- Файловый отказоустойчивый кластер для повышения надежности и доступности данных

- Отказоустойчивые системы: ключевой элемент безопасности и надежности

- Currently 5/5

- 1

- 2

- 3

- 4

- 5

Оценка: 5/5 (Проголосовало: 2)

Спасибо за ваш отзыв!

Как можно улучшить эту статью?

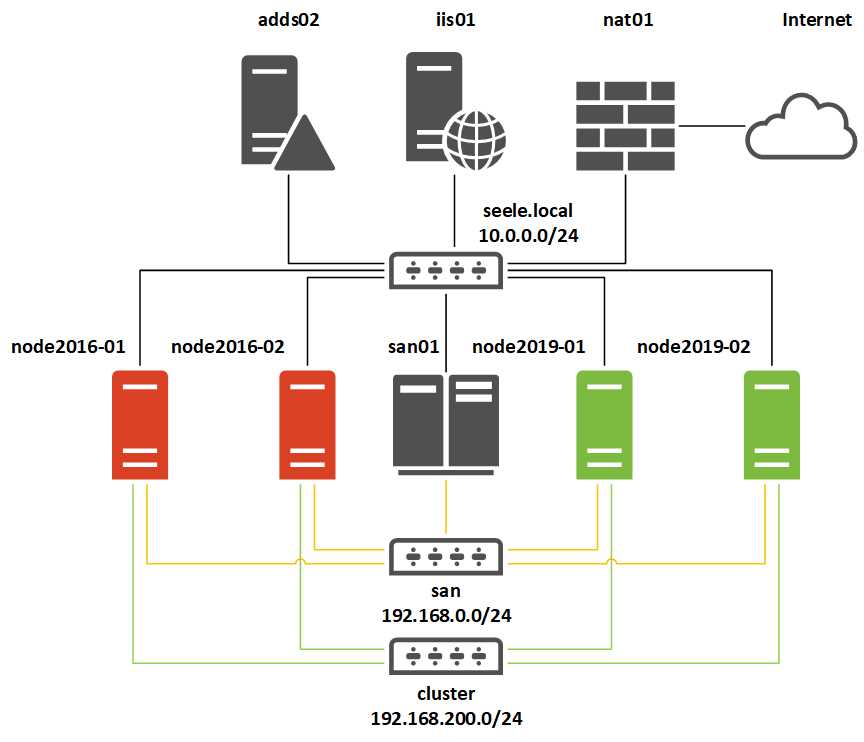

Данная статья подойдёт для новичков, которые хотят потренироваться в настройке кластера Hyper-V 2019. Итак, имеется:

— Тестовый комп1 «железный»

— Тестовый комп2 «железный»

— Тестовый комп3 «виртуальный» с Windows srv 2019 и настроенной ролью контроллера домена.

— Тестовый комп4 «железный» с расшаренным диском по протоколу iSCSI.

— Всё это соединено через обычный пассивный коммутатор.

На тестовый комп1 установлена Windows Srv 2019 Standard Evaluation с графической оболочкой. На тестовый комп2 установлена Microsoft Hyper-V Server 2019 — данная ОС бесплатна и устанавливается как обычная Windows 10/2019. Скачать эту ОС можно с оф.сайта Microsoft:

https://www.microsoft.com/ru-ru/evalcenter/evaluate-hyper-v-server-2019

Собственно, на этой же странице можно скачать и Windows Srv 2019 Standard Evaluation. И если, после установки Windows Srv 2019 с графической оболочкой, вопросов о том, как ей пользоваться дальше, нету, то после установки Hyper-V Server 2019 могут возникнуть вопросы, что с этой ОС делать дальше. Ведь у Hyper-V Server 2019 графической оболочки нет. После установки есть лишь вот такое окно:

Здесь можно сделать самые основные настройки: задать имя компьютера, прописать статический IP, включить доступ по RDP.

Для дальнейшего удобства администрирования данной ОС, я установлю пару инструментов. Первый из них — это банальный Total Commander portable, который я просто скопирую на диск C: с флэшки. Сделать это можно командой:

xcopy f:\totalcmd c:\totalcmd\ /y /e

Где f:\totalcmd — это каталог с total командером на флэшке, а c:\totalcmd\ — каталог, в который копирую.

Потом перехожу в этот каталог и запускаю тотал командер:

c:

cd c:\totalcmd

totalcmd.exe

Дальше уже будет проще. Пользуясь тотал командером, нахожу каталог с драйверами и устанавливаю их.

Следующий инструмент, который облегчит администрирование Hyper-V Server 2019 — это WINDOWS ADMIN CENTER. Это вэб-админка от Microsoft, с помощью которой можно администрировать сервер через вэб-интерфейс. Некий аналог Webmin, но для Windows-систем. Скачать его можно на той же странице, где скачивались установочные образы операционных систем:

https://www.microsoft.com/ru-ru/evalcenter/evaluate-windows-admin-center

Дистрибутив Windows админ центра можно тоже перенести через флэшку на сервер.

Установка данного программного обеспечения самая обычная, где все параметры можно оставить по умолчанию.

После установки Windows админ центра нужно зайти на сервер через обычный браузер по https протоколу:

https://192.168.0.206/

Сообщение безопасности нужно игнорировать, т.к. используется самоподписанный сертификат. Логин и пароль при подключении — это виндовый «администратор» с его паролем в самой ОС. Вот так выглядит Windows Admin Центр:

В списке серверов выбираю свой, который также стал шлюзом Windows AdminЦентра. Ну и подробно на всех возможностях останавливаться не буду, т.к. их много. Вэб-интерфейс хоть и тормозной, но довольно функциональный — через него можно будет управлять и виртуальными машинами в том числе. Или, например, если какие-то драйвера не установлены, то их можно доустановить уже через Windows AdminЦентр:

Я же пробую ввести данный сервер в домен. Жму на меню «Обзор» и затем на «Изменить идентификатор компьютера».

Ну а дальше, всё как обычно:

Сервер перезагрузится. После чего, в Windows Admin Центр рекомендуется войти уже под доменным администратором! Имя пользователя надо вводить в таком формате:

Ну и кстати, желательно бы установить обновления для Windows Admin Центра, если они есть. Для этого надо нажать на шестерёнку и выбрать пункт «расширения». Ну и там дальше всё понятно будет:

Разобравшись с сервером на ОС Hyper-V Server 2019, сделаю всё то же самое и на сервере под управлением Windows Srv 2019 Standard Evaluation. Там уже всё делается в привычном виде — через графическую оболочку Windows. Установил драйверы, ввел сервер в домен AD — подробности этого всего описывать не буду.

Следующим шагом будет подключение сетевого диска iSCSI. Захожу в «Средства администрирования»:

И там выбираю Инициатор iSCSI:

При первом запуске выйдет сообщение о том, что служба iSCSI не запущена, и будет предложено запустить эту службу и включить её автозапуск при старте сервера. Ну а потом появится окно, в котором надо будет перейти на вкладку «Обнаружение» и нажать на кнопку «Обнаружить портал»:

Затем надо ввести IP-адрес сервера iSCSI:

В моём случае, этого будет достаточно. Но если iSCSI сервер требует пароль для подключения к себе, то надо нажать кнопку «Дополнительно» и там ввести этот пароль.

Далее, надо перейти на вкладку «Конечные объекты» и нажать кнопку «Подключить»:

В появившемся окне надо нажать на «ОК», после чего диск перейдёт в состояние «Подключено»:

Всё, это окно можно закрывать. Дальше надо зайти в диспетчер управления дисками, в котором отобразится подключенный iSCSI диск. Его надо проинициализировать и отформатировать в NTFS:

Сильно подробно это не буду расписывать. Уверен, что форматировать диск под NTFS умеют все ИТ-специалисты. После форматирования можно попробовать что-нибудь записать на него, чтобы убедиться в работоспособности диска.

Далее, этот же диск надо подключить на втором сервере под управлением Hyper-V Server 2019. На самом деле, там это всё делается точно также. Надо лишь в командной строке ввести:

iscsicpl

Появится точно такое же окно, как и на сервере с графической оболочкой:

Нужно проделать те же действия, что и на первом сервере. Но в диспетчер дисков заходить уже не нужно. Достаточно просто подключить диск по iSCSI.

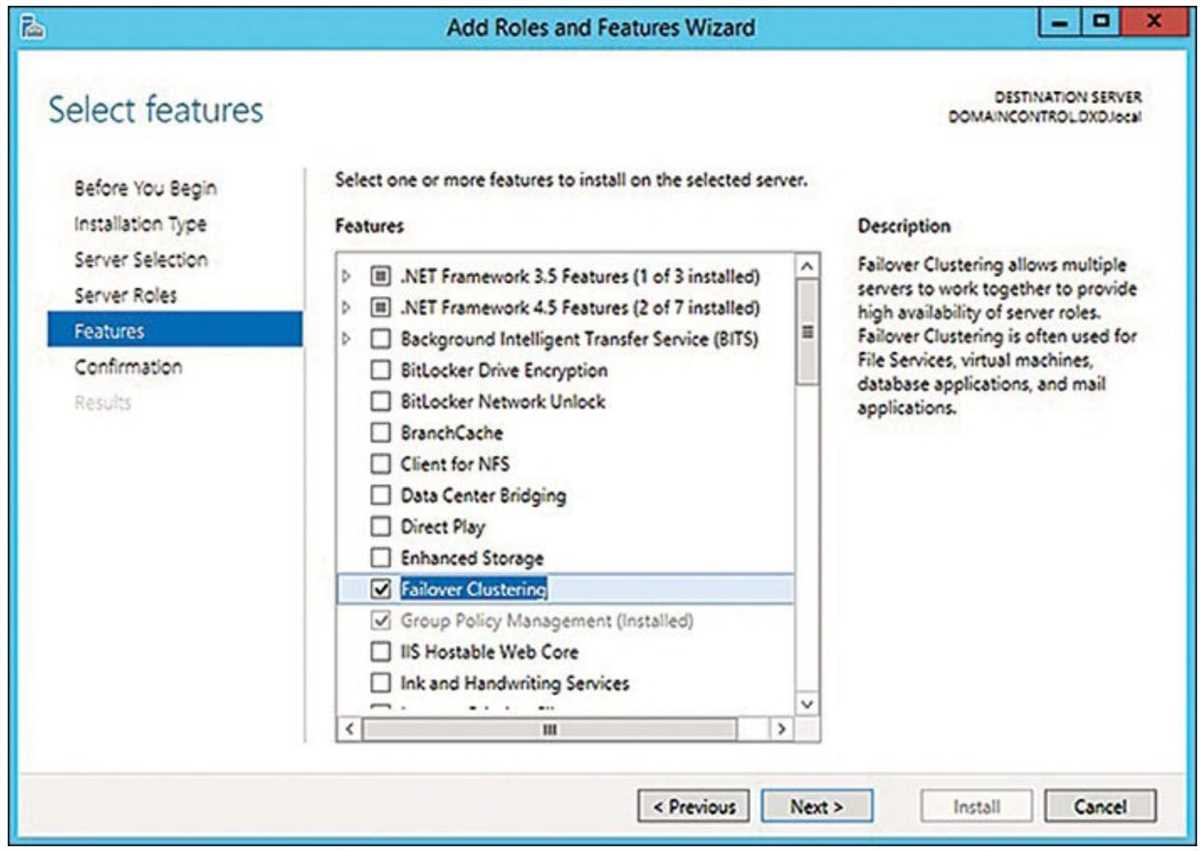

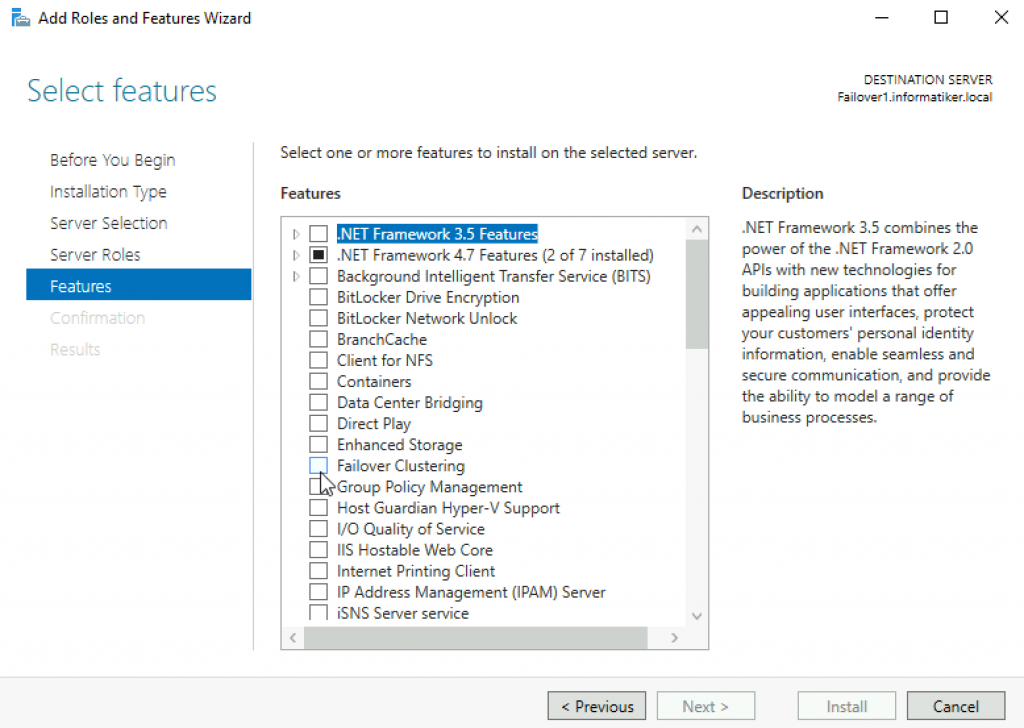

Теперь снова перехожу к серверу под управлением Windows Srv 2019 Standard Evaluation, на котором нужно установить роль Hyper-V, а также роль Кластера. В диспетчере сервером жму «Добавить роли и компоненты»:

В первом шаге жму «далее», потом снова «далее», оставив на месте крыжик «Установка ролей или компонентов». Выбираю в списке свой сервер, который там пока один, жму «далее»:

Ставлю галку на Hyper-V и соглашаюсь с добавлением остальных компонентов по зависимостям:

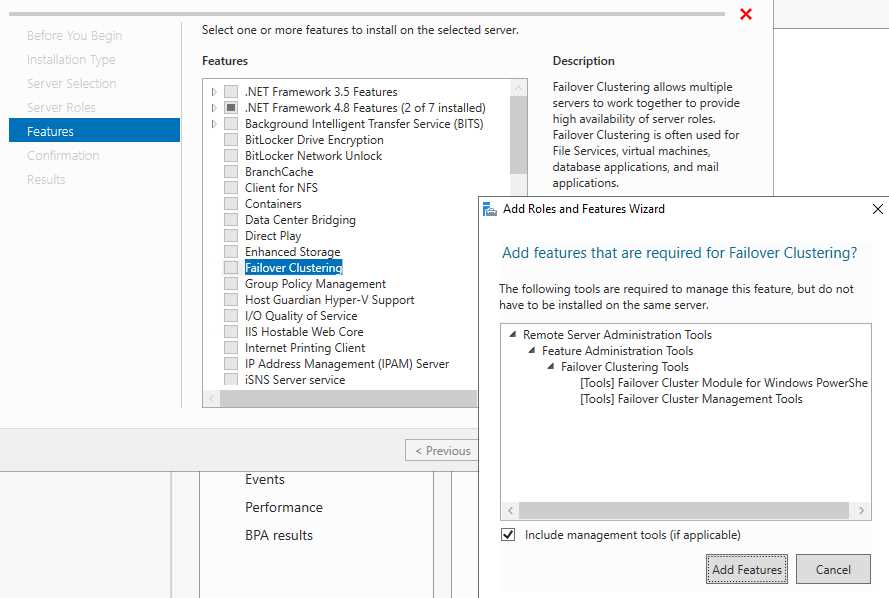

Жму «далее». На следующем шаге, где уже предлагается выбрать компоненты, ставлю галку на «Отказоустойчивой кластеризации» и соглашаюсь с добавлением остальных компонентов по зависимостям:

Жму кнопку «Далее». На следующем шаге предлагается сразу создать виртуальный коммутатор, но я пока не буду. Создам его потом вручную. Просто жму «Далее».

На следующем шаге предлагается включить и выбрать протокол для динамической миграции. Однако внизу есть предупреждение, что если данный сервер будет членом кластера, то этого делать на надо. Поэтому ничего не трогаю и жму «далее».

Расположение по умолчанию дисков и конфигурации виртуальных машин тоже пока не трогаю. Эти значения надо менять уже после настройки кластера. Жму «далее», а затем «установить». Дожидаюсь окончания установки.

Теперь кое-какие компоненты надо установить на машине с Hyper-V Server 2019. Для этого открываю диспетчер серверов на машине с Windows Srv 2019 Standard Evaluation и жму «Добавить другие серверы для управления»:

В поле «Имя» ввожу имя компьютера машины Hyper-V Server 2019, жму «найти» и потом добавляю его в правый список. Жму «ОК»:

Потом жму «Добавить роли и компоненты» и на шаге, где предлагается выбрать сервер, выбираю машину с Hyper-V Server 2019:

На шаге с выбором ролей сервера ничего не трогаю и жму «далее». А вот на шаге выбора компонентов добавляю «Отказоустойчивую кластеризацию» и соглашаюсь с добавлением остальных компонентов по зависимостям:

Жму «далее» и «установить», дожидаюсь окончания установки.

Теперь надо создать кластер. На машине Windows Srv 2019 Standard Evaluation захожу в «средства администрирования» и выбираю «Диспетчер отказоустойчивости кластеров»:

В открывшемся окне жму «Создать кластер».

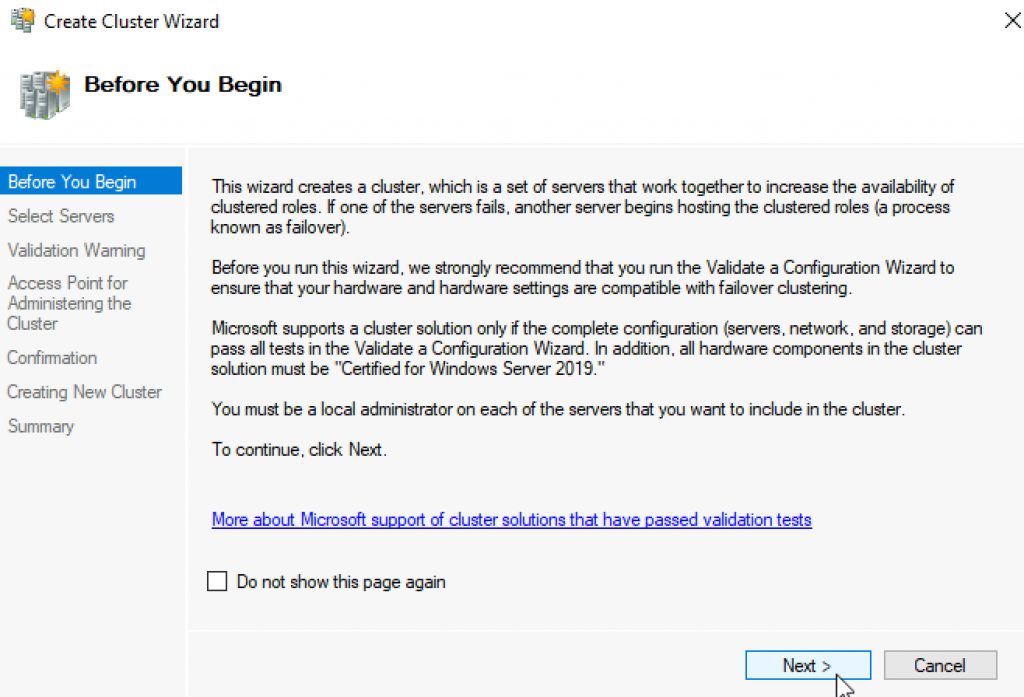

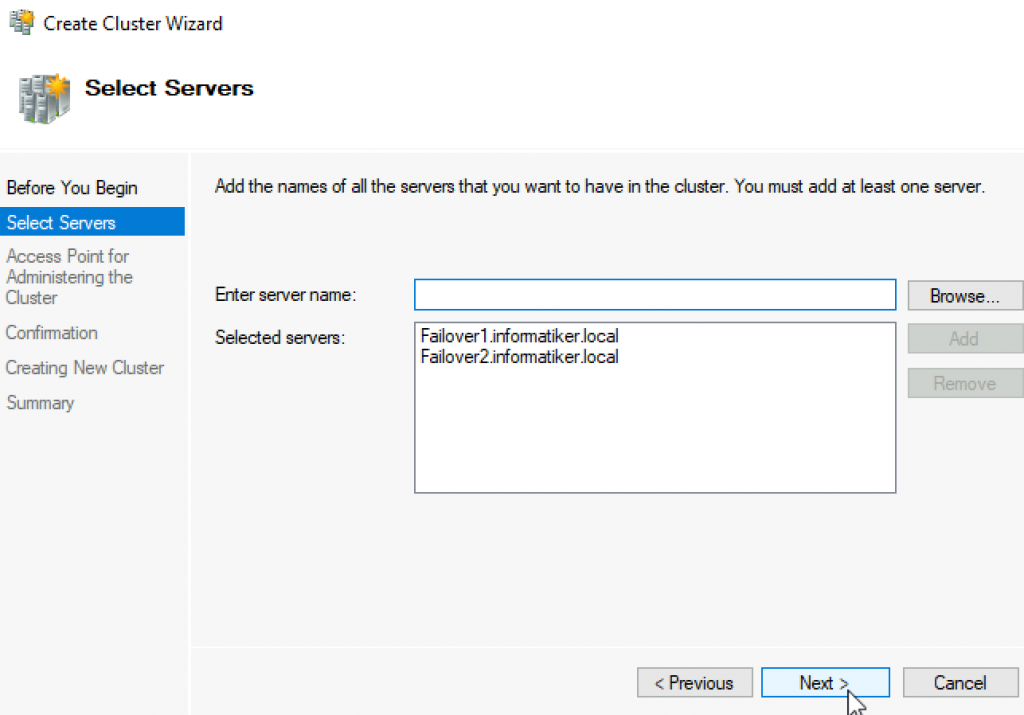

На первом шаге «Перед началом работы» жму «далее». А на следующем шаге выбираю, какие серверы будут членами кластера:

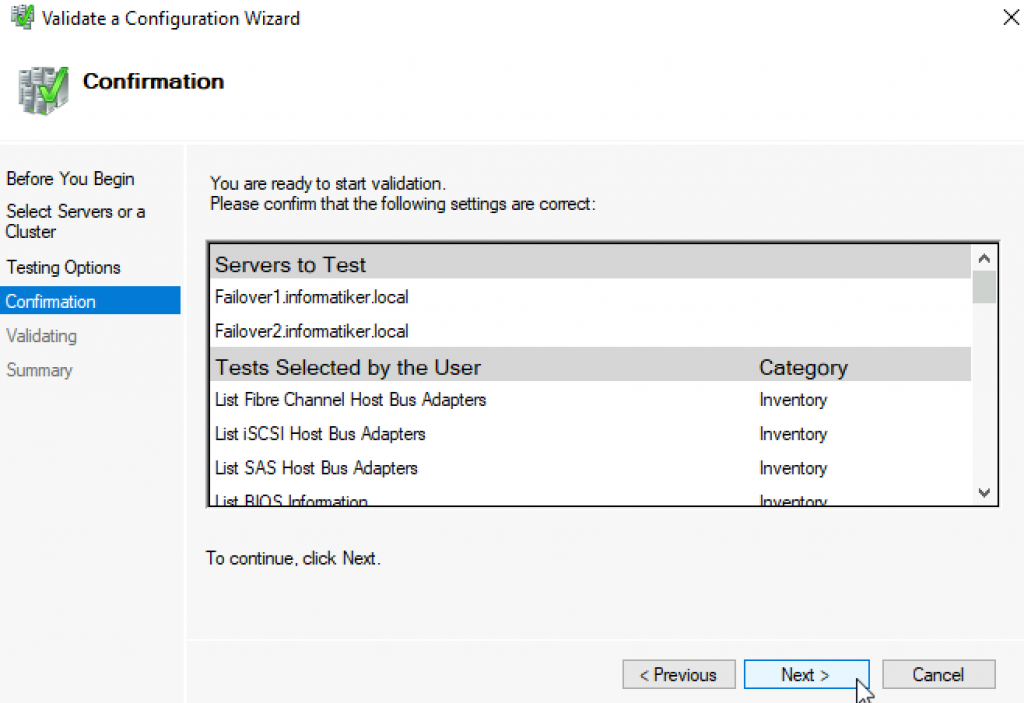

На следующем шаге предлагается выполнить проверочные тесты для выбранных серверов. Пусть выполнит. Оставляю «да» и жму «далее».

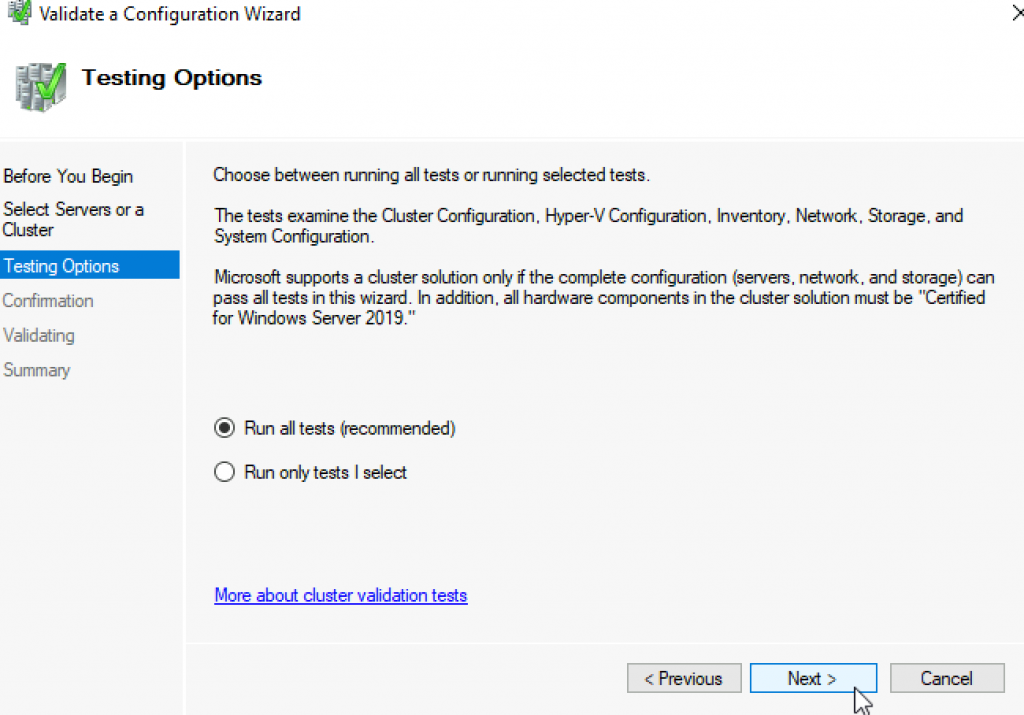

Откроется дополнительный мастер с вопросом, какие тесты выполнить. Оставляю «Выполнить все тесты» и жму «далее».

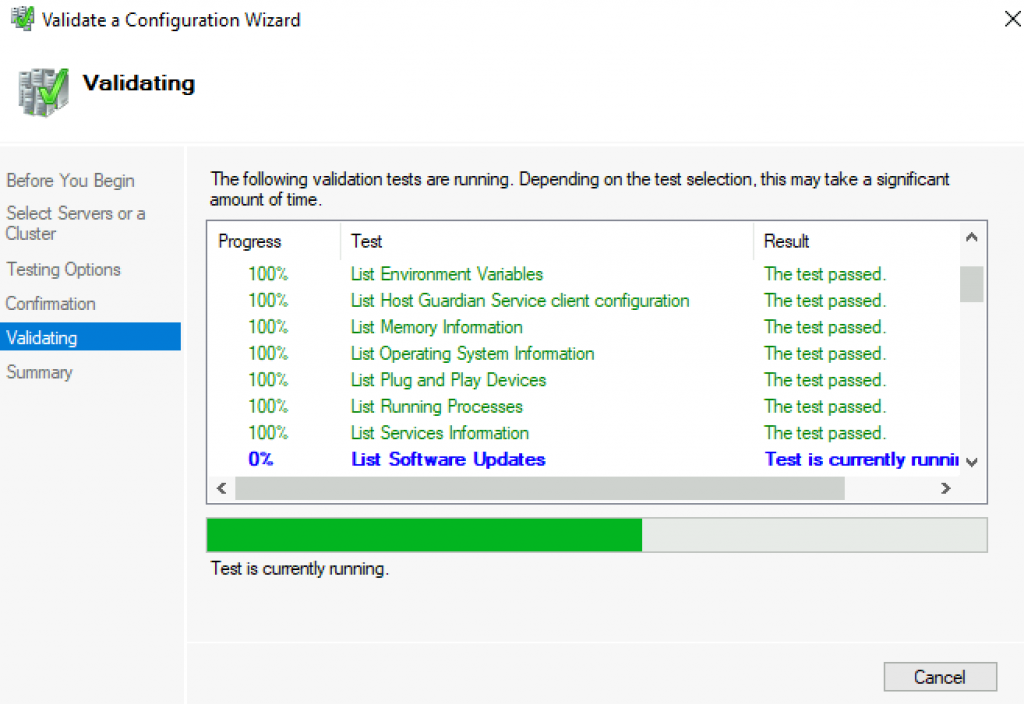

Запускается тестирование, жду его окончания:

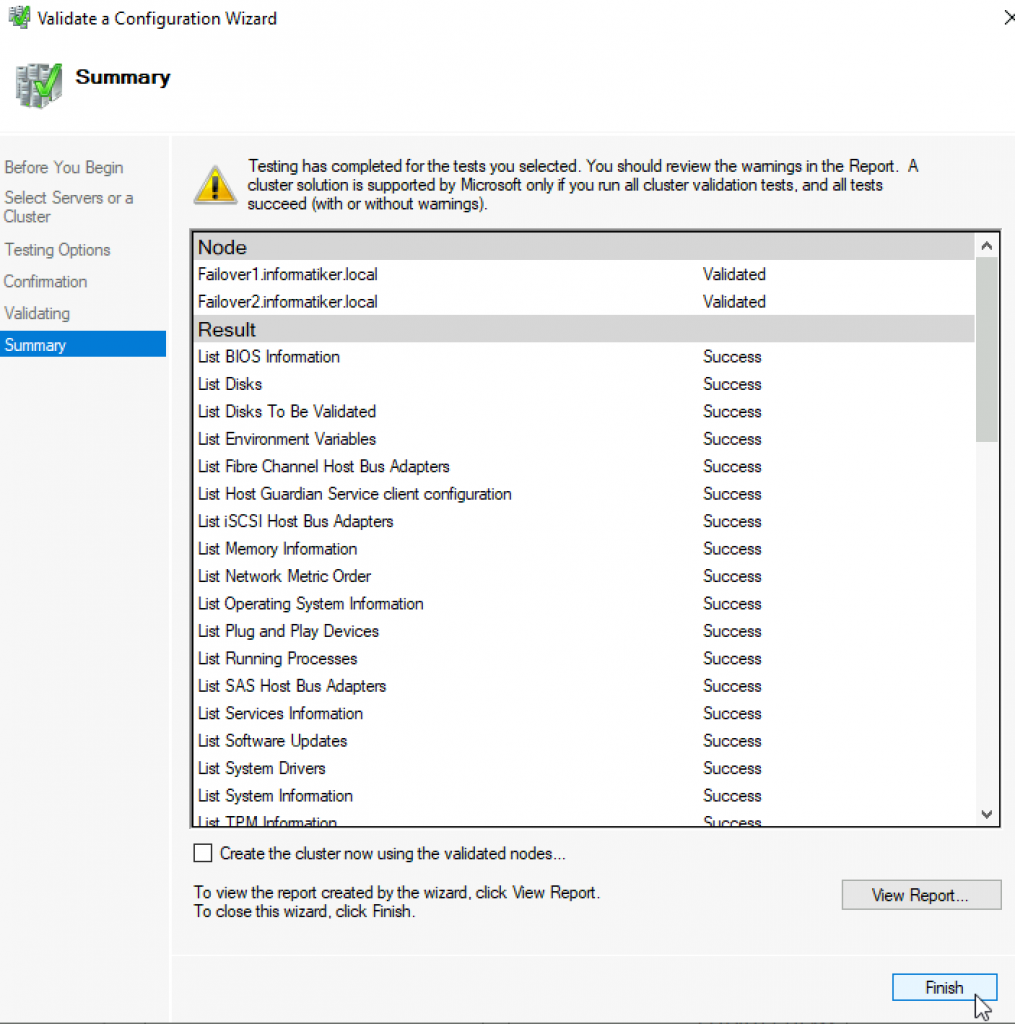

У меня тестирование нашло ошибки, которые я и предполагал, что будут:

Да, действительно, у меня тестовые компы на разных процессорах. Один на Intel Xeon 2620 v3, а второй на AMD FX 8350. Но других компов у меня нет, да и это лишь тестовая установка. Сеть у меня тоже одна, хотя рекомендуется иметь выделенную сеть для соединения с дисками iSCSI. Ну и разные версии операционных систем я выбрал нарочно — хочу посмотреть, как оно будет работать именно в таком варианте. Повторюсь, что установка тестовая, в домашних условиях и лишь для ознакомления. Для продакшена надо делать следуя рекомендациям Microsoft.

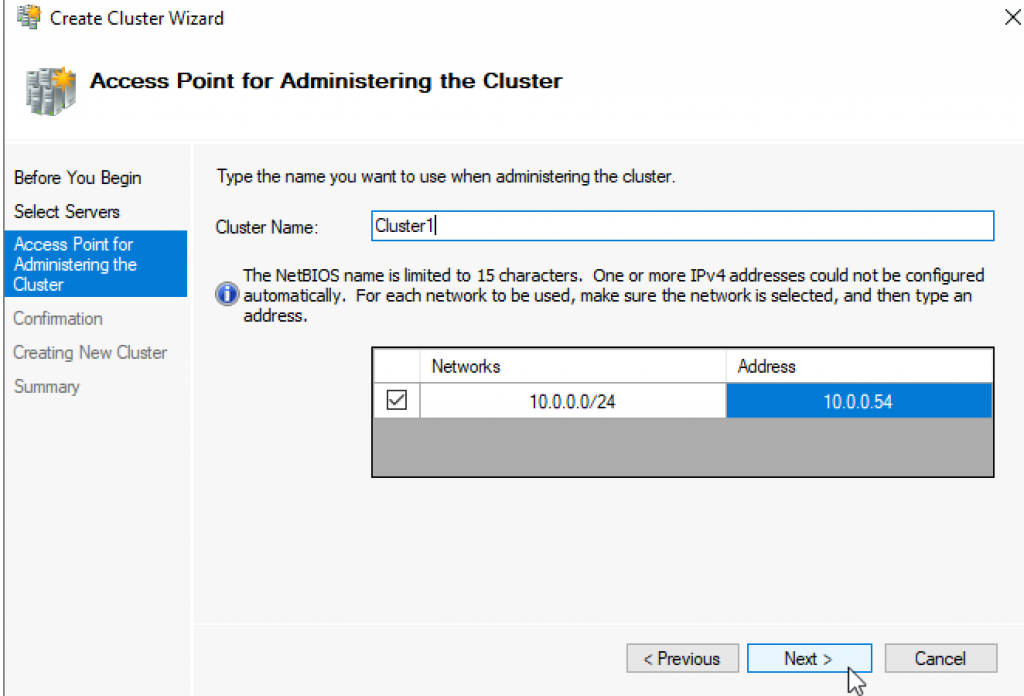

После тестов появляется следующий шаг, на котором надо задать имя кластера и указать его IP-адрес:

Жму «далее». Здесь тоже жму «далее»:

После создание кластера появится такое окно:

Иии… Сразу обращаю внимание, что есть какие-то ошибки.

Смотрю их подробнее:

Ресурсу сетевого имени «Имя кластера» кластера не удалось зарегистрировать одно или несколько связанных DNS-имен по следующей причине:

Неверный раздел DNS.

Убедитесь, что сетевые адаптеры, связанные с зависимыми ресурсами IP-адресов, настроены для доступа хотя бы к одному DNS-серверу.

И действительно на DNS-сервере запись о кластере не добавилась. Причину тому не знаю:

Но не страшно, добавляю эту запись вручную.

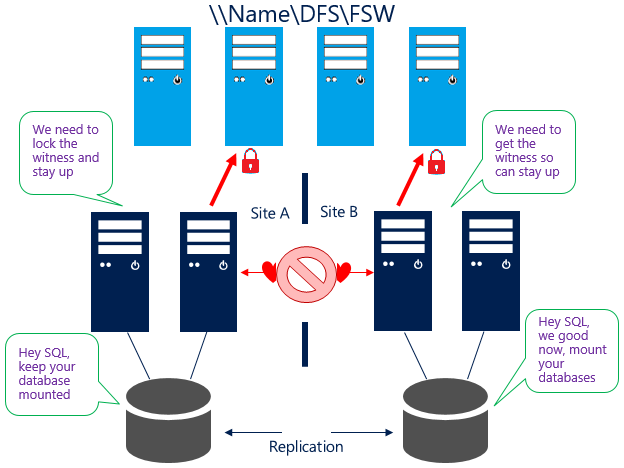

После создания кластера надо настроить для него параметры кворума. Что это за кворум, почитать можно тут:

https://docs.microsoft.com/ru-ru/windows-server/storage/storage-spaces/understand-quorum

Вообще, мастер установки сделал правильно. Он под кворум забрал диск iSCSI. Но дело в том, что это мой единственный диск iSCSI, который я хочу использовать под виртуальные машины, а не под кворум. Кворум можно разместить в обычной сетевой папке. Поэтому захожу вот сюда:

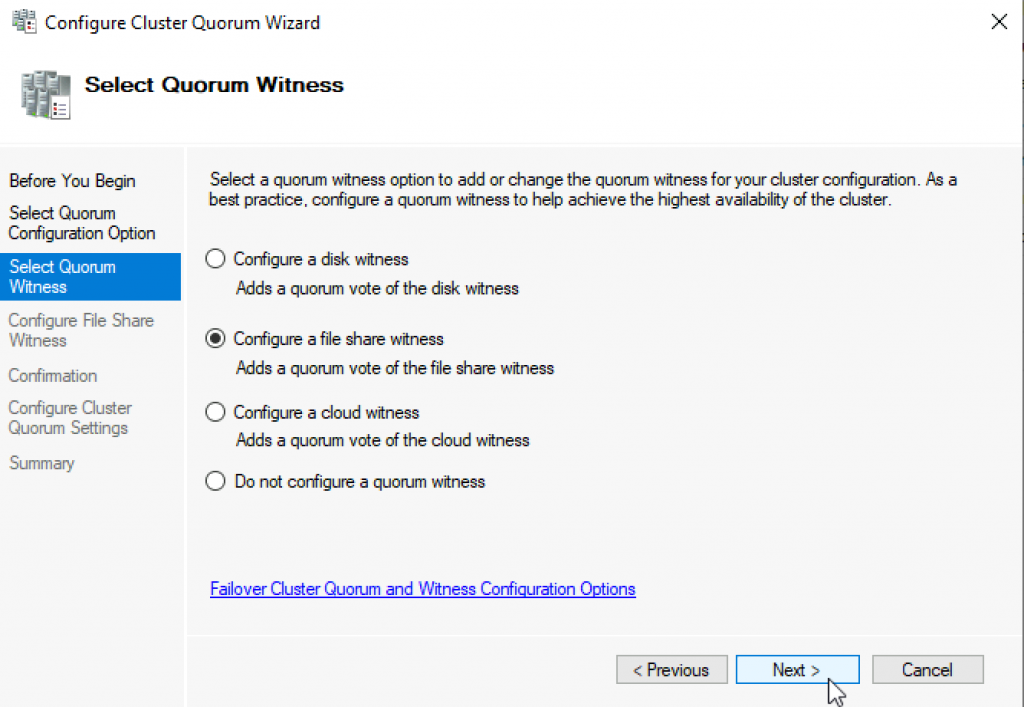

Там выбираю «Выбрать свидетель кворума»:

И дальше выбираю «Настроить файловый ресурс-свидетель»:

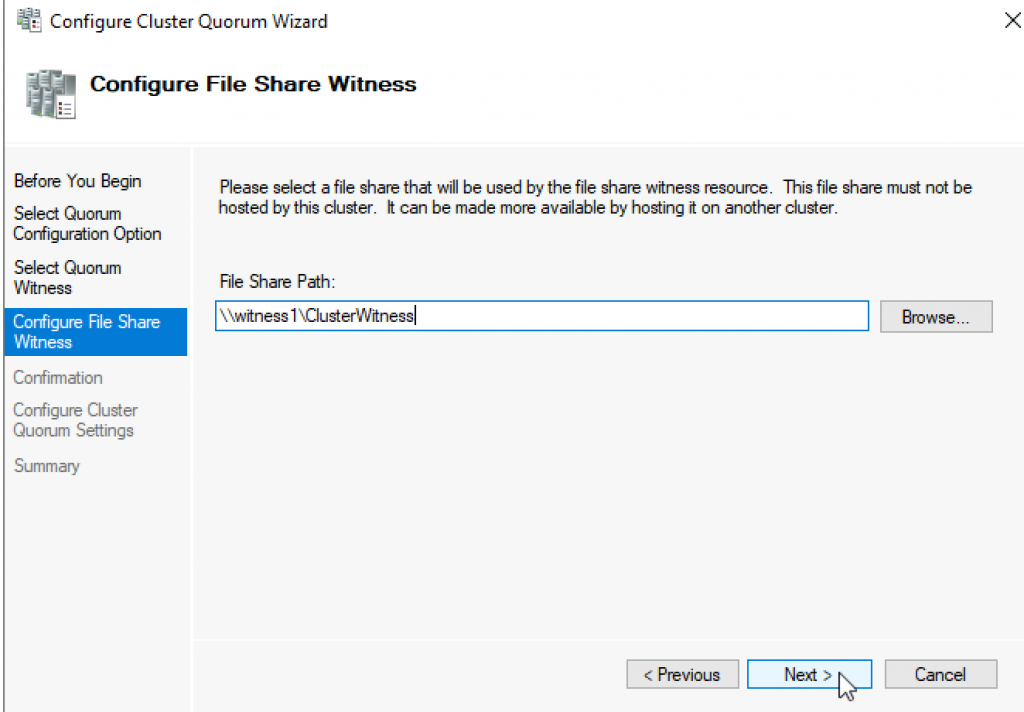

И указываю сетевую папку:

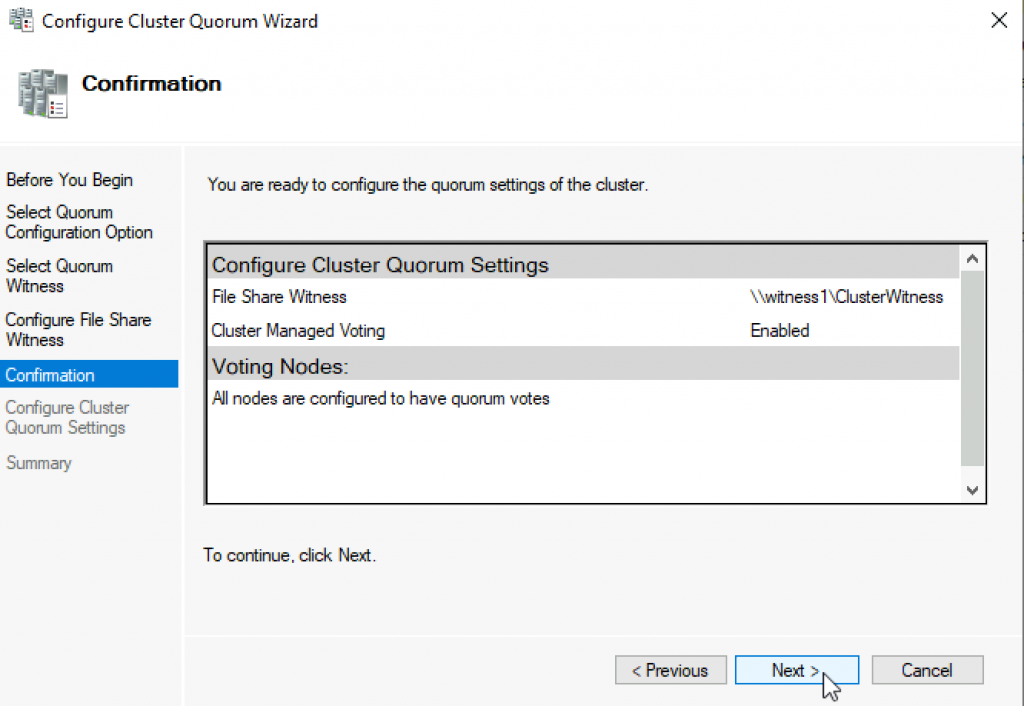

Потом жму везде «далее».

Важно! В правах доступа к этому каталогу должны быть указаны не только администраторы, но и сам кластер:

Добавить его можно, включив галку «Компьютеры» вот тут:

После того, как диск высвободился из-под кворума, добавляю его в общие тома кластера:

Теперь надо добавить виртуальный коммутатор на обе машины. Важно, чтобы виртуальные коммутаторы имели одинаковое название. Создать их можно как через оснастку на Windows Srv 2019 Standard Evaluation, так и через Windows Admin Center. Я, ради интереса, создам виртуальный коммутатор на машине с Windows Srv 2019 Standard Evaluation через Windows Admin Center. А виртуальный коммутатор на машине с Hyper-V Server 2019 создам через оснастку на Windows Srv 2019 Standard Evaluation.

Итак, захожу в Windows Admin Center и выбираю «Диспетчер кластеров»:

Потом жму «Добавить»:

И справа будет предложено ввести имя кластера, а также учётные данные для подключения к нему. Заполняю и жму «Подключитесь с помощью учётной записи»:

Потом жму «Добавить»:

Теперь вижу кластер в списке хостов для управления через Windows Admin Center. Выбираю его:

Ну а там перехожу в меню «Виртуальные коммутаторы» и жму «Создать».

Ну а там дальше выбираю узел, задаю название коммутатора и тип выбираю ему внешний. Жму создать.

Во время создания виртуального коммутатора отвалится ненадолго связь с машиной, на которой он создаётся. Потом он отобразится в списке виртуальных коммутаторов:

Теперь создам виртуальный коммутатор для машины с Hyper-V Server 2019, но через оснастку на машине Windows Srv 2019 Standard Evaluation. Открываю «Средства администрирования» и выбираю оснастку «Диспетчер Hyper-V»:

Там выбираю «Подключиться к серверу», пишу его имя и жму «ОК»:

Дальше захожу в «Диспетчер виртуальных коммутаторов»:

Выбираю внешний и жму «Создать виртуальный коммутатор»:

Задаю такое же имя, как и на первой машине, жму «ОК»:

Выйдет предупреждение, что связь с машиной потеряется на некоторое время. Соглашаюсь и жду завершения. После чего снова захожу в «Диспетчер виртуальных коммутаторов» и вижу, что коммутатор там появился:

Также его можно видеть и через Windows Admin Center:

Что ж, пришло время создать виртуальную машину. Я попробую что-нибудь лёгкое, например, виртуальную машину с Windows XP. Создаю:

Выбираю хост:

Задаю название машины и расположение её конфигурации. Каталог C:\ClusterStorage\volume1 — это и есть тот самый iSCSI диск.

Далее предлагается выбрать поколение виртуальной машины. Для Windows XP надо выбирать первое поколение.

Оперативной памяти выделяю 1Гб, хватит сполна.

Далее настройка сети. Там выбираю виртуальный коммутатор komm1.

Дальше мастер предлагает сразу создать виртуальный диск для этой виртуальной машины. Для XP большой диск не нужен. Также указываю месторасположение диска — тоже на ресурсе iSCSI:

Жму «Далее». На следующем шаге предлагается выбрать установочный носитель с операционной системой. В моём случае, он лежит на флэшке, подключенной к серверу. Выбираю его:

Жму «далее», жму «готово» и получаю вот такую непонятную ошибку:

Не удалось создать виртуальную машину. Проблема оказалась в правах доступа файловой системы. Мастер не мог создать виртуальную машину, т.к. у него просто не было доступа в указанный каталог. Дал вот такие права, и виртуальная машина создалась:

Пробую запустить и установить Windows XP. Жму сначала «Запустить», а потом «Подключить»:

Началась установка Windows XP. Кстати, эту виртуальную машину видно и в Windows Админ Центре:

И от туда к ней тоже можно подключиться:

После установки в Windows XP даже мышь работать не будет. Чтобы всё заработало, надо установить службы интеграции. Установочный образ можно взять тут:

https://disk.yandex.ru/d/b8dcTwIQerC-EQ/vmguest.iso

А затем подставить его в свойствах виртуальной машины вместо установочного образа Windows XP:

Это можно сделать даже при включённой виртуальной машине. Сработает автозапуск с виртуального CD, и интеграционные службы начнут сразу устанавливаться:

Потом установщик попросит перезагрузку. После перезагрузки Windows XP будет работать абсолютно нормально.

Теперь хочется проверить, как виртуальная машина будет переходить с одного узла на другой в кластере. Пробую запустить динамическую миграцию на узел Hyper1:

И получаю ошибку. В подробных сведениях написано вот что:

Собственно, это то, о чём и предупреждал мастер создания кластера на этапе тестирования. Невозможно произвести динамическую миграцию от узла с процессором Intel на узел с процессором AMD. И наоборот — тоже нельзя. Но зато можно это сделать, завершив работу виртуальной машины. Пробую. Работу Windows XP завершил и теперь пробую сделать быструю миграцию (меню динамической миграции уже неактивно):

На этот раз всё успешно, виртуальная машина переместилась на узел Hyper1. Пробую запустить:

Работает. Пробую теперь погасить сервер Hyper2. Виртуальная машина с Windows XP осталась работать при этом:

На этом можно и заканчивать статью. Конечно, для продакшена такая настройка кластера не подойдёт. Но для ознакомления — вполне себе вариант. Так что, может кому и пригодится.

Донаты принимаются на кошельки:

Yoomoney:

4100118091867315

Карта Т-Банк (бывший Тиньков):

2200 7017 2612 2077

Карта Альфа-Банк:

2200 1539 1357 2013

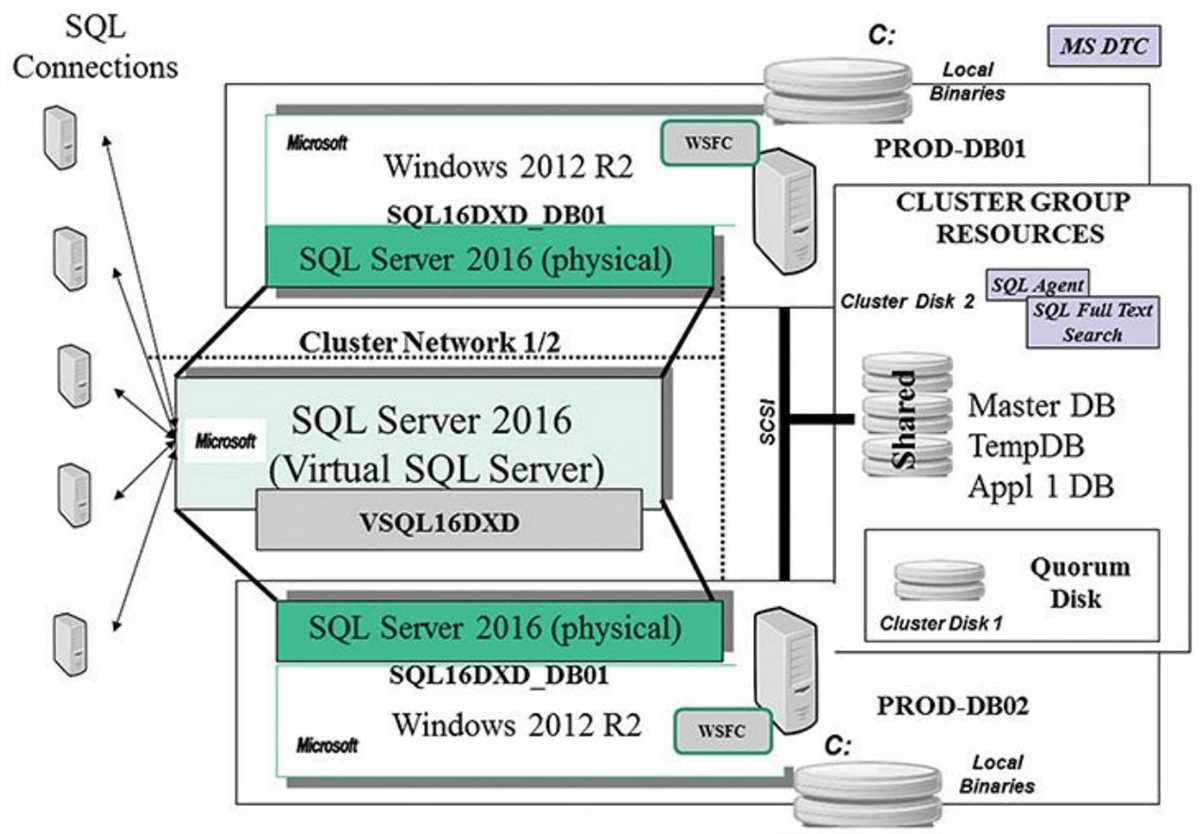

In this tutorial, we would learn how to install and setup Failover cluster in Windows Server 2019 step by step. In the previous tutorial, we configures an iSCSI storage server and created three virtual disk.

To install and configure a failover cluster, let’s look at our network setup, then we follow some steps

- Our Network Environment

- Determine the Cluster Disks

- Add Failover Clustering Role

- Create the Failover Cluster

- Add Disks to the Cluster

1. Our Network Environment

Our lab network is set up using VirtualBox and consists of 4 computers:.

How to set up a domain network is explained here.

DC (192.168.1.90) – This is our domain controller.

Node1 (192.168.1.91) – This is one of the failover cluster nodes and a iSCSI initiator.

Node2 (192.168.1.92) – This is the second failover cluster nodes and an iSCSI initiator.

Node3 (192.168.1.93) – This is out iSCSI target server. It hosts the virtual disks

2. Determine the Cluster Disks

Before you start creating the failover cluster, you need to determine the disk that hold the cluster data. This is so that if a member of the cluster fails, then the data would still be available. In our setup, we have decided to host the disks in another computer (Node3). This is configured as iSCSI target server and contain 3 virtual disk.

The figure below shows Node3 with the 3 iSCSI disks configured.

How to configure iSCSI target server and disks

Note: Ensure that the disks are iSCSI virtual disks are initialized on one of the failover nodes

3. Add the Failover Clustering Role

Now we have to install the Failover cluster role in Node1 and Node2. Follow the steps below to do that.

Step 1 – In Node1, click on Add Roles and Feature. This will launch the Add Roles and Features wizard. Follow the steps and select Failover Clustering as shown below. Then complete the installation.

Step 2 – Repeat the process for Node2

4. Create the Failover Cluster

We would now use the Failover cluster manager to create a cluster. Follow the steps below:

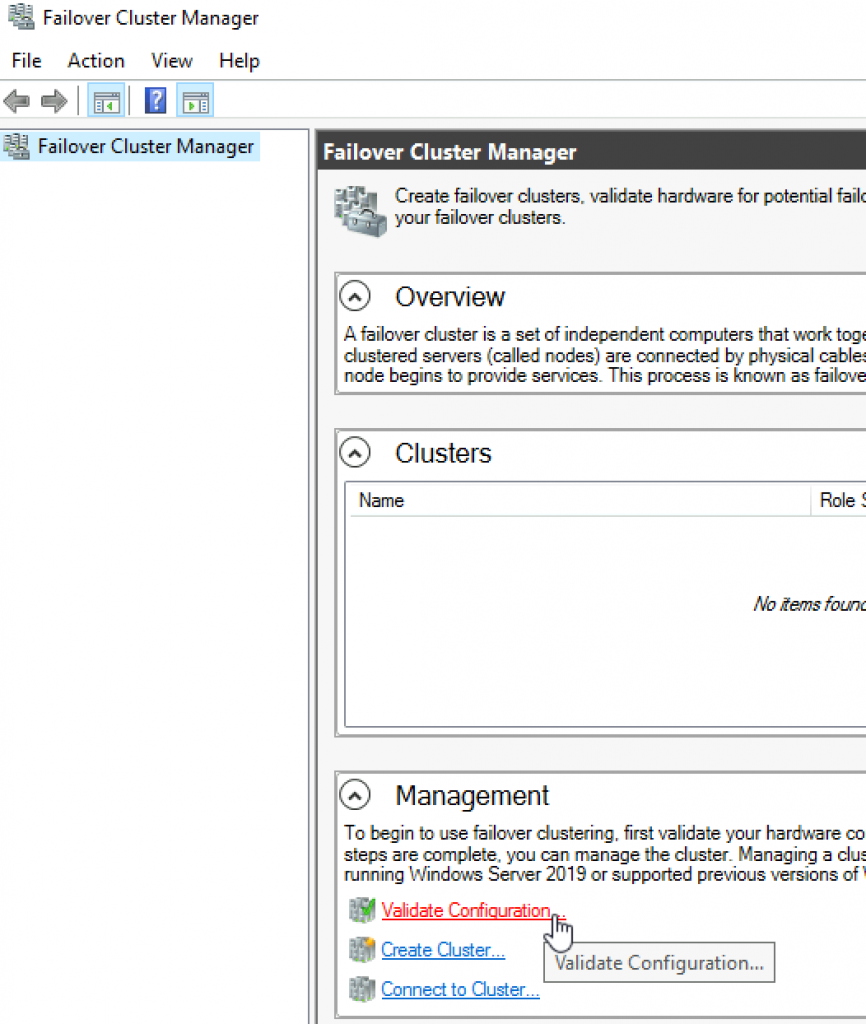

Step 1 – In Node1, click on Manager and select Failover Cluster Manager. The window is shown below

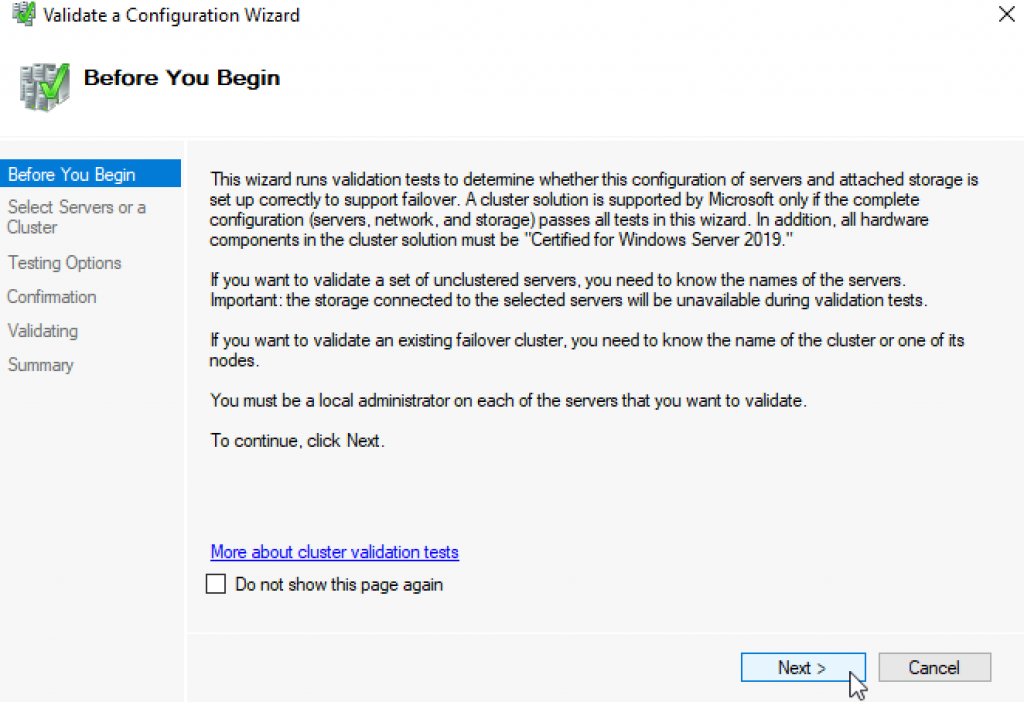

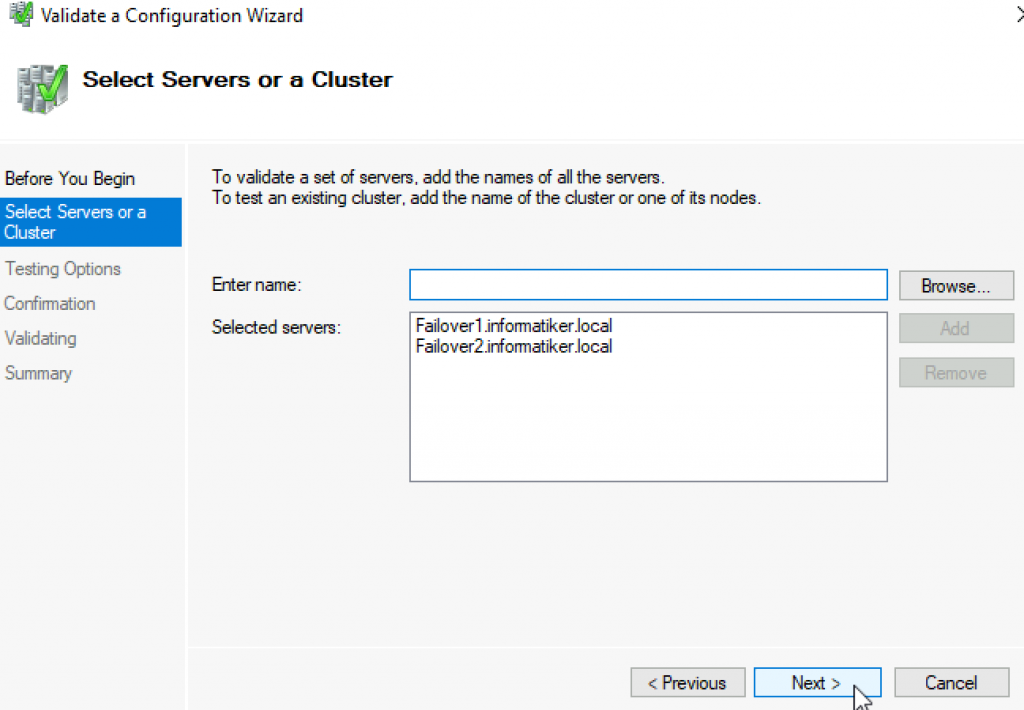

Step 2 – Click on Validate Configuration and follow the wizard steps to do the validation (this is done only in Node1). The wizard will ask you to specify the Servers you want to participate in the clustering. You will use AD to find Node1 and Node2 and select them.

At the end of the validation, you may have warning relating to unsigned drivers. Ignore these warnings because they come from VirtualBox Guest Additions.

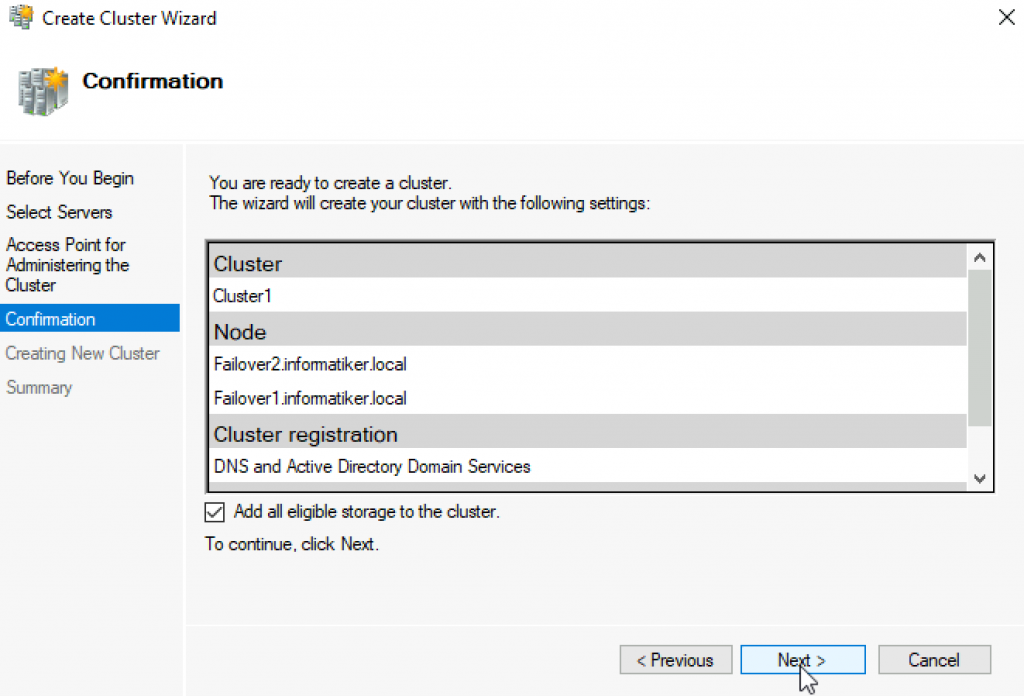

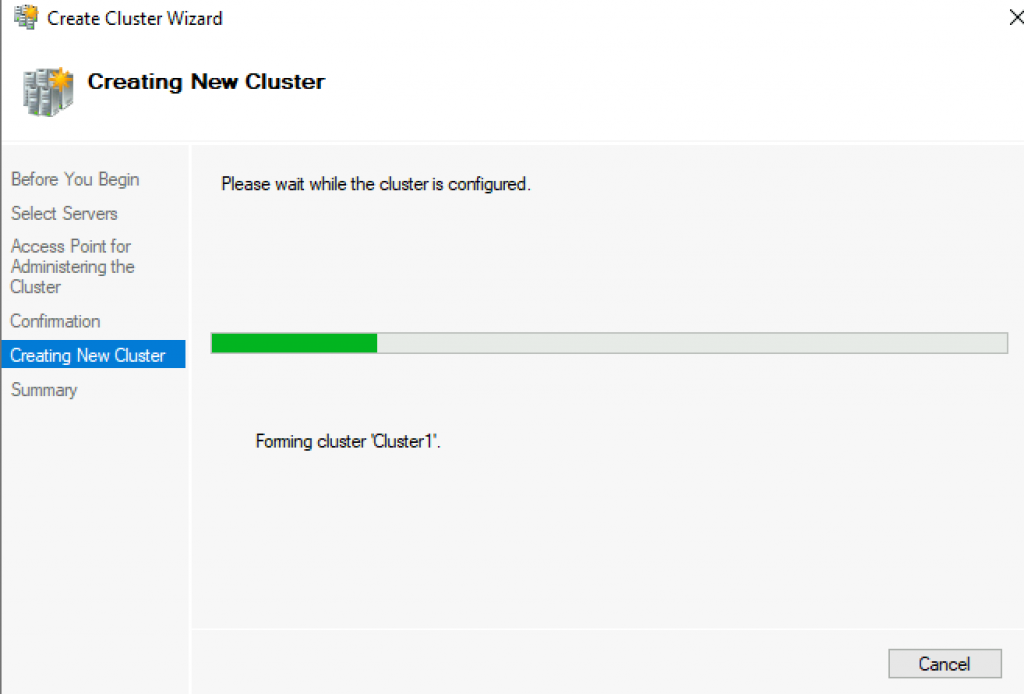

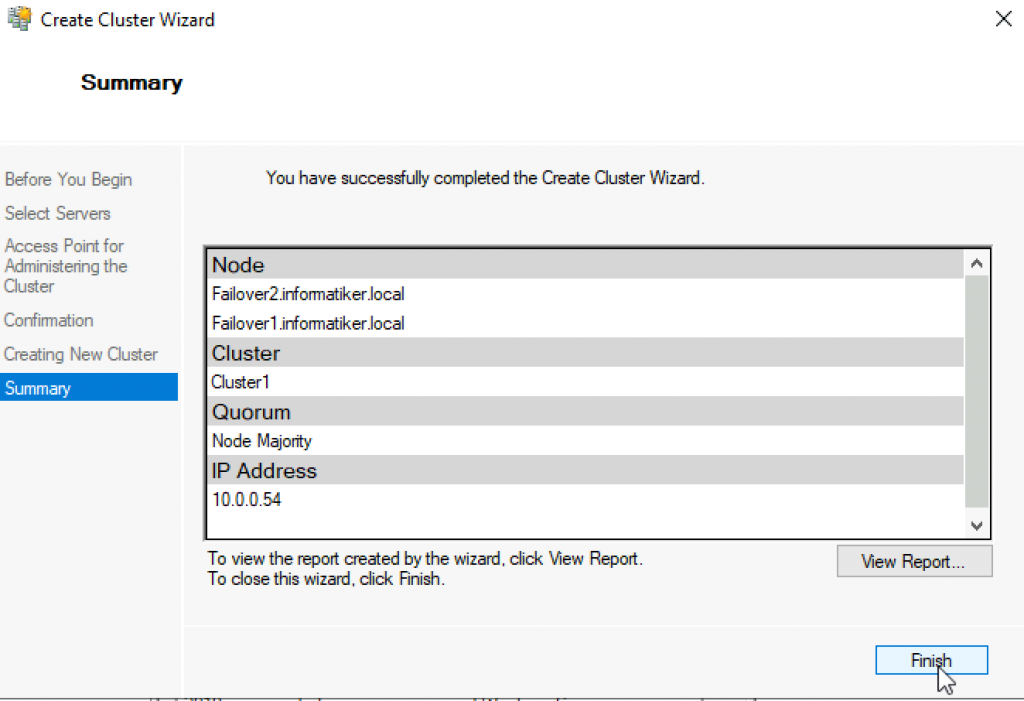

Step 3 – Click on Create Cluster. You will have to select the Node1 and Node1. Then you need to specify the cluster name. The complete the cluster creation. The figure below shows the final screen indicating the cluster creation was successful.

5. Add Disks to the Cluster

Failover clusters require disks and in this case we would used virtual disks from the iSCSI target server.

Step 1– Add storage to the cluster. To do that open the Failover Cluster manager as shown below.

Step 2 – Click on Add Disk. The three iSCSI disks would be listed. Ensure that they are selected.

Click on OK.

At this point, the disks are added to the cluster and they are online as well. See the figure below

In subsequent tutorials, I discuss the concept of Witness in failover cluster and how to configure Quorum witness and Disk witness.

I also recommend you watch the video in my Youtube Channel.

Failover clustering will enable you to make you Windows Server services highly available. In this guide we will go just through simple setup of failover clustering on Windows Server 2019 without setting up any services.

Before we begin

These are the resources you will need if you are completely new to Failover Clustering – https://docs.microsoft.com/en-us/windows-server/failover-clustering/create-failover-cluster

Prerequisites

I assume you know basic things about Windows Server before you attempt to do this.

DC

LAB for this guide consists of following:

Domain: informatiker.local

Domain Controller named DC1 – 10.0.0.31

ISCSI

One Windows Server ISCSI Target server named ISCSI1 (if you don’t know how to make ISCSI target server, here is the guide)

ISCSI1 – 10.0.0.50

That machine has one additional disk of 40GBs that will be assigned to ISCSI Target.

Optionally, you don’t have to bring up iscsi target server and configure iscsi for failover cluster – you can also bring up failover cluster without storage.

Failover cluster

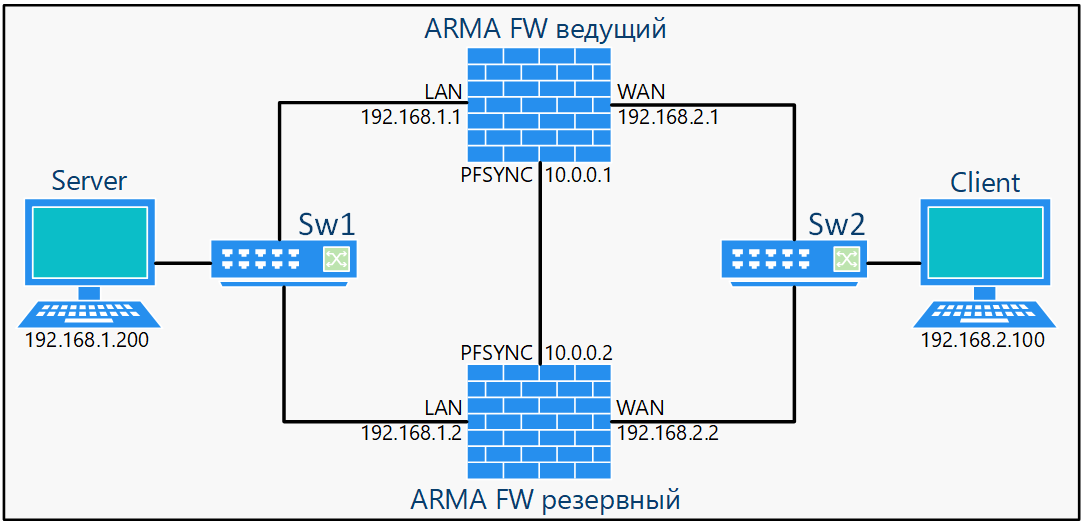

We will have two nodes that will have failover clustering installed. These machines will have two network cards – one for communication with network, and another one for clustering communication.

Failover1 – NIC1 10.0.0.52 NIC2 192.168.4.2

Failover2 – NIC1 10.0.0.53 NIC2 192.168.4.3

192.168.4.xx network is only for internal cluster configuration (heartbeat). On netowrk cards that will serve you as heartbeat and internal cluster communication – Control Panel | Network and Sharing Center | Change Adapter Settings | right click on network adapter that will serve for cluster communication – Properties | under Networking tab select IPv4 – Properties | click on Advanced button | under DNS tab deselect Register this connection’s addresses in DNS | WINS tab – select Disable NetBIOS over TCP/IP. Do this ONLY ON network adapters that will server for internal cluster communication!

All of these machines should be part of domain.

Be sure to enable MPIO Feature and iSCSI Initiator on both Failover1 and Failover2 machines. Be sure to follow my guide I posted above for creating ISCSI target, it has all the details in it.

MPIO is very important when you use shared storage.

Connect one 40GB disk you defined as ISCSI target to both Failover1 and Failover2, leave it offline at failover2 node.

Cluster is going to be named Cluster1

Cluster1 – 10.0.0.54

Cluster Witness. We need additional VM that will hold file share that ill be available to our cluster – Witness1

Witness1 – 10.0.0.55

Install Failover Clustering

We will go through the process on Failover1 node, you will repeat the process on Failover2 node. I will show you only important parts, I assume you know how to use Server Manager.

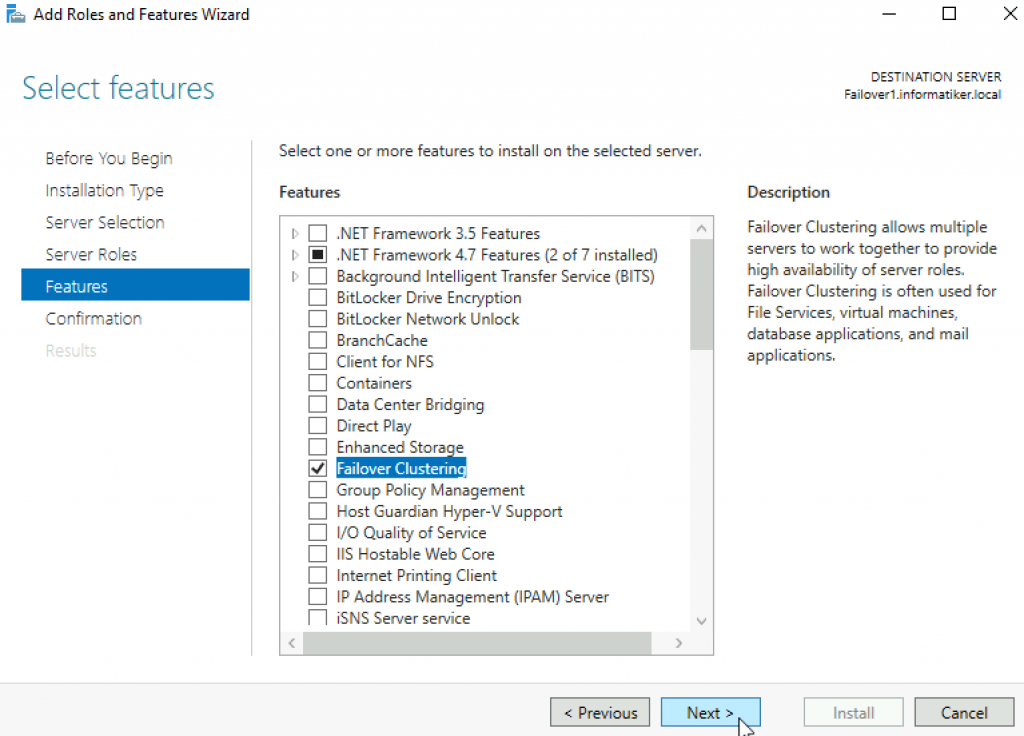

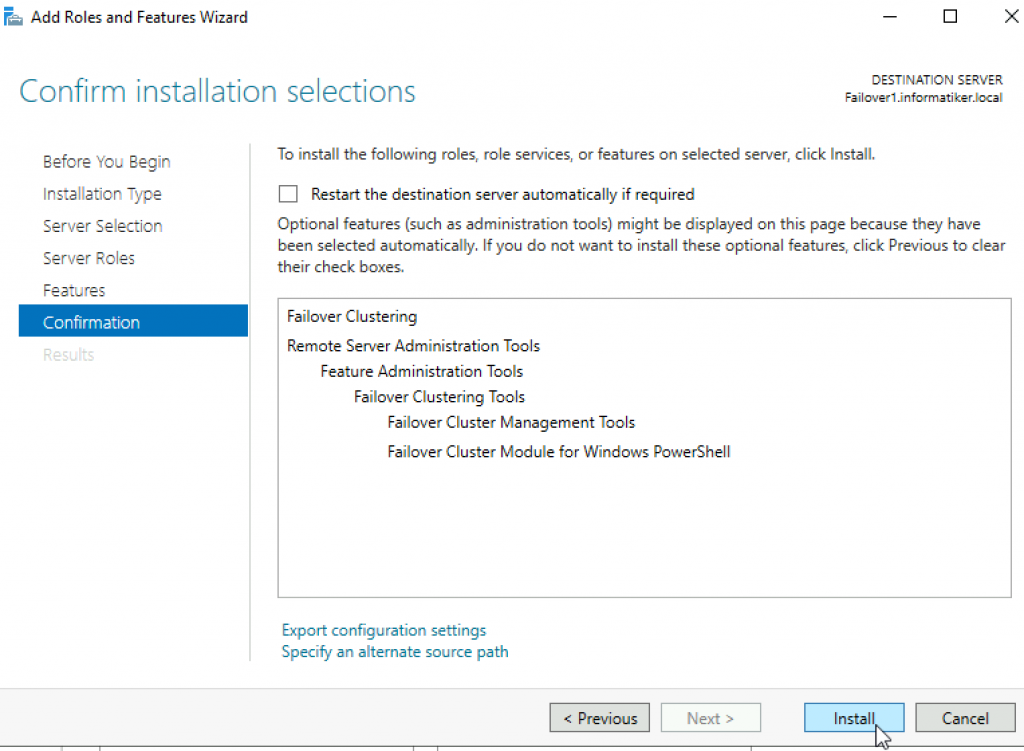

Open Server Manager | click on Manage | Add Roles And Features | on Features screen select Failover Clustering

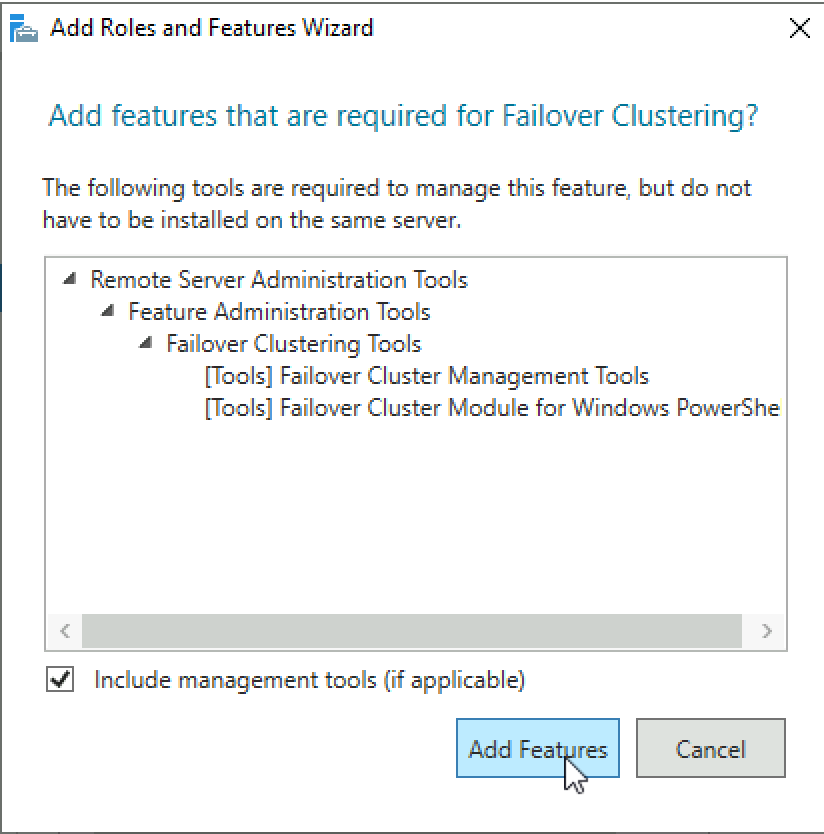

Additional pop-up will appear, click on Add Features

Next

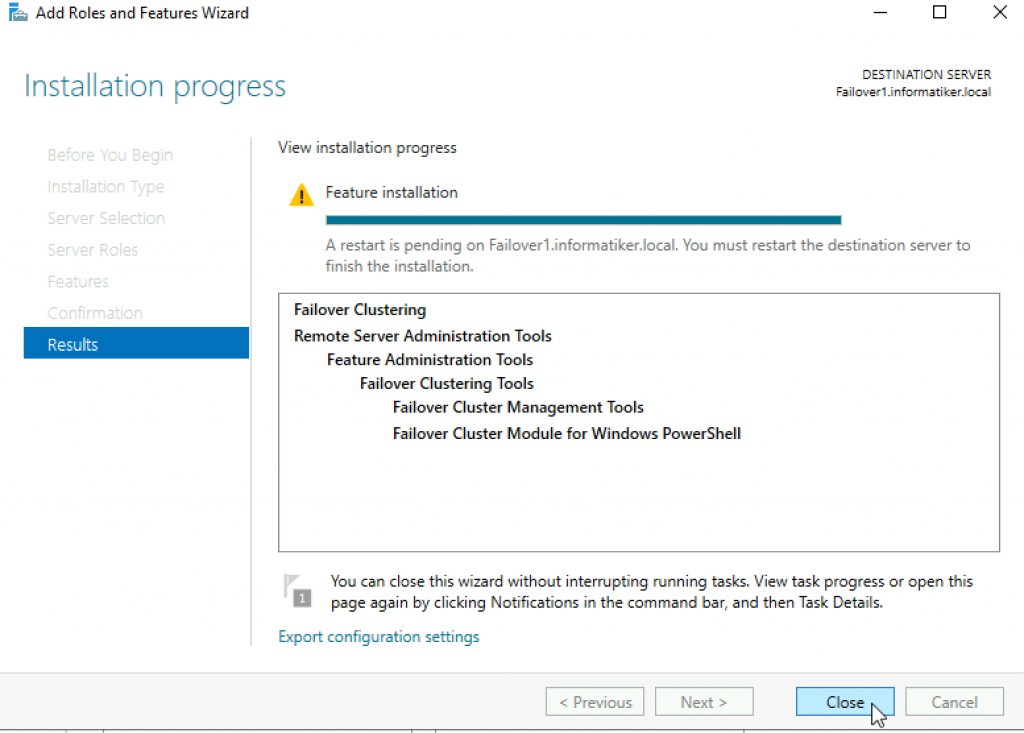

Install

Close wizard and reboot server.

Repeat this process on Failover2 node.

Validate Cluster Configuration

After you installed Failover Clustering on both nodes, login to Failover1 node, click on Start | Windows Administrative Tools | select Failover Cluster Manager

Click on Failover Cluster Manager, and from the middle screen select Validate Configuration…

Next

Select both servers (in my case Failover1 and Failover2) and select Next

Run all tests | Next

Next

…

All test were success | Finish

We can proceed to creating cluster

Failover Cluster Manager | from Action screen, select Create Cluster

Next

Again select both servers that will be part of the cluster | Next

I will name cluster – Cluster1 and give it IP 10.0.54 | Next

Next

…

Success! Finish

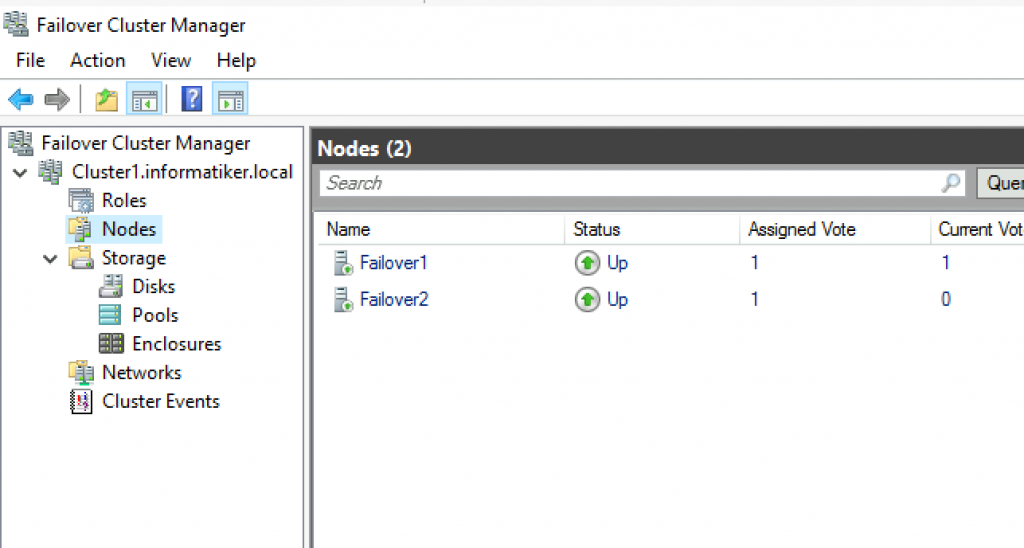

We can now see created cluster1 and two nodes as part of it.

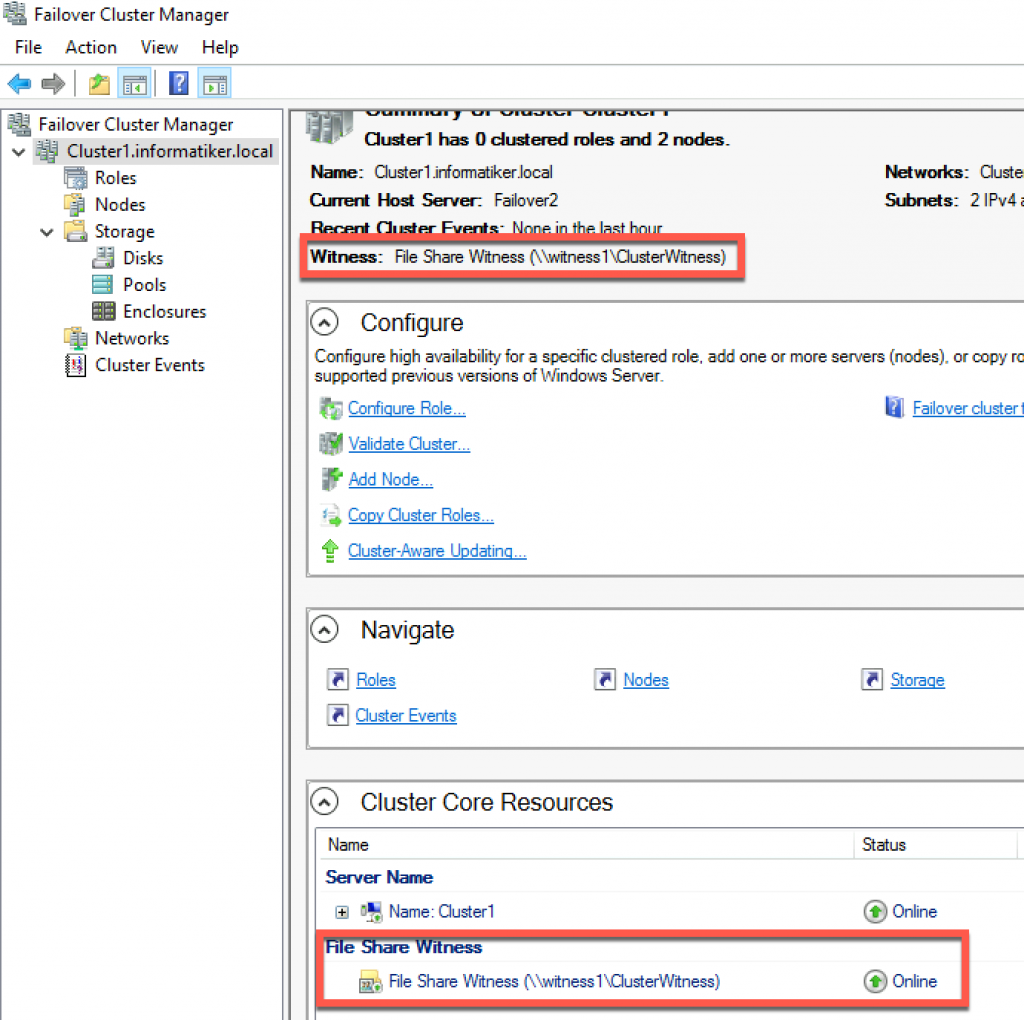

Add Cluster Quorum Witness

Cluster Quorum Witness will enhance your Failover Cluster Availability. I will not go into detail about witness role, you can find many more details here – https://docs.microsoft.com/en-us/windows-server/failover-clustering/manage-cluster-quorum

In our scenario, we will add File Share as Witness. since we have only two nodes, witness and one node will always have to be up, for cluster to be valid. So, make sure you plan you outages and patching so that you always have two nodes up.

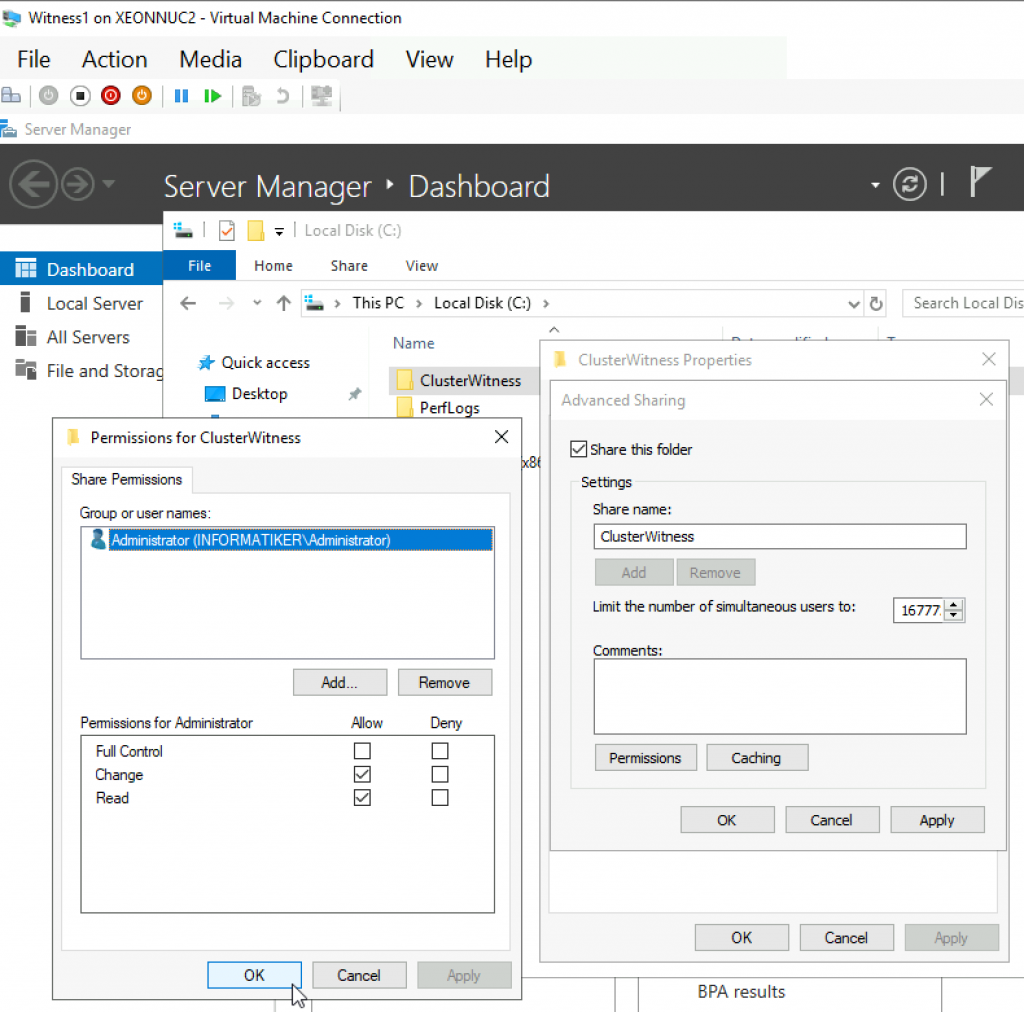

On Witness1 machine, I added folder named ClusterWitness and shared it. In the screenshot below – three things are MISSING – you should also add Failover1, Failover2 and Cluster1 computers to this fileshare with full rights. Also, visit security tab of the shared folder and repeat procedure there!!

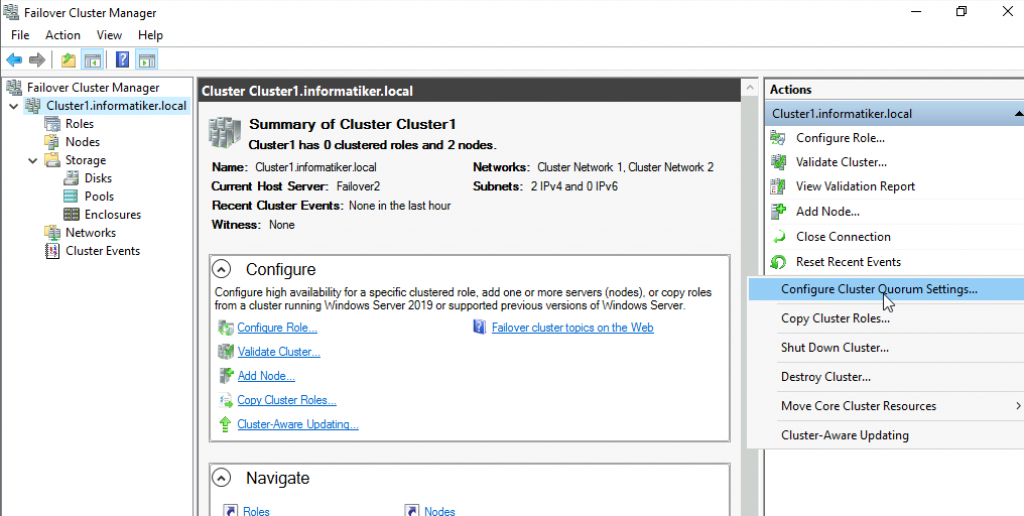

Back to Failover1 node – Open Failover Cluster Manager | select Actions | More Actions | Configure Cluster Quorum Settings

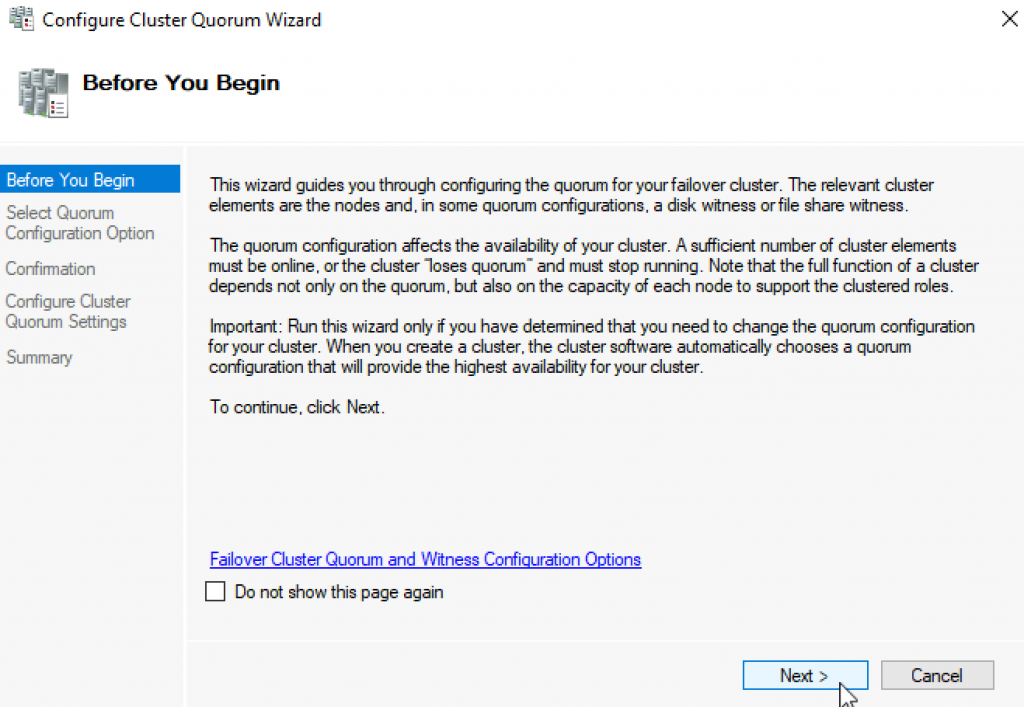

Next

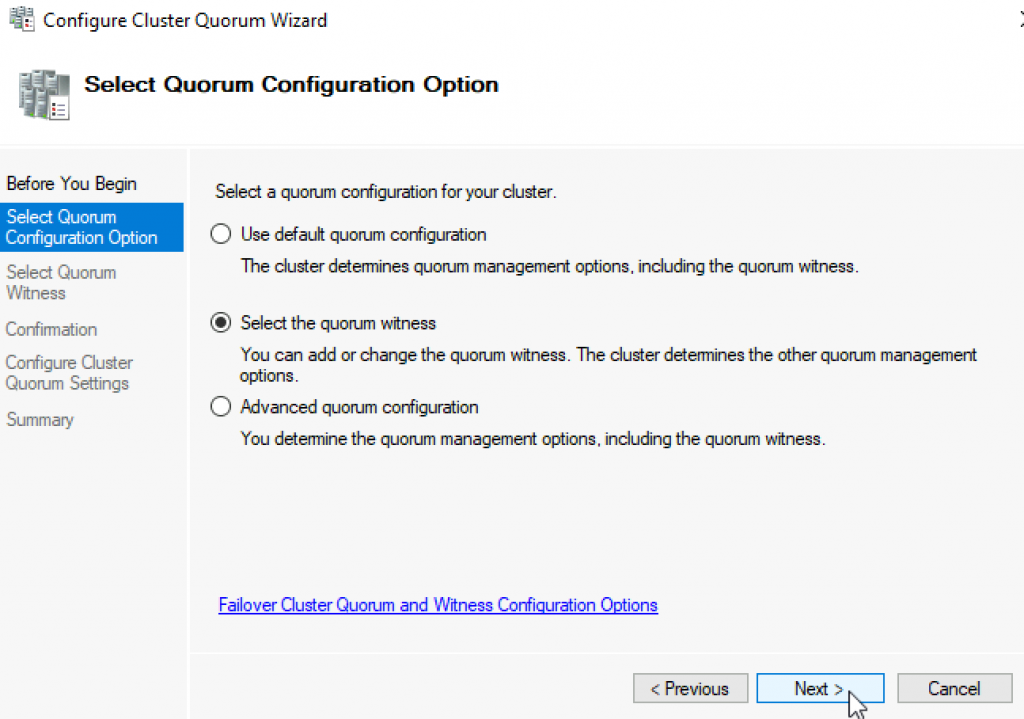

Select the quorum witness | Next

You have many options, today we will select “Configure a file share witness” Next

Enter FQDN to your file share on witness1. In my case it is \witness1\ClusterWitness | Next

Review and click Next

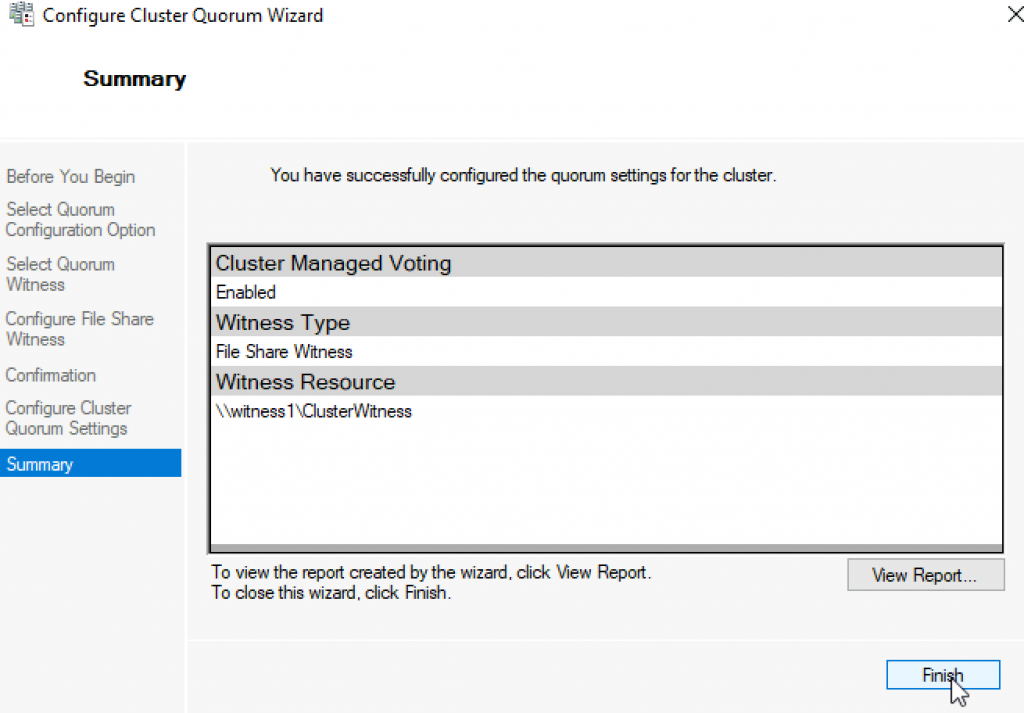

Success! Finish

Now, we can see in Failover Cluster Manager that Witness is available.

That is it, we covered the basics and we can now start deploying various services in our clustered scenario.

Disclaimer

Installing the Cluster is easy now days. But just this I post a little blog on how to do this, In my blog stats it shows that the 2012 post is still very active , so time for an update to Windows Server 2019. in the creation there isn’t much changed, it gets only easier. but If you still not in PowerShell you got more clicks to do an less Coffee. And Windows Admin Center is also a great addition to manage a cluster. This blog post is also usable in Azure Only you need to add Storagespacesdirect and a CSV file share.

Just install a bare metal (VM) windows Server 2019 and do a domain join and the fun can start.

Installing the Cluster Feature in powershell

Install-WindowsFeature –Name Failover-Clustering –IncludeManagementTools

#Create cluster validation report

Test-Cluster -Node MVP19-01,MVP19-02

#Create new Cluster

New-Cluster -Name MVP1911-27 -Node MVP19-01,MVP19-02 -NoStorage -StaticAddress «10.255.255.45»

#place witness file on USB device from my router

Set-ClusterQuorum -FileShareWitness \\SERVER\SHARE -Credential $(Get-Credential)

Now that the basic cluster is ready we start with the HA share

File share witness enhancements We enabled the use of a file share witness in the following scenarios:

- Absent or extremely poor Internet access because of a remote location, preventing the use of a cloud witness.

- Lack of shared drives for a disk witness. This could be a Storage Spaces Direct hyperconverged configuration, a SQL Server Always On Availability Groups (AG), or an * Exchange Database Availability Group (DAG), none of which use shared disks.

- Lack of a domain controller connection due to the cluster being behind a DMZ.

-

A workgroup or cross-domain cluster for which there is no Active Directory cluster name object (CNO). Find out more about these enhancements in the following post in Server & Management Blogs: Failover Cluster File Share Witness and DFS.

We now also explicitly block the use of a DFS Namespaces share as a location. Adding a file share witness to a DFS share can cause stability issues for your cluster, and this configuration has never been supported. We added logic to detect if a share uses DFS Namespaces, and if DFS Namespaces is detected, Failover Cluster Manager blocks creation of the witness and displays an error message about not being supported.

that’s it the cluster is created, we can start with the File server

Next is installation of the file server role

A restart is needed! After the restart we can build the cluster with the HA file share

$servers = («MVP19-01», «MVP19-02»)

foreach ($server in $servers) {Install-WindowsFeature -Name file-services -ComputerName $server}

Now that the File Server Role is added we can add the Disk. Or use a disk that you already added before.

First we need to add a disk this can be done in the Failover Cluster manager or with PowerShell

Get-ClusterAvailableDisk | Add-ClusterDisk

The Roles are there and the Disk is added

Next step is adding the File server Role to the Cluster and add the HA File Share.

In this case I have a fail over disk and I use the File Server for general use.

So when adding the Disk it is not showing the disk. This is The disk is added to the cluster but the disk isn’t formatted!

Keep in mind that formating the cluster disk while it is online is not possible. You need to set the disk in maintenance mode else the format will fail.

So after the disk format we will see the Disk appear and can be added to the File server

After this the File server is up and running. As you can see the setup is screen intense, building this with PowerShell is a lot faster.

Powershell

add-ClusterFileServerRole -Storage «Cluster Disk 1» -Name MyFiles

New-SmbShare -Name «Data» -Path «J:\Data» -EncryptData $True

Quick steps with powershell and even the share is created and encrypted

Next step is adding the file share.

go for the Quick setup

Pick the disk and select the folder with the data on the disk, if there is no data then create a folder that will hold the data later.

as you can see the UNC path from the File Server.

As you can see the settings can be adjusted for you needs and also set the right access, and keep in mind this needs to be don on the Cluster Level!

All Done

So creating a File Server and 2 file shares is Click intensive if you don’t use PowerShell.

But What about Windows Admin Center ? yes that would be an option also except here you can’t create a cluster role.

You can create a new role but no file server /share etc.

But when the share is created and running like now you can use Windows Admin Center for migration the data to the file share.

But more and more options are coming in Windows Admin Center below are some links that you can use to add your request to the UserVoice

https://docs.microsoft.com/en-us/windows-server/manage/windows-admin-center/use/manage-failover-clusters

More Coming

Failover cluster management in Windows Admin Center is actively under development and new features will be added in the near future. You can view the status and vote for features in UserVoice:

Feature Request

Show more clustered disk info

Support additional cluster actions

Support converged clusters running Hyper-V and Scale-Out File Server on different clusters

View CSV block cache

See all or propose new feature

+++++++++++++++

Follow Me on Twitter @ClusterMVP

Follow My blog https://robertsmit.wordpress.com

Linkedin Profile Robert Smit MVP Linkedin profile

Google : Robert Smit MVP profile

Robert Smit is Senior Technical Evangelist and is a current Microsoft MVP in Clustering as of 2009.

Robert has over 20 years experience in IT with experience in the educational, health-care and finance industries.

Robert’s past IT experience in the trenches of IT gives him the knowledge and insight that allows him to communicate effectively with IT professionals

who are trying to address real concerns around business continuity, disaster recovery and regulatory compliance issues. Robert holds the following certifications:

MCT — Microsoft Certified Trainer, MCTS — Windows Server Virtualization, MCSE, MCSA and MCPS. He is an active participant in the Microsoft newsgroup community and is currently focused on Hyper-V, Failover Clustering, SQL Server, Azure and all things related to Cloud Computing and Infrastructure Optimalization.

Follow Robert on Twitter @ClusterMVP

Or follow his blog https://robertsmit.wordpress.com

Linkedin Profile Http://nl.linkedin.com/in/robertsmit

Robert is also capable of transferring his knowledge to others which is a rare feature in the field of IT. He makes a point of not only solving issues but also of giving on the job training of his colleagues.

A customer says » Robert has been a big influence on our technical staff and I have to come to know him as a brilliant specialist concerning Microsoft Products. He was Capable with his in-depth knowledge of Microsoft products to troubleshoot problems and develop our infrastructure to a higher level. I would certainly hire him again in the future. »

Details of the Recommendation: «I have been coordinating with Robert implementing a very complex system. Although he was primarily a Microsoft infrastructure specialist; he was able to understand and debug .Net based complext Windows applications and websites. His input to improve performance of applications proved very helpful for the success of our project

View all posts by Robert Smit [MVP]