Docker-compose — это утилита, позволяющая запускать одновременно несколько контейнеров, используя при этом единый файл конфигурации всего стека сервисов, нужных вашему приложению. Например, такая ситуация: запускаем node.js webapp, которому нужна для работы mongodb, compose выполнит build вашего контейнера с webapp (традиционный Dockerfile) и перед его запуском запустит контейнер с mongodb внутри; так же может выполнить линк их между собой. Что крайне удобно как в разработке, так и в CI самого приложения. Так сложилось, что Windows пользователи были обделены возможностью использовать столько удобное средство, ввиду того, что официальной поддержки данной ОС все еще нет. А python версия для *nix не работает в окружении windows cmd, ввиду ограничений консоли Windows.

Для того, чтобы запустить docker-compose, мы можем использовать консольную оболочку Babun. Это, так сказать, «прокаченный» форк cygwin.

Итак, рецепт запуска docker-compose в Windows из консоли babun такой:

1. Скачиваем(~280MB!) и устанавливаем сам babun, узнать больше об этой оболочке можно на ее домашней странице babun.github.io;

2. Распаковываем архив (после установки полученную папку можно удалять);

3. Запускаем файл install.bat и ждем, пока пройдет установка;

4. После в открывшемся окне babun введем команду:

babun update

И убедимся, что у нас самая последняя версия оболочки (далее все команды выполняются только внутри оболочки babun);

5. Если вам не нравится дефолтный shell babun (используется zsh), его можно изменить на bash. Для этого вводим:

babun shell /bin/bash

6. Теперь нам нужно установить те самые зависимости Python, которых так не хватает docker-compose. Для этого выполним следующие команды по очереди:

pact install python-setuptools

pact install libxml2-devel libxslt-devel libyaml-devel

curl -skS https://bootstrap.pypa.io/get-pip.py | python

pip install virtualenv

curl -skS https://raw.githubusercontent.com/mitsuhiko/pipsi/master/get-pipsi.py | python

7. Теперь мы готовы установить сам docker-compose:

pip install -U docker-compose

Если все прошло успешно, увидим:

{ ~ } » docker-compose --version

docker-compose 1.2.0

Если же вы получили ошибку, error python fcntl или сообщение о не найдом файле docker-compose, попробуйте найти файл docker-compose в папках /usr/local/bin, /usr/sbin и подобных, затем можно сделать симлинк на /bin/. либо добавить в системный PATH недостающий путь.

Для правильной работы docker-compose нужно иметь уже настроенное окружение консоли для работы с docker-machine или boot2docker, а так же сам клиент docker должен быть доступен в системном PATH. О том, что такое docker, docker-machine и как с ними работать отлично рассказывает официальная документация.

Для входа в окружение нашего хоста докера, запущенного в docker-machine, нужно выполнить:

eval "$(docker-machine env ИМЯ_МАШИНЫ)"

Либо тоже самое для boot2docker:

eval "$(boot2docker shellinit)"

Проверить правильность работы клиента docker можно так:

docker ps

Если получаем список контейнеров или просто заголовки таблицы, значит, все ок!

docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

Для запуска стека приложения переходим в каталог нашего приложения, где у нас уже должен быть заготовлен файл docker-compose.yml или fig.yml. Синтаксис yml файла описан тут.

Далее для запуска вводим команду:

docker-compose up

Если нужно запустить в фоне, добавляем -d. Compose построит нужный образ и запустит его согласно вашему файлу docker-compose.yml.

На этом все.

Спасибо за внимание, надеюсь было полезно.

p.s. Я умышлено не стал говорить о варианте запуска compose как контейнера, т.к. считаю его неудобным.

Введение

Приветствую вас в мире Docker Compose! Если вы только начинаете свой путь работы с контейнерами или хотите упростить уже имеющийся процесс, это руководство именно для вас. Docker Compose — это мощный инструмент, который позволяет управлять многоконтейнерными приложениями с легкостью. Вам не придется вручную запускать каждую часть вашего стека, вместо этого вы сможете автоматически развертывать его с помощью одного файла конфигурации. Давайте шаг за шагом изучим, как это все работает и что необходимо для начала работы.

Установка Docker Compose

Прежде чем начать, нам нужно установить Docker Compose на вашем компьютере. Убедитесь, что Docker уже установлен, так как он необходим для работы Compose.

Установка на Linux

Для начала давайте настроим Docker Compose на Linux. Выполните следующие команды в вашем терминале:

# Скачиваем последнюю версию Docker Compose

sudo curl -L "https://github.com/docker/compose/releases/download/1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

# Даем файлу права на выполнение

sudo chmod +x /usr/local/bin/docker-composeУстановка на macOS

Если вы используете macOS, самым простым способом будет установка через Homebrew. Следующая команда установит Docker и Docker Compose:

# Устанавливаем docker-compose через Homebrew

brew install docker-composeУстановка на Windows

На вашей машине с Windows Docker Compose обычно устанавливается вместе с Docker Desktop. После установки Docker Desktop у вас сразу будет доступ к Docker Compose.

После установки проверьте, что Docker Compose успешно установлен:

# Проверка версии Docker Compose

docker-compose --versionЕсли увидите версию, значит, всё прошло успешно. Теперь переходим к следующему шагу.

Основные команды Docker Compose

Теперь, когда мы установили Docker Compose, давайте посмотрим на основные команды, которые помогут вам управлять контейнерами.

Запуск контейнеров

Для запуска контейнеров используйте команду up. Она выполнит все этапы, от сборки до запуска, как это определено в вашем docker-compose.yml файле.

# Запуск контейнеров

docker-compose upЕсли вы хотите, чтобы процесс выполнялся в фоновом режиме, используйте флаг -d:

# Запуск в фоновом режиме

docker-compose up -dОстановка контейнеров

Чтобы остановить работающие контейнеры, просто выполните команду down. Она не только остановит контейнеры, но и удалит их:

# Остановка и удаление контейнеров

docker-compose downПросмотр статуса

Чтобы увидеть, какие контейнеры сейчас запущены, используйте команду ps:

# Просмотр состояния контейнеров

docker-compose psЛоги контейнеров

Смотрите логи вашего приложения в режиме реального времени с помощью команды logs:

# Показать логи всех контейнеров

docker-compose logsТеперь, когда мы разобрались с основными командами, давайте перейдем к конфигурации.

Работа с конфигурацией Docker Compose

Конфигурация в Docker Compose осуществляется через файл docker-compose.yml, в котором вы описываете, какие услуги вам нужны и как они должны взаимодействовать друг с другом.

Создание файла docker-compose.yml

Давайте рассмотрим простой пример конфигурации. Смотрите, я покажу, как это работает для небольшого приложения на Node.js и базы данных MongoDB. Создайте файл docker-compose.yml в вашем проекте:

version: '3' # Указываем версию Docker Compose

services:

web: # Это наш сервис для приложения

image: node:14 # Используем официальный образ Node.js

volumes:

- .:/usr/src/app # Монтируем текущий каталог внутрь контейнера

working_dir: /usr/src/app # Устанавливаем рабочую директорию в контейнере

command: npm start # Команда для старта приложения

ports:

- "3000:3000" # Пробрасываем порт 3000

database: # Сервис базы данных

image: mongo # Используем официальный образ MongoDB

ports:

- "27017:27017" # Пробрасываем порт базы данныхВот так просто можно создать многоконтейнерное приложение. Обратите внимание, как этот файл описывает все, что нужно для запуска.

Сетевые настройки

Docker Compose автоматически создает сеть, чтобы сервисы могли взаимодействовать друг с другом. Например, в вашем коде Node.js, чтобы подключиться к MongoDB, просто используйте database в качестве hostname.

Переменные окружения

Вы можете передавать переменные окружения в контейнеры. Это делается через блок environment:

services:

web:

# код...

environment:

- NODE_ENV=production # Устанавливаем режим "production"Заключение

Теперь вы знаете, как устанавливать, запускать и конфигурировать Docker Compose. Это мощный инструмент, упрощающий работу с многоконтейнерными приложениями. Необходимо только один раз настроить docker-compose.yml, и вы получите возможность легко управлять вашим стеком приложений. Надеюсь, это руководство сделало ваш старт в Docker Compose более простым и понятным. Удачи в написании вашего собственного проекта!

В этой статье рассмотрим, как использовать Docker Compose для управления многоконтейнерными приложениями. Разберем, зачем нужен Docker Compose и как он помогает решать задачи разработки, тестирования и развертывания. Узнаем, как создавать и настраивать контейнеры для приложений с помощью файла docker-compose.yml. Расскажем, какие команды будут полезны в работе с контейнерами и как настраивать пользовательские сети для взаимодействия компонентов внутри проекта.

Зачем нужен Docker Compose

Docker Compose — это инструмент управления многоконтейнерными приложениями. Он упрощает разработку, развертывание и тестирование сложных проектов, где используются несколько сервисов. Ими могут быть веб-серверы, базы данных, приложения и другие компоненты.

В отличие от Docker, который работает с отдельными контейнерами, Docker Compose ориентирован на управление несколькими контейнерами одновременно. Он описывает их конфигурацию в одном файле — docker-compose.yml. Это делает его незаменимым инструментом для разработчиков и DevOps-инженеров, которые хотят автоматизировать сборку, запуск и настройку сети между контейнерами.

Сравнивать Docker Compose с Docker корректно, но важно понимать их различия. Docker — это инструмент для создания и управления отдельными контейнерами. Docker Compose же предназначен для работы с группами контейнеров, объединенных в сервисы.

Например, с помощью Docker Compose можно одной командой запустить весь проект, включая веб-сервер, базу данных и приложение, а также настроить сеть между ними.

docker-compose upЭто значительно ускоряет разработку и упрощает управление зависимостями между компонентами. За это Docker Compose и ценят в современных IT-проектах.

Что такое YAML

YAML — это человекочитаемый формат данных, который часто используется для создания конфигурационных файлов, например docker-compose.yml. Формат прост и имеет понятный синтаксис. Это делает его идеальным для описания конфигураций сервисов, сетей, портов и других параметров в Docker Compose.

В YAML используются отступы для обозначения структуры, что позволяет легко описывать сложные зависимости и настройки. Например, из файла docker-compose.yml можно указать, какие образы использовать, как настроить сеть между контейнерами, какие порты открыть на хосте и как управлять переменными окружения. Благодаря своей гибкости и удобству, YAML стал стандартом для работы с Docker Compose и другими инструментами в сфере разработки и DevOps.

Создание проекта для запуска в Docker Compose

Запуск проекта с использованием Docker Compose предполагает создание и настройку нескольких контейнеров, которые работают вместе. В этом разделе мы рассмотрим, как создать контейнеры для Nginx и PHP, чтобы они могли взаимодействовать друг с другом. Это типичный сценарий для веб-приложений, где Nginx выступает в роли веб-сервера, а PHP обрабатывает backend-логику.

Создание контейнера для Nginx

Nginx — высокопроизводительный веб-сервер, который часто используется для обслуживания статических файлов и проксирования запросов к backend-сервисам. Для создания контейнера с Nginx необходимо:

- создать Dockerfile,

- настроить конфигурацию Nginx,

- описать сервис в docker-compose.yml.

Пример Dockerfile для Nginx:

FROM nginx:latest

COPY nginx.conf /etc/nginx/nginx.conf

COPY ./html /usr/share/nginx/html

Пример минимальной конфигурации для проксирования запросов к PHP (nginx.conf):

server {

listen 80;

server_name localhost;

root /var/www/html;

index index.php index.html;

location / {

try_files $uri $uri/ /index.php?$query_string;

}

location ~ \.php$ {

fastcgi_pass php:9000; # Связь с PHP-контейнером

fastcgi_index index.php;

include fastcgi_params;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

}

}

Описание сервиса в docker-compose.yml:

services:

nginx:

image: nginx:latest

container_name: nginx

ports:

- "80:80"

volumes:

- ./nginx.conf:/etc/nginx/nginx.conf

- ./html:/var/www/html

depends_on:

- php

networks:

- app_network

Создание контейнера для PHP

PHP-контейнер будет обрабатывать backend-логику приложения. Для его создания необходимо:

- использовать официальный образ PHP с поддержкой FPM (FastCGI Process Manager),

- настроить PHP для работы с Nginx,

- описать сервис в docker-compose.yml.

Пример Dockerfile для PHP:

FROM php:8.2-fpm

RUN docker-php-ext-install pdo_mysql

Описание сервиса в docker-compose.yml:

services:

php:

image: php:8.2-fpm

container_name: php

volumes:

- ./php:/var/www/html # Проброс директории с PHP-кодом

networks:

- app_network

Создание файла docker-compose.yml и настройка проекта

Чтобы Nginx мог передавать запросы PHP-FPM, необходимо:

- убедиться, что оба контейнера находятся в одной сети (app_network),

- указать в конфигурации Nginx правильный адрес PHP-контейнера (в нашем примере это php:9000, где php — имя сервиса в docker-compose.yml).

Итоговый docker-compose.yml:

version: '3.8'

services:

nginx:

image: nginx:latest

container_name: nginx

ports:

- "80:80"

volumes:

- ./nginx/nginx.conf:/etc/nginx/nginx.conf

- ./nginx/html:/var/www/html

depends_on:

- php

networks:

- app_network

php:

image: php:8.2-fpm

container_name: php

volumes:

- ./php:/var/www/html

networks:

- app_network

networks:

app_network:

driver: bridge

Создайте файл index.php в директории php/:

<?php

echo "Hello from PHP!";

?>

Запустите проект командой:

docker-compose up -dОткройте браузер и перейдите по адресу http://localhost. Вы увидите сообщение «Hello from PHP!». Оно означает успешную работу связки Nginx и PHP.

Пример структуры проекта:

project/

├── docker-compose.yml

├── nginx/

│ ├── nginx.conf

│ └── html/

├── php/

│ └── index.php

Работа с контейнерами в Docker Compose

Docker Compose предоставляет удобный способ управления контейнерами, начиная от их сборки и запуска, заканчивая остановкой и удалением.

Сборка контейнеров в Docker Compose

Используйте команду:

docker-compose buildОна позволяет создать образы на основе инструкций, указанных в docker-compose.yml.

Запуск всех сервисов

docker-compose upЗапуск контейнеров в фоновом режиме

Для этой задачи можно добавить в команду флаг -d:

docker-compose up -dЭто особенно полезно для развертывания приложений на сервере.

Остановка контейнеров без их удаления

Это делается командой:

docker-compose stopОна приостанавливает работу всех сервисов, описанных в docker-compose.yml, но сохраняет их состояние.

Остановка и полное удаление контейнеров, сети и тома

Выполните команду:

docker-compose downУдаление образов

Чтобы удалить образы, необходим дополнительный флаг —rmi all:

docker-compose down --rmi allУдаление томов

А для удаления томов добавьте флаг —volumes:

docker-compose down --volumesВыполнение команд внутри запущенного контейнера

Для выполнения команд внутри запущенного контейнера используется команда:

docker-compose exec <service_name> <command>Здесь <service_name> — это имя сервиса, а <command> — команда, которую нужно выполнить. Например, чтобы открыть терминал в контейнере с PHP, выполните:

docker-compose exec php bashЗависимости между сервисами

Зависимости между сервисами задаются в docker-compose.yml с помощью опции depends_on. Например, чтобы база данных запускалась перед приложением:

services:

app:

depends_on:

- db

Для запуска контейнера от имени определенного пользователя, нужно настроить опцию user в конфигурации:

services:

app:

user: "<user_id_or_user_name>:<group_id_or_group_name>"

Проброс папок между хостом и контейнером настраивается через volumes. Например:

services:

app:

volumes:

- ./app:/var/www/html

Переменные окружения задаются с помощью environment в docker-compose.yml:

services:

db:

environment:

MYSQL_ROOT_PASSWORD: password

Для просмотра логов конкретного сервиса применяется команда:

docker-compose logs <service_name>Например, если нужно, чтобы nginx показал логи веб-сервера, нужно запустить команду:

docker-compose logs nginxПроброс портов настраивается через ports. Например, чтобы связать порт 80 на хосте с портом 8080 в контейнере, выполните:

services:

web:

ports:

- "80:8080"

Лимиты на использование CPU и памяти задаются через deploy.resources.limits:

services:

app:

deploy:

resources:

limits:

cpus: '0.5'

memory: 512M

Метки добавляются для удобства управления контейнерами. Например:

services:

web:

labels:

com.example.description: "Web service"

Docker Compose делает процесс работы с контейнерами простым и эффективным, автоматизируя множество рутинных задач.

Работа с сетью

Создание пользовательских сетей

Docker Compose позволяет создавать пользовательские сети для улучшения управления коммуникацией между контейнерами. По умолчанию Compose создает одну сеть для всех сервисов, но можно определить дополнительные сети в файле docker-compose.yml. Например, чтобы создать сеть с именем app_network, используется следующий код:

networks:

app_network:

driver: bridge

Чтобы подключить к этой сети нужные сервисы, нужно указать их в разделе networks каждого сервиса. Это полезно для сложных проектов, где требуется разделение сетевых ресурсов.

Изоляция сетей

Изоляция сетей позволяет ограничить взаимодействие между контейнерами, что повышает безопасность и упрощает управление. В Docker Compose можно создать несколько сетей и подключить к ним только определенные сервисы. Например, база данных может быть изолирована в отдельной сети, доступной только для backend-сервисов. Это делается через конфигурацию networks в docker-compose.yml:

services:

db:

networks:

- db_network

backend:

networks:

- db_network

- app_network

Здесь сервис db изолирован в сети db_network, а backend имеет доступ как к db_network, так и к app_network.

Коммуникация между контейнерами

Docker Compose упрощает коммуникацию между контейнерами, автоматически настраивая DNS-имена для каждого сервиса. Это позволяет обращаться к контейнерам по имени сервиса, указанному в docker-compose.yml. Например, если у вас есть сервис db, вы можете подключиться к нему из другого контейнера, используя имя db как хост. Пример:

services:

db:

image: postgres

app:

image: my_app

environment:

DB_HOST: db

В этом случае сервис app сможет подключиться к базе данных, используя db как хост. Docker Compose автоматически настроит сеть и DNS, чтобы обеспечить корректную коммуникацию между контейнерами.

Читайте также:

The root folder of the repo contains all docker-compose files (docker-compose*.yml). Here is a list of all of them and what’s their purpose, for different deployment needs.

CONTENT

- Getting Started

- Run eShopOnContainers locally

- Run eShopOnContainers on a remote docker host

- Run eShopOnContainers on Windows containers

- Run infrastructure containers

- Other files

Getting Started

Make sure you have installed and configured docker in your environment. After that, you can run the below commands from the /src/ directory and get started with the eShopOnContainers immediately.

docker-compose build docker-compose up

You should be able to browse different components of the application by using the below URLs :

Web Status : http://host.docker.internal:5107/ Web MVC : http://host.docker.internal:5100/ Web SPA : http://host.docker.internal:5104/

Note: If you are running this application in macOS then use docker.for.mac.localhost as DNS name in .env file and the above URLs instead of host.docker.internal.

Below are the other avenues to setup eShopOnContainers.

Run eShopOnContainers locally

-

docker-compose.yml: This file contains the definition of all images needed for running eShopOnContainers. -

docker-compose.override.yml: This file contains the base configuration for all images of the previous file

Usually these two files are using together. The standard way to start eShopOnContainers from CLI is:

docker-compose -f docker-compose.yml -f docker-compose.override.yml

This will start eShopOnContainers with all containers running locally, and it is the default development environment.

Run eShopOnContainers on a remote docker host

-

docker-compose.prod.yml: This file is a replacement of thedocker-compose.override.ymlbut contains some configurations more suitable for a «production» environment or when you need to run the services using an external docker host.

docker-compose -f docker-compose.yml -f docker-compose.prod.yml

When using this file the following environments variables must be set:

-

ESHOP_PROD_EXTERNAL_DNS_NAME_OR_IPwith the IP or DNS name of the docker host that runs the services (can uselocalhostif needed). -

ESHOP_AZURE_STORAGE_CATALOGwith the URL of the Azure Storage that will host the catalog images -

ESHOP_AZURE_STORAGE_MARKETINGwith the URL of the Azure Storage that will host the marketing campaign images

You might wonder why an external image resource (storage) is needed when using docker-compose.prod.yml instead of docker-compose.override.yml. Answer to this is related to a limitation of Docker Compose file format. This is how we set the environment configuration of Catalog microservice in docker-compose.override.yml:

PicBaseUrl=${ESHOP_AZURE_STORAGE_CATALOG:-http://localhost:5101/api/v1/catalog/items/[0]/pic/}

The PicBaseUrl variable is set to the value of ESHOP_AZURE_STORAGE_CATALOG if this variable is set to any value other than blank string. If not, the value is set to http://localhost:5101/api/v1/catalog/items/[0]/pic/. That works perfectly in a local environment where you run all your services in localhost and setting ESHOP_AZURE_STORAGE_CATALOG you can use or not Azure Storage for the images (if you don’t use Azure Storage images are served locally by catalog servide). But when you run the services in a external docker host, specified in ESHOP_PROD_EXTERNAL_DNS_NAME_OR_IP, the configuration should be as follows:

PicBaseUrl=${ESHOP_AZURE_STORAGE_CATALOG:-http://${ESHOP_PROD_EXTERNAL_DNS_NAME_OR_IP}:5101/api/v1/catalog/items/[0]/pic/}

So, use ESHOP_AZURE_STORAGE_CATALOG if set, and if not use http://${ESHOP_PROD_EXTERNAL_DNS_NAME_OR_IP}:5101/api/v1/catalog/items/[0]/pic/}. Unfortunately seems that docker-compose do not substitute variables inside variables, so the value that PicBaseUrl gets if ESHOP_AZURE_STORAGE_CATALOG is not set is literally http://${ESHOP_PROD_EXTERNAL_DNS_NAME_OR_IP}:5101/api/v1/catalog/items/[0]/pic/} without any substitution.

Run eShopOnContainers on Windows containers

All docker-compose-windows*.yml files have a 1:1 relationship with the same file without the -windows in its name. Those files are used to run Windows Containers instead of Linux Containers.

-

docker-compose-windows.yml: Contains the definitions of all containers that are needed to run eShopOnContainers using windows containers (equivalent todocker-compose.yml). -

docker-compose-windows.override.yml: Contains the base configuration for all windows containers

Note We plan to remove the docker-compose-windows.override.yml file, because it is exactly the same as the docker-compose.override.yml. The reason of its existence is historical, but is no longer needed. You can use docker-compose.override.yml instead.

-

docker-compose-windows.prod.ymlis the equivalent ofdocker-compose.prod.ymlfor containers windows. As happens withdocker-compose-windows.override.ymlthis file will be deleted in a near future, so you should usedocker-compose.prod.ymlinstead.

Run infrastructure containers

These files were intended to provide a fast way to start only «infrastructure» containers (SQL Server, Redis, etc). This files are deprecated and will be deleted in a near future*:

docker-compose-external.override.ymldocker-compose-external.yml

If you want to start only certain containers use docker-compose -f ... -f ... up container1 contaner2 containerN as specified in compose doc

Other files

-

docker-compose.nobuild.yml: This file contains the definition of all images needed to run the eShopOnContainers. Contains the same images thatdocker-compose.ymlbut without anybuildinstruction. If you use this file instead ofdocker-compose.ymlwhen launching the project and you don’t have the images built locally, the images will be pulled from dockerhub. This file is not intended for development usage, but for some CI/CD scenarios. -

docker-compose.vs.debug.yml: This file is used by Docker Tools of VS2017, and should not be used directly. -

docker-compose.vs.release.yml: This file is used by Docker Tools of VS2017, and should not be used directly.

Note: The reason why we need the docker-compose.nobuild.yml is that docker-compose issue #3391. Once solved, parameter --no-build of docker-compose could be used safely in a CI/CD environments and the need for this file will disappear.

Last Updated :

03 Jul, 2024

Docker Desktop is an user-friendly tool that simplifies the deployment of Docker containerized applications on your local machine. It provides a graphical interface for managing containers, images, and volumes, making it accessible for developers and DevOps professionals. In this guide, we will walk you through the essential steps of using Docker Desktop, from installation to deploying a simple Nginx application.

Table of Content

- What is Docker Desktop?

- Installation of Docker Desktop

- Getting Started with Docker Desktop

- How to Deploy your First Docker Container with Docker Desktop?

- Managing Multi-Container Applications with Docker Compose

- Difference between Docker and Docker Compose

- Troubleshooting Queries of Docker Container Deployment

- Advantages Docker Desktop

- Disadvantages of Docker Desktop

- Best Practices for maintaining and Securing Docker Containerized Applications

What is Docker Desktop?

Docker Desktop is a lightweight virtualization platform that enables you to run containers on your local machine. Docker Containers are portable and self-contained units that encapsulate an application and its dependencies. Docker Desktop streamlines the development, testing, and deployment processes, making it an integral part of modern application development workflows.

Installation of Docker Desktop

Before we delve into deploying containerized applications, let’s get Docker Desktop installed on your machine. Follow these steps based on your operating system:

1. Windows Installation

Visit the Docker website and download the Docker Desktop installer for Windows. Run the installer, following the on-screen instructions. Upon installation, Docker Desktop may prompt you to enable virtualization in your system’s BIOS settings. Make sure to do this for optimal performance.

- For further installation guide refer How to install Docker on Windows.

2. MacOS Installation

Download the Docker Desktop installer for macOS from the official Docker website. Open the downloaded package and drag the Docker icon to your Applications folder. Launch Docker Desktop from the Applications folder.

- For further installation guide refer How to install Docker on MacOS.

3. Linux Installation

Install Docker Engine on your Linux distribution by following the official documentation. Download the Docker Desktop package for Linux from the Docker website. Install Docker Desktop by executing the provided commands in the terminal.

Getting Started with Docker Desktop

Now that Docker Desktop is installed, let’s explore the basic functionalities.

- Access to DockerHub: Upon launching Docker Desktop, you may be prompted to sign in with your Docker ID. If you don’t have one, you can create it for free. Logging in allows you to access Docker Hub, a cloud-based registry for Docker images.

- Dashboard: The Dashboard serves as the command center, providing an overview of your running containers, available images, and other essential information. It’s the first screen you see upon launching Docker Desktop.

- Containers: In the Containers section, you can manage your running containers. Docker Desktop allows you to start, stop, and remove containers with a simple click, making it a user-friendly way to interact with your applications.

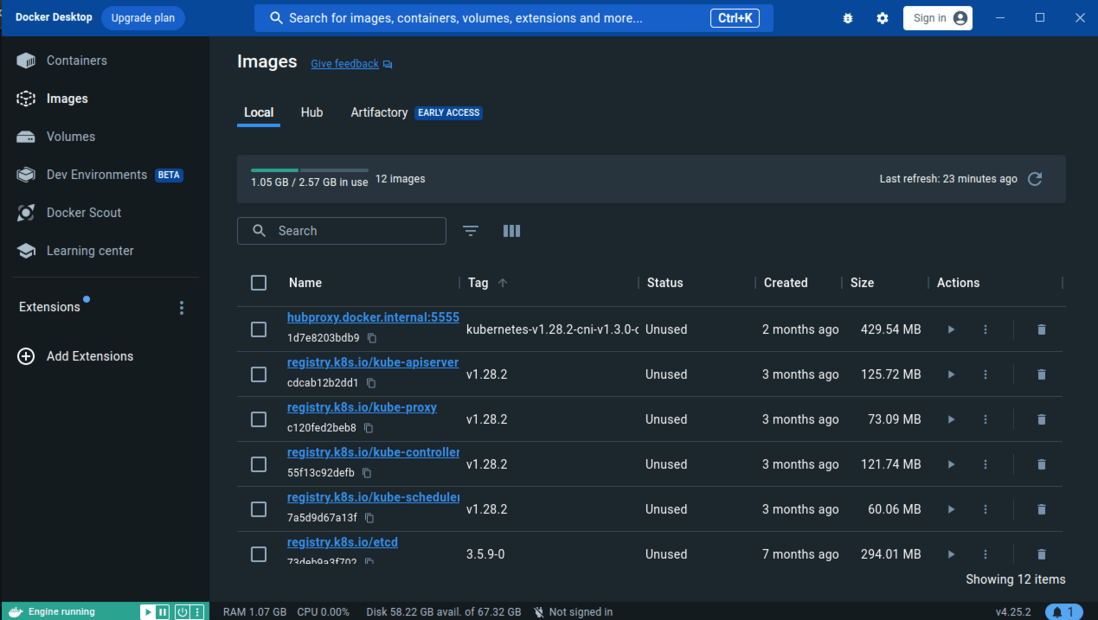

- Images:The Images section displays the Docker images available on your system. You can pull images from Docker Hub, create custom images, and manage image repositories effortlessly.

- Docker Volumes: Volumes in Docker Desktop are where you manage persistent data storage for your containers. This is crucial for applications that require data persistence beyond the lifespan of a container.

How to Deploy your First Docker Container with Docker Desktop?

Now that Docker Desktop is up and running, let’s deploy a basic containerized application using the GUI. For starters, if you want to explore more.

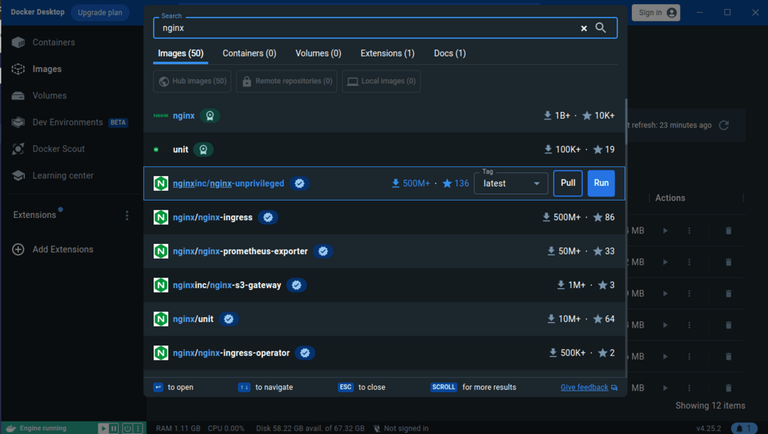

- Open Docker Desktop and navigate to the «Dashboard.» Use the search bar to find an image. For example, let’s search for the official Nginx image.

- Click on the image to pull it to your local machine. Then Click on run button run the ubuntu, after doing this it show the status “In use” instead of unused. With the container running, open a web browser and navigate to http://localhost:8080.

- You should see the default Nginx welcome page, indicating a successfully deployed containerized application.

- We can try other images availabe on DockerHub as per our need. But in this article, we will be focusing more on how to run a custom container.

Creating a Dockerfile

- To deploy a custom application, you’ll need to create a Dockerfile. This file contains instructions for building a Docker image.

- Here’s a simple Dockerfile for an Nginx application:

# Use the official Nginx image

FROM nginx:latest# Copy your HTML files into the container

COPY ./html /usr/share/nginx/html

Building and Running the Docker Image

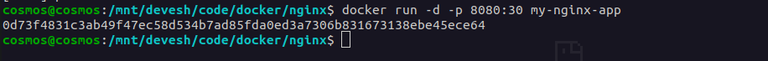

- Open a terminal in the directory containing your Dockerfile. Build the Docker image:

docker build -t my-nginx-app .

.webp)

- Run the Docker container:

docker run -d -p 8080:80 my-nginx-app

- This command maps port 8080 on your host machine to port 80 on the container.

Managing Multi-Container Applications with Docker Compose

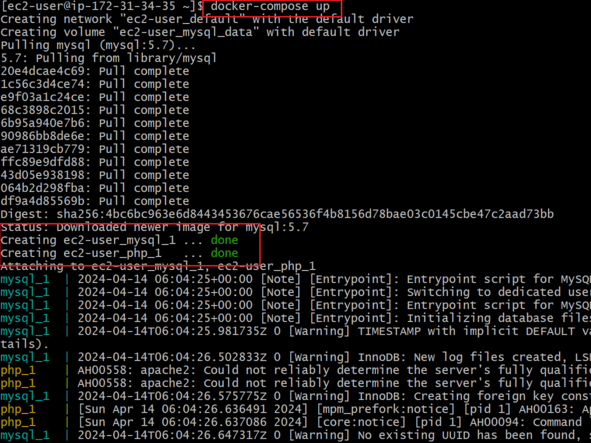

Docker Desktop seamlessly integrates with Docker Compose, allowing you to define and manage multi-container applications using a YAML file. The following are the steps that guides you on how to manage the multi-container applications with docker compose:

Step 1: Create a docker-compose.yml File

- In your project directory, create a docker-compose.yml file with the following content:

version: '3'

services:

web:

image: nginx

ports:

- "8080:80"

db:

image: mysql

environment:

MYSQL_ROOT_PASSWORD: example

MYSQL_DATABASE: mydatabase

- This example defines two services: web (Nginx) and db (MySQL). It specifies port mapping for the Nginx service and sets environment variables for the MySQL service.

Step 2: Run Docker Compose

- On the Docker Desktop Dashboard, go to the «File» menu and select «Open Compose.» Choose your docker-compose.yml file.

- Docker Desktop will recognize the file and present options to build and run the defined services.

Step 3: Access Your Multi-Container Application

- With Docker Compose running, your multi-container application is accessible just like a single-container application. On visiting the following link, we can interact with the Nginx service in this example:

http://localhost:8080

Difference between Docker and Docker Compose

The following are the difference between Docker and Docker Compose:

| Feature | Docker | Docker Compose |

|---|---|---|

| Purpose | It is used for managing individual containers. | It is used for managing multi-container applications. |

| Command-line Tool | It uses docker command for performing operations. |

Uses docker-compose command for performing tasks. |

| Configuration | Container configurations defined in Dockerfiles. | Configurations defined in docker-compose.yml files. |

| Orchestration | It mainly focuses on single container operations. | it facilitaes with simplifying the orchestration of multiple interconnected containers. |

Troubleshooting Queries of Docker Container Deployment

The following are the troubleshooting queries of Docker Container Deployment:

1. How To Resolve «Docker Desktop fails to start» Issue?

- Try to Ensure that virtualization is enabled in your system’s BIOS and Check for conflicting softwares that might be interfering with Docker Desktop.

2. What Are Steps Should Be Taken When Encountered a Failure In Pulling An Image?

- Fiirstly try on verifying your internet connection stability and Next check whether the pulling image exists on Docker Hub Repository or Not.

3. What To Do When the Port Conflict Issue Raised With Error «Port Already In Use»?

- The Port Conflict Issue raise when you are trying to use already assigned and working port for other program, to resolve this try on using Other available ports.

- To know what are the port currently used run the following command.

netstat -tnlp

4. What Steps Should Be Taken When The Docker Application Is Not Accessible From The Host?

- Firstly Ensure the Application binded with the correct port and verify the firewall settings on the host machine to allow traffic to the specified port.

5. How To TroubleShoot Slow Performance Inside a Docker Container?

- Firstly check the resource allocation for the container and then inspect the container logs for errors. Check the Host Mahine respective resources. In addition try on optimizing the applications code if necessary.

Advantages Docker Desktop

The following are the advantages of Docker Desktop:

- User-Friendly Interface: Docker Desktop helps with providing a simple and user-friendly graphical interface, making it easy usable for developers in managing the docker containers and images.

- Cross-Platform Support: It is available for Windows, macOS, and Linux platforms. Docker Desktop helps in providing a consistent development environment across different operating systems with reducing compatibility issues.

- Integrated Tools: It comes with supporting the other tools like Docker Compose and Kubernetes with allowing seamless orchestration and management of multi-container applications.

- Local Development Environment: Docker Desktop facilitates the developers with allowing them to run and test containerized applications locally before deploying to production, improving development speed and reliability.

Disadvantages of Docker Desktop

The following are the disadvantages of Docker Desktop:

- Resource Intensive: Docker Desktop can consume significant system resources, which may impact the performance of the host machine, especially on lower-end hardware.

- Licensing and Cost: Docker Desktop’s usage policies and licensing may results with some restrictions and in raise costs for businesses.

- Limited Integration on Some Platforms: With certain features and integrations, it will be helpful with fully supportivenss or provides optimization on all operating systems.

Best Practices for maintaining and Securing Docker Containerized Applications

The following are the best practices for maintaining and security docker containerized applications:

- Regularly Update Images and Containers: It is suggested to keep docker images and containers up to date with the latest security patches avoid the expose of vulnerabilities and improve the performance.

- Implement Principle of Least Privilege: On running the containers with the least amount of privileges necessary we can reduce the risk of security breaches.

- Use Trusted Base Images: The Source of your base images should be pulled from the trusted registries. Regularly scan images for vulnerabilities using tools like Trivy, Clair we bring security practices for the image.

- Network Segmentation and Isolation: Utilization Docker’s networking features to segment and isolate container networks, limiting communication between containers and reducing the attack surface.

Conclusion

Docker Desktop, with its user-friendly interface, brings the power of containerization to developers without the need for extensive command-line knowledge. This guide has covered the installation of Docker Desktop on Windows, macOS, and Linux, as well as an exploration of its graphical interface for deploying and managing containerized applications. By leveraging Docker Desktop’s intuitive features, developers can streamline their workflows and embrace the efficiency and portability that containerization offers in the world of modern software development.